https://arxiv.org/abs/2402.01761

在大型语言模型时代的可解释性再思考

摘要

在过去十年中,随着越来越大的数据集和深度神经网络的兴起,可解释机器学习领域的兴趣迅速增长。同时,大型语言模型(LLMs)在广泛的任务中展示了卓越的能力,为可解释机器学习提供了重新思考的机会。值得注意的是,以自然语言解释的能力使LLMs能够扩大可以提供给人类的模式的规模和复杂性。然而,这些新能力也带来了新的挑战,如幻觉解释和巨大的计算成本。

在这篇立场论文中,我们首先回顾了评估LLM解释(解释LLMs和使用LLMs进行解释)这一新兴领域现有方法。我们认为,尽管存在局限性,LLMs有机会以更雄心勃勃的范围重新定义可解释性,包括在审计LLMs自身中。我们强调了LLM解释的两个新兴研究重点:使用LLMs直接分析新数据集和生成交互式解释。

1 引言

近年来,由于越来越大的数据集和强大的神经网络模型的可用性,机器学习(ML)和自然语言处理(NLP)领域迅速扩张。作为回应,可解释ML领域已经发展出多种技术和方法,以理解这些模型和数据集[1, 2, 3]。这一扩展的一部分集中在开发和使用固有可解释的模型[4],如稀疏线性模型、广义加性模型和决策树。与此同时,事后可解释技术变得越来越突出,为模型训练后提供洞察力。值得注意的例子包括评估特征重要性的方法[5, 6],以及更广泛的事后技术,例如模型可视化[7, 8]或**可解释蒸馏[**9, 10]。

与此同时,预训练的大型语言模型(LLMs)在一系列复杂的NLP任务中表现出令人印象深刻的熟练程度,显著推进了该领域的发展,并为应用开辟了新的前沿[11, 12, 13]。然而,这些模型的有效解释能力不足,削弱了它们在医学等高风险应用中的使用,并引发了与监管压力、安全性和一致性相关的问题[14, 15, 16]。此外,这种缺乏可解释性限制了LLMs(以及其他神经网络模型)在科学和数据分析等领域的使用[17, 18, 19]。在这些环境中,最终目标通常是获得可靠的解释,而不是部署LLM。

在这项工作中,我们认为LLMs有机会以更雄心勃勃的范围重新思考可解释性。LLMs可以比前一代可解释ML技术提供更精细的解释。虽然以前的方法经常依赖于像显著性图这样的受限接口,但LLMs可以直接用富有表现力的自然语言进行交流。这使用户可以提出针对性的查询,例如“你能解释你的逻辑吗?”,“为什么你没有回答(A)?”或“向我解释这些数据。”,并获得立即、相关的响应。我们相信,像这些简单的问题,加上定位和处理数据的技术,将使LLMs能够直接向人类以可理解的文本表达以前难以理解的模型行为和数据模式。然而,要实现这些机会,需要解决新挑战,包括幻觉(即不正确或无根据的)解释,以及现代LLMs的巨大规模、成本和固有的不透明性。

图 1: LLM解释研究的分类。(A) LLMs为解释提供了独特的机遇和挑战(第3节)。(B) 解释LLM可以分为寻求解释LLM单个生成的方法(即局部解释,第4.1节)或整个LLM(即全局/机制性解释,第4.2节)。局部解释方法基于许多最初为解释非LLM模型而开发的技术,例如特征归因方法。更近期的局部解释技术使用LLM本身产生解释,例如通过事后自然语言(NL)解释,要求LLM在其生成过程中构建解释,或通过数据定位。类似的技术已经开发并应用于全局解释,尽管它还包括独特的解释类型,例如分析LLM内部的个别注意力头或电路。© 第5节分析了使用LLM直接帮助解释数据集的新兴领域。在此设置中,给LLM一个新的数据集(可以由文本或表格特征组成),并用其帮助分析。基于LLM的数据集解释技术非常多样化,包括帮助构建可解释模型、生成NL解释、生成NL解释链或构建数据可视化。(D) 在局部解释、全局解释和数据集解释的方法中出现了共同的主题。

图中的内容是关于大型语言模型(LLM)解释研究的分类和相关概念,以下是中英文对应的翻译:

- Natural-language interface 自然语言界面

- Hallucination 幻觉

- Opportunities 机遇

- Challenges 挑战

- Interactive explanations 交互式解释

- Size, opacity, and cost 规模、不透明性和成本

(B) Explain an LLM 解释一个LLM

- Local explanation 局部解释

- Explain a generation 解释一个生成

- Globa/mechanistic explanation 全局/机制性解释

- Explain entire model 解释整个模型

© Explain a dataset 解释一个数据集

- Explain data insights 解释数据洞察

Feature attribution 特征归因

- Attribution for LLM internals LLM内部归因

- Interpretable model 可解释模型

- e.g. SHAP 例如:SHAP

- e.g. Attention head importance 例如:注意力头的重要性

- e.g. Linear model of ngrams 例如:n-gram的线性模型

Attribution 归因

- NL explanation NL解释

- Explanations for LLM internals LLM内部的解释

- e.g., LLM explanations 例如:LLM解释

- Interactive NL explanation 交互式NL解释

- e.g. Attention heads summaries 例如:注意力头摘要

- e.g. Short string 例如:短字符串

Natural language (NL) 自然语言

- Prediction decomposition 预测分解

- Algorithmic understanding 算法理解

- Chain of LLMs LLM链

- Decomposing 分解

- e.g. Chain of thought 例如:思维链

- e.g. Circuit analysis 例如:电路分析

- e.g. Tree of prompts 例如:提示树

- Decomposing 分解

reasoning 推理

Data grounding 数据定位

- Data influence 数据影响

- Aiding data analysis 辅助数据分析

- Data

- e.g. RAG 例如:RAG(Retrieval-Augmented Generation)

- e.g. Influence function 例如:影响函数

- e.g. Find problematic samples 例如:发现问题样本

- grounding 定位

贡献和概述

我们评估了LLM解释,并强调了新兴的研究重点,其范围比近期的作品更广,例如那些专注于解释LLM预测[20]、机制性可解释性[21]、社会科学[19]或更普遍的科学[17, 22, 23]的作品。我们不是提供一个详尽的方法概述,而是突出了对LLMs独特的可解释性方面,并用实际有用的方法展示它们。

具体来说,我们首先从背景和定义(第2节)开始,然后继续分析LLMs在解释方面所呈现的独特机遇和挑战(第3节)。然后我们将这些机遇定位在两个互补的LLM基础解释类别中(见图1)。第一个是为现有的LLM生成解释(第4节),这对于审计模型的性能、一致性、公平性等非常有用。第二个是解释一个数据集(第5节);在这种设置中,使用LLM帮助分析一个新的数据集(可以由文本或表格特征组成)。

在整个论文中,我们强调数据集解释和交互式解释作为新兴的研究重点。这两个领域在科学到统计等领域具有巨大的潜在实际意义,它们可以促进科学发现、数据分析和模型构建的过程。我们始终关注预训练的LLMs,主要应用于文本数据,但也应用于表格数据。

2 背景:定义和评估

定义

没有上下文,可解释性是一个定义不清的概念。精确定义可解释性需要理解解释旨在服务的问题和受众。鉴于这种不精确性,可解释机器学习主要与一组狭窄的技术联系在一起,包括特征归因、显著性图和透明模型。然而,LLM解释的范围更广,表达能力也超过这些方法。在这里,我们引用之前工作[2]中可解释机器学习的定义,将LLM解释定义为从LLM中提取与数据中包含的关系或模型学习到的关系相关的知识。我们强调这个定义既适用于解释LLM,也适用于使用LLM生成解释。此外,这个定义依赖于提取相关知识,即对特定问题和受众有用的知识。例如,在代码生成的背景下,相关的解释可能帮助用户快速整合LLM生成的代码片段。相比之下,在医学诊断环境中,相关的解释可能会告知用户一个预测是否可信。

“大型语言模型”(LLM)这个术语通常使用不精确。在这里,我们用它来指代基于变换器的神经语言模型,这些模型包含数十亿到数百亿的参数,并且是在大量文本数据上预训练的,例如PaLM[24]、LLaMA[12]和GPT-4[13]。与早期的预训练语言模型(如BERT)相比,LLMs不仅规模更大,而且表现出更强的语言理解、生成能力和解释能力。在最初的计算密集型预训练阶段之后,LLMs通常会经历指令微调和进一步与人类偏好对齐,以提高指令遵循能力[25]或提高交互聊天能力,例如LLaMA-2聊天模型[12]。它们有时还会通过监督微调进一步适应,以提高在特定领域(如医学[26])的性能。

经过这些步骤后,LLMs通常使用提示,这是应用LLMs最常见的接口(也是本文的主要关注点)。在提示中,文本提示直接输入到LLM并用于生成随后的输出文本。少样本提示是一种涉及向LLM提供少量示例的提示类型,使其更好地理解被要求执行的任务。

评估LLM解释

由于不同的解释与不同的上下文相关,评估解释的理想方式是通过研究其在真实环境中与人类一起使用是否改善了期望的结果[27]。相比之下,仅仅测量人类对解释的判断不是特别有用,因为它可能不会转化为实践中的改进[28]。最近的元分析发现,将NLP解释引入到人类环境中产生了广泛变化的效用,从完全无用到非常有用[29]。这种评估的一个重要部分是互补性的概念[30],即解释应该帮助LLMs在团队环境中补充人类的表现,而不是孤立地提高它们的表现。

虽然人类研究提供了最现实的评估,但自动化指标(可以在不涉及人类的情况下计算)是可取的,以便于评估和扩展评估,特别是在机制性可解释性方面。一种越来越流行的方法是在评估中使用LLMs本身,尽管必须非常小心以避免引入偏见,例如LLM系统地对自己的输出评分过高[31]。减少偏见的一种方法是将LLMs作为针对特定问题量身定制的评估过程的一部分,而不是直接询问LLMs评估分数。例如,一个常见的设置是评估给定函数的自然语言解释(可能是预训练LLM的任何组件)。在这种情况下,可以评估解释模拟函数行为的能力[32],函数在LLM生成的合成数据上的输出[33],或者恢复真实函数的能力[34, 35]。在问答设置中,已经提出了许多自动化指标来衡量自然语言解释对问题个别答案的忠实度[36, 37, 38]。

评估解释的最后一个途径是通过它们能够以有用的方式改变/改善模型性能的能力。这种方法为解释的效用提供了有力的证据,尽管它并不包括所有关键的可解释性用例(特别是那些直接涉及人类交互的用例)。模型改进可以采取多种形式,最简单的是提高下游任务的准确性。例如,当将LLM的理由与使用事后解释方法生成的解释对齐时,或从大型模型中提取的解释时,少样本准确性被看到有所提高[39]或[40]。此外,在推理期间(而不是训练期间)使用少样本解释可以显著提高少样本LLM准确性,特别是当这些解释进一步优化时[41, 42]。除了一般性能外,解释还可以用来克服模型的特定缺点。例如,一项工作识别并解决了LLM学习到的捷径/虚假相关性[43, 44, 45]。模型编辑,一项相关的工作,使对某些模型行为进行精确修改成为可能,从而提高整体性能[46, 47, 48]。

3 LLM解释的独特机遇和挑战

LLM解释的独特机遇

首先是LLM解释能力,即能够提供自然语言界面来解释复杂模式。这个界面对人类来说非常熟悉,可能减轻了从业者在使用可解释性技术时经常面临的困难[49, 50]。此外,自然语言可以用来在人类和其他模式之间建立桥梁,例如DNA、化学物质或图像[51, 52, 53],这些对人类来说可能很难单独解释。在这些情况下,自然语言允许通过不同粒度级别的解释来表达复杂概念,这些解释可能基于证据或对反事实的讨论。

第二个主要机遇是LLMs生成交互式解释的能力。交互性使用户能够根据他们的独特需求定制解释,例如,通过提出后续问题和对相关示例进行分析。与决策者(包括医生和政策制定者)的访谈表明,他们强烈偏好交互式解释,特别是以自然语言对话的形式[54]。交互性进一步允许将LLM解释分解为许多不同的LLM调用,每个调用都可以独立审计。这可以通过不同的方式实现,例如,让用户反复使用提示与LLM聊天,或为用户提供一系列LLM调用和证据进行分析。

LLM解释的独特挑战

这些机遇带来了新的挑战。首先是**幻觉问题,**即提供不正确或毫无根据的解释。以自然语言提供的灵活解释可能很快就会缺乏证据支持,无论证据是在给定输入中存在还是在LLM从其训练数据中学到的知识中假定存在。幻觉解释是无益的,甚至可能误导人,因此识别和对抗幻觉的技术对LLM解释的成功至关重要。

第二个挑战是LLMs的巨大和不透明性。模型已经发展到包含数十亿或数百亿的参数[11, 12],并继续增长。这使得人类无法检查或甚至理解LLM的单元。此外,它需要有效的解释算法,因为即使从LLM生成单个标记通常也需要非平凡的计算成本。实际上,LLMs通常太大而无法在本地运行,或者只能通过专有的文本API访问,这就需要不需要完全访问模型的解释算法(例如,无法访问模型权重或模型梯度)。

4 解释一个LLM

在这一部分中,我们研究了解释LLM的技术,包括解释LLM的单个生成(第4.1节)或整个LLM(第4.2节)。我们评估了传统的可解释ML技术和基于LLM的技术来解释LLM。

4.1 局部解释

局部解释,即解释LLM的单个生成,在最近的可解释性文献中一直是一个主要焦点。它允许在高风险场景中理解和使用LLM,例如医疗保健。

在LLMs中提供局部解释的最简单方法是为输入标记提供特征归因。这些特征归因为每个输入特征分配一个相关性得分,反映其对模型生成输出的影响。已经开发了各种归因方法,包括基于扰动的方法[6]、基于梯度的方法[55, 56]和线性近似[5]。最近,这些方法特别适应了变换器模型,解决了诸如离散标记嵌入[57, 58]和计算成本[59]等独特挑战。此外,LLM学习的条件分布可以用来增强现有的归因方法,例如通过执行输入边际化[60]。除了特征归因,LLM内的注意力机制为可视化标记对LLM生成的贡献提供了另一种途径[61],尽管它们的忠实度/有效性仍然不清楚[62]。有趣的是,最近的工作表明,LLMs本身可以通过提示生成重要特征的事后归因[63]。这种方法可以扩展,以在不同情境中引发相关的不同特征归因。

在标记级归因之外,LLMs还可以直接用自然语言生成局部解释。虽然自然语言解释的生成早于当前的LLM时代(例如,在文本分类[64, 65]或图像分类[66]中),但更强大模型的出现显著提高了它们的有效性。由LLM生成的自然语言解释已经显示出阐明模型预测的能力,甚至模拟反事实情景[67],并表达不确定性等细微差别[68, 69, 70]。尽管有潜在的好处,自然语言解释仍然非常容易受到幻觉或不准确性的影响,特别是当事后生成时[71, 72]。

对抗这些幻觉的一个起点是在答案生成过程中整合解释本身。思维链提示就是这种方法的一个例子[73],其中LLM被提示在得出答案之前逐步阐述其推理。这种推理链通常会产生更准确和忠实的结果,因为最终答案与前面的逻辑步骤更加一致。这种方法的鲁棒性可以通过在推理过程中引入扰动并观察对最终输出的影响来测试[74, 75, 76]。生成这种推理链的替代方法包括思维树[77],它将思维链扩展为生成与回溯一起使用的思维树,思维图[78]等[79, 80, 81]。所有这些方法不仅帮助向用户传达LLM的中间推理,而且帮助LLM通过提示遵循推理,通常增强了输出的可靠性。然而,像所有基于LLM的生成一样,这些解释的保真度可能会有所不同[76, 82]。

减少生成期间幻觉的另一种途径是使用检索增强生成(RAG)。在RAG中,LLM在其决策过程中纳入了检索步骤,通常通过使用文本嵌入搜索参考语料库或知识库[83, 84](见评论[85])。这允许明确指定和检查用于生成输出的信息,使解释LLM在决策过程中使用的证据变得更加容易。

4.2 全局和机制性解释

与研究单个生成不同,全局/机制性解释旨在整体理解LLM。这些解释可以帮助审计模型,以解决超出泛化范围的关注点,例如偏见、隐私和安全,有助于构建更高效/可信赖的LLM。它们还可以产生关于LLM如何运作的机制性理解。为此,研究人员已专注于通过不同视角总结LLM的行为和机制。通常,这些工作需要访问模型权重,并且不适用于仅通过文本API可访问的模型解释,例如GPT-4[13]。

理解神经网络表示的一种流行方法是探测。探测技术通过解码嵌入信息,例如语法[86],或通过精确设计的任务测试模型的能力,例如主谓一致性[87, 88],来分析模型的表示。在LLM的背景下,探测已发展到包括分析注意力头[89]、嵌入[90]以及表示的不同可控方面[91]。它还包括直接解码输出标记以理解不同位置和层所表示的内容的方法[92, 93]。这些方法可以提供对LLM处理和表示信息的微妙方式的更深入理解。

除了探测,许多工作还在更细粒度的层面上研究LLM表示。这包括对单个神经元进行分类或解码概念[94, 95],或直接用自然语言解释注意力头的功能[32, 33, 96]。在单个神经元之外,对理解神经元组如何结合执行特定任务的兴趣日益增加,例如找到用于间接宾语识别的电路[97],用于实体绑定[98],或用于多个共享目的[99]。更广泛地说,这种类型的分析可以应用于定位功能而不是完全解释电路,例如在LLM内定位事实知识[46, 100]。这些方法的一个持续问题是它们很难扩展到庞大的LLM,导致研究(半)自动化方法,可以扩展到当今最大的LLM[101, 102]。

机制理解的补充方法使用微型LLM作为研究复杂现象的试验场。例如,检查2层变换器模型可以揭示注意力头作为输入统计函数学习的模式信息[103],或帮助识别关键组件,例如归纳头或n-gram头,它们复制并使用相关标记[104, 105]。这种机制理解特别关注研究上下文学习的重要能力,即在提示中给定少量输入-输出示例后,LLM可以学习为新输入正确生成输出[106, 107]。

研究的一个相关领域试图通过理解其训练数据分布的影响来解释LLM。与我们讨论的其他方法不同,这需要访问LLM的训练数据集,这些数据集通常未知或无法访问。在知道数据的情况下,研究人员可以使用影响函数等技术来识别训练数据中的重要元素[108]。他们还可以研究模型行为是如何从训练数据的模式中产生的,例如在长尾数据存在时的幻觉[109],在重复训练数据存在时[110],或与正确推理相矛盾的统计模式[111]。

所有这些解释技术都可以通过基于LLM的交互性得到改进,允许用户通过后续查询和用户改变的提示来调查不同的模型组件。例如,最近的一项工作引入了一个端到端的框架,用于基于解释的文本模型调试和改进,表明它可以快速提高文本分类性能[112]。另一项工作,Talk2Model,引入了一个自然语言界面,允许用户通过对话询问表格预测模型,隐式调用许多不同的模型可解释性工具,例如计算特征重要性[113]。† 最近的工作将Talk2Model扩展到一个设置,询问LLM关于其行为[114]。

最后,从机制理解中获得的见解开始通知实际应用,当前的重点领域包括模型编辑[46]、改进指令遵循[115]和模型压缩[116]。这些领域同时作为许多机制解释的理智检查,以及作为提高LLM可靠性的有用途径。

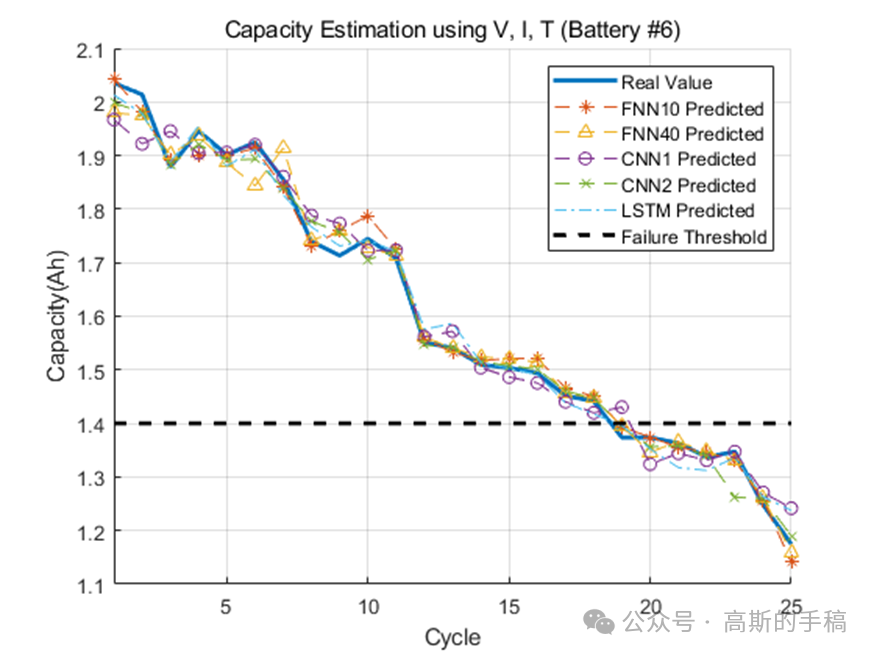

5 解释数据集

随着LLMs在其上下文长度和能力上的提升,它们可以被用来解释整个数据集,而不仅仅是解释LLM或其生成的内容。这可以帮助数据分析、知识发现和科学应用。图2显示了不同粒度级别的数据集解释的概览,我们将在下面详细覆盖。我们区分了表格数据和文本数据,但注意到大多数方法可以成功地应用于两者,或者在多模态设置中同时应用。

图2:不同粒度级别的数据集解释。

- 低层次 (Low-level)

- 高层次 (High-level)

- 可解释的 (Interpretable)

- 自然语言 (Natural-language)

- 表格数据 (Tabular data)

- 数据集解释 (Dataset explanations)

- 可视化 (visualizations)

- 文本模型 (text models)

- 表格模型 (tabular models)

- 解释 (explanation)

- (表格或文本)(Tabular or text)

- 这应该是 (This should be)

- 递减 (decreasing)

使用预训练的LLM来理解一个新的数据集(由文本或表格特征组成)涉及数据集解释。低级别解释对数据集更忠实,但涉及更多的人力努力来提取有意义的见解。许多数据集解释使用预测模型(分类或回归)作为识别和解释特征之间模式的手段。

表格数据

LLMs可以通过使交互式可视化和分析表格数据变得更容易来帮助解释数据集。这是可能的,因为LLMs可以将代码、文本和数字同时理解为输入标记。这一类中最受欢迎的方法可能是ChatGPT代码解释器‡,它允许上传数据集并通过交互式文本界面在它们之上构建可视化。这种能力是LLM辅助可视化的更广泛趋势的一部分,例如,为数据框架[117]建议自动可视化,帮助自动化数据整理[118],甚至进行完整的数据分析[119]。这些能力得益于不断增长的研究线,该研究线分析了如何有效地表示和处理LLMs的表格数据[120, 121, 122]。

LLMs也可以帮助通过直接分析拟合表格数据的模型来解释数据集。与机制性可解释性不同,后者的目标是理解模型,在数据集解释中,目标是通过模型理解数据中的模式(尽管可以为两个问题使用类似的技术)。例如,最近的一项工作使用LLMs分析拟合表格数据的广义可加模型(GAMs)[123]。GAMs是可解释的模型,可以表示为一组曲线,每条曲线表示一个特征对输出预测的贡献,作为该特征值的函数。LLM可以通过处理每条曲线作为一组数值标记,然后检测和描述每条曲线中的模式来分析拟合的模型(从而是底层数据集)。作者发现,基于他们对领域的先验知识,LLM能够识别曲线和底层数据中的令人惊讶的特征。而不是使用可解释的GAM模型,另一种方法是通过分析分类器预测来提取数据集见解。例如,MaNtLE根据分类器的预测生成分类器推理的自然语言描述,这些解释被发现可以识别包含相似特征模式的可解释子组[124]。

文本数据

文本数据对数据集解释提出了与表格数据不同的挑战,因为它是稀疏的、高维的,建模它需要许多高阶交互。因此,在表格领域成功使用的可解释模型(例如,稀疏线性模型[125, 126]、GAMs[127, 128, 129]、决策树[130, 131, 132]和其他[133, 134])在准确建模文本方面一直存在困难。最近的一项工作通过使用LLMs帮助构建完全可解释的文本模型,如线性模型或决策树[135],解决了这个问题;生成的模型出人意料地准确,通常甚至超过了更大的LLM模型。这些可解释的模型可以通过展示哪些特征(即单词或n-gram)对预测不同结果很重要来帮助解释数据集。类似的方法是,例如CHiLL[136]使用LLMs为文本分类任务构建可解释的表示。

除了完全可解释的模型之外,LLMs还有助于构建部分可解释的文本模型。部分可解释的文本模型通常采用提示链;这些链允许分解LLM的决策过程,以分析模型学习的数据集模式。提示链通常由人工构建,或者通过查询模型生成一系列即时调用[137]。对于数据集解释,最相关的链是由LLM生成的解释序列。例如,模型可以生成一个单一的解释树,该树在数据集中的所有示例中共享,这个过程使理解数据集中存储的层次结构成为可能[138]。而不是树,单一提示链通常可以帮助LLM进行自我验证,即模型本身使用一系列提示检查其先前的生成,这是一种流行的技术,通常可以提高可靠性[139, 140, 141]。与局部解释一样,LLM可以在其决策过程中纳入检索步骤[85],并且访问不同工具可以帮助使不同步骤(例如,算术)更可靠和透明[142]。

自然语言解释有可能产生丰富、简洁的数据集中模式描述,但容易受到幻觉的影响。一种方法,iPrompt[143],旨在通过搜索以单一提示形式的数据集解释,并验证提示是否引导LLM准确预测数据集中的模式来避免幻觉。相关方法使用LLMs提供区分数据集中不同组的描述,然后由LLM验证描述的可信度[144, 35, 145]。除了原始的自然语言解释外,LLMs还可以帮助总结文本信息,例如,通过可解释的文本数据集聚类[146]或创建基于提示的主题模型[147]。

6 未来研究重点

我们现在强调围绕LLM解释的三个研究重点:解释的可靠性、数据集解释和交互式解释。

解释的可靠性

所有LLM解释都受到可靠性问题的限制。这包括幻觉[148],但也包括更广泛的问题集。例如,LLM对提示措辞的细微差别仍然非常敏感;提示中的微小变化可以完全改变LLM输出的实质[149, 150]。此外,LLM可能会忽略上下文的部分内容,例如,长上下文的中间部分[151]或难以解析的指令[115]。

这些可靠性问题在解释中尤为关键,解释通常用于在高风险环境中使用以降低风险。一项分析解释可靠性的工作发现,LLM经常生成看似正确的解释,实际上与其自身在相关问题上的输出不一致[71],阻止了人类从业者信任LLM或理解其解释如何适用于新场景。另一项研究发现,LLM生成的解释可能不包含模型的预测或在输入中没有事实基础,即使是在具有提取性解释的简单任务上也是如此[72]。未来的工作需要提高解释的基础性,并开发更强的方法来测试它们的可靠性,可能通过自我验证[139]、迭代提示[143]或自动提高模型自我一致性[152, 153, 154]等方法。

数据集解释与知识发现

使用LLMs的数据集解释(第5节)有潜力帮助从数据中生成和发现新知识[17, 22, 23],而不仅仅是帮助加快数据分析或可视化。数据集解释最初可以在构思科学假设的水平上提供帮助,然后由人类研究人员进行筛选或测试[155]。在这个过程中,LLM解释可以帮助使用自然语言来理解来自不透明领域(如化学物质[156]或DNA序列[51])的数据。在算法领域,LLM已被用来发现新算法,将其翻译成人类可读的计算机程序[157]。这些方法可以与实验数据结合起来,帮助产生新的数据驱动的见解。

LLM解释也可以用来帮助人类更好地执行任务。变换器的解释已经开始被应用于如国际象棋等领域,在那里它们的解释可以帮助即使是专家级玩家提高[158]。此外,LLM可以提供专家人类行为的解释,例如“鉴于关于患者的这些信息,医生为什么开这种药?”这对于理解、审计和改进人类行为是有帮助的[159]。

交互式解释

最后,LLM的进步有望允许开发更多以用户为中心的交互式解释。LLM解释和后续问题已经集成到各种LLM应用中,如交互式任务规范[160]、推荐[161]以及涉及对话的广泛任务集。此外,像Talk2Model[113]这样的工作使用户能够以对话方式交互式地审计模型。这种对话界面可以与本文涵盖的许多方法结合使用,帮助新的应用,例如交互式数据集解释。

7 结论

在这篇论文中,我们探索了可解释机器学习广阔而充满活力的领域,特别关注了LLMs所呈现的独特机遇和挑战。LLMs先进的自然语言生成能力为生成更精细和微妙的解释开辟了新的途径,允许对数据中的复杂模式和模型行为有更深入、更易于理解的认识。在探索这一领域时,我们坚信将LLMs整合到解释过程中不仅仅是现有方法的增强,而是一种转型变化,承诺重新定义机器学习可解释性的边界。

我们的立场基于这样一种信念:可解释机器学习的未来取决于我们能否充分发挥LLMs的全部潜力。为此,我们概述了几个关键立场和未来研究方向,例如提高解释的可靠性和推进数据集解释以发现知识。随着LLMs的快速改进,这些解释(以及本文讨论的所有方法)将相应地发展,以实现新的应用和洞见。在不久的将来,LLMs可能能够提供可解释性的圣杯:能够可靠地聚合并向我们所有人传达极其复杂信息的解释。