这是我的第319篇原创文章。

一、引言

电脑配置 :

- python版本要求:3.8

- torch版本:2.0.1

- cuda:11.7

- windows系统:Windows 10

- 显卡:6G以上GPU

二、实现过程

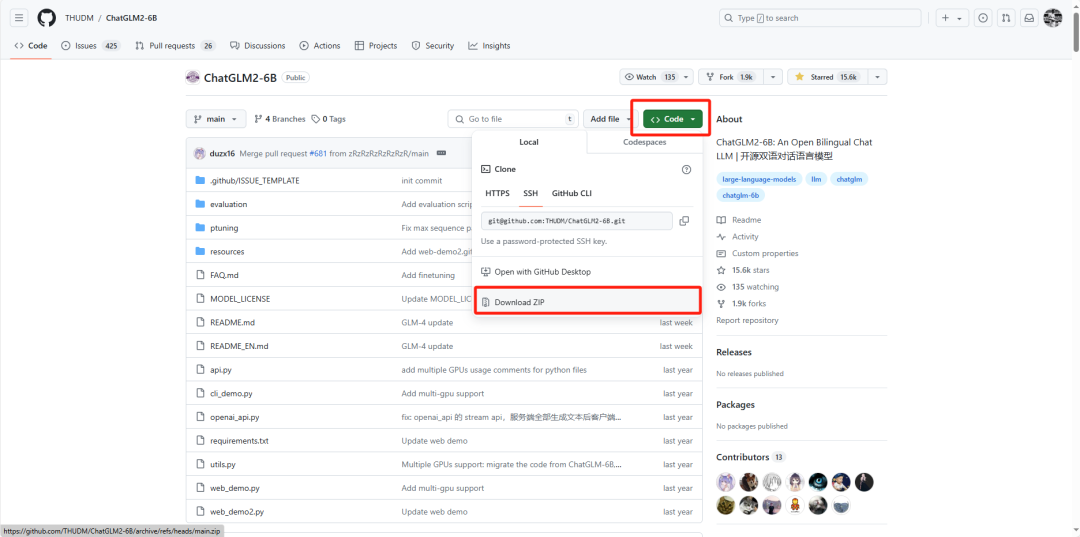

2.1 下载chatglm2-6b的项目源码

上chatglm2-6B的官方github下载源码(https://github.com/THUDM/ChatGLM2-6B)直接右键下载打包的源码即可,解压到本地目录。

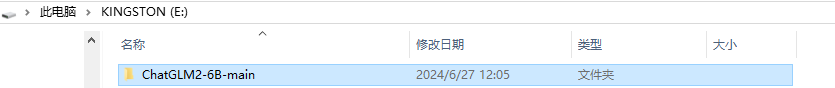

这里我把项目zip直接下载到E:\盘,解压后项目根目录为E:\ChatGLM2-6B-main:

2.2 创建虚拟环境,安装项目依赖

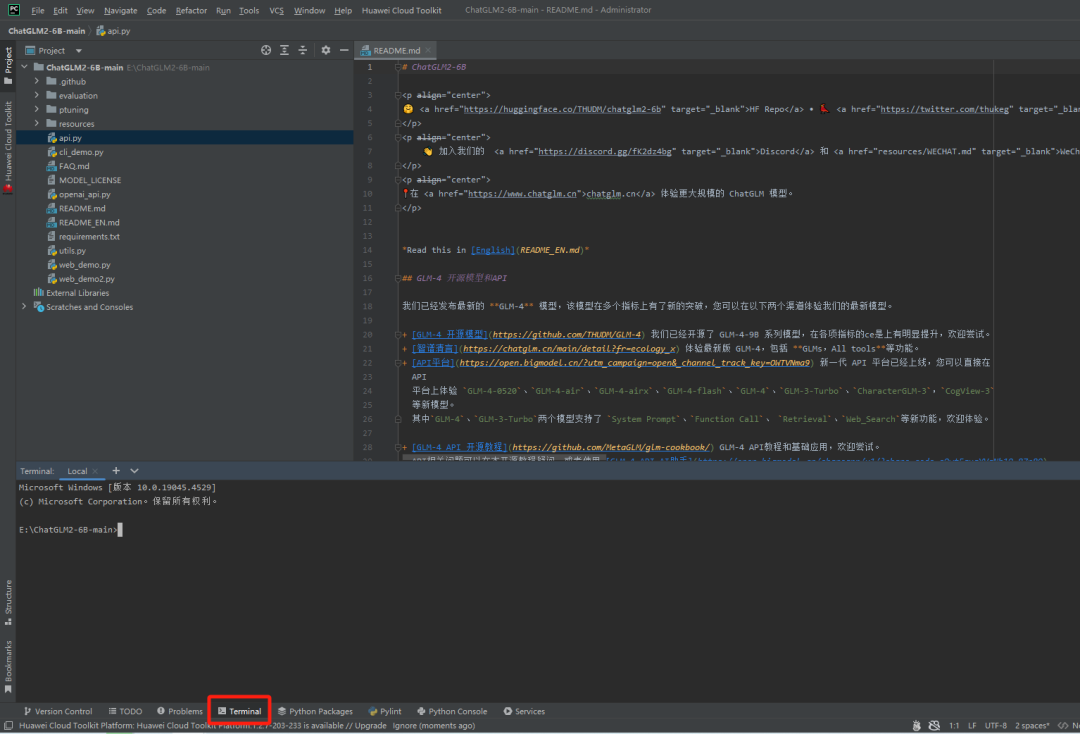

用Pycharm打开这个文件夹,进入终端:

(1)创建conda的虚拟环境,指定Python的版本:

conda create -n chatglm2-6b python=3.8

(2)激活环境:

conda activate chatglm2-6b

(3)下载torch的gpu版本以及依赖包:

pip install -r requirements.txt

2.3 下载chatglm2-6b-int4的模型文件

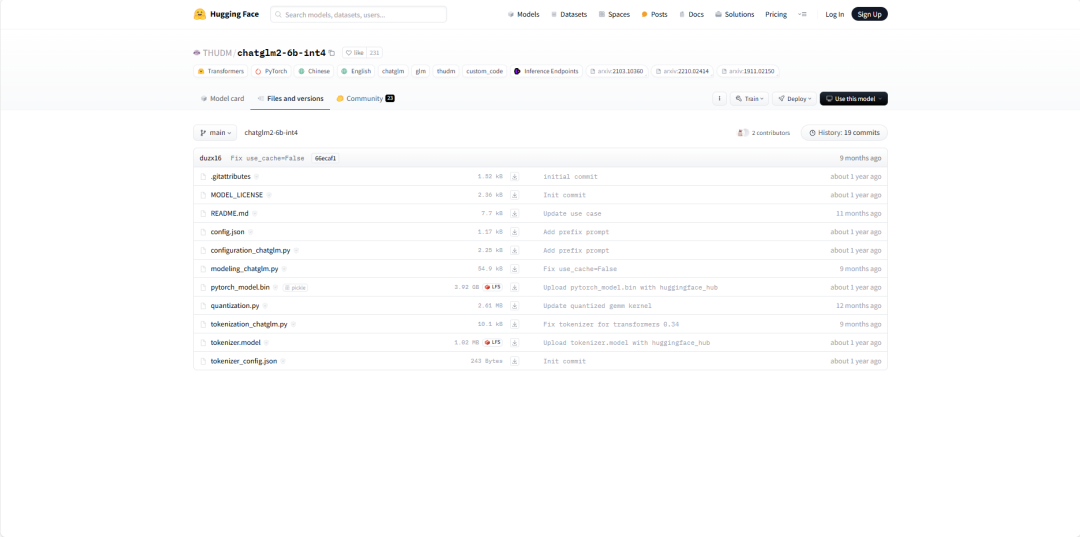

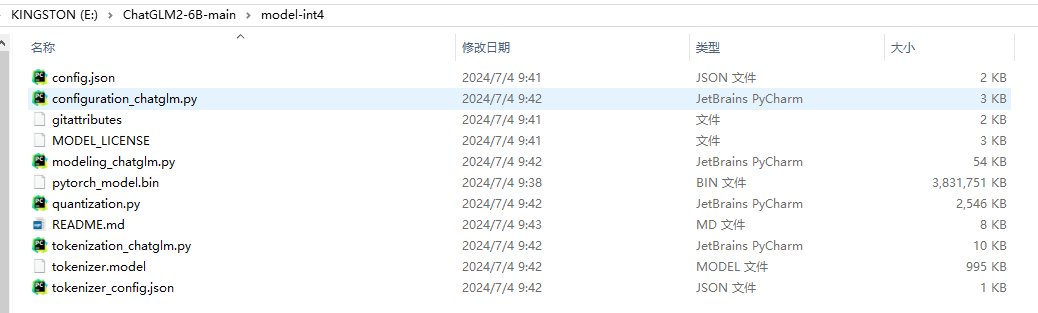

从(https://huggingface.co/THUDM/chatglm2-6b-int4/tree/main)下载里面的模型文件下来,放到上面项目的model-int4目录(新建)里。

结果:

2.4 修改项目脚本文件进行配置,使用模型

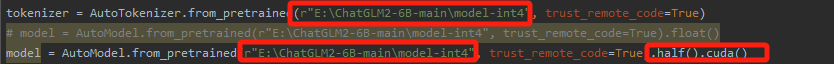

修改web_demo.py:

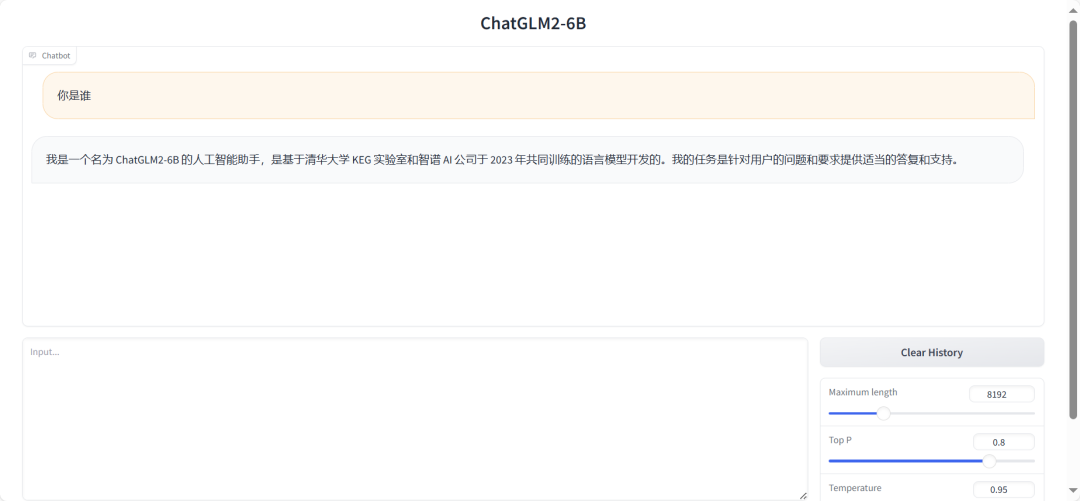

运行结果:

作者简介:

读研期间发表6篇SCI数据挖掘相关论文,现在某研究院从事数据算法相关科研工作,结合自身科研实践经历不定期分享关于Python、机器学习、深度学习、人工智能系列基础知识与应用案例。致力于只做原创,以最简单的方式理解和学习,关注我一起交流成长。需要数据集和源码的小伙伴可以关注底部公众号添加作者微信。

![[PM]流程与结构设计](https://img-blog.csdnimg.cn/img_convert/281209a126f737d58326b06aa7bdee76.png)