不同于LLM或者MLLM那样用于上百亿甚至上千亿参数量的大模型,具身智能端到端大模型并不追求参数规模上的大,而是指其能吸收大量的数据,执行多种任务,并能具备一定的泛化能力,如笔者前博客里的RT1。目前该领域一个前沿工作是Octo: An Open-Source Generalist Robot Policy,该工作由美国Robot Learning顶尖高校(UC Berkeley,Stanford University,Carnegie Mellon University)联合推出,性能超过RT1,值得关注。值得注意的是该工作目前还处于ongoing状态,意味着还在推进中,并不成熟,有很大的提升空间。

项目目标和主要贡献

本工作目标为研发一个开源、广泛使用和通用的机器人操作模型打基础,为此本工作首先在Open X-Embodiment数据集上的800k条机器人轨迹数据上进行预训练。Octo具有高度灵活性:支持多RGB输入;可控制多种机械臂;可通过语言或者图像目标进行引导。更重要的是,Octo Transformer backbone的模块化注意力结构使其可被高效地微调适配拥有新传感器配置、动作空间和形态的机器人。

主要贡献包括:

- 预训练好的27M和93M参数量的权重;

- 微调到新目标领域(target domains)的脚本;

- 完整的预训练流程,包括高效的数据加载器以及相关工具链等,以方便研发人员follow。

octo模型架构

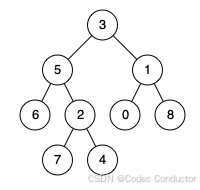

octo【英文全称是octopus,八爪鱼】模型可简单划分为三大部分:输入encoder,输出head和Transformer backbone。

输入encoder:使用一个浅层的CNN网络对图像进行编码,使用t5 base预训练语言encoder对文本进行编码,以及一个可学习的readout。更多细节:

图像编码

- 使用了一个浅层的CNN patch encoders,然后将编码之后的embeddings输入给transformer主干网络中进行学习,相对比于其他大型的image encoder,这样的好处是能够将大部分的数据信息都集中在可扩展的transformer里面训练,有利于网络能够学习到更多的信息,参考(Early Convolutions Help Transformers See Better)

- 如果训练过程是需要使用到目标图像(goal image)作为condition来训练网络,这里采用ViNT的方案将目标图像和观测进行提前融合,然后再将融合的patch token输入到transformer中进行训练,相当于提供一个目标与观测之间的关系信息的网络。

- 对比发现,使用ImageNet等非机器人相关的图像数据训练的权重与不加载权重,最终的效果都是一样的。【与RT1的结论相反】

语言编码 - Language encoder用的是t5-base的模型,模型参数111M,T5的全称为Text to Text Transfer Transformer,是谷歌提出的预训练语言模型领域的通用模型,该模型将所有自然语言问题都转化成文本到文本的形式,并用一个统一的模型解决。为了得到大一统的高质量预训练语言模型,T5不可避免地走上了“大力出奇迹”的道路,使用了更大的模型和更多的数据,但是模型和数据规模只是T5通往最强模型的手段之一,T5最核心的理念是:使用前缀任务声明及文本答案生成,统一所有自然语言处理任务的输入和输出。

Readout - 它在进入序列之前会处理观测和任务tokens,但并不会被任务观测和任务tokens所处理,因此它们(观测和任务tokens)只能被动地读取和处理内在的embeddings,而不能影响他们;

- 有点类似ViT里的cls token,用来作为其他token的汇总,可以认为是summary。

输出head

- 一个轻量级的“action head”被应用到与readout tokens相对应的embeddings上,用于产生所需的输出和计算扩散损失。

Transformer Backbone

- 使用一个Transformer对输入的task和observation tokens进行处理,其注意力pattern是block-wise masked:观测tokens只会和来自同一时刻或者之前时刻的观测tokens或者任务tokens发生关联,不存在的观测则会被完全mask(比如没有语言指令的数据集),这种设计使得可以方便地在微调期间增加或者减少观测或者任务。

预训练数据以及数据处理

训练混合数据包括来自各种机器人demonstration、场景和任务的数据。这些数据集不仅在机器人类型方面是异构的,而且在传感器(例如,包括或不包括腕式相机)和标签(例如,包括或不包括语言指令)方面也是异构的。数据处理主要包括数据过滤、数据平衡以及数据padding:

Data Filter

1,滤除那些不含图像观测和没有使用机械臂末端位姿变化量作为action的数据;

2,然后根据多样性和任务相关性将剩下的数据集进行排序,去除重复性较高的冗余数据、图像分辨率太低的数据和过于小众任务的数据;

data balance

3,根据任务和环境将剩余数据粗略地划分为“更多样性”和“少多样性”数据集,在训练期间将前者的权重加倍,同时降低具有许多数据点的几个大数据集的权重。

图像padding和夹爪动作对齐

- 使用zero-padding的方式对缺失的相机数据进行处理;

- Gripper的指令1代表着open,0代表close。

实验

验证目标

- Octo是否可以控制多个机器人本体,并且可以开箱即用式地解决语言和图像引导的任务?

- Octo是否可以作为一个强大的基石微调到新的任务和机器人?并比重新训练和常用的其他预训练表征更好?

- Octo的设计是否支持微调到新的观测和动作空间?

评测任务

我们在3所机构的6个真实机器人系统上对Octo进行了评估。我们的评估涵盖了各种物体交互(例如“WidowX BridgeV2”)、较长任务long task horizons (例如“Stanford Coffee”)以及精确操作(例如“Berkeley Peg Insert”)。我们评估了Octo在不使用任何预训练数据的情况下,对机器人在环境内的控制能力,以及在使用少量目标域数据(~100 demonstrations)的情况下,对机器人进行高效微调以适应新任务和环境的能力。我们还测试了在使用新观测值(“Berkeley Peg Insert”中的力矩输入)和动作空间(“Berkeley Pick-up”中的关节位置控制)的情况下进行微调的能力。

实验结论一:octo具有一定的zero-shot能力,能在某些任务上开箱即用,由于SOTA的RT1-X和RT2-X

实验结论二:可以在新领域实现高效学习

讨论和结论

存在的问题和可能的解决方法:

- 当前的Octo模型难以处理手腕相机信息,通常只使用第三视角相机微调时结果更强时,一个可能的原因是预训练数据缺乏腕部相机:只有27%的数据包含腕部相机信息,使得腕部摄像头编码器很可能训练不足。添加更多的腕部相机数据或者和第三人称相机编码器共享权重也许能提高表现;

- 我们发现language-conditioned策略与image goal conditioned策略的表现有很大差异,只有56%的预训练数据包含语言注释,这可能会降低language-conditioned策略的性能。除了在预训练组合中添加更多的语言注释数据外,也可以关注语言信息的融合策略,比如设计observation与language之间的cross attention。

将来计划

- 更好地language conditioned;

- 支持腕部相机;

- 使用更多更好的专家演示数据。

附录:一些消融尝试

有改进的尝试

- Using action chunking: We found it helpful to use “action chunking”to predict multiple actions into the future, for getting more coherent policy movements. We did not find temporal ensembling of future actions to provide additional benefits in the finetuning tasks we tested. 使用action chunking可以取得更好的预测结果

- Decreasing patch size Tokenizing images into patches of size 16 × 16 led to improved performance over patches of size 32 × 32, particularly for grasping and other fine-grained tasks. This does add compute complexity (the number of tokens is 4×), so understanding how to balance compute costs and resolution remains a problem of interest. 图像patches的设计影响也很大,16x16优于32x32

- Increasing shuffle buffer size: Loading data from 25 datasets in parallel is a challenge. Specifically, we found that achieving good shuffling of frames during training was crucial — zero-shot performance with a small shuffle buffer (20k) and trajectory-level interleaving suffered significantly. We solved this issue by shuffling and interleaving frames from different trajectories before decoding the images, allowing us to fit a much larger shuffle buffer (up to 500k). We also subsample at most 100 randomly chosen steps from each training trajectory during data loading to avoid “over-crowding” the shuffle buffer with single, very long episodes.

无改进的尝试

- MSE Action Heads: i.e., replacing our diffusion decoding head with a simple L2 loss, lead to “hedging” policies that move very slowly and e.g., fail to rotate the gripper in Bridge evals.

- Discrete Action Heads: i.e., discretizing actions into 256 bins per dimension and training with cross-entropy loss; lead to more “decisive” policies, yet often observe early grasping issues.

- ResNet Encoders: train faster as they compress the image into fewer tokens, but attain worse zero-shot performance.

- Pretrained Encoders: ImageNet pretrained ResNet encoders did not provide benefit on zero-shot evals, though may be confounded with ResNet architectures underperforming as mentioned above.

- Relative Gripper Action Representation: when aligning the gripper action representations of the different datasets, we tried (A) absolute gripper actions, i.e.,17 actions are +1 when the gripper is open and -1 if it is closed, and (B) relative gripper actions, i.e., gripper action is +1/-1 only in the timestep when the gripper opens/closes. We found that the latter tends to open/close grippers less often since most of the training data represents “do not change gripper” actions, leading to a slightly higher grasp success rate. At the same time, the relative representation led to less retrying behavior after a grasp failed, which was ultimately worse.

- Adding Proprioceptive Inputs: resulting policies seemed generally worse, potentially due to a strong correlation between states and future actions. This might be due to a causal confusion between the proprioceptive information and the target actions。

- Finetuning Language Model: In order to improve the visuo-lingual grounding of Octo we experimented with: i) varying sizes of the T5 encoder small (30M), base (111M), large (386M) and ii) finetuning the last two layers of the encoder. While using the base model resulted in better language-conditioned policies, we did not find improvements when using even larger encoders or finetuning the encoder. This might be due to the lack of rich, diverse, free-form language annotations in most of the datasets.

个人观点

octo首次向研究者展示了具身智能端到端操作大模型的理想范式:支持多种观测、多种condition输入,也支持多种action输出,且可在少量数据上实现高效率学习,支持控制多种不同型号的机器人,这个工作放在将来来看很可能是一个milestone,但目前还有着许多技术和理论问题待解决,具身智能的scaling law还在研究探索中,尤其是跨场景和跨机器人本体泛化性问题【该问题是通用具身智能需要的,在很多工业场景并不怎么需要,所以沿途下蛋还是有希望的】,这种可插拔式的架构设计有望成为具身智能端到端操作大模型的典范。

![[pwn]静态编译](https://img-blog.csdnimg.cn/img_convert/3b29f2825a5d3bd650025cb4b2c266c9.png)