AI 容器镜像——面向云上全容器场景

王坚院士提到,算力是人工智能发展的三要素之一,而云计算是最好的提供算力的技术手段,英伟达的黄仁勋也表达过类似的观点。可以说,大模型时代下的 AI,天然就是在云场景里的。

容器镜像是云时代软件和应用分发、部署的事实标准,在容器引擎、集群管理系统的加持下,容器镜像可以让应用快速达到大规模分发、便捷部署的目的,并且提供了整个集群下应用的一致性保障,方便系统管理员进行应用运维。而在当前的 AI 和云计算的融合之下,如何复用容器镜像在分发和部署上的成熟能力,还能提供面向 AI 软硬件技术栈开箱即用的产品能力,是很多云上客户的需求。

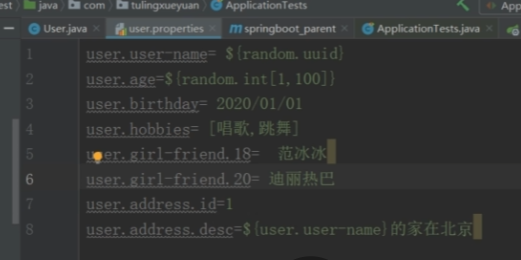

用户在整个 AI 应用场景下,除了数据获取和经验积累外还存在大量前置准备和后端优化工作,而对于新入门的 AI 用户,前置准备阶段就会消耗较多的时间和精力。以 AI 系统镜像部署为例——用户想要部署自己的 AI 应用就需要进行以下操作:先获取操作系统基础镜像,然后在基础镜像上部署 runtime、AI 框架(TensorFlow、pytorch 等),最后再部署模型。这些基础环境的部署需要花费大量的精力,而针对镜像本身的安全性、维护也都存在一些问题,都在占用用户的时间和人力。

另外,针对后期的推理和训练部分,大部分用户都是直接使用开源软件和云厂商 PaaS 平台,对于推理和训练的性价比就只能交给开源和云厂商了。这里就需要厂商能够提供更好的性能,并且通过统一的 AI 容器运行环境来保障系统的兼容性和稳定性。

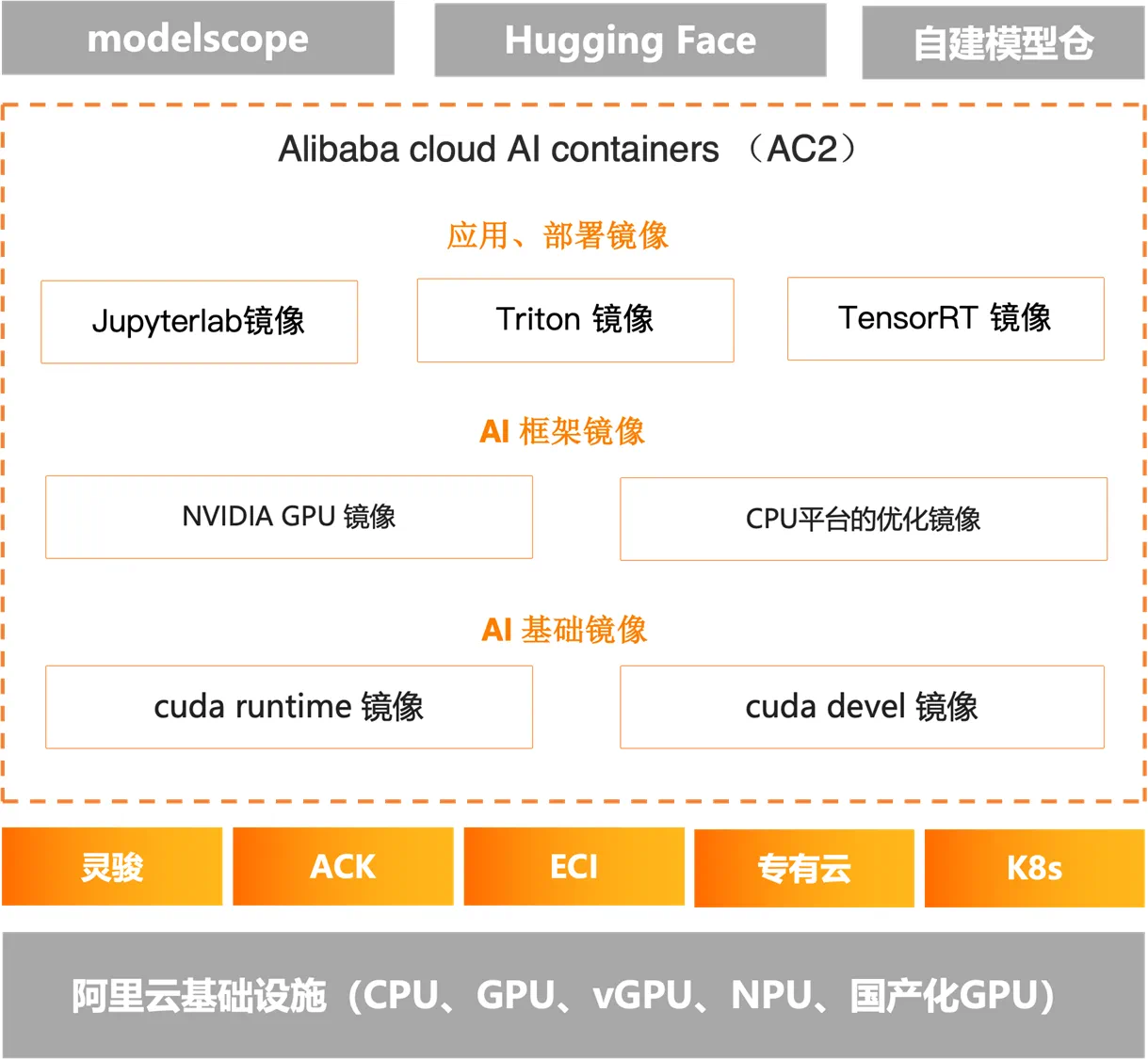

基于这类需求,已经有一些企业推出了面向 AI 场景的系列容器镜像产品。今天推荐的是龙蜥社区理事长单位阿里云的AI 容器镜像 ——Alibaba Cloud AI Containers(简称 AC2)。Alibaba Cloud AI Containers(AC2)通过提供开箱即用的 AI 应用环境,包括内置 CUDA AI 库、AI 框架 PyTorch 等,内置Intel、AMD、NVIDIA 等硬件厂家在 AI 生态上原生适配,并结合阿里云基础设施进行性能优化、兼容性和稳定性保障,让用户可以在阿里云上全容器场景下有更好的使用体验。

更多介绍可进入官网查看:

阿里云AI容器镜像

AC2 于 2024 年 4 月份正式上线。截止目前,已帮助数十家企业解决了 AI 场景下的不同问题,涵盖金融、券商、电商、自动驾驶等领域。其中具有代表性的是 助力 ZOLOZ (世界领先的身份认证和安全解决方案的公司)解决在视觉 AI 认证领域的算力与成本问题,本文将详细介绍——ZOLOZ 如何借助 Alibaba Cloud AI Containers(AC2),实现低成本高性能的完美提优。

(图/Alibaba Cloud AI Containers 产品架构)

案例推荐:ZOLOZ,视觉 AI 推理的算力和成本问题求解

ZOLOZ 是蚂蚁数科的身份安全品牌,致力于提供世界领先的身份认证和安全解决方案,核心产品囊括可信身份认证、反洗钱、终端安全等,为中国、印尼等 14 个国家和地区的 70 余家合作伙伴提供技术服务。其中 ZOLOZ RealId 产品采用大量深度学习模型提供实人认证、人脸识别、证件核验等组合能力,帮助客户解决数字化渠道下实人认证相关的体验和安全问题,应用于金融业务核身、人证核验、人脸注册/登录等多种场景。

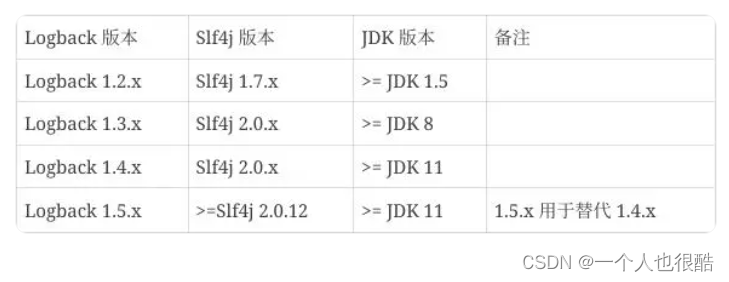

(图/视觉 AI 技术在ZOLOZ RealID产品中的典型应用)

项目挑战:算力和成本等

为了提升视觉 AI 推理效率,给用户提供更加安全、实时性的实人认证服务,提升竞争优势,ZOLOZ 希望重点解决视觉 AI 推理在算力和成本等层面的挑战:

-

在保证视觉 AI 推理精度的同时,提升吞吐率。ZOLOZ 核心模型不仅需要在单位时间内处理海量的请求,还必须确保处理时间在严格的时延阈值范围内,以实现出色的用户体验。

-

采用 CPU 进行小模型推理服务,获取更高的成本效益。通过软件优化充分释放硬件潜力,有效利用服务器资源,从而降低认证服务的总体拥有成本(TCO)。

-

提升视觉 AI 服务敏捷性,高效部署模型。简化应用部署流程,提升 AI 服务开发效率。

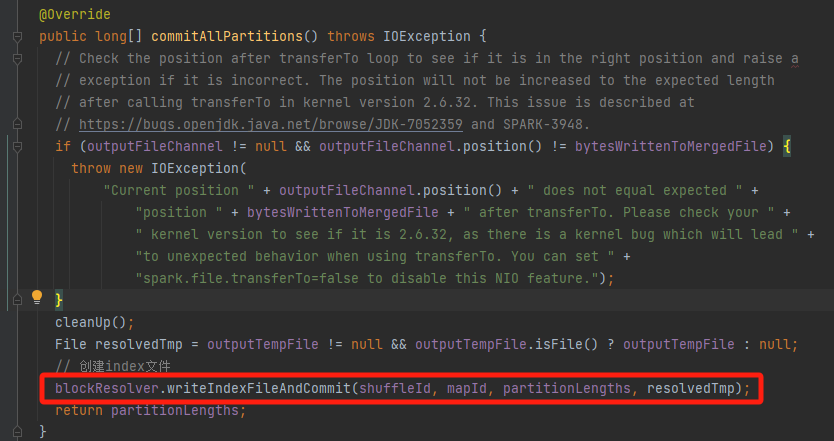

项目方案:AC2+Intel OpenVINOTM

面对如上挑战,ZOLOZ 与阿里云、Intel 展开合作。通过 Alibaba Cloud AI Containers(AC2)产品并利用 Intel 的开源 AI 工具套件 OpenVINO™,在第五代英特尔® 至强® 可扩展处理器构建端到端的深度学习应用流程,提升推理性能优化效果,在 CPU 上实现高效的深度学习模型推理。

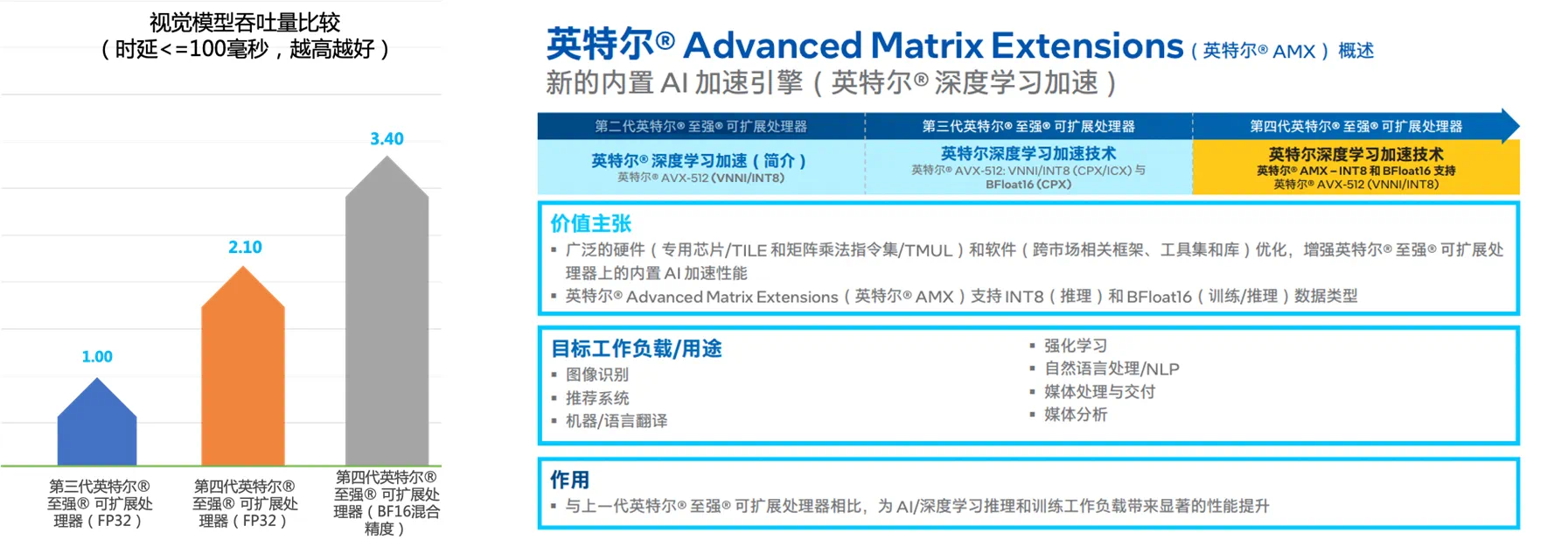

针对视觉 AI 推理服务成本较高的挑战,ZOLOZ 选择了小模型推理服务 CPU 化的策略,即采用英特尔® 至强® 可扩展处理器处理负载压力与时延要求相对较低的模型推理服务。这种方式有助于 ZOLOZ 高效利用现有的 CPU 资源,降低在 GPU 部署与运维方面的高昂成本。为了进一步加速视觉 AI 推理服务的性能表现,ZOLOZ 采用了第五代英特尔® 至强® 可扩展处理器,并利用处理器集成的英特尔® AMX 加速引擎,以及英特尔® OpenVINO™ 等软件套件进行优化。在多个视觉 AI 模型中,ZOLOZ 通过采用英特尔® AMX 加速技术,动态将模型数据类型从 FP32 转换为 BF16,从而在可接受的精度损失下,增加吞吐量并加速推理。为了验证优化后的性能提升,ZOLOZ 将使用英特尔® AMX 加速技术转换后的 BF16 模型,与基准 FP32 模型的推理性能进行了比较。在将模型转化为 BF16 之后,模型推理性能可实现 3.12-4.03 倍的提升,同时精度损失大部分可以控制在 0.01%-0.03%。

针对视觉 AI 推理服务部署难的挑战,ZOLOZ 选择了Alibaba Cloud AI Containers(AC2)产品。AC2 预先安装了各种流行深度学习框架和库,最大程度释放来自 CPU、GPU 硬件能力,降低用户在 AI 场景下的使用难度。AC2 设计为即插即用,非常方便快速将 AI 服务部署到阿里云托管服务上,如 PAI、ECI、ACK 或者自定义的 ECS 实例。AC2 将 ZOLOZ 常用的软件技术栈都内置在镜像中,并为阿里云的计算优化实例以及 ECS 实例进行优化,确保在 AI 推理时能获得最高性能。同时阿里云基础软件团队会定期更新 Alibaba Cloud AI Containers(AC2),修复安全漏洞,极大减少了 ZOLOZ 维护容器相关负担,让 ZOLOZ 能够更专注于 AI 能力的构建。而非环境的搭建和配置,也简化了 ZOLOZ 应用部署流程,在提升开发效率方面起到了重要的作用。

在 ZOLOZ 的 AI 推理优化过程中,通过 Alibaba Cloud AI Containers(AC2)产品,利用 Intel 的开源 AI 工具套件 OpenVINO™充分加速释放第五代英特尔® 至强® 可扩展处理器在处理 AI 推理工作负载方面的巨大潜力,从而帮助ZOLOZ 显著提升端到端推理性能,并解决实际的业务问题。对于用户而言,该解决方案有助于降低部署专用加速器(例如独立显卡)时的开销,以及更有效地控制地址标准化的总体拥有成本 (TCO)。

项目成果:便捷、高效、低成本

-

ZOLOZ 采用 Alibaba Cloud AI Containers(AC2)镜像后,更加便捷安全部署 AI 服务,加速 DL 模型的应用,最大限度地发挥技术的价值。

-

ZOLOZ 能够在保证视觉模型符合推理时延 <= 100 毫秒的同时,将推理的吞吐量提升到 3.4 倍。同时在将模型量化到 BF16 之后,AI 推理精度依然能够满足需求。

-

基于 CPU 的推理方案具备媲美高端 GPGPU 的性能表现,同时在成本、灵活性等方面具备更强的优势。通过软件优化充分释放了硬件潜力,有效利用服务器资源,从而降低了实人认证服务的 TCO。

此次 ZOLOZ 与 Alibaba Cloud AI Containers(AC2)、 Intel 的深度合作,不仅是技术融合的典范,更是推动全球智能化进程的重要里程碑。三方将各自的专长与资源紧密结合,共同探索AI技术的无限可能。未来,我们期待这一联盟合作能够持续推动行业创新,也希望更多的企业牵手 Alibaba Cloud AI Containers(AC2),探讨更多合作可能性,共同为全球用户带来更安全、更高效、更具成本效益的智能解决方案,一起开启智能时代的新篇章。

附:

Alibaba Cloud AI Containers (AC2):作为阿里云官方精心打造的一系列AI容器镜像集合,正引领行业迈向AI应用的新高度。AC2 集成了多种硬件加速库、优化的 AI 运行时环境以及广泛适用的AI框架,全方位满足用户多样化的场景需求。通过与阿里云ECS(Elastic Compute Service)、ACK(Container Service for Kubernetes)和ECI(Elastic Container Instance)等基础设施的深度整合与优化,AC2 不仅显著提升了云上AI应用的性能表现,更确保了用户能够享受到流畅无阻的AI体验,加速业务创新步伐。

Intel 大模型优化团队:Intel 是全球计算创新的领导者,其大模型优化团队专注于为高性能计算和人工智能应用提供前所未有的性能提升。在本次合作中,Intel 针对 AC2 容器镜像进行了深度优化,特别是在人脸认证与证书认证等关键业务场景下,为 ZOLOZ 量身定制了优化方案。这一系列优化工作不仅助力 ZOLOZ 在香港和印尼两地顺利部署 AI 模型业务,实现了业务性能的翻倍提升,还有效降低了用户的使用成本,为全球用户提供更加高效、安全的认证体验。