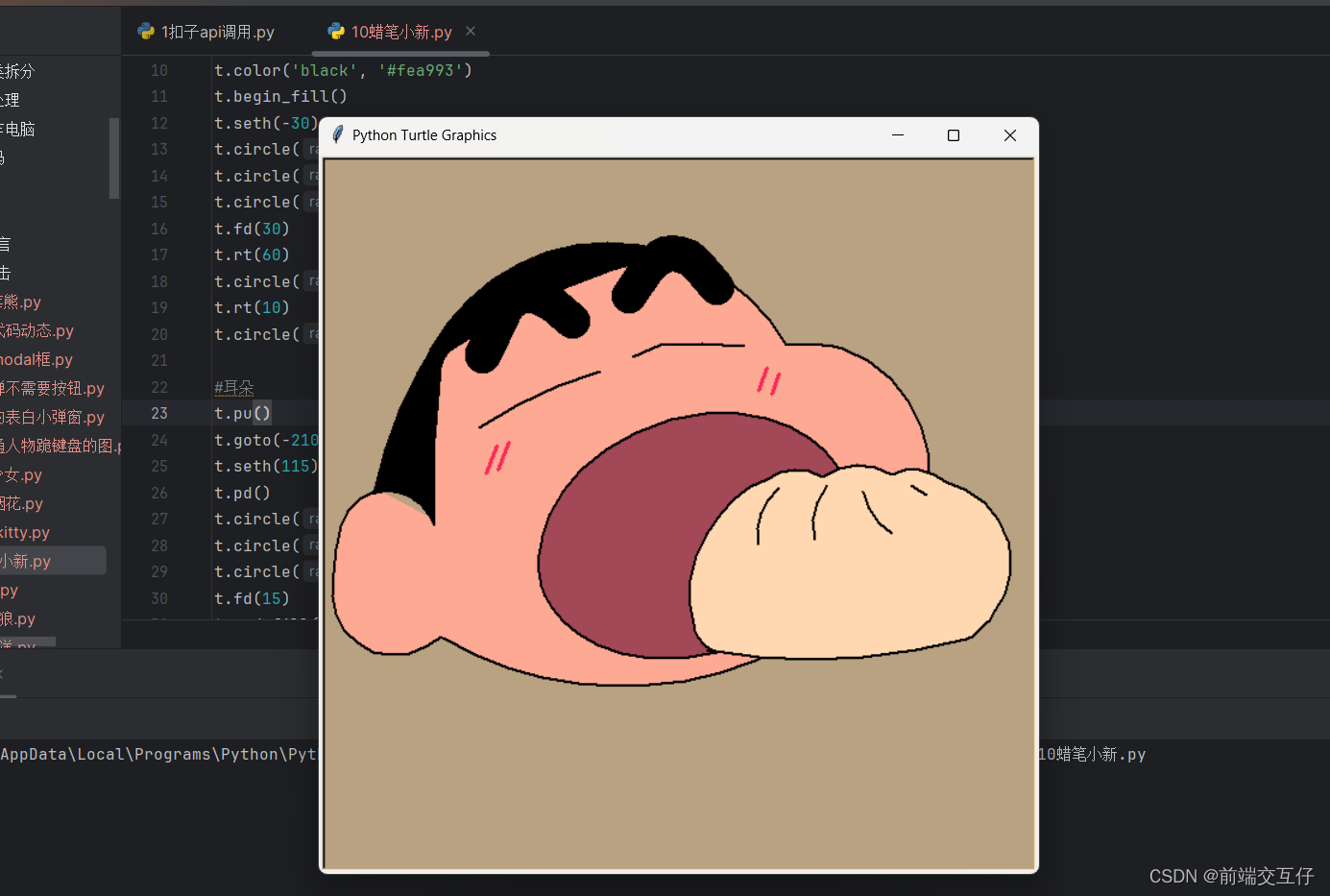

现在,大多数 .com 公司已于 2023 年更名为 .ai,那么价值万亿美元的问题是:接下来会发生什么?哪些关键障碍、工具、技术和方法将重塑格局

企业 AI 的不同之处在于,它专注于可衡量、可管理的输出,企业可以控制这些输出并将其品牌与之联系起来。今年将以技术工具为主,使 GenAI 克服挑战,成为一种可靠的工具,而不仅仅是潜力。

数据科学家在预测自己领域的未来方面确实很糟糕(双关语!)。因此,请以 95% 的置信区间来看待这些预测 :)

图片由 Dall-E 生成

1. 资本支出周期的转变

现在,没有一家企业没有投资 GenAI。今年某个时候,这些投资将开始产生回报。新技术的资本支出 (capex) 产品周期通常遵循 18 个月的周期:18 个月投资,18 个月寻找市场,然后决定是进一步发展以达到顶峰还是投资其他地方。

构建 GenAI PoC 很容易,但将其投入生产却极具挑战性,因为存在幻觉、治理、缺乏评估标准和架构混乱等问题。

到 2024 年秋季,我们将看到公司试图为去年春季开始嵌入 AI 的所有产品找到产品与市场的契合度。这意味着有些公司会错失良机,而精益求精的人才会脱颖而出。这意味着那些没有找到产品与市场契合度的公司将面临有关投资和团队的艰难决策。

这是否意味着 GenAI 泡沫将要破裂?远非如此。然而,我们将看到企业进行整合,不仅关注 PoC 项目,还将关注今年秋季末投入生产的项目。而那些没有达到要求的企业要么拿出资金,要么撤资。

2.推理优化

到目前为止,大多数 GenAI PoC 最容易被忽视的领域是运行这些基于 LLM 的大型推理的成本。它看起来可能单价很小,但对于一家拥有几百万次推理调用的中型公司来说,成本很快就会累积起来。

报道芯片市场的新闻通讯 SemiAnalysis 在 2 月份估计,OpenAI 处理 GPT-3.5 提示花费了 0.0036 美元。按照这个速度,如果谷歌使用 GPT-3.5 来回答其搜索引擎每秒收到的约 32 万个查询,其营业收入将从每年 555 亿美元降至 195 亿美元。2 月份,谷歌表示,节省处理成本是其将 Bard 聊天机器人建立在其 LaMDA 大型语言模型的相对较小版本上的原因。

今年的重点将是开发推理优化方法。该领域将通过考虑各种因素来平衡成本效益,以提供推理服务,例如准确性、ROI 预测、底层本地部署与云基础架构与 SaaS 模型、LLM 的大小,以及它应该是 RAG 还是微调或自定义调整模型。

这是一个复杂的问题,人工智能领导层需要提前考虑,以免在将 GenAI 投入生产后遭遇账单冲击。请关注正在为加速计算开发的新框架,这些框架可以更快地运行模型或降低计算要求。

3. 再见“提示词优化”(欢迎回来 微调)

提示词调整是一种很好的建立基线的技术,但还不足以构建生产级解决方案。提示词调整是一种零样本学习方法,它不会调整张量的值。这意味着它不会学习任何特定于您的企业数据集的内容。毕竟,如果您的聊天机器人听起来和其他人一样,为什么有人会更喜欢你而不是他们呢?是什么让您的 GenAI 与众不同?

虽然提示词调整可以快速体现价值而无需训练任何模型,但它也存在固有的局限性。最终,你会得到一个推理成本过高且过于通用的解决方案。微调可以解决这个问题。

对于任何想要使用 GenAI 为客户增加价值的公司来说,它都需要带来其数据的独特性。而实现这一目标的方法要么是 RAG(Retriever Augmented Generation),要么是微调。RAG 与微调之间的争论是错误的,因为它取决于用例和您拥有的数据类型。

对于生成式问答来说,RAG 是更好的选择,而 Fine-Tuning 则适合其他问题,例如 text2sql。

虽然 Prompt Tuning 会作为一种方法继续存在,但它只是 GenAI 流程中的一个步骤,而不是流程本身的结束。对于任何拥有大量数据的企业来说,使用 LLM 嵌入作为基础模型,然后在此基础上构建自定义或微调模型更有意义,这种模型更轻量、更便宜、更好。

留意为“ AI中间件”创建的新空间,该空间具有更高的抽象框架,可以轻松微调模型(如SuperKnowa)。

4. SLM,MLM和VSLM的兴起

你不需要用大炮来杀死蚊子!

继续之前的主题,如果您知道如何针对您的数据调整或训练较小的模型,您可以获得更好、更便宜的模型。这将引发人们对 SLM(小型语言模型)和 MLM(中型语言模型)的新兴趣,这些模型通常具有少于 7B 的参数,并且可以轻松安装在单个 GPU 上。

使用较大的模型进行实验不仅成本高昂,而且速度也很慢。在 20B LLM 上运行实验需要很长时间。另一个关键驱动因素是 GPU 短缺,这种情况将持续到 2024 年。

我预计,我们将看到甚至极小的语言模型(参数少于 10 亿)的兴起,这些模型可以安装在边缘设备上,将 GenAI 嵌入硬件中,并快速进行自定义训练,而无需 GPU。目前已有用于各种 NLP 任务的可嵌入NLP 库,这些库内部使用 2 亿到 3 亿个参数模型。

5. 多 - 多 - 多

多模型、多模式和多云 — 这些是您今年会多次听到的术语。为任何企业协调这些众多选项都会产生一系列新问题。今年,AI 领导者需要解决一些挑战:

- 企业希望在其架构中支持多少个不同的 LLM?(请记住,由于 GPU 短缺,仅加载和推断 34B 参数的 LLM 就需要 6 个 GPU)。我们是想支持所有模型,还是选择更多较小的模型,或者几个中型模型,或者一个大模型和一个小模型?

- 在单一云上运行既有风险又昂贵,那么我们如何管理跨多个云与本地 LLM 的工作负载?通常,本地模型部署从长远来看可以节省大量资金,并且可以更好地控制治理和产出。

- 多模式——将文本与图像、视频和音频相结合将是一个值得关注的主题。这些多模式模型的部署仍然是一个需要工具开发的领域。

6. 阿基里斯·希尔——“人工智能治理”

如果说 GenAI 有一个领域让高管们夜不能寐,那就是 AI 治理。他们不知道他们的聊天机器人应用程序何时会散播错误信息,他们将不得不支付罚款(如加拿大航空案),或者何时会说出仇恨内容并被下架(如谷歌),或者如何遵守欧盟法律等新法规。

所有公司都想知道的答案是,一旦投入生产,它会做什么。尚未解决的问题是“如何衡量”它。没有简单的指标或解决方案来衡量幻觉,尤其是当涉及到没有普遍基本事实的特定领域数据(如政策)时。另一个挑战是合规性工具,就像审计目的一样。让黑匣子变得开放和可预测是一个挑战,它阻碍了许多公司将他们的 GenAI PoC 推向生产。

预计在私人和公共空间中都会有大量关于这个问题的讨论。希望美国国会能通过一些法律,并让行业采用一套可接受的通用标准(类似于制药药物试验的标准)。当然,这其中很多都是一厢情愿的想法,在此之前,像WatsonX.Governance这样的工具将是必不可少的。

7. 绝地归来(又名数据科学家)

去年,看起来成为一名人工智能工程师就是从事人工智能的全部需要(一些误导性的新报告声称,成为一名人工智能工程师可以为你提供 90 万美元的薪水,不含工资可以达到 40 万美元)。

今年最后一个但可能很难实现的变化是,人们认识到仍然非常需要数据科学家来推动 GenAI 从潜力到效力。

首先,两者有什么区别?传统的 ML 需要训练模型,数据科学家会利用他们的统计和算法专业知识来使模型适合您的用例。有了 LLM,您已经有一个预先训练好的模型,所以人们认为您不再需要这样做了。无论你需要什么,都可以用 Prompt Tuning 来完成,这是一种智能英语写作。因此,AI 工程师的数量激增,他们不太关注科学部分,而更专注于 ML-Ops 工程,以在应用程序内部配置、集成和部署 GenAI。

事实证明,现实情况要复杂一些,尤其是对于企业 GenAI 而言。以 RAG 应用程序为例。为几十个文档构建 RAG 很容易,但当文档数量达到几百万时,您需要了解检索器和重新排序算法(如 KNN、编码器、BM-25)深度的技能。对于另一个用例(如 text2sql),您需要微调模型的技能(即 PEFT、Beam Search 等)。此外,所有 GenAI 应用程序都需要评估模型的技能,并提出适合该数据集和用例的正确统计指标(如 NDCG、Fleiss-Kappa)。所有这些都意味着统计和 ML 算法的核心技能仍然非常重要,仅仅把这些框框放在一起是不够的。

因此,数据科学家将以绝地武士的身份回归,让 GenAI 焕发活力。核心统计技能将成为您快速提供高精度 GenAI 解决方案的关键因素。

期待意外

人工智能的魅力在于它的不可预测性(这不是缺陷,而是一种特性,因为一切都建立在概率之上)。包括 Sam Altman 在内的所有人都未能预测到当前的 GenAI 浪潮。我们第一次看到这一点是在 2012 年视觉模型的高潮和对自动驾驶汽车的炒作中。现在,LLM又迎来了一次繁荣。

所有企业都应该预料到,他们自己的计划可能会因为一些表现优于预期的新模型(如 Llama3 或 GPT5)或一些完全不同、出乎意料的东西而被打乱。新的模型、方法、数据集或服务器可能会扰乱局面。无论好坏,GenAI 中总是会出现意想不到的情况。