一、定义

1、对于卷积,我们另一个超参数是核的大小,通常使用的卷积核是3×3或者5×5,很少用偶数核

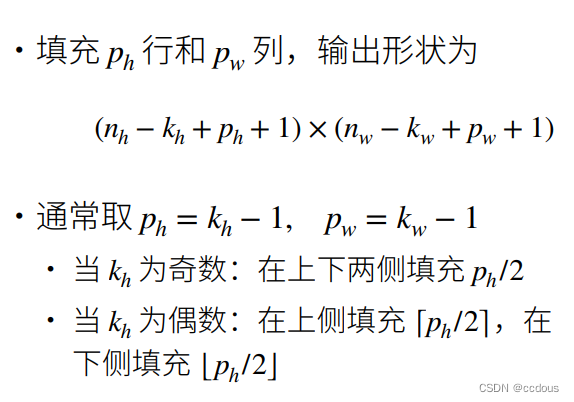

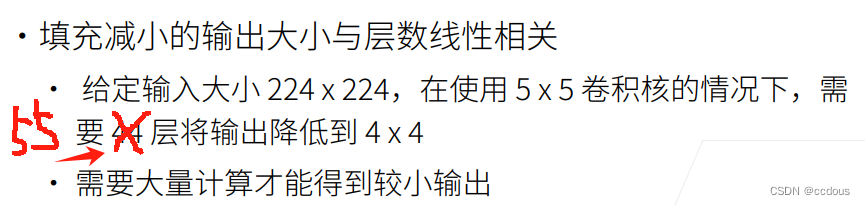

2、填充是为了让输出不变或者变大,是为了在输入不太大,又能使模型足够深的情况下使用

3、填充:在输入周围添加格外的0的行和列

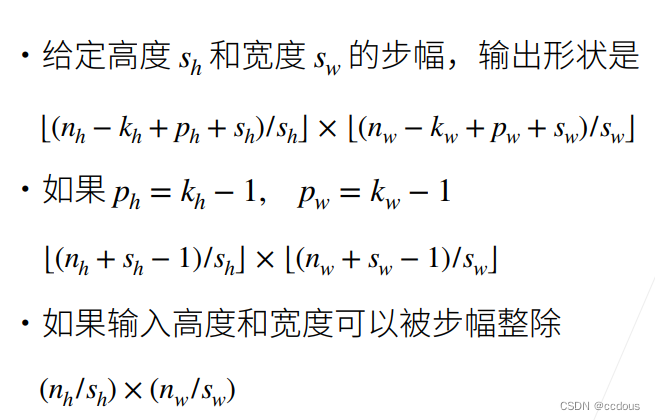

4、步幅:行和列的滑动步长

(1)输出大小与层数线性相关,加入了步幅能使之线性相关,步幅将模型输出成倍的减少,使得我的计算量不会过于复杂

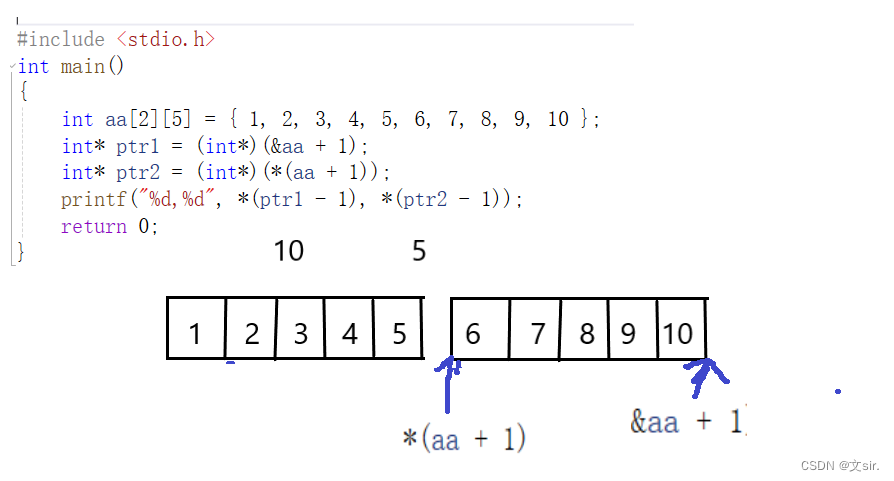

(2)n是输入,k是卷积核,p是填充,s是步幅

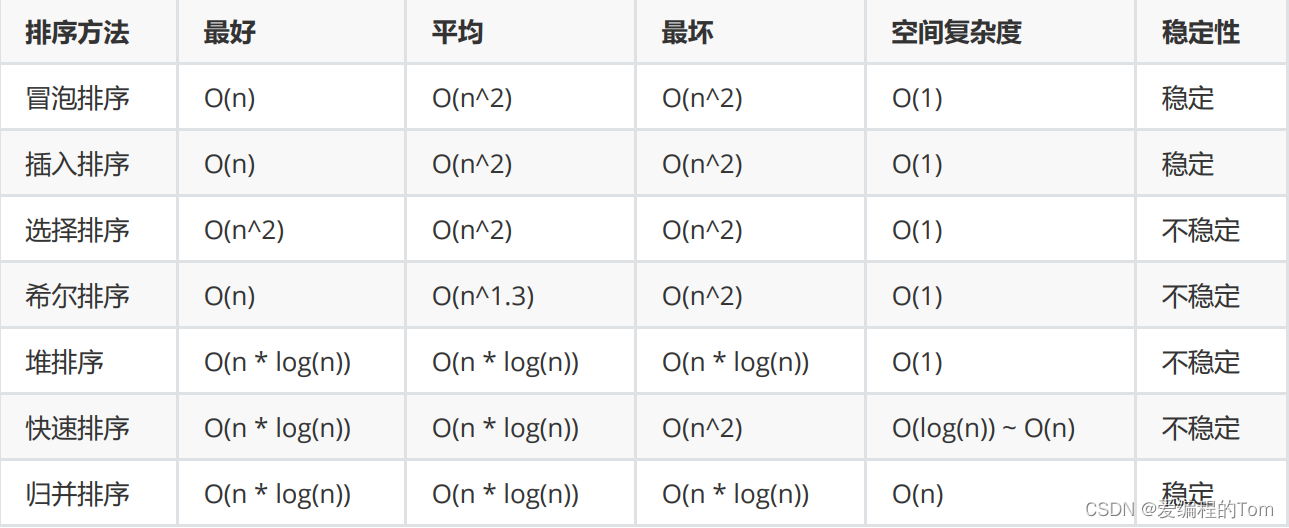

5、总结

(1)填充和步幅是卷积层的超参数

(2)填充在输入周围添加额外的行/列,来控制输出形状的减少量

(3)步幅是每次滑动核窗口时的行/列的步长,可以成倍的减少输出形状

二、代码

1、填充

import torch

from torch import nn

# 为了方便起见,我们定义了一个计算卷积层的函数。

# 此函数初始化卷积层权重,并对输入和输出提高和缩减相应的维数

def comp_conv2d(conv2d, X):

# 这里的(1,1)表示批量大小和通道数都是1,将X.shape追加到(1, 1)后面

X = X.reshape((1, 1) + X.shape)

Y = conv2d(X)

# 省略前两个维度:批量大小和通道

#Y.shape[2:] 表示从 Y.shape 中的第三个维度开始取到最后一个维度(即去除了前两个维度)

return Y.reshape(Y.shape[2:])

# 请注意,这里每边都填充了1行或1列,因此总共添加了2行或2列

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1)

X = torch.rand(size=(8, 8))

comp_conv2d(conv2d, X).shape

-》》torch.Size([8, 8]) #8+2-3+1=8

2、步幅

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1, stride=2) comp_conv2d(conv2d, X).shape

-》》torch.Size([4, 4]) #(8+2-3+1)/2=4

3、总结

(1)填充可以增加输出的高度和宽度。这常用来使输出与输入具有相同的高和宽。

(2)步幅可以减小输出的高和宽,例如输出的高和宽仅为输入的高和宽的1/𝑛(𝑛是一个大于1的整数)。

(3)填充和步幅可用于有效地调整数据的维度。