文章目录

- 前言:

- 今日所学:

- 1. 数据集加载

- 2. 数据集迭代

- 3. 数据集常用操作与自定义数据集

前言:

今天学习的是数据集的内容。首先,数据是深度学习的基石,高质量的数据输入能够在整个深度神经网络中发挥积极作用。MindSpore通过基于Pipeline的数据引擎,实现了高效的数据预处理,这个数据引擎包括数据集(Dataset)和数据变换(Transforms)两部分。其中,Dataset是Pipeline的起点,用于加载原始数据。mindspore.dataset模块提供了内置的文本、图像、音频等数据集加载接口,还学习了自定义数据集的加载等内容。

今日所学:

1. 数据集加载

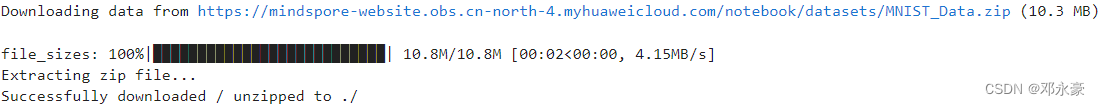

首先我们学习了数据集的加载,我们使用Mnist数据集作为样例来介绍了mindspore.dataset进行加载的方法,然后因为对应的接口仅支持解压后的数据文件,使用download库来下载数据集并进行解压。代码如下:

# Download data from open datasets

from download import download

url = "https://mindspore-website.obs.cn-north-4.myhuaweicloud.com/" \

"notebook/datasets/MNIST_Data.zip"

path = download(url, "./", kind="zip", replace=True)

解压把压缩文件删除之后,我们可以通过加载看到对应的数据类型:

train_dataset = MnistDataset("MNIST_Data/train", shuffle=False)

print(type(train_dataset))

2. 数据集迭代

在第二个部分,我们学习了数据集的迭代,在数据集进行了加载之后,一般通过迭代的方式来获取数据,然后送入神经网络进行训练。在这个部分当中,我们使用相关的接口来创建了数据迭代器,迭代访问数据。通过如下的一个可视化函数来迭代了九张的图片来进行了一个这个部分的展示。

下面代码定义一个可视化函数,迭代9张图片进行展示:

def visualize(dataset):

figure = plt.figure(figsize=(4, 4))

cols, rows = 3, 3

plt.subplots_adjust(wspace=0.5, hspace=0.5)

for idx, (image, label) in enumerate(dataset.create_tuple_iterator()):

figure.add_subplot(rows, cols, idx + 1)

plt.title(int(label))

plt.axis("off")

plt.imshow(image.asnumpy().squeeze(), cmap="gray")

if idx == cols * rows - 1:

break

plt.show()

3. 数据集常用操作与自定义数据集

在第三个部分,我们讲解了数据集常用的操作。包括了数据集随机shuffle操作来消除数据排列造成的分布不均的问题、map操作来对数据进行预处理操作、batch操作将数据集打包为固定大小的batch从而保证梯度下降的随机性和优化计算量。通过这些数据及常用的操作我们进一步的了解了数据集的相关内容。

然后在之后还根据自定义数据集的内容,讲解了不同方法来自定义数据集下面是相关方法的代码与结果。

可随机访问数据集:

# Random-accessible object as input source

class RandomAccessDataset:

def __init__(self):

self._data = np.ones((5, 2))

self._label = np.zeros((5, 1))

def __getitem__(self, index):

return self._data[index], self._label[index]

def __len__(self):

return len(self._data)

loader = RandomAccessDataset()

dataset = GeneratorDataset(source=loader, column_names=["data", "label"])

for data in dataset:

print(data)

# list, tuple are also supported.

loader = [np.array(0), np.array(1), np.array(2)]

dataset = GeneratorDataset(source=loader, column_names=["data"])

for data in dataset:

print(data)

得到如下结果:

[Tensor(shape=[2], dtype=Float64, value= [ 1.00000000e+00, 1.00000000e+00]), Tensor(shape=[1], dtype=Float64, value= [ 0.00000000e+00])]

[Tensor(shape=[2], dtype=Float64, value= [ 1.00000000e+00, 1.00000000e+00]), Tensor(shape=[1], dtype=Float64, value= [ 0.00000000e+00])]

[Tensor(shape=[2], dtype=Float64, value= [ 1.00000000e+00, 1.00000000e+00]), Tensor(shape=[1], dtype=Float64, value= [ 0.00000000e+00])]

[Tensor(shape=[2], dtype=Float64, value= [ 1.00000000e+00, 1.00000000e+00]), Tensor(shape=[1], dtype=Float64, value= [ 0.00000000e+00])]

[Tensor(shape=[2], dtype=Float64, value= [ 1.00000000e+00, 1.00000000e+00]), Tensor(shape=[1], dtype=Float64, value= [ 0.00000000e+00])]

[Tensor(shape=[], dtype=Int64, value= 2)]

[Tensor(shape=[], dtype=Int64, value= 0)]

[Tensor(shape=[], dtype=Int64, value= 1)]

可迭代数据集:

# Iterator as input source

class IterableDataset():

def __init__(self, start, end):

'''init the class object to hold the data'''

self.start = start

self.end = end

def __next__(self):

'''iter one data and return'''

return next(self.data)

def __iter__(self):

'''reset the iter'''

self.data = iter(range(self.start, self.end))

return self

loader = IterableDataset(1, 5)

dataset = GeneratorDataset(source=loader, column_names=["data"])

for d in dataset:

print(d)

得到如下结果:

[Tensor(shape=[], dtype=Int64, value= 1)]

[Tensor(shape=[], dtype=Int64, value= 2)]

[Tensor(shape=[], dtype=Int64, value= 3)]

[Tensor(shape=[], dtype=Int64, value= 4)]

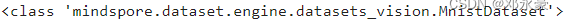

生成器:

# Iterator as input source

# Generator

def my_generator(start, end):

for i in range(start, end):

yield i

# since a generator instance can be only iterated once, we need to wrap it by lambda to generate multiple instances

dataset = GeneratorDataset(source=lambda: my_generator(3, 6), column_names=["data"])

for d in dataset:

print(d)

得到如下结果:

[Tensor(shape=[], dtype=Int64, value= 3)]

[Tensor(shape=[], dtype=Int64, value= 4)]

[Tensor(shape=[], dtype=Int64, value= 5)]

以上就是今天我所学习的内容啦~