-

准备:虚拟机:centos7

-

安装Docker:首先,需要安装Docker,因为Ollama和MaxKB都是基于Docker的容器。使用以下命令安装Docker:

sudo yum install -y yum-utils device-mapper-persistent-data lvm2

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

sudo yum install docker-ce docker-ce-cli containerd.io

sudo systemctl start docker

sudo systemctl enable docker

docker -v

- 配置镜像源

vi /etc/docker/daemon.json

建议镜像源:

{

"registry-mirrors" : [

"https://docker.m.daocloud.io",

"https://dockerproxy.com",

"https://mirror.ccs.tencentyun.com"

]

}

- 安装Ollama:Ollama是一个用于自然语言处理和机器学习的Python库。使用以下命令安装Ollama:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

- 安装MaxKB:MaxKB是一个用于知识图谱构建和分析的Python库。使用以下命令安装MaxKB:

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data --privileged=true 1panel/maxkb

受限于国内镜像站,可能无法下在maxkb镜像,可以网上找到该镜像,再上传到虚拟机中,下面是上传到/root/Downloads/中:

cd /root/Downloads/

docker load -i maxkb_latest.tar

docker images

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data --privileged=true 1panel/maxkb

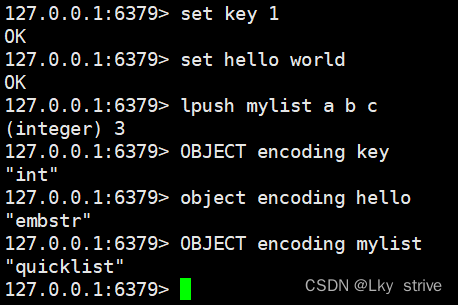

- 查看Ollama中的模型:使用以下命令查看Ollama中已经下载的模型:

docker exec -it ollama ollama list

- Ollama下载并运行新的模型(以千问7b为例):

docker exec -it ollama ollama run qwen:7b

如果不知道某个模型的执行命令,可以查看ollama网站:

https://ollama.com/library

- 在MaxKB中配置本地模型:

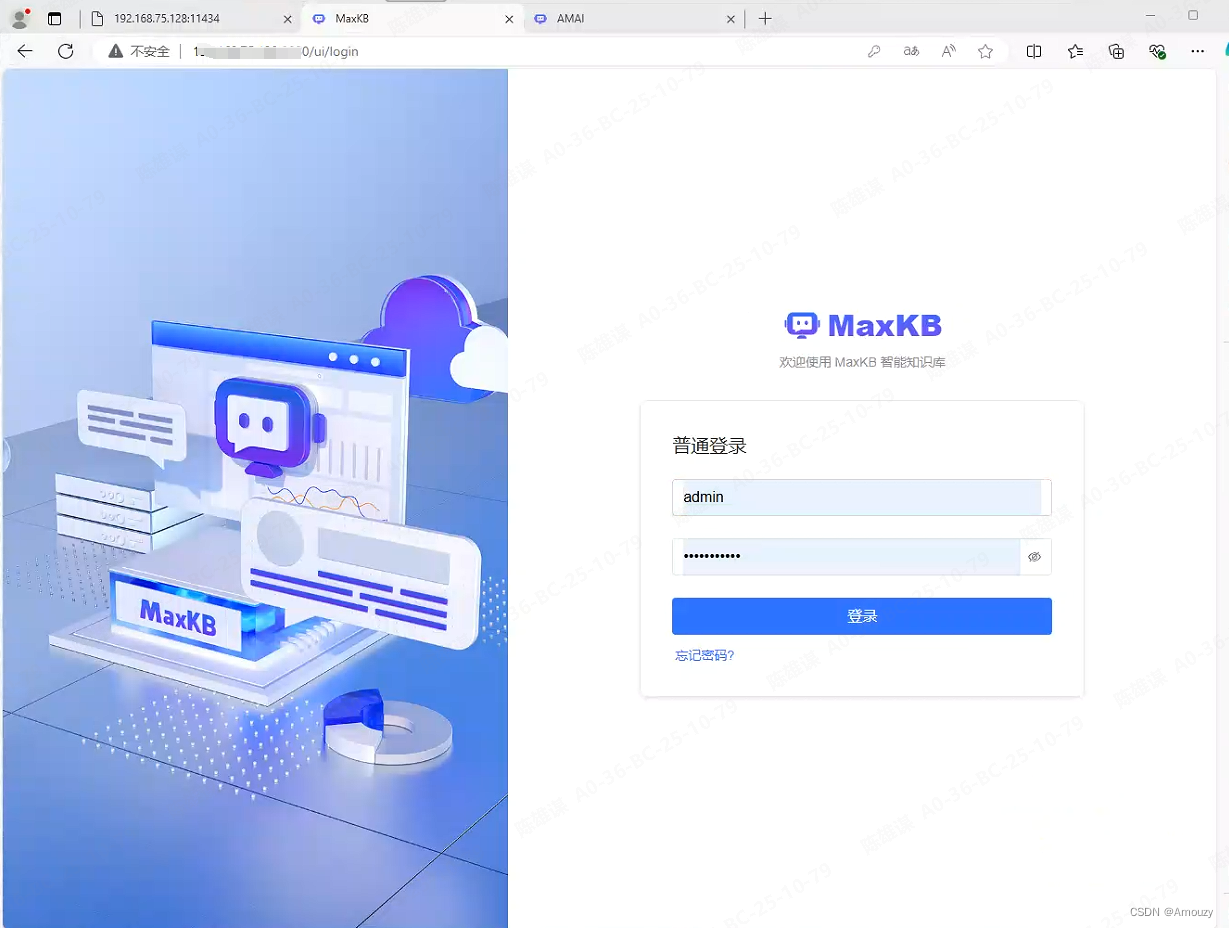

访问http://ip:8080/ui/login,登录管理用户:admin/MaxKB@123..

- 添加模型:如果基础模型选择的不是本地模型,maxkb会自动下载并且运行对应的模型。这里我们选择前面已经下载的qwen:7b。API为ollama运行的ip:端口,默认是11434d端口。

- 应用这里添加应用即可。

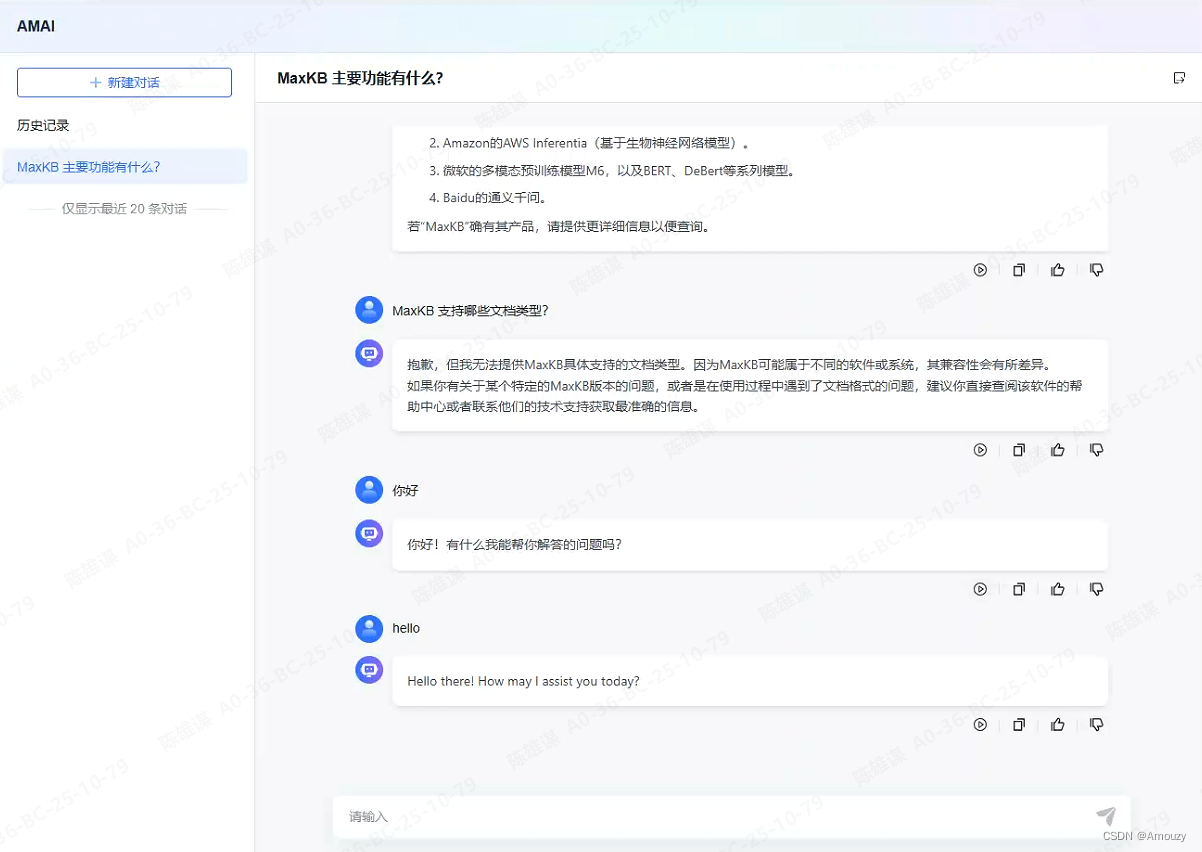

- maxkb演示

- 安装运行open-webui

Open-WebUI是另一款功能丰富、用户友好的自托管Web界面,专为大型语言模型(LLMs)设计。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

docker不太稳定,下载不下来的话,可以网上找到该镜像,再上传到虚拟机中。

- 注册管理员

访问链接,注册管理员。进去之后,如果ollama已经添加过模型,则“工作”板块中会自动罗列出来,否则在该页面添加模型即可。

ip:3000/auth

- open-webui演示