文章目录

- 迁移学习:理论、方法与实践

- 引言

- 第一章 迁移学习的基本概念

- 1.1 什么是迁移学习

- 1.2 迁移学习的类型

- 1.3 迁移学习的优势

- 第二章 迁移学习的核心方法

- 2.1 特征重用(Feature Reuse)

- 2.2 微调(Fine-Tuning)

- 2.3 领域适应(Domain Adaptation)

- 第三章 迁移学习的应用实例

- 3.1 医疗影像分析

- 3.2 文本分类

- 3.3 工业故障检测

- 第四章 迁移学习的未来发展与挑战

- 4.1 领域差异与模型适应性

- 4.2 数据隐私与安全

- 4.3 跨领域迁移与多任务学习

- 结论

迁移学习:理论、方法与实践

引言

迁移学习(Transfer Learning)作为机器学习的一个重要分支,通过将一个领域或任务中学得的知识应用到另一个领域或任务中,可以在数据稀缺或训练资源有限的情况下显著提升模型性能。本文将深入探讨迁移学习的基本原理、核心方法及其在实际中的应用,并提供代码示例以帮助读者更好地理解和掌握这一技术。

第一章 迁移学习的基本概念

1.1 什么是迁移学习

迁移学习是一类机器学习方法,通过在源领域(source domain)或任务(source task)中学得的知识来帮助目标领域(target domain)或任务(target task)的学习。迁移学习的核心思想是利用已有的模型或知识,减少在目标任务中对大规模标注数据的依赖,提高学习效率和模型性能。

1.2 迁移学习的类型

迁移学习可以根据源任务和目标任务的关系进行分类,主要包括以下几种类型:

- 归纳迁移学习(Inductive Transfer Learning):源任务和目标任务不同,但源领域和目标领域可以相同或不同。

- 迁移学习(Transductive Transfer Learning):源领域和目标领域不同,但任务相同。

- 跨领域迁移学习(Cross-Domain Transfer Learning):源领域和目标领域不同,且任务也不同。

1.3 迁移学习的优势

迁移学习相比于传统机器学习方法具有以下优势:

- 减少标注数据需求:通过利用源任务中的知识,可以在目标任务中减少对大量标注数据的需求。

- 提高模型性能:在目标任务中数据稀缺或训练资源有限的情况下,迁移学习能够显著提升模型的泛化能力和预测准确性。

- 加快模型训练:通过迁移预训练模型的参数,可以减少模型训练时间和计算成本。

第二章 迁移学习的核心方法

2.1 特征重用(Feature Reuse)

特征重用是迁移学习的一种简单但有效的方法,通过直接使用源任务模型的特征提取层,将其应用到目标任务中进行特征提取,再在目标任务的数据上训练新的分类器或回归器。

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.applications import VGG16

# 加载预训练的VGG16模型,不包括顶层分类器

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 冻结预训练模型的层

for layer in base_model.layers:

layer.trainable = False

# 构建新的分类器

model = models.Sequential([

base_model,

layers.Flatten(),

layers.Dense(256, activation='relu'),

layers.Dropout(0.5),

layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 加载并预处理CIFAR-10数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.cifar10.load_data()

x_train = tf.image.resize(x_train, (224, 224)).numpy() / 255.0

x_test = tf.image.resize(x_test, (224, 224)).numpy() / 255.0

y_train = tf.keras.utils.to_categorical(y_train, 10)

y_test = tf.keras.utils.to_categorical(y_test, 10)

# 训练模型

model.fit(x_train, y_train, epochs=10, validation_data=(x_test, y_test), batch_size=32)

# 评估模型

test_loss, test_acc = model.evaluate(x_test, y_test)

print(f'测试准确率: {test_acc}')

2.2 微调(Fine-Tuning)

微调是迁移学习的一种常用方法,通过在目标任务的数据上继续训练预训练模型的部分或全部层,从而适应目标任务的特性。

# 解冻部分预训练模型的层

for layer in base_model.layers[-4:]:

layer.trainable = True

# 重新编译模型(使用较小的学习率)

model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=1e-5), loss='categorical_crossentropy', metrics=['accuracy'])

# 继续训练模型

model.fit(x_train, y_train, epochs=5, validation_data=(x_test, y_test), batch_size=32)

# 评估模型

test_loss, test_acc = model.evaluate(x_test, y_test)

print(f'微调后的测试准确率: {test_acc}')

2.3 领域适应(Domain Adaptation)

领域适应是迁移学习中的一种方法,通过调整源领域模型使其能够更好地适应目标领域的数据分布,从而提高在目标领域的预测性能。常见的领域适应方法包括对抗训练(Adversarial Training)和子空间对齐(Subspace Alignment)等。

from tensorflow.keras.datasets import mnist, usps

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Dense, Input

# 加载MNIST和USPS数据集

(mnist_train_images, mnist_train_labels), (mnist_test_images, mnist_test_labels) = mnist.load_data()

(usps_train_images, usps_train_labels), (usps_test_images, usps_test_labels) = usps.load_data()

# 数据预处理

mnist_train_images = mnist_train_images.reshape(-1, 28*28).astype('float32') / 255

mnist_test_images = mnist_test_images.reshape(-1, 28*28).astype('float32') / 255

usps_train_images = usps_train_images.reshape(-1, 28*28).astype('float32') / 255

usps_test_images = usps_test_images.reshape(-1, 28*28).astype('float32') / 255

mnist_train_labels = tf.keras.utils.to_categorical(mnist_train_labels, 10)

mnist_test_labels = tf.keras.utils.to_categorical(mnist_test_labels, 10)

usps_train_labels = tf.keras.utils.to_categorical(usps_train_labels, 10)

usps_test_labels = tf.keras.utils.to_categorical(usps_test_labels, 10)

# 定义源领域模型

input_tensor = Input(shape=(28*28,))

x = Dense(256, activation='relu')(input_tensor)

x = Dense(256, activation='relu')(x)

output_tensor = Dense(10, activation='softmax')(x)

source_model = Model(inputs=input_tensor, outputs=output_tensor)

source_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 在MNIST数据集上训练源领域模型

source_model.fit(mnist_train_images, mnist_train_labels, epochs=10, batch_size=128, validation_data=(mnist_test_images, mnist_test_labels))

# 定义领域适应模型

feature_extractor = Model(inputs=source_model.input, outputs=source_model.layers[-2].output)

target_input = Input(shape=(28*28,))

target_features = feature_extractor(target_input)

target_output = Dense(10, activation='softmax')(target_features)

domain_adapt_model = Model(inputs=target_input, outputs=target_output)

domain_adapt_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 在USPS数据集上微调领域适应模型

domain_adapt_model.fit(usps_train_images, usps_train_labels, epochs=10, batch_size=128, validation_data=(usps_test_images, usps_test_labels))

# 评估领域适应模型

test_loss, test_acc = domain_adapt_model.evaluate(usps_test_images, usps_test_labels)

print(f'领域适应模型在USPS测试集上的准确率: {test_acc}')

第三章 迁移学习的应用实例

3.1 医疗影像分析

在医疗影像分析任务中,迁移学习通过利用在大规模自然图像数据集上预训练的模型,可以显著提高在小规模医疗影像数据集上的分类或检测性能。以下是一个在胸部X光片数据集上使用迁移学习进行肺炎检测的示例。

from tensorflow.keras.preprocessing.image import ImageDataGenerator

from tensorflow.keras.applications import InceptionV3

# 加载预训练的InceptionV3模型

base_model = InceptionV3(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 冻结预训练模型的层

for layer in base_model.layers:

layer.trainable = False

# 构建新的分类器

model = models.Sequential([

base_model,

layers.GlobalAveragePooling2D(),

layers.Dense(256, activation='relu'),

layers.Dropout(0.5),

layers.Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 数据预处理

train_datagen = ImageDataGenerator(rescale=0.5, validation_split=0.2)

train_generator = train_datagen.flow_from_directory(

'chest_xray/train',

target_size=(224, 224),

batch_size=32,

class_mode='binary',

subset='training'

)

validation_generator = train_datagen.flow_from_directory(

'chest_xray/train',

target_size=(224, 224),

batch_size=32,

class_mode='binary',

subset='validation'

)

# 训练模型

model.fit(train_generator, epochs=10, validation_data=validation_generator)

# 评估模型

test_datagen = ImageDataGenerator(rescale=0.5)

test_generator = test_datagen.flow_from_directory(

'chest_xray/test',

target_size=(224, 224),

batch_size=32,

class_mode='binary'

)

test_loss, test_acc = model.evaluate(test_generator)

print(f'迁移学习模型在胸部X光片测试集上的准确率: {test_acc}')

3.2 文本分类

在文本分类任务中,迁移学习通过使用在大规模文本语料库上预训练的语言模型,可以显著提高在特定领域或任务上的分类性能。以下是一个使用BERT预训练模型进行IMDB情感分析的示例。

from transformers import BertTokenizer, TFBertForSequenceClassification

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.losses import SparseCategoricalCrossentropy

# 加载BERT预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = TFBertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=2)

# 编译模型

model.compile(optimizer=Adam(learning_rate=3e-5), loss=SparseCategoricalCrossentropy(from_logits=True), metrics=['accuracy'])

# 加载IMDB数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.imdb.load_data(num_words=10000)

# 数据预处理

maxlen = 100

x_train = pad_sequences(x_train, maxlen=maxlen)

x_test = pad_sequences(x_test, maxlen=maxlen)

# 将数据转换为BERT输入格式

def encode_data(texts, labels):

input_ids = []

attention_masks = []

for text in texts:

encoded = tokenizer.encode_plus(

text,

add_special_tokens=True,

max_length=maxlen,

pad_to_max_length=True,

return_attention_mask=True,

return_tensors='tf'

)

input_ids.append(encoded['input_ids'])

attention_masks.append(encoded['attention_mask'])

return {

'input_ids': tf.concat(input_ids, axis=0),

'attention_mask': tf.concat(attention_masks, axis=0)

}, tf.convert_to_tensor(labels)

train_data, train_labels = encode_data(x_train, y_train)

test_data, test_labels = encode_data(x_test, y_test)

# 训练模型

model.fit(train_data, train_labels, epochs=3, batch_size=32, validation_data=(test_data, test_labels))

# 评估模型

test_loss, test_acc = model.evaluate(test_data, test_labels)

print(f'迁移学习模型在IMDB测试集上的准确率: {test_acc}')

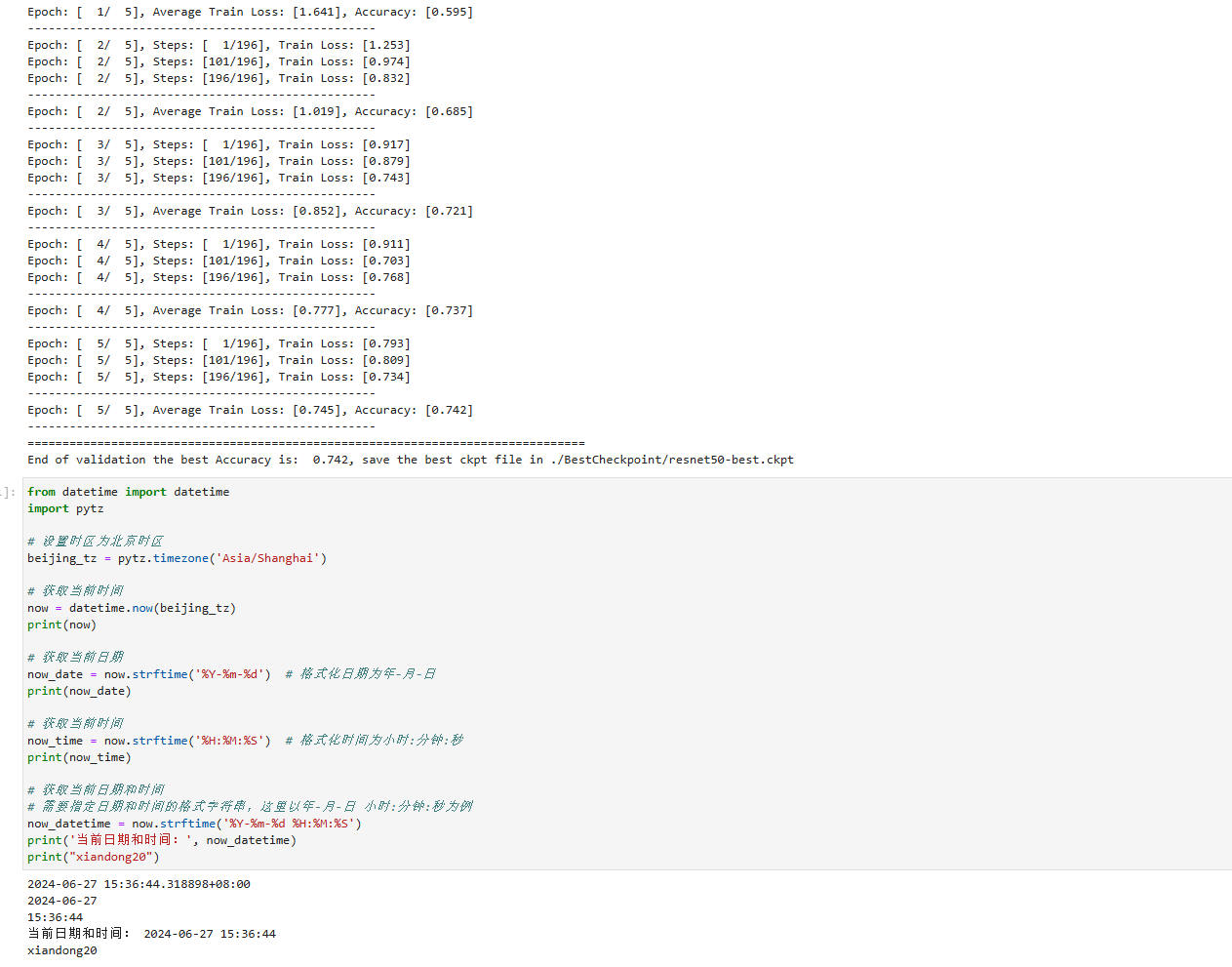

3.3 工业故障检测

在工业故障检测任务中,迁移学习通过利用在大规模工业数据上预训练的模型,可以显著提高在特定设备或场景下的故障检测性能。以下是一个使用迁移学习进行工业设备故障检测的示例。

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_split

from tensorflow.keras.models import load_model

# 加载预训练的故障检测模型

base_model = load_model('pretrained_fault_detection_model.h5')

# 冻结预训练模型的层

for layer in base_model.layers[:-2]:

layer.trainable = False

# 构建新的分类器

model = models.Sequential([

base_model,

layers.Dense(64, activation='relu'),

layers.Dropout(0.5),

layers.Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 加载并预处理工业设备数据集

data = pd.read_csv('industrial_equipment_data.csv')

X = data.drop(columns=['fault'])

y = data['fault']

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.2, random_state=42)

# 训练模型

model.fit(X_train, y_train, epochs=10, batch_size=32, validation_data=(X_test, y_test))

# 评估模型

test_loss, test_acc = model.evaluate(X_test, y_test)

print(f'迁移学习模型在工业设备故障检测测试集上的准确率: {test_acc}')

第四章 迁移学习的未来发展与挑战

4.1 领域差异与模型适应性

迁移学习的一个主要挑战是源领域和目标领域之间的差异。研究如何设计更加灵活和适应性的模型,使其能够在不同领域间有效迁移,是一个重要的研究方向。

4.2 数据隐私与安全

在迁移学习中,源领域数据的隐私和安全问题需要特别关注。研究如何在保证数据隐私和安全的前提下进行有效的迁移学习,是一个关键的研究课题。

4.3 跨领域迁移与多任务学习

跨领域迁移学习和多任务学习是迁移学习的两个重要方向。研究如何在多个任务和领域间共享知识,提升模型的泛化能力和适应性,是迁移学习的一个重要研究方向。

结论

迁移学习作为一种有效的机器学习方法,通过将已学得的知识从一个任务或领域应用到另一个任务或领域,在数据稀缺或训练资源有限的情况下尤其有效。本文详细介绍了迁移学习的基本概念、核心方法及其在实际中的应用,并提供了具体的代码示例,帮助读者深入理解和掌握这一技术。希望本文能够为您进一步探索和应用迁移学习提供有价值的参考。

![Grafana+Prometheus构建强大的监控系统-保姆级教程[监控linux、oracle]](https://img-blog.csdnimg.cn/img_convert/c6b9487a73135c000f55cbae588d32e3.png)