金融机构普遍采用“存算一体”架构支撑基于 Hadoop 框架的大数据平台。而随着金融业务的多元化发展,不同业务对计算和存储的需求差异较大,由于“存算一体”架构共享存储与计算资源,经常会出现资源需求不均衡、资源利用率低下、难以灵活调度等问题,不仅难以满足大数据平台的业务需求,还可能增加用户的资源投入与运行成本。

近期,SmartX 与某头部保险集团开展合作,探索基于 SmartX 分布式存储 SMTX ZBS 构建“存算分离”架构,搭配 NVMe-oF(RDMA)接入协议,支撑 HDP 发行版的大数据平台性能表现。测试结果显示,相比基于裸金属和本地盘的“存算一体”架构,基于 SMTX ZBS(开启 RDMA)的“存算分离”架构,可有效缩短 HDP 大数据平台导出与查询表用时约 70%,同时提升资源使用率和资源扩展灵活性。

下载阅读《金融核心生产业务场景探索合集》系列电子书,了解更多金融业务系统在分布式存储“存算分离”架构下的性能表现。

【核心业务篇】金融核心生产业务场景探索文章合集

【信创转型与架构升级篇】金融核心生产业务场景探索文章合集

【数据库与数据仓库篇】金融核心生产业务场景探索文章合集

实践背景

某保险集团原使用基于服务器和本地硬盘的“存算一体”架构支撑大数据平台,在生产环境运行期间,随着数据量的增加,存储和计算的资源使用逐渐变得不均衡,在算力足够的情况下出现了存储 I/O 瓶颈。由于采用“存算一体”架构,用户选择增加节点数量的方式来分担 I/O 负载,而扩展节点后整套系统的存储资源利用率仅为 30%,不仅浪费了资源,还增加了非必要的硬件成本。同时,由于本地硬盘不具备容灾机制,如果磁盘出现故障,为了保证数据的可靠性,大数据平台会占用业务带宽进行数据恢复,进而影响整个集群的性能和稳定性。

经过细致评估,用户希望尝试“存算分离”架构,来改善上述资源分配和可靠性的问题——存算分离架构将存储层和计算层分开部署,允许独立地扩展存储和计算资源,并根据实际需求动态地调整资源配置,从而提高系统的灵活性和可扩展性。同时,结合企业级分布式存储的数据保护机制,当存储磁盘故障时可实现大数据平台无感知的自动数据恢复(不占用业务带宽流量),进一步增强架构的可靠性和稳定性。

不过,选择哪一款分布式存储支持大数据平台?存储性能能否满足大数据平台日常需求?“存算分离”架构是否会因为网络远程传输 I/O 带来性能下降?多种数据冗余机制是否会造成额外的存储消耗?……针对这些顾虑,用户对 SmartX 分布式存储 SMTX ZBS 基于多种接入协议支持大数据平台的性能表现进行了测试验证。

SMTX ZBS 支持金融大数据平台的性能评测

ZBS 是 SmartX 自主研发的分布式存储,既可以与 SmartX 原生虚拟化 ELF/ VMware 虚拟化软件融合部署为超融合架构,也可作为分布式存储软件进行独立部署。SMTX ZBS 支持多种计算平台,具备多种企业级高可用特性和端到端的性能优化,同时支持 NVMe over RDMA(RoCE)技术以降低网络传输带来的延迟。欲深入了解 ZBS 功能特性,请阅读:

- 分布式块存储 ZBS 的自主研发之旅 | 架构篇

- 分布式块存储 ZBS 的自主研发之旅|接入协议之 NVMe-oF

- 分布式块存储 ZBS 的自主研发之旅|数据同步协议 RDMA

- 分布式块存储 ZBS 的自主研发之旅|元数据管理

测试目标

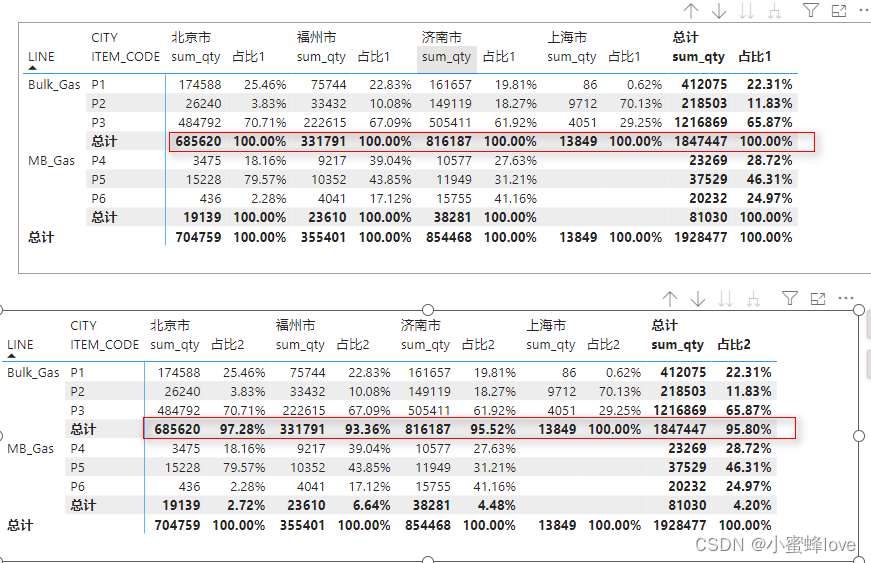

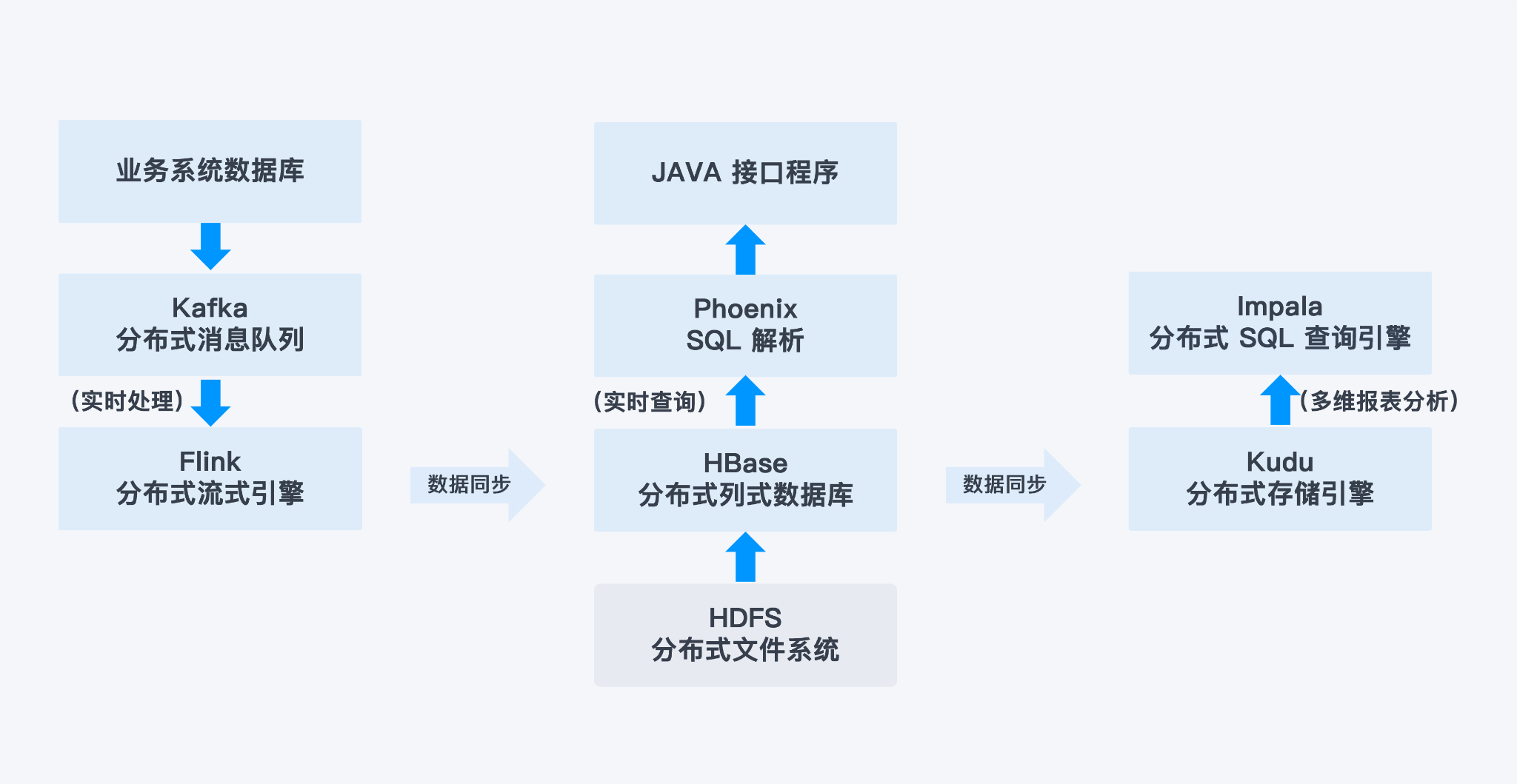

通过 SMTX ZBS 分布式存储对接裸金属服务器基础架构,用于承载上图中的 HDFS 和 HBase 等相关服务。对比 SMTX ZBS 和本地硬盘环境下大数据平台在备份场景和业务场景中的性能表现,同时针对 SMTX ZBS 基于 iSCSI 和 NVMe over RDMA(RoCE)两种接入协议的性能表现进行对比验证。

测试项目

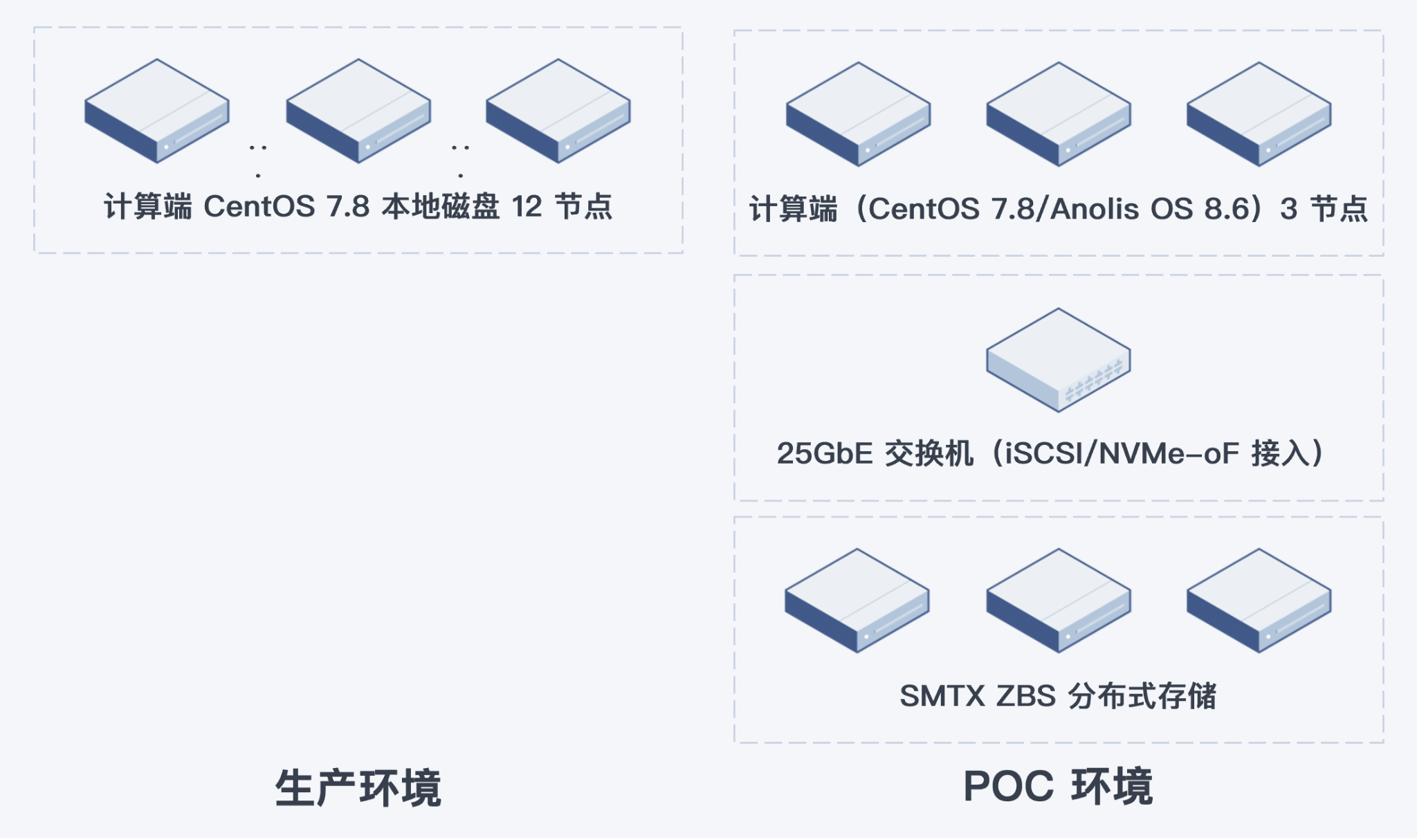

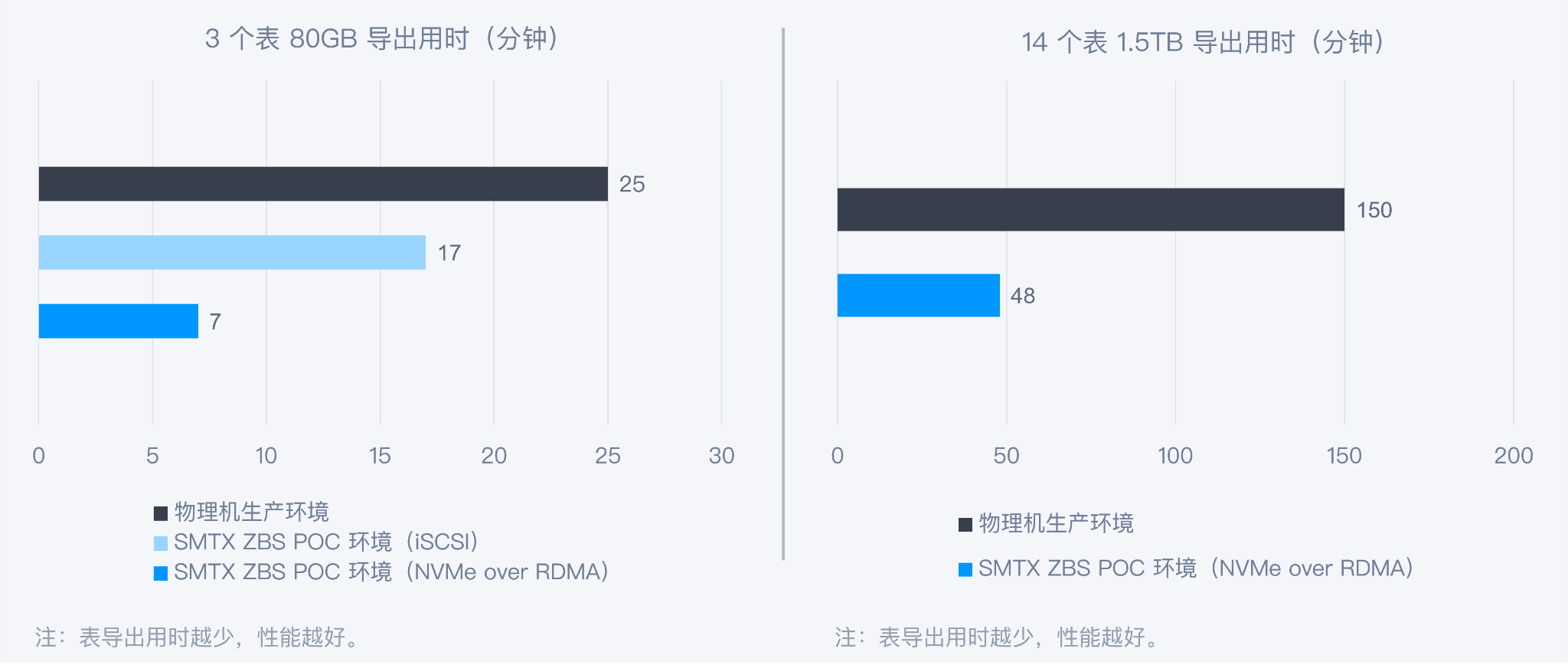

- 场景一 – 从 HBase 写入 HDFS(备份场景):分别从生产环境 12 台计算节点和 POC 环境 3 台计算节点中的 HBase 数据库中,导出 3 个(共 80GB)、14个(共 1.5TB)相同数据表写入到 HDFS,记录用时时间。

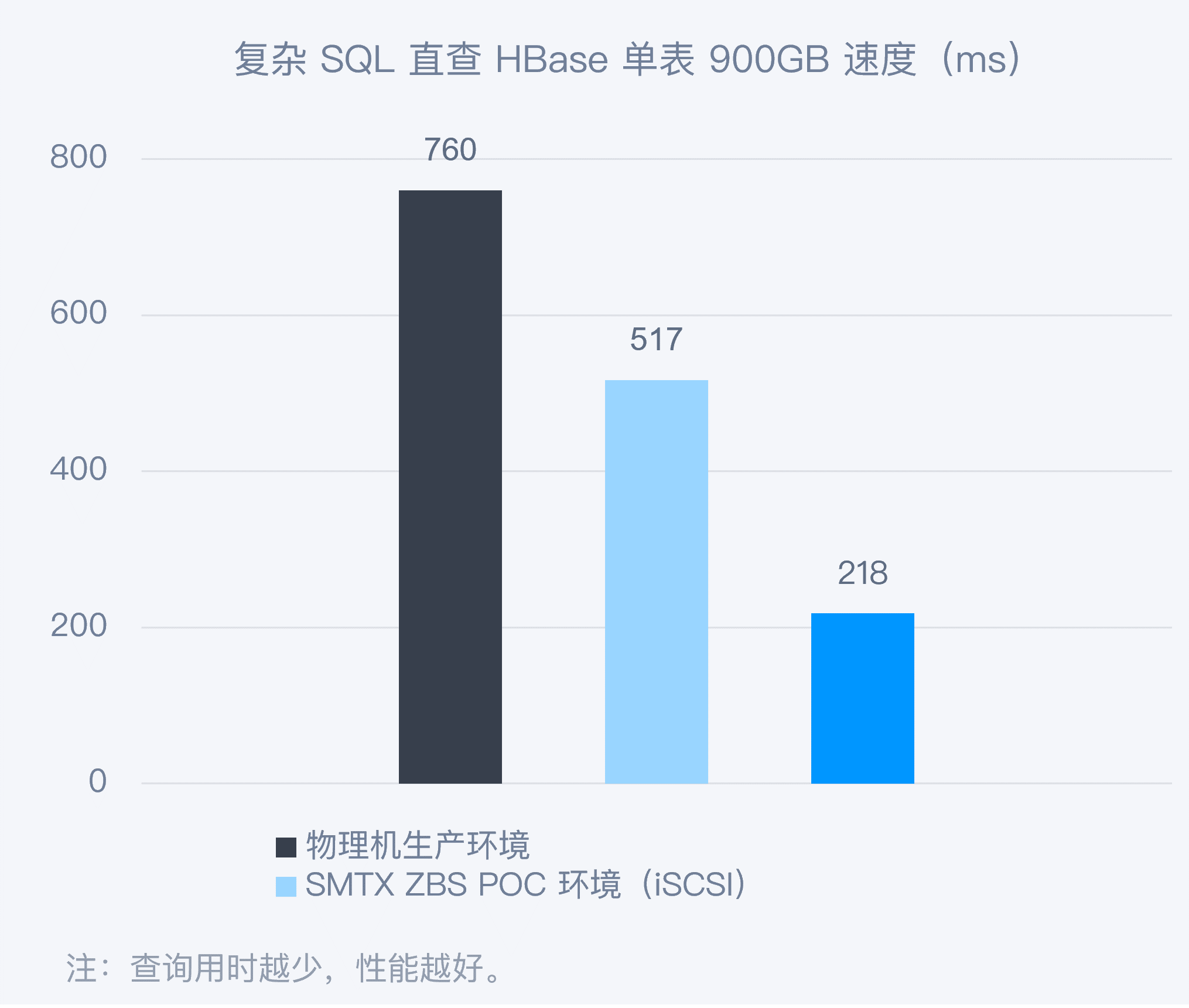

- 场景二 – Phoenix 查询 HBase 数据表(业务场景):通过 Phoenix 程序直接查询 HBase 数据库,观察查询数据表的响应时间(响应延迟)。

环境配置

生产环境

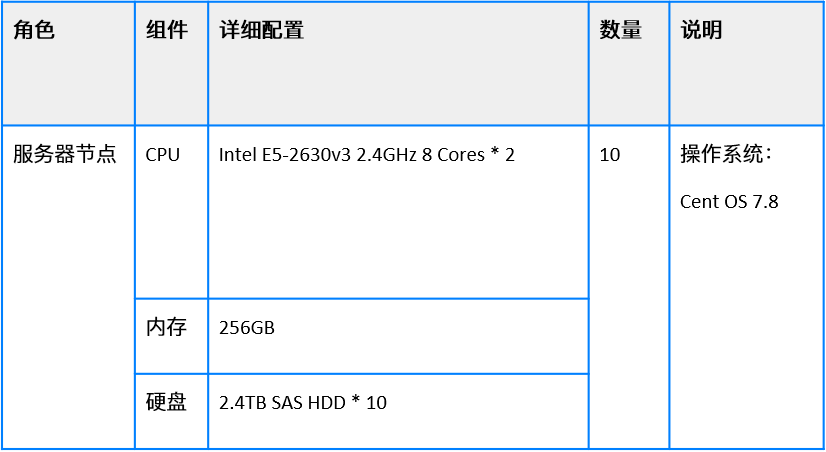

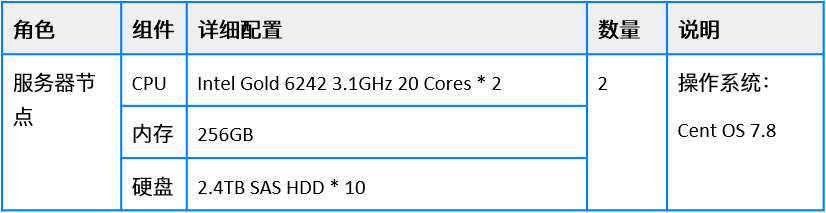

生产环境有配置 1 和配置 2 两种服务器配置,具体如下:

配置 1:

配置2:

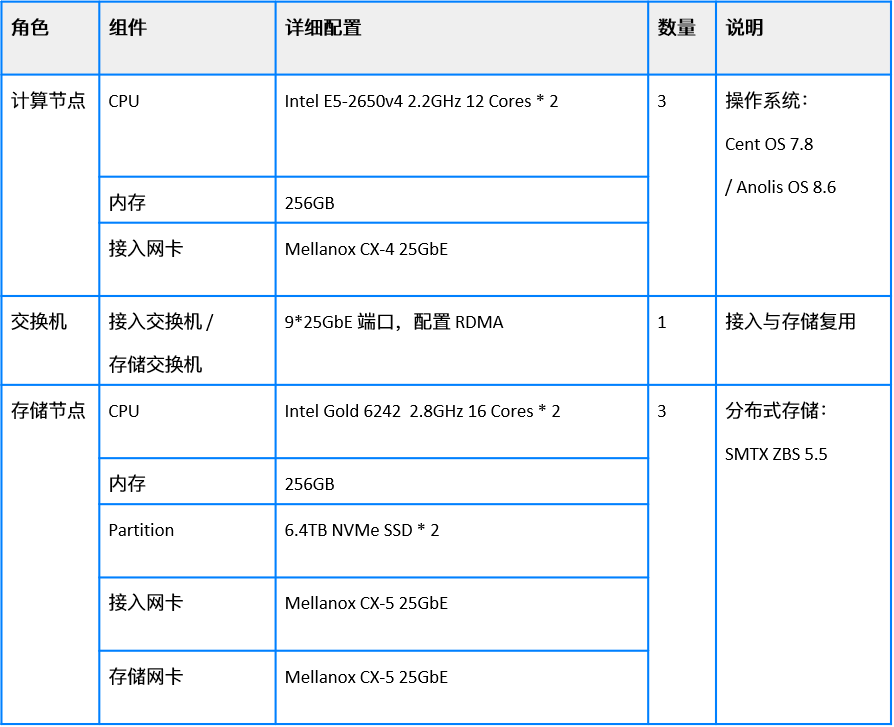

测试环境

说明:因为 NVMe over RDMA 技术对计算平台操作系统版本存在兼容性要求,故 Anolis OS 用于 NVMe Over RDMA 协议的测试。

测试结果

场景一:从 HBase 写入 HDFS

从 HBase 3/14 个表导出的用时对比来看,基于 NVMe over RDMA 接入协议的 SmartX 分布式存储相比生产物理机环境,导表时间分别缩短 72% 和 68%;3 个表导出场景下,相比 iSCSI 接入协议,采用 NVMe over RDMA 接入协议的 SMTX ZBS 导表时间缩短约 60%。

场景二:Phoenix 查询 HBase 数据表

为了更真实反映出存储性能差异对于该场景的性能影响,通过使用 Phoenix 本地直接查询 HBase 方式进行测试(消除接口服务器自身影响和网络环境差异)。结果显示,SmartX 分布式存储(使用 NVMe over RDMA 接入协议)相比生产物理机环境,查询时间缩短 71%,相比 SmartX 分布式存储(使用 iSCSI 接入协议),查询时间缩短约 60%。

测试总结

总体而言,在大数据应用场景下,基于不同存储架构与存储接入协议的存储系统,其性能表现有较大差异,其中开启 NVMe over RDMA(RoCE)的 SMTX ZBS 可大幅提升应用运行效率,满足大数据应用对高性能与低时延的需求,同时不会因为“存算分离”架构带来额外的性能开销影响。

这一测试也充分证明了 SmartX 分布式存储和超融合对 NVMe over RDMA(RoCE)技术的支持能力。欲深入了解,请阅读:

- 解决 SAN 交换机“卡脖子”并升级存储架构?一文解析 RoCE 与相关存储方案趋势

- ZBS 的 RoCE 技术支持与业务场景性能评测

后续部署实践

经过测试,保险用户对基于 SMTX ZBS “存算分离”架构支持大数据平台的性能表现非常满意,3 个 ZBS 分布式存储节点即可提供远高于生产环境 12 个物理节点的性能,同时提升扩展灵活性、资源利用率、数据可靠保障,并降低硬件投入成本,为大数据平台 IT 基础设施带来整体优化。

目前,该保险用户已基于存储端 5 节点 SMTX ZBS 和计算端 16 节点信创操作系统服务器,搭配某商用大数据平台,构建了新一代生产大数据平台架构。

更多金融行业基于超融合和分布式存储支持金融核心应用系统的探索和实践,欢迎下载阅读

《 SmartX 金融核心生产业务场景探索文章合集》系列电子书。

【核心业务篇】金融核心生产业务场景探索文章合集

【信创转型与架构升级篇】金融核心生产业务场景探索文章合集

【数据库与数据仓库篇】金融核心生产业务场景探索文章合集