目录

一、UDF概述

二、编写自定义UDF

1.创建项目

2.pom.xml文件添加依赖

3.编写工具类及自定义UDF类

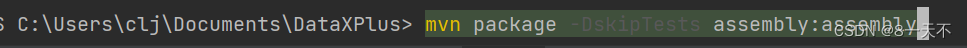

4.打包

5.测试 jar

6.上传至服务器、HDFS并给jar包赋权

7.添加到hive类路径并创建临时函数

8.使用测试:

9.临时函数、永久函数

一、UDF概述

UDF全称:User-Defined Functions,即用户自定义函数,在Hive SQL编译成MapReduce任务时,执行java方法,类似于像MapReduce执行过程中加入一个插件,方便扩展。

二、编写自定义UDF

1.创建项目

启动IDEA,创建MAVEN项目

2.pom.xml文件添加依赖

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>3.1.3</version>

</dependency>3.编写工具类及自定义UDF类

加密、解密工具类

import sun.misc.BASE64Decoder;

import sun.misc.BASE64Encoder;

import javax.crypto.*;

import javax.crypto.spec.SecretKeySpec;

import java.io.IOException;

import java.nio.charset.StandardCharsets;

import java.security.InvalidKeyException;

import java.security.NoSuchAlgorithmException;

import java.security.SecureRandom;

/**

* @Author liujian

* @Date 2023/1/30 10:45

* @Version 1.0

*/

public class AES {

public static final String ENCODE_RULES = "8DFC34B0B7C98EFA0A299A6C3FFFBD9D";

/*

* 加密

* 1.构造密钥生成器

* 2.根据ecnodeRules规则初始化密钥生成器

* 3.产生密钥

* 4.创建和初始化密码器

* 5.内容加密

* 6.返回字符串

*/

public static String AESEncode(String encodeRules,String content){

try {

//1.构造密钥生成器,指定为AES算法,不区分大小写

KeyGenerator keygen=KeyGenerator.getInstance("AES");

//2.根据ecnodeRules规则初始化密钥生成器

//生成一个128位的随机源,根据传入的字节数组

SecureRandom random = SecureRandom.getInstance("SHA1PRNG");

random.setSeed(encodeRules.getBytes());

keygen.init(128, random); //3.产生原始对称密钥

SecretKey original_key=keygen.generateKey();

//4.获得原始对称密钥的字节数组

byte [] raw=original_key.getEncoded();

//5.根据字节数组生成AES密钥

SecretKey key=new SecretKeySpec(raw, "AES");

//6.根据指定算法AES自成密码器

Cipher cipher=Cipher.getInstance("AES");

//7.初始化密码器,第一个参数为加密(Encrypt_mode)或者解密解密(Decrypt_mode)操作,第二个参数为使用的KEY

cipher.init(Cipher.ENCRYPT_MODE, key);

//8.获取加密内容的字节数组(这里要设置为utf-8)不然内容中如果有中文和英文混合中文就会解密为乱码

byte [] byte_encode=content.getBytes(StandardCharsets.UTF_8);

//9.根据密码器的初始化方式--加密:将数据加密

byte [] byte_AES=cipher.doFinal(byte_encode);

//10.将加密后的数据转换为字符串

//这里用Base64Encoder中会找不到包

//解决办法:

//在项目的Build path中先移除JRE System Library,再添加库JRE System Library,重新编译后就一切正常了。

//11.将字符串返回

return new BASE64Encoder().encode(byte_AES);

} catch (BadPaddingException e) {

e.printStackTrace();

} catch (NoSuchPaddingException e) {

e.printStackTrace();

} catch (NoSuchAlgorithmException e) {

e.printStackTrace();

} catch (IllegalBlockSizeException e) {

e.printStackTrace();

} catch (InvalidKeyException e) {

e.printStackTrace();

}

//如果有错就返加nulll

return null;

}

/*

* 解密

* 解密过程:

* 1.同加密1-4步

* 2.将加密后的字符串反纺成byte[]数组

* 3.将加密内容解密

*/

public static String AESDncode(String encodeRules,String content){

try {

//1.构造密钥生成器,指定为AES算法,不区分大小写

KeyGenerator keygen=KeyGenerator.getInstance("AES");

//2.根据ecnodeRules规则初始化密钥生成器

//生成一个128位的随机源,根据传入的字节数组

SecureRandom random = SecureRandom.getInstance("SHA1PRNG");

random.setSeed(encodeRules.getBytes());

keygen.init(128, random);

//3.产生原始对称密钥

SecretKey original_key=keygen.generateKey();

//4.获得原始对称密钥的字节数组

byte [] raw=original_key.getEncoded();

//5.根据字节数组生成AES密钥

SecretKey key=new SecretKeySpec(raw, "AES");

//6.根据指定算法AES自成密码器

Cipher cipher=Cipher.getInstance("AES");

//7.初始化密码器,第一个参数为加密(Encrypt_mode)或者解密(Decrypt_mode)操作,第二个参数为使用的KEY

cipher.init(Cipher.DECRYPT_MODE, key);

//8.将加密并编码后的内容解码成字节数组

byte [] byte_content= new BASE64Decoder().decodeBuffer(content);

/*

* 解密

*/

byte [] byte_decode=cipher.doFinal(byte_content);

return new String(byte_decode, StandardCharsets.UTF_8);

} catch (NoSuchAlgorithmException | NoSuchPaddingException | InvalidKeyException | IOException | IllegalBlockSizeException | BadPaddingException e) {

e.printStackTrace();

}

//如果有错就返加nulll

return null;

}

}

UDF类 代码

import com.qiyu.util.AES;

import org.apache.hadoop.hive.ql.exec.UDF;

public class AESUDF extends UDF {

String password = "8DFC34B0B7C98EFA0A299A6C3FFFBD9D";

public String evaluate ( String type , String content) throws Exception {

if (content == null) return null;

if(! type.equals("encode") && ! type.equals("decode")){

throw new Exception("Parmeter one is needed encode/decode");

}

if( type.equals("encode")){

//进行加密

return AES.AESEncode (password, content);

}else {

//进行解密

return AES.AESDncode(password, content);

}

}

public static void main(String[] args) throws Exception {

AESUDF ase = new AESUDF();

System.out.println(ase.evaluate("encode","hello world"));

System.out.println(ase.evaluate("decode","uW6YH6mvckQxBATpfJbMnw=="));

}4.打包

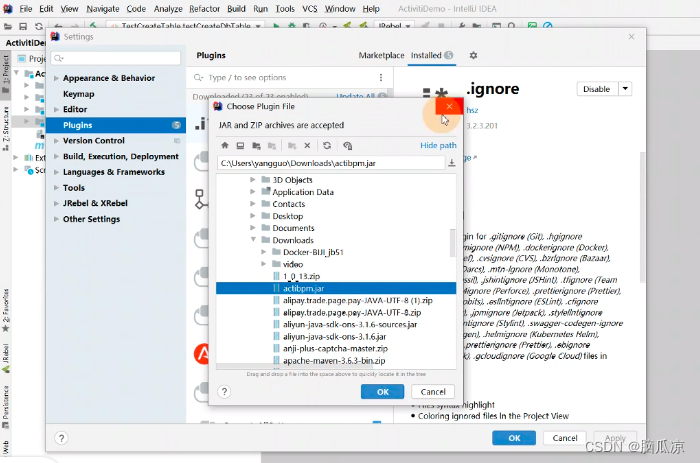

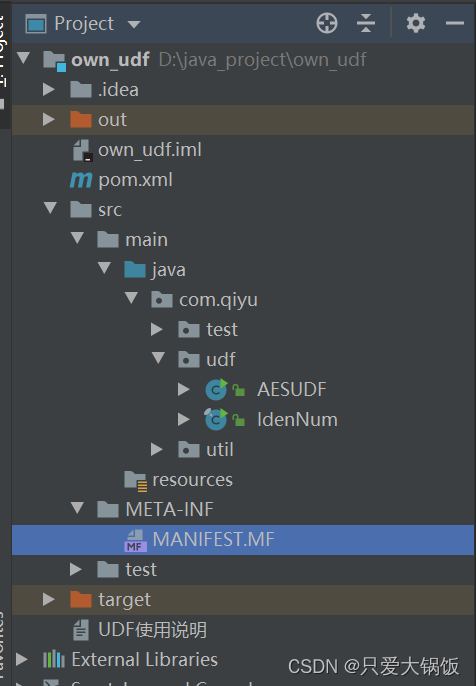

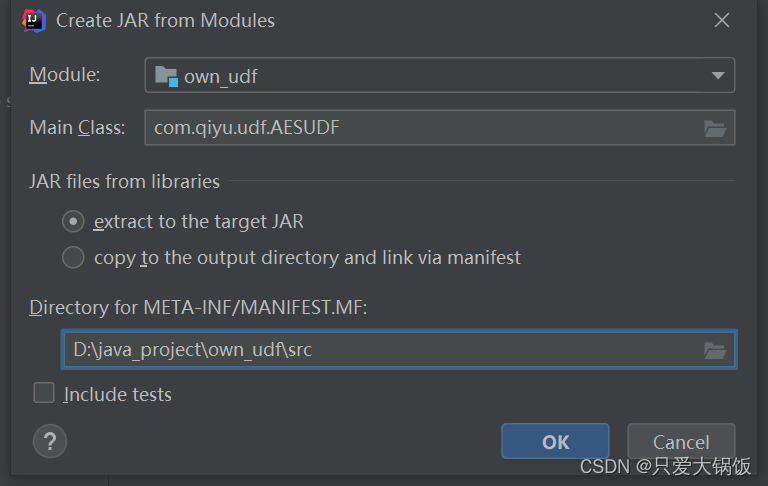

依次点击 IDEA (File --- Projiect Structure ---Artifacts --- + --- jar --- From modules with ...)

选择 主加载UDF类

注:将默认路径后面 \main\java 删除,原本路径为:D:\java_project\own_udf\src\main\java\

打包成功后,进入out目录,利用压缩软件 打开 jar 包,修改 jar,删除

META-INF目录下面 的所有 文件及文件夹 (只保留 maven文件夹 ,MANIFEST.MF文件 )

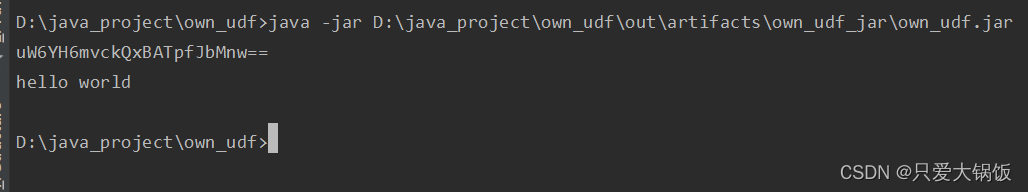

5.测试 jar

java -jar D:\java_project\own_udf\out\artifacts\own_udf_jar\own_udf.jar

6.上传至服务器、HDFS并给jar包赋权

7.添加到hive类路径并创建临时函数

hive> add jar hdfs:///UDF_lib/ASEUDF.jar;

Added [/tmp/6ebfbc8b-18e5-4437-87fd-56293e03b159_resources/ASEUDF.jar] to class path

Added resources: [hdfs:///UDF_lib/ASEUDF.jar]

hive> create temporary function ase_udf as "com.jiami.AESUDF";

OK

Time taken: 0.375 seconds

hive>

8.使用测试

hive> select ase_udf("encode","hello");

OK

pHd9T1SMP8Ii7OmuVvFk/w==

Time taken: 1.68 seconds, Fetched: 1 row(s)

hive> select ase_udf("decode","pHd9T1SMP8Ii7OmuVvFk/w==");

OK

hello

Time taken: 0.115 seconds, Fetched: 1 row(s)

hive>

9.临时函数、永久函数

//临时函数

create temporary function ase_udf as "com.jiami.AESUDF";

//永久函数

create function ASE_udf as "com.jiami.AESUDF" using jar "hdfs://hive1:8020/UDF_lib/ASEUDF.jar";