目录

- 前言

- 常量和变量

- 构造器

- put方法

- resize扩容

- get方法

前言

HashMap的源码非常经典,里面用到了哈希表、链表、红黑树等数据结构,而且又是用纯Java实现的,所以成为了Java程序员必读的源码之一。

事先了解下哈希表(散列表)对阅读HashMap的源码将会非常有帮助,哈希表的知识可以参考我的这篇博文:散列表(哈希表)概述。

废话少说,直接看代码,我这里只摘录重点部分。

常量和变量

// 链表长度阈值,超过这个阈值要么哈希表扩容,要么链表转红黑树,下文会细讲

static final int TREEIFY_THRESHOLD = 8;

// 哈希表默认的负载因子(也叫装填因子)

static final float DEFAULT_LOAD_FACTOR = 0.75f;

// 哈希表默认容量(16),注意,指的是数组长度,HashMap规定数组长度必须是2的倍数

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4;

// 哈希表容量的最大值

static final int MAXIMUM_CAPACITY = 1 << 30;

// 当链表长度达到阈值时,如果哈希表长度小于这个值,会进行哈希表的扩容,而不是链表转树

static final int MIN_TREEIFY_CAPACITY = 64;

// 哈希表(散列表)本体

transient Node<K,V>[] table;

// key-value映射的个数,也就是我们常说的HashMap的大小

transient int size;

// 哈希表扩容的阈值,默认是DEFAULT_INITIAL_CAPACITY * DEFAULT_LOAD_FACTOR = 12

// 也就是说HashMap的size超过12时会进行table的扩容

int threshold;

构造器

public HashMap() {

this.loadFactor = DEFAULT_LOAD_FACTOR; // 其他字段都是默认的

}

public HashMap(int initialCapacity, float loadFactor) {

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

// HashMap规定哈希表容量必须是2的整数倍,而initialCapacity不一定是2的整数倍

// 所以这里通过tableSizeFor求哈希表初始容量。

// 这里的threshold成员变量其实是身兼多职,如果是通过这个构造器创建HashMap实例,

// 在还未调用resize方法初始化哈希表前,threshold记录的是哈希表初始容量,

// 在resize之后,threshold就回归本职了。为什么要这么做?我猜主要是不想额外引入一个成员变量吧

this.threshold = tableSizeFor(initialCapacity);

}

public HashMap(int initialCapacity) {

this(initialCapacity, DEFAULT_LOAD_FACTOR);

}

public HashMap(Map<? extends K, ? extends V> m) {

this.loadFactor = DEFAULT_LOAD_FACTOR;

putMapEntries(m, false);

}

这里有个比较有意思的方法tableSizeFor:

static final int tableSizeFor(int cap) {

int n = cap - 1;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

对这个方法进行测试,输入12,输出16;输入16,输出16;输入19,输出32。可以看出,这个方法是求大于等于输入值的最小的2的倍数。HashMap规定哈希表的容量必须是2的整数倍,如果你通过构造器自定义容量,就是通过这个方法保证容量是2的倍数。那它是如何实现的呢?

假如我输入的cap是16,那么n = 16 - 1 = 15,15用二进制表示是1111,n >>> 1 = 0111,n |= n >>> 1的运算过程如下:

1111 |

0111 =

1111

此时n = 1111,n >>> 2 = 0011,n |= n >>> 2的运算过程如下:

1111 |

0011 =

1111

此时n = 1111,n >>> 4 = 0000,n |= n >>> 4的运算过程如下:

1111 |

0000 =

1111

此时n = 1111,n >>> 8 = 0000,1111 | 0000 = 1111。

此时n = 1111,n >>> 16 = 0000,1111 | 0000 = 1111。

所以最后求得的n = 1111 = 15. 最终返回n + 1 = 16。

那如果我输入的是12呢?继续看,n = 12 - 1 = 11,11用二进制表示是1011,n >>> 1 = 0101,n |= n >>> 1的运算过程如下:

1011 |

0101 =

1111

此时n = 1111,n到了1111后,接下来的流程就没啥好说的了,上面已经都推演过了,最终返回15 + 1 = 16。

继续看输入19,n = 19 - 1 = 18,18用二进制表示是10010,n >>> 1 = 01001,n |= n >>> 1的运算过程如下:

10010 |

01001 =

11011

此时n = 11011,n >>> 2 = 00110,n |= n >>> 2的运算过程如下:

11011 |

00110 =

11111

此时n = 11111,用十进制表示就是31,后续不管怎么计算,n都是11111,所以最终返回的结果是31 + 1 = 32。

所以我们发现那一串移位和或运算主要就是为了把所有低位都变成1,最终目的是使哈希表的表长变成2的倍数。

put方法

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

本身java对象都是有hashcode的,这里对key求哈希值,主要是为了防止实现的不好的hashcode方法影响哈希表的性能。

static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16); // 哈希扰动

}

put实际上调用的是putVal,看下putVal:

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

if ((tab = table) == null || (n = tab.length) == 0) // 哈希表未初始化

n = (tab = resize()).length; // 初始化哈希表并获取哈希表长度

if ((p = tab[i = (n - 1) & hash]) == null) // 通过key的哈希码定位它在哈希表中的位置,等于null说明没有哈希冲突

tab[i] = newNode(hash, key, value, null); // 将数据存到哈希表

else { // 有哈希冲突

Node<K,V> e; K k;

if (p.hash == hash && ((k = p.key) == key || (key != null && key.equals(k)))) // key已存在

e = p; // 用e记录该结点,数据结构保持不变

else if (p instanceof TreeNode) // 该结点是树的根结点

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value); // 以树的方式处理

else { // 该结点是链表的头结点,以链表的方式处理

for (int binCount = 0; ; ++binCount) { // 遍历链表,并记录链表长度

if ((e = p.next) == null) { // 到了链表尾部,说明结点不存在,则新增结点

p.next = newNode(hash, key, value, null);

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash); // 链表太长了,考虑是否转红黑树

break;

}

if (e.hash == hash && ((k = e.key) == key || (key != null && key.equals(k)))) // key已存在

break;

p = e;

}

}

if (e != null) { // key已存在

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null) // 可以覆盖旧值,或者旧值为null

e.value = value; // 覆盖旧值

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

if (++size > threshold) // size超过阈值

resize(); // 扩容

afterNodeInsertion(evict);

return null;

}

上述代码在定位key位于哈希表中的位置时,不是用常见的对数组长度取余(%)的方式,而是用位运算&,因为位运算更高效。

if ((p = tab[i = (n - 1) & hash]) == null)

那它是如何实现的呢?HashMap规定哈希表(数组)长度必须是2的倍数,假设哈希表长度是16,忽略高位的0,用二进制表示就是10000,16 - 1 = 15,15用二进制表示就是1111;假设哈希表长度是32,用二进制表示是100000,32 - 1 = 31,31用二进制表示是11111。1 & 1 = 1,1 & 0 = 0,所以(n - 1) & hash其实取得就是hash的低位,得到的值绝对不会超过n - 1,哈希冲突的概率完全取决于hash()算得的值是否分布均匀。

关于链表转红黑树的时机,首先,链表长度要大于等于阈值(比如8),此条件满足时,会调用treeifyBin方法,我们看treeifyBin方法:

final void treeifyBin(Node<K,V>[] tab, int hash) {

int n, index; Node<K,V> e;

if (tab == null || (n = tab.length) < MIN_TREEIFY_CAPACITY)

resize();

else if ((e = tab[index = (n - 1) & hash]) != null) {

TreeNode<K,V> hd = null, tl = null;

do {

TreeNode<K,V> p = replacementTreeNode(e, null);

if (tl == null)

hd = p;

else {

p.prev = tl;

tl.next = p;

}

tl = p;

} while ((e = e.next) != null);

if ((tab[index] = hd) != null)

hd.treeify(tab);

}

}

通过这个方法我们知道,如果哈希表容量(也即数组长度)小于MIN_TREEIFY_CAPACITY(64)时,会进行哈希表扩容,而不是链表转红黑树。

resize扩容

final Node<K,V>[] resize() {

Node<K,V>[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

if (oldCap > 0) { // 当前哈希表的容量大于0,也就是说哈希表已经初始化过

if (oldCap >= MAXIMUM_CAPACITY) { // 超过最大容量

threshold = Integer.MAX_VALUE;

return oldTab; // 还是返回原哈希表,不扩容

}

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY && // 新容量是老容量的2倍

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // 新阈值是老阈值的2倍

}

else if (oldThr > 0) // 这种情况一般是用带参的构造器new出来,但还未put过

newCap = oldThr;

else { // 这种情况一般是用无参的构造器new出来,但还未put过

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap]; // 创建新的哈希表

table = newTab; // 成员变量table指向新的哈希表

if (oldTab != null) { // 老的哈希表不为null,将数据搬迁到新哈希表

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

if (e.next == null) // 当前位置没有哈希冲突

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode) // 当前位置是树的根结点

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // 当前位置是链表的头结点

// 把原链表拆成两个链表

// 链表1存放在低位(原索引位置)

Node<K,V> loHead = null, loTail = null;

// 链表2存放在高位(原索引+旧数组长度)

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

// 哈希表容量是2的倍数,用二进制表示的话,所有位中只有一个1,比如10000(省略高位的0)

// e.hash & oldCap要么等于0,要么等于oldCap,这里其实可以看做取是或否

if ((e.hash & oldCap) == 0) { // 构建链表1

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

else { // 构建链表2

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead; // 高位链表的索引是原索引+旧数组长度

}

}

}

}

}

return newTab; // 扩容完成,返回新的哈希表

}

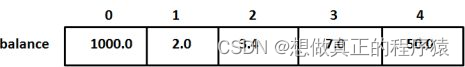

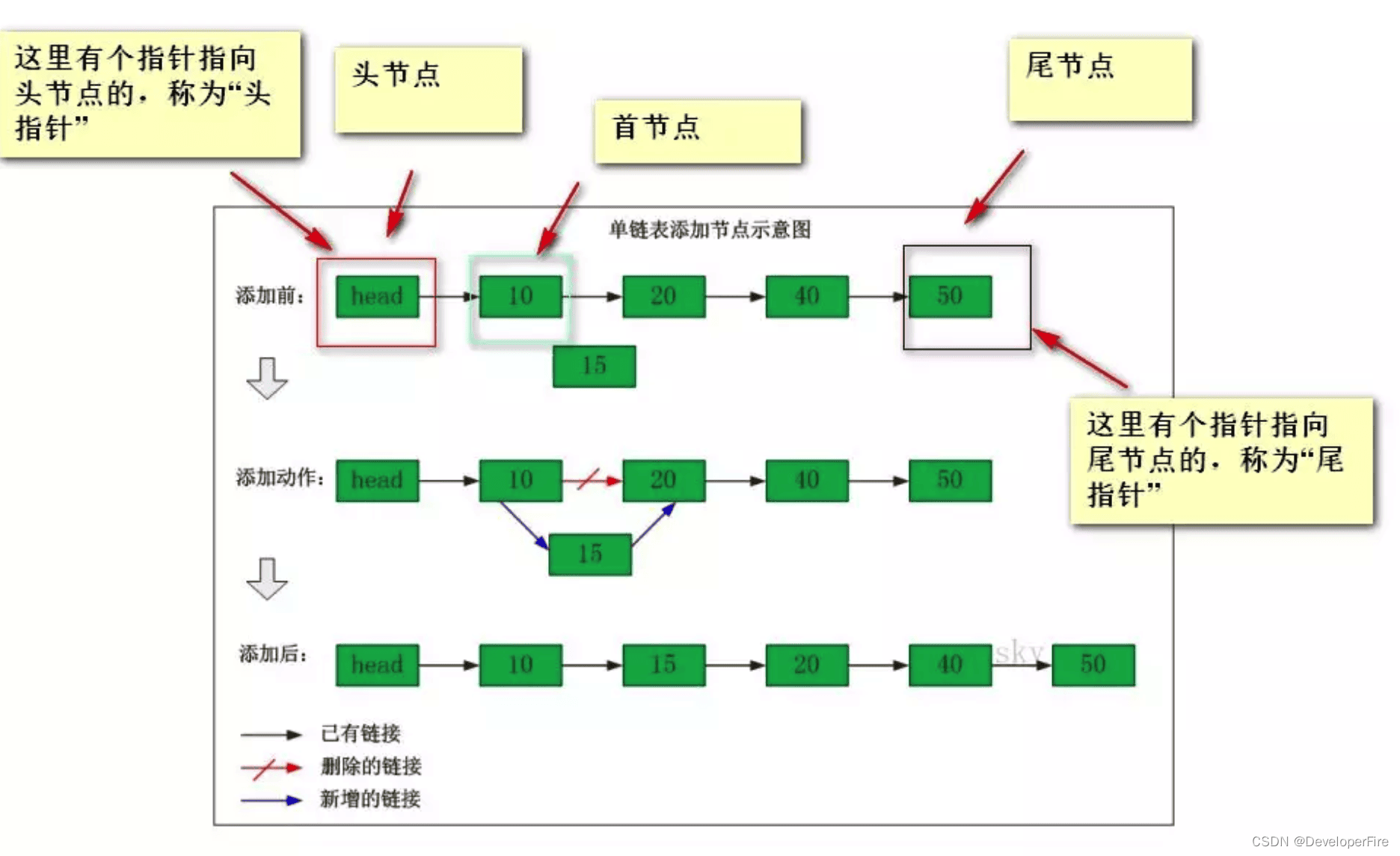

扩容时对链表的处理如下图所示:

get方法

public V get(Object key) {

Node<K,V> e;

return (e = getNode(hash(key), key)) == null ? null : e.value;

}

get方法的主体是getNode方法,所以我们直接看getNode方法:

final Node<K,V> getNode(int hash, Object key) {

Node<K,V>[] tab; Node<K,V> first, e; int n; K k;

if ((tab = table) != null && (n = tab.length) > 0 && // 哈希表非空

(first = tab[(n - 1) & hash]) != null) { // 头结点非空

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k)))) // 头结点即是要找的结点

return first;

if ((e = first.next) != null) { // 此处存在哈希冲突

if (first instanceof TreeNode) // 头结点是树的根结点,按照树的方式处理

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

// 按照链表的方式处理,遍历链表查找

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

可以看到,get方法其实是非常容易理解的。