函数式自动微分

学习心得

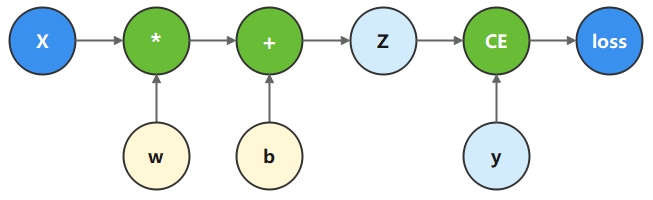

- 反向传播:神经网络在训练时,会使用一个叫做“反向传播”的方法。这个方法的基本思路是这样的:首先,神经网络会做出一个预测(我们称之为“logits”),然后我们将这个预测与真实的答案(我们称之为“label”)进行比较,通过一个叫做“损失函数”的工具来得到一个“loss”(损失值)。这个损失值可以告诉我们神经网络的预测有多不准确。接下来,我们利用反向传播算法来计算如何调整神经网络的参数,以使得损失值降低。这个计算过程会生成一个“梯度”(gradients),梯度可以告诉我们应该如何调整神经网络的参数。最后,我们会根据这个梯度来更新神经网络的参数。

- 自动微分:自动微分是一个强大的工具,它可以自动地计算一个函数在任意点上的导数值。在神经网络训练中,自动微分可以帮助我们更轻松地计算梯度。它通过将复杂的数学运算分解为一系列简单的基本运算,从而自动地计算出梯度,而不需要我们手动进行复杂的求导计算。这大大简化了神经网络的训练过程,降低了使用深度学习框架的门槛。

- MindSpore使用函数式自动微分的设计理念,提供更接近于数学语义的自动微分接口grad和value_and_grad

笔记

import numpy as np

import mindspore

from mindspore import nn

from mindspore import ops

from mindspore import Tensor, Parameter

在这个模型中,

x

x

x为输入,

y

y

y为正确值,

w

w

w和

b

b

b是我们需要优化的参数。

x = ops.ones(5, mindspore.float32) # input tensor

y = ops.zeros(3, mindspore.float32) # expected output

w = Parameter(Tensor(np.random.randn(5, 3), mindspore.float32), name='w') # weight

b = Parameter(Tensor(np.random.randn(3,), mindspore.float32), name='b') # bias

# 计算损失(loss)的函数

def function(x, y, w, b):

z = ops.matmul(x, w) + b

loss = ops.binary_cross_entropy_with_logits(z, y, ops.ones_like(z), ops.ones_like(z)) # 损失函数,计算预测值和目标值之间的二值交叉熵损失。

return loss # ,z

grad_fn = mindspore.grad(function, (2, 3))

grads = grad_fn(x, y, w, b)

print(grads)

(Tensor(shape=[5, 3], dtype=Float32, value=

[[ 6.56869709e-02, 5.37334494e-02, 3.01467031e-01],

[ 6.56869709e-02, 5.37334494e-02, 3.01467031e-01],

[ 6.56869709e-02, 5.37334494e-02, 3.01467031e-01],

[ 6.56869709e-02, 5.37334494e-02, 3.01467031e-01],

[ 6.56869709e-02, 5.37334494e-02, 3.01467031e-01]]),

Tensor(shape=[3], dtype=Float32, value= [ 6.56869709e-02, 5.37334494e-02, 3.01467031e-01]))

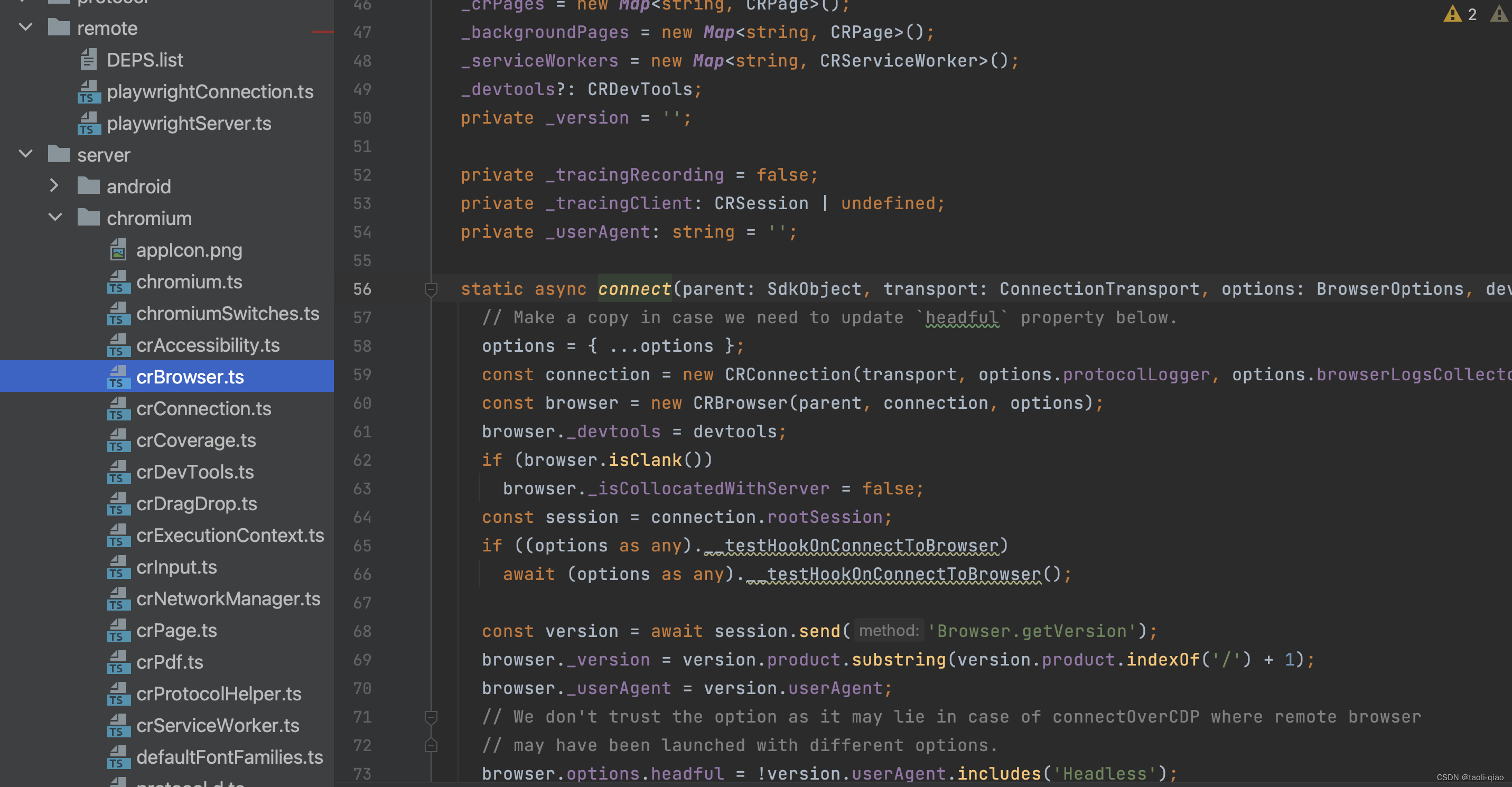

神经网络梯度计算

class Network(nn.Cell):

def __init__(self):

super().__init__()

self.w = w

self.b = b

def construct(self, x):

z = ops.matmul(x, self.w) + self.b

return z

# Instantiate model

model = Network()

# Instantiate loss function

loss_fn = nn.BCEWithLogitsLoss()

# Define forward function

def forward_fn(x, y):

z = model(x)

loss = loss_fn(z, y)

return loss

grad_fn = mindspore.value_and_grad(forward_fn, None, weights=model.trainable_params())

loss, grads = grad_fn(x, y)

print(grads)

(Tensor(shape=[5, 3], dtype=Float32, value=

[[ 2.38697276e-01, 2.73945987e-01, 1.91579953e-01],

[ 2.38697276e-01, 2.73945987e-01, 1.91579953e-01],

[ 2.38697276e-01, 2.73945987e-01, 1.91579953e-01],

[ 2.38697276e-01, 2.73945987e-01, 1.91579953e-01],

[ 2.38697276e-01, 2.73945987e-01, 1.91579953e-01]]), Tensor(shape=[3], dtype=Float32, value= [ 2.38697276e-01, 2.73945987e-01, 1.91579953e-01]))

![[RPI4] 树莓派4b安装istoreos及使用 -- 1. 系统安装](https://img-blog.csdnimg.cn/direct/55d8c7eaba514c77a772d3754112865b.png)