1.定义

在机器学习中,偏差(Bias)和方差(Variance)是评估模型泛化能力的重要概念。它们描述了模型在训练数据上的表现以及对新数据的适应能力。

-

偏差(Bias) :

- 偏差是指模型的预测值与真实数据的偏差程度。

- 高偏差意味着模型对训练数据的拟合程度不够,通常表现为欠拟合(Underfitting)。

- 欠拟合的模型可能过于简单,没有捕捉到数据中的复杂关系。

-

方差(Variance) :

- 方差是指模型在不同训练数据集上的预测结果的波动程度。

- 高方差意味着模型对训练数据中的噪声和细节过于敏感,容易过拟合(Overfitting)。

- 过拟合的模型在训练数据上表现很好,但在新的、未见过的数据上表现差。

理想情况下,我们希望模型既有较低的偏差也有较低的方差,这样它就能在训练数据上表现良好,同时对新数据也有较好的泛化能力。我们希望找到一个偏差和方差都较低的模型,即能够很好地拟合训练数据,同时具较好的泛化能力。这需要通过调整模型的复度、增加训练数据、使用正则化等方法来平衡偏差和方差。

理解偏差和方差对于选择合适的机器学习模型和调整模型参数至关重要。

通俗易懂点说:偏差衡量的就是拟合能力,偏差越小说明训练集拟合的越好,但是同时有可能会过拟合;方差衡量的是训练集的变化对泛化性能的影响,方差越大说明如果在训练集上的一点变换就会对泛化性能造成很大影响。

补充:

噪声(噪音):

在机器学习中,噪声(Noise)或称为噪音,指的是数据中存在的随机误差或不相关的信息,这些信息并不反映潜在的数据生成过程或模式。噪声可能会干扰模型的学习过程,导致模型性能下降。以下是我给出的关于噪声的一些具体的特点:

-

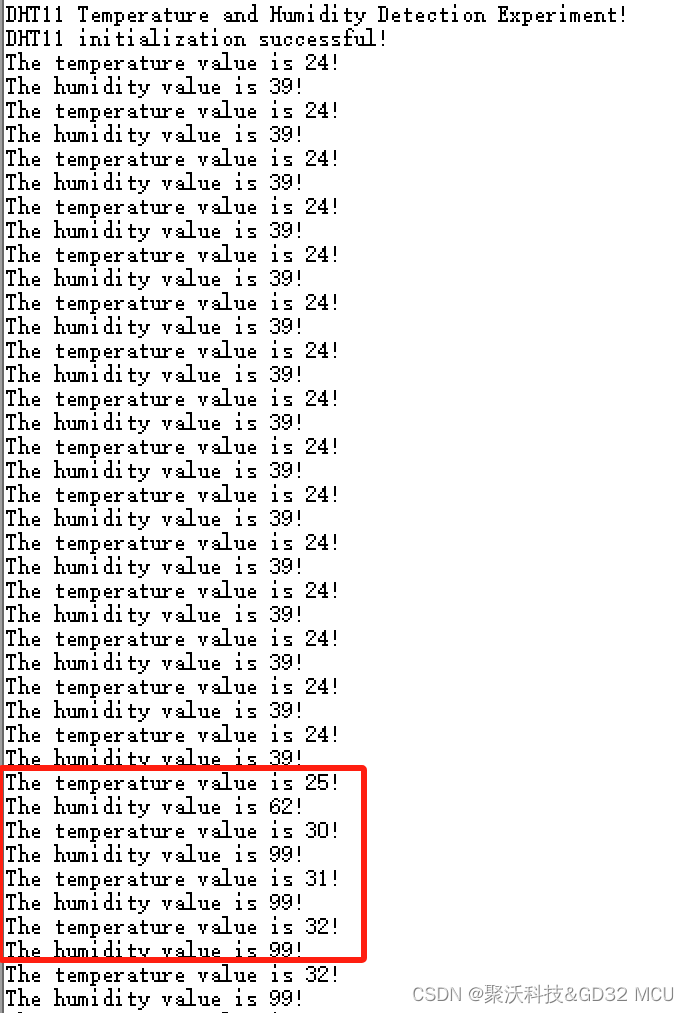

随机误差:噪声通常是由于测量误差、数据输入错误或其他随机因素引起的。例如,在收集温度数据时,可能会由于仪器的不精确性而引入噪声。

-

不相关的信息:噪声还可以指那些与目标变量无关,但存在于数据集中的信息。这些信息可能会误导模型,使其学习到错误的模式。

-

过拟合:噪声是导致过拟合的主要原因之一。如果模型对噪声过于敏感,它可能会学习到数据中的随机波动,而不是潜在的模式。这会导致模型在训练数据上表现良好,但在新数据上的泛化能力下降。

-

数据清洗:为了减少噪声对模型性能的影响,通常需要进行数据清洗,包括去除异常值、填补缺失值和平滑数据等。

-

鲁棒性:一个鲁棒的模型应该能够抵抗噪声的影响,专注于学习数据中的潜在模式。这可以通过使用正则化技术、集成方法或选择更简单的模型来实现。

-

半监督学习和无监督学习:在某些情况下,可以使用无监督学习方法(如聚类或降维)来识别和去除噪声,或者使用半监督学习方法来利用未标记的数据来提高模型对噪声的抵抗力。

-

噪声对模型选择的影响:噪声的存在可能会影响模型选择。例如,对于具有高噪声的数据集,可能需要选择更简单的模型或使用正则化技术来防止过拟合。

总之,噪声是机器学习中需要特别注意的问题,因为它可能会干扰模型的学习过程并降低模型的性能。通过数据清洗、选择合适的模型和使用鲁棒的学习方法,可以减少噪声对模型性能的影响。

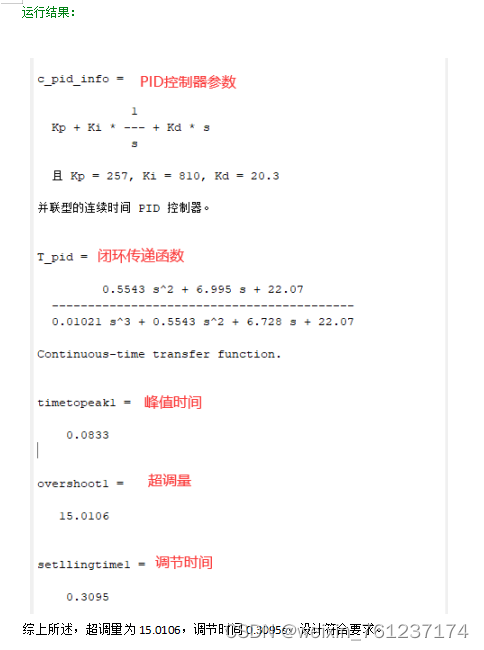

2.高方差与高偏差

在机器学习中,偏差(Bias)和方差(Variance)是评估模型泛化能力的重要指标,它们共同决定了模型在未知数据上的表现。理解高偏差和高方差的概念对于选择合适的模型和调整模型参数至关重要。

高偏差(High Bias)

高偏差通常发生在模型过于简单,无法捕捉到数据中的复杂关系时。这种情况下,模型倾向于对训练数据进行欠拟合(Underfitting)。具体表现如下:

- 训练误差高:模型在训练集上的表现就很差,无法学习到数据的基本规律。

- 泛化能力弱:由于模型过于简化,它在新数据上的表现也不会好,因为它没有学习到足够的特征来泛化到新的情况。

- 决策边界简单:在分类问题中,模型的决策边界可能非常直线,无法区分复杂的类别边界。

![B)9`X8_]RA0E]XH@XUH0G.png](https://img-blog.csdnimg.cn/img_convert/cfe9d81f0e732c04886e895c55085b67.webp?x-oss-process=image/format,png)

高方差(High Variance)

高方差则发生在模型过于复杂,对训练数据中的噪声和细节过于敏感时。这种情况下,模型倾向于对训练数据过拟合(Overfitting)。具体表现如下:

- 训练误差低:模型在训练集上的表现非常好,能够捕捉到数据中的大部分细节。

- 泛化能力差:尽管在训练集上表现良好,但模型在新数据上的表现很差,因为它学习到了训练数据中的噪声和不相关的细节。

- 决策边界复杂:在分类问题中,模型的决策边界可能非常曲折,能够捕捉到训练数据中的每一个点,但这种复杂性在新数据上可能不适用。

如何解决高偏差和高方差

-

解决高偏差:

- 增加模型复杂度:选择更复杂的模型,例如从线性模型升级到非线性模型。

- 添加特征:引入更多的特征或构造更复杂的特征,以帮助模型捕捉数据的复杂性。

- 减少正则化:如果模型使用了正则化技术,减少正则化强度可能有助于模型捕捉更多的信息。

-

解决高方差:

- 简化模型:选择更简单的模型,减少模型的复杂度。

- 增加数据:更多的训练数据可以帮助模型学习到更一般化的特征,减少对噪声的敏感性。

- 正则化:使用正则化技术(如L1、L2正则化)来限制模型的复杂度,减少对训练数据的拟合。

- 数据增强:通过数据增强技术生成更多的训练样本,以提高模型的泛化能力。

理解偏差和方差之间的权衡是机器学习中的一个核心概念,它有助于我们选择和调整模型,以达到更好的泛化性能。

- 欠拟合模型(Underfitting Model)无法捕捉数据的线性趋势,因为它太简单了。

- 过拟合模型(Overfitting Model)在训练数据上拟合得很好,但在测试数据上表现不佳,因为它捕捉了数据中的噪声。

- 适当拟合模型(Good Fit Model)在训练数据和测试数据上都表现良好,因为它找到了偏差和方差之间的平衡。

3.学习曲线

在机器学习中,学习曲线(Learning Curve)是一个非常有用的工具,用于分析和诊断模型的性能问题。学习曲线通过展示模型在不同大小的训练集上的性能(通常是训练误差和验证误差)来帮助我们理解模型的学习能力。

学习曲线的组成

学习曲线通常由两部分组成:

-

训练误差(Training Error):模型在训练集上的平均误差。这表示模型对已见过的数据的拟合程度。

-

验证误差(Validation Error)或交叉验证误差(Cross-Validation Error):模型在与训练集不同的验证集或通过交叉验证得到的平均误差。这表示模型对未见过的数据的泛化能力。

学习曲线的类型

根据模型的表现,学习曲线可以揭示不同的问题:

-

高偏差(欠拟合):如果训练误差和验证误差都相对较高,且两者之间的差距不大,这表明模型太简单,无法捕捉数据的基本规律,即存在高偏差。

-

高方差(过拟合):如果训练误差远小于验证误差,且两者之间的差距随训练集大小的增加而增大,这表明模型对训练数据学得过多,包括噪声和细节,即存在高方差。

-

适当的拟合:如果训练误差和验证误差都相对较低,且两者之间的差距不大,这表明模型找到了一个较好的平衡点,能够很好地泛化到新数据。

如何使用学习曲线

-

选择模型复杂度:通过观察学习曲线,可以选择一个合适的模型复杂度,以避免欠拟合或过拟合。

-

确定数据量:如果模型在较小的训练集上表现不佳,可能需要更多的训练数据来提高模型性能。

-

调试模型:如果模型存在性能问题,学习曲线可以帮助确定问题类型(高偏差或高方差),从而采取相应的解决措施。

绘制学习曲线

绘制学习曲线通常涉及以下步骤:

-

选择模型:确定要分析的模型。

-

划分数据集:将数据集划分为多个不同大小的子集作为训练集,剩余部分作为验证集。

-

训练模型:对每个大小的训练集训练模型,并记录训练误差和验证误差。

-

绘制曲线:在同一个图表上绘制训练误差和验证误差曲线,通常横轴表示训练样本的数量,纵轴表示误差。

示例代码

以下是使用Python和scikit-learn库绘制学习曲线的示例代码:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.model_selection import learning_curve

# 假设 X_train 和 y_train 是你的训练数据

X_train, y_train = ...

# 定义模型

model = ...

# 计算学习曲线

train_sizes, train_scores, test_scores = learning_curve(

model,

X_train,

y_train,

cv=3, # 交叉验证的折数

n_jobs=4, # 并行计算的核数

train_sizes=np.linspace(.1, 1.0, 5))

# 计算平均值和标准差

train_mean = np.mean(train_scores, axis=1)

train_std = np.std(train_scores, axis=1)

test_mean = np.mean(test_scores, axis=1)

test_std = np.std(test_scores, axis=1)

# 绘制学习曲线

plt.figure()

plt.plot(train_sizes, train_mean, 'o-', label="Training error")

plt.plot(train_sizes, test_mean, 'o-', label="Cross-validation error")

plt.fill_between(train_sizes, train_mean - train_std, train_mean + train_std, alpha=0.1)

plt.fill_between(train_sizes, test_mean - test_std, test_mean + test_std, alpha=0.1)

plt.xlabel("Number of training samples")

plt.ylabel("Error")

plt.title("Learning Curve")

plt.legend(loc="best")

plt.show()

学习曲线示例:

通过分析学习曲线,可以获得关于模型性能和数据需求的宝贵见解。

4.泛化能力与数据敏感度

泛化能力和对数据的敏感性在机器学习模型中是相对的,它们之间存在一种权衡关系。这种权衡通常被称为偏差-方差权衡(Bias-Variance Tradeoff)。

泛化能力

泛化能力是指模型对未见过的数据进行预测的能力。一个具有强泛化能力的模型能够从训练数据中学习到普适的规律,并能够将这些规律应用到新数据上,从而做出准确的预测。

对数据的敏感性

对数据的敏感性是指模型对训练数据中的细节和噪声的反应程度。一个对数据高度敏感的模型可能会捕捉到训练数据中的每一个细节和异常值,包括那些可能不具有普适性的噪声。

偏差-方差权衡

-

高偏差(欠拟合):模型太简单,对数据的敏感性低,无法捕捉到数据中的复杂关系。这种模型的泛化能力通常较差,因为它无法学习到足够的特征来泛化到新数据上。

-

高方差(过拟合):模型太复杂,对数据过于敏感,会捕捉到训练数据中的噪声和细节。虽然这种模型在训练数据上的表现可能很好,但它的泛化能力也较差,因为它学习到了太多特定于训练数据的特征。

-

适当的拟合:模型复杂度适中,既能够捕捉到数据中的重要特征,又不会对噪声和细节过于敏感。这种模型通常具有较好的泛化能力。

如何平衡泛化能力和对数据的敏感性

-

模型选择:选择一个复杂度适中的模型,避免过于简单或过于复杂的模型。

-

特征工程:通过特征选择或特征提取减少数据中的噪声和不相关特征,提高模型的泛化能力。

-

正则化:使用L1或L2正则化等技术限制模型的复杂度,减少对数据的敏感性。

-

数据增强:通过数据增强等技术增加训练数据的多样性,提高模型对新数据的适应性。

-

交叉验证:使用交叉验证等方法评估模型的泛化能力,避免过拟合。

-

早停:在训练过程中,当验证集上的性能不再提升时停止训练,以防止过拟合。

通过这些方法,可以在提高模型对数据的敏感性的同时,保持或提高其泛化能力,从而达到更好的预测性能。

注意:

泛化能力强的模型并不意味着对数据完全不敏感,而是它能够识别出数据中真正重要的特征和模式,而不是被噪声和细节所干扰。换句话说,泛化能力强的模型能够从数据中学习到普适的规律,并能将这些规律应用到新数据上,而不是仅仅记住训练数据的特定实例。

以下是其间一些制衡关系的特点特性:

- 区分信号与噪声:泛化能力强的模型能够区分数据中的信号(有用的信息)和噪声(无用的干扰),而不会过度拟合噪声。

- 学习普适特征:泛化能力强的模型倾向于学习那些在训练集和新数据中都适用的特征,而不是只适用于训练集的特定特征。

- 避免过拟合:泛化能力强的模型不太可能出现过拟合现象,即不会对训练数据中的每一个细节都过于敏感,包括那些在新数据中不会出现的细节。

- 适度的复杂度:泛化能力强的模型通常具有适度的复杂度,既不会太简单而无法捕捉数据的复杂性,也不会太复杂而对数据过于敏感。

- 稳健性:泛化能力强的模型对数据的小变化更加稳健,不会因为训练数据中的小波动而产生大的预测变化。

- 推广到新数据:泛化能力强的模型能够更好地推广到新数据上,即使新数据与训练数据在分布上略有不同。

总之,泛化能力强的模型并不是对数据不敏感,而是它能够更加智能地对数据进行敏感,专注于那些对预测任务最重要的信息,同时忽略那些不重要的噪声和细节。通过适当的模型选择、特征工程、正则化、数据增强等技术,可以提高模型的泛化能力,使其在新数据上表现更好。

以上就是我关于机器学习中偏差和方差知识点的理解以及笔记,欢迎大家点赞,收藏和交流!!!

如何系统的去学习大模型LLM ?

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的 AI大模型资料 包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

😝有需要的小伙伴,可以V扫描下方二维码免费领取🆓

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

阶段1:AI大模型时代的基础理解

- 目标:了解AI大模型的基本概念、发展历程和核心原理。

- 内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

- 目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

- 内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.2.1 什么是Prompt

- L2.2.2 Prompt框架应用现状

- L2.2.3 基于GPTAS的Prompt框架

- L2.2.4 Prompt框架与Thought

- L2.2.5 Prompt框架与提示词

- L2.3 流水线工程

- L2.3.1 流水线工程的概念

- L2.3.2 流水线工程的优点

- L2.3.3 流水线工程的应用

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

- 目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

- 内容:

- L3.1 Agent模型框架

- L3.1.1 Agent模型框架的设计理念

- L3.1.2 Agent模型框架的核心组件

- L3.1.3 Agent模型框架的实现细节

- L3.2 MetaGPT

- L3.2.1 MetaGPT的基本概念

- L3.2.2 MetaGPT的工作原理

- L3.2.3 MetaGPT的应用场景

- L3.3 ChatGLM

- L3.3.1 ChatGLM的特点

- L3.3.2 ChatGLM的开发环境

- L3.3.3 ChatGLM的使用示例

- L3.4 LLAMA

- L3.4.1 LLAMA的特点

- L3.4.2 LLAMA的开发环境

- L3.4.3 LLAMA的使用示例

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

- 目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

- 内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

学习计划:

- 阶段1:1-2个月,建立AI大模型的基础知识体系。

- 阶段2:2-3个月,专注于API应用开发能力的提升。

- 阶段3:3-4个月,深入实践AI大模型的应用架构和私有化部署。

- 阶段4:4-5个月,专注于高级模型的应用和部署。

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓