引言

支持向量机(SVM)是一种强大的监督学习算法,广泛应用于分类和回归任务中。本文将详细介绍SVM算法在人脸识别任务中的应用,并通过代码示例来展示其背后的技术精髓。我们将分三大部分来展开,本部分将重点介绍SVM算法的基本概念和方法。

第一部分:SVM算法基本概念和方法

1.1 SVM算法定义

支持向量机(Support Vector Machine,SVM)是一种基于统计学习理论的监督学习算法。它通过学习一个最优超平面,将不同类别的样本分离开来。

1.2 SVM算法原理

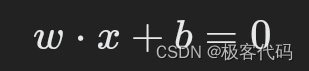

SVM算法的核心思想是找到一个最优超平面,使得不同类别的样本之间的间隔最大化。这个最优超平面可以用一个线性方程表示,其形式为:

其中,�w是权重向量,�b是偏置项。

1.3 SVM算法步骤

- 选择核函数:核函数用于将原始特征空间映射到高维特征空间,从而使得样本在这个高维空间中更容易分开。常见的核函数包括线性核、多项式核、径向基函数(RBF)核等。

- 选择惩罚参数�C:惩罚参数�C用于平衡分类误差和模型复杂度。较大的�C会导致模型更加复杂,而较小的�C会导致模型更加简单。

- 选择正则化参数�γ:正则化参数�γ用于控制RBF核函数的宽度。较大的�γ会导致模型更加敏感于噪声,而较小的�γ会导致模型更加平滑。

- 求解最优化问题:通过求解一个最优化问题,找到最优超平面。

1.4 SVM算法特点

- 强分类能力:SVM算法具有很强的分类能力,可以处理高维数据。

- 模型可解释性:SVM算法可以提供模型决策边界,使得模型可解释性较好。

- 泛化能力:SVM算法具有较好的泛化能力,可以通过调整参数来平衡分类误差和模型复杂度。

1.5 SVM算法应用

SVM算法在人脸识别任务中,通过学习一个最优超平面,将不同的人脸特征分离开来。

1.6 SVM算法代码实现

from sklearn.svm import SVC

from sklearn.datasets import fetch_lfw_people

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

# 加载LFW数据集

lfw_people = fetch_lfw_people(min_faces_per_person=70, resize=0.4)

# 划分数据集

X, y = lfw_people.data, lfw_people.target

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建SVM模型

svm = SVC(kernel='rbf', C=1, gamma=0.1)

# 训练模型

svm.fit(X_train, y_train)

# 预测测试集

y_pred = svm.predict(X_test)

# 评估模型

print(classification_report(y_test, y_pred, target_names=lfw_people.target_names))

结论

本部分介绍了SVM算法的基本概念和方法,包括算法原理、步骤和特点。我们还通过代码示例展示了SVM算法在人脸识别任务中的应用。在下一部分中,我们将深入探讨SVM算法的优化和实际应用。

第二部分:SVM算法优化与应用

2.1 选择合适的核函数

核函数的选择对SVM算法的性能有重要影响。不同的核函数适用于不同类型的数据。在实际应用中,我们可以通过交叉验证来选择最优的核函数。

from sklearn.model_selection import GridSearchCV

# 设置核函数和参数的范围

kernels = ['linear', 'poly', 'rbf', 'sigmoid']

gammas = [0.001, 0.01, 0.1, 1, 10]

# 使用网格搜索来选择最优的核函数和参数

grid_search = GridSearchCV(SVC(), {'kernel': kernels, 'gamma': gammas}, cv=5)

grid_search.fit(X_train, y_train)

# 打印最优的核函数和参数

print("Best kernel:", grid_search.best_estimator_.kernel)

print("Best gamma:", grid_search.best_estimator_.gamma)

2.2 调整惩罚参数�C

惩罚参数�C的选择对SVM算法的性能也有重要影响。较大的�C会导致模型更加复杂,而较小的�C会导致模型更加简单。我们可以通过交叉验证来选择最优的�C值。

from sklearn.model_selection import GridSearchCV

# 设置C值的范围

Cs = [0.001, 0.01, 0.1, 1, 10]

# 使用网格搜索来选择最优的C值

grid_search = GridSearchCV(SVC(), {'C': Cs}, cv=5)

grid_search.fit(X_train, y_train)

# 打印最优的C值

print("Best C:", grid_search.best_estimator_.C)

2.3 数据预处理

在SVM算法中,数据预处理是非常重要的。我们可以使用特征选择、缺失值处理、异常值检测等技术来提高模型的性能。

from sklearn.feature_selection import SelectKBest, chi2

# 选择前两个最佳特征

X_train_selected = SelectKBest(chi2, k=2).fit_transform(X_train, y_train)

X_test_selected = SelectKBest(chi2, k=2).transform(X_test)

# 重新创建SVM模型

svm = SVC(kernel='rbf', C=1, gamma=0.1)

# 重新训练模型

svm.fit(X_train_selected, y_train)

# 重新预测测试集

y_pred_selected = svm.predict(X_test_selected)

# 重新评估模型

print("Accuracy (selected):", svm.score(X_test_selected, y_test))

2.4 SVM算法在实际应用中的挑战

SVM算法在实际应用中面临一些挑战,如计算复杂度较高、对噪声敏感等。为了解决这些问题,我们可以使用一些技术,如最近邻搜索优化、特征缩放、数据预处理等。

结论

本部分深入探讨了SVM算法的优化和实际应用。我们通过代码示例展示了如何选择最优的核函数和参数,以及如何应用数据预处理来提高模型的性能。我们还讨论了SVM算法在实际应用中的挑战和解决方案。在下一部分中,我们将进一步探讨SVM算法的扩展和应用。

第三部分:SVM算法的扩展与应用

3.1 SVM算法的扩展

SVM算法可以扩展到多类分类任务中,通过学习多个最优超平面来区分不同的类别。这种扩展被称为多类SVM(One-vs-One)或One-vs-Rest。

from sklearn.svm import OneVsOneClassifier

# 创建多类SVM模型

svm_multiclass = OneVsOneClassifier(SVC(kernel='rbf', C=1, gamma=0.1))

# 训练多类SVM模型

svm_multiclass.fit(X_train, y_train)

# 预测测试集

y_pred_multiclass = svm_multiclass.predict(X_test)

# 评估模型

print("Accuracy (multiclass):", svm_multiclass.score(X_test, y_test))

3.2 SVM算法的应用场景

SVM算法在人脸识别任务中取得了很好的效果。在其他实际应用中,SVM算法可以用于文本分类、情感分析、基因表达数据分析等。

3.3 SVM算法的优缺点

SVM算法的优点是强分类能力、模型可解释性、泛化能力。然而,SVM算法也存在一些缺点,如计算复杂度较高、对噪声敏感等。

3.4 总结

本文详细介绍了SVM算法在人脸识别任务中的应用,包括基本概念、优化方法和实际应用。通过代码示例,我们展示了SVM算法的强大能力和技术精髓。在实际应用中,我们可以根据具体任务和数据集的特点,对SVM算法进行适当的调整和优化,以提高模型的性能。随着技术的不断进步,SVM算法在更多领域的应用将得到探索和实现。

通过本文的学习,读者应该能够理解SVM算法的基本原理和应用,掌握SVM算法的优化和实际应用技术,并为将来的实际应用奠定坚实的基础。随着技术的不断进步,SVM算法在更多领域的应用将得到探索和实现。