MIRIA: A Mixed Reality Toolkit for the In-Situ Visualization and Analysis of Spatio-Temporal Interaction Data

- 摘要

- 1 引言

- 2 背景及相关工作

- 2.1 用户交互和运动数据分析

- 2.2 沉浸式分析

- 3 时空用户交互分析

- 3.1 现有系统的用例和分析

- 3.2 要求

- 4 MIRIA 工具包

- 4.1 一般概念

- 4.2 实施概述

- 4.3 元数据描述及数据导入

- 4.4 数据处理

- 4.5 可视化视图

- 4.6 系统和时间线控制

- 5 分析工作流程以及实际示例和专家反馈

- 5.1 基于平板电脑的 3D 可视化空间交互

- 5.2 多人游戏

- 5.3 进一步的应用示例

- 5.4 专家反馈和工具改进

- 5.5 讨论和限制

- 6 结论和未来的工作

- 参考文献

摘要

在本文中,我们提出了 MIRIA,这是一个混合现实交互分析工具包,旨在支持混合现实和多显示环境中用户交互的现场可视化分析。到目前为止,有效探索和分析此类新颖计算系统中的交互模式的选择很少。借助 MIRIA,我们通过直接在原始环境中支持多个共处一地的用户对用户移动、空间交互和事件数据的分析来解决这一差距。根据我们自己的经验以及对现有方法中使用的典型数据、任务和可视化的分析,我们确定了系统的要求。我们报告 MIRIA 的设计和原型实现,它根据这些要求提供信息,并提供各种可视化效果,例如 3D 运动轨迹、位置热图和散点图。为了证明 MIRIA 对于现实世界分析任务的价值,我们使用多个具有真实研究数据的用例进行了专家反馈会议。

CCS CONCEPTS

- Human-centered computing → Mixed / augmented reality; Visualization toolkits;

- Information systems → Data analytics.

KEYWORDS

interaction analysis, immersive analytics, in-situ analysis, in-situ visualization, augmented reality, human-computer interaction, visualization

1 引言

近年来,沉浸式和多显示环境越来越受到从业者和研究人员的关注,除了传统的桌面或移动使用场景之外,它也受到了越来越多的关注。他们利用各种设置,例如大型交互式显示墙或混合现实头戴式显示器,有时与空间跟踪移动设备或附加的固定显示器结合使用。例如,在可视化研究中,沉浸式分析[54]将混合现实技术的使用与自然和具体的用户交互相结合,以支持沉浸式环境中数据的可视化分析。

为了深入了解人们如何使用此类新颖的设置,进行了用户研究,这些研究经常会产生大量异构的时空数据,包括运动、用户交互和其他事件,需要对这些数据进行可视化和分析才能获得所需的见解。然而,当今的分析工具(例如,[8, 74])大多是 2D、单用户,并且仅限于桌面,使分析师远离可能对用户行为产生至关重要影响的丰富而复杂的环境。例如,在从固定角度进行分析时,数据中的模式可能并不明显,或者在没有原始环境背景的情况下难以解释。此外,经典工具通常不能充分支持高级计算环境中采用的各种形式的多模式交互[10],这些交互结合了用户移动、空中手势、笔和触摸以及凝视等输入通道。

我们相信,在原位(即直接在原始环境中)可视化交互数据可以支持多显示和增强现实(AR)环境中的空间交互分析。为此,我们设计了一个名为 MIRIA(混合现实交互分析工具包)的工具包,它通过将空间交互数据的 AR 可视化嵌入到最初记录的物理位置来允许这种形式的现场数据探索和分析。

我们支持对不同交互数据进行可视化分析,因为这些数据通常记录在用户研究中:一方面,我们基于跟踪的(主要是三维的)位置数据可视化 3D 轨迹。这包括环境中人员的移动、空间交互中移动设备和控制器的路径以及虚拟相机路径。另一方面,我们提供位于 3D 环境中的可配置 2D 视图,可用于可视化空间数据的 2D 投影(例如,地板上的用户位置)以及表面或显示器上的 2D 事件(例如)。 ,触摸显示墙。我们还支持聚合视图,例如热图或散点图。

本文的三个主要科学贡献及其总体结构如下:

我们的第一个贡献是对增强现实和多显示环境中记录的时空交互数据进行原位混合现实分析的概念,包括其要求和挑战。基于对相关工作的系统回顾和我们自己研究空间和多模态用户交互的经验,我们深入分析了现有的空间用户交互分析方法。我们专门研究了典型的、特定领域的分析任务、最常见的数据类型和来源,以及已经使用的可视化。从这篇评论中,我们得出了现场交互可视化和分析的要求和典型挑战。根据这些要求,我们提出了 MIRIA 工具包的概念,强调了如何可视化位置和事件数据以及我们设想用户如何与这样的系统交互。

我们的第二个贡献是通过提出一个工作原型系统来展示我们概念的技术可行性。我们描述了 MIRIA 工具包的设置、重要的设计选择和实现细节。与许多现有的解决方案相比,我们的工具包具有多用户功能,因此允许进行同地协作视觉分析,例如将人机交互 (HCI) 和不同目标领域的专家配对。 MIRIA 工具包在一台或多台 Microsoft HoloLens 增强现实头戴式显示器上独立运行,并且可以轻松部署在各种不同的环境中,独立于外部跟踪系统或中央数据服务器等任何仪器。

我们的第三个贡献是初步评估,说明我们的方法如何有利地用于研究数据的协作视觉分析。为此,我们与专家一起报告了我们系统的实际演练,使用了四项用户研究的真实数据,我们对其中两项进行了更详细的讨论。这些示例案例研究涵盖不同的技术设置(混合现实、大型显示墙和多显示环境)、各种交互方式(触摸、有形物体、远距离指向、空间输入)以及单用户和多用户场景。

2 背景及相关工作

我们的工作涉及多个研究领域。接下来,我们将首先研究经典的(主要是基于桌面的)用户交互分析,以及其他上下文中的运动数据。与大多数现有系统相比,我们的方法集中于探索空间交互数据的沉浸式现场可视化。因此,我们随后还讨论了沉浸式分析发展领域的相关工作。

2.1 用户交互和运动数据分析

大多数情况下,基于桌面或基于网络的分析工具用于探索和分析 HCI 用户研究中的用户交互。分析与经典图形用户界面交互的技术包括凝视或点击数据的热图 [33, 55]。然而,为了分析虚拟环境中的空间交互或用户行为,需要专门的工具。例如,GIAnT [74] 允许分析用户在大型多点触控显示墙前的运动和领地性。它提供热图和散点图等 2D 可视化效果,以在墙壁显示屏上显示用户移动、交互和注视数据,并捕获视频流以及距显示屏的距离或触摸频率等基本统计数据。布鲁迪等人。 [8]提供了一种分析工具来研究群体交互,例如人和设备的 f-formations。他们的工具可以通过轨迹、视频播放和热图来可视化人们在一段时间内的位置和运动。此外,它支持搜索查询来识别邻近区域或注意力分组。 Tang 等人的 VisTACO。 [71]是一种在交互式桌面表面上协作期间识别空间行为模式的工具。通过基于桌面的工具,可以可视化记录的多个用户在桌面上的交互序列。

还有用于分析特定传感器和模式的工具。例如,Kinect Analysis [59] 针对微软的 Kinect 传感器来跟踪和可视化身体运动,而 GestureAnalyzer [42] 则专注于手势数据的分析。用于可视化基于时间的用户或组交互数据的其他工具包括 EXCITE [53]、VICPAM [57]、ChronoViz [30] 和 Panoramic [80]。 VU-Flow [19] 是分析虚拟环境中运动模式的早期示例,支持 2D 轨迹图、热图和流图。此外,还有用于虚拟现实 (VR) 和增强现实 (AR) 应用中交互分析的商业解决方案,例如 Cognitive3D1。

还有用于分析特定传感器和模式的工具。例如,Kinect Analysis [59] 针对微软的 Kinect 传感器来跟踪和可视化身体运动,而 GestureAnalyzer [42] 则专注于手势数据的分析。用于可视化基于时间的用户或组交互数据的其他工具包括 EXCITE [53]、VICPAM [57]、ChronoViz [30] 和 Panoramic [80]。 VU-Flow [19] 是分析虚拟环境中运动模式的早期示例,支持 2D 轨迹图、热图和流图。此外,还有用于虚拟现实 (VR) 和增强现实 (AR) 应用中交互分析的商业解决方案,例如 Cognitive3D1。

虽然现有的经典工具提供了强大的(大部分)2D 可视化来分析用户交互或运动,但通常缺少用户位置和运动的空间上下文。例如,“为什么轨迹图会有间隙?”、“为什么用户总是从某个位置发起交互?”或者“为什么采取某些姿势?”用这些工具很难回答。我们相信,对这些现象的探索可以受益于现场分析,通过清晰地显示数据与环境之间的空间关系,例如,以 1:1 的比例围绕桌子或椅子等物理障碍物进行移动。这样的系统还可以帮助分析所产生的遮挡,例如在同地协作中,类似于 Fender 等人提出的工具。用于显示[28]和虚拟内容放置[27]。

除了用户交互之外,还可以对来自多个其他领域的空间数据进行可视化分析。这些领域包括博物馆 [49, 83] 或体育运动 [81]、交通监控和监视 [35, 72]、动物迁徙 [46] 以及战斗和海军船只路径 [3, 64] 等环境中的运动可视化75]。 Andrienko 和 Andrienko [2] 的一项调查概述了运动数据的可视化分析。这些系统大多数都基于经典的桌面设置。空间上下文通常显示为地图或通过将可视化与视频记录合成来显示。此外,在上述大多数领域中,数据是二维的或不需要 3D 表示。因此,大多使用二维投影。相比之下,在我们的领域中,用户的高度或被跟踪设备的 3D 空间运动通常很重要。我们的数据的不同之处还在于,与上面给出的许多示例相比,用户研究通常包括相对较少的具有高复杂性的轨迹,其中需要考虑许多简单的轨迹。

2.2 沉浸式分析

沉浸式分析(IA)[18,54,67]利用新颖的显示技术,例如混合现实耳机或大型显示墙以及空间或实体交互[10]来促进数据的沉浸式分析。 Fonnet 和 Prié 最近对 IA 进行了广泛的调查 [29]。我们的工作在两个方面与 IA 相关:一方面,我们的系统可以归类为 IA 本身,无论是我们使用的技术还是我们采用的主要设计原则。另一方面,我们通过提出一种方法来为 IA 领域做出贡献,该方法允许分析各种现有和未来的增强现实沉浸式分析系统中的交互。

IA 建议进行协作设置 [6, 17, 52],允许通过头戴式显示器 (HMD) [41, 70] 呈现用户特定的信息,或通过进一步的 AR 信息可视化来扩展(交互式)显示表面 [15 ,63]。 IA 的另一个潜在优势是可以在沉浸式视觉分析环境中使用整个身体进行交互 [31, 45] 并支持情景可视化,可以直接附加到与数据相关的物理对象 [26] 或将它们用作提供参考框架的地标 [12, 15]。

最近的几个例子强调了 IA 系统用于探索时空数据的可行性:In Fly with the fock [46],Klein 等人。检查了不同技术混合现实设置中鸟类追踪数据的可视化。菲尔霍等人。 [77]提出了一种时空立方体可视化,用于轨迹数据的沉浸式 VR 可视化。按照 VirtualDesk [76] 的比喻,轨迹显示在虚拟桌面环境上渲染的 2D 地图上方。他们发现,与传统设置相比,他们的系统感知到的脑力负荷较低,这表明沉浸对于此类轨迹可视化的有用性。同样,杨等人。 [82] 研究了不同形式的起点-目的地流向图,发现 3D 表示可能是有益的证据。巴奇等人。 [5] 提出了关于沉浸式分析的第一个广泛的混合方法研究之一,与专家领域用户一起测试了 ImAxes 系统 [21]。除其他测量外,他们还收集跟踪数据并对其进行分析,以了解用户如何在 VR 中移动,以及他们如何/在何处排列散点图矩阵或平行坐标图等视图。对于多维数据的协作分析,Butscher 等人。 [15]使用带有交互式桌面的 AR 环境来支持流体交互,并为此类工具提供了一组指南。

在过去的几年里,用于沉浸式数据分析的 VR 和 AR 框架已经开发出来,使科学家能够探索多维或时空数据,有时甚至是协作探索。除了通用框架(例如,[14,20,63,66])之外,还有一些专业化框架,如 FiberClay [38],用户可以将多维数据可视化为具有 VR 中抽象数据属性的 3D 轨迹(例如,空中交通数据) 。

最近,阿加瓦尔等人。 [1] 提出了对混合现实中可视化用户操作的设计空间的分析。这与我们在 3.1 节中对先前工作的分析类似,但主要涵盖 2D 可视化。 Kloiber 等人与我们的工作密切相关。 [47] 能够在记录数据的同一 VR 环境中分析用户运动,重点关注 3D 轨迹和沿时间线关键事件的可视化。相比之下,我们的工作重点是真实和 AR 环境。 Nebeling 等人的 MRAT 也与我们的工作非常相关。 [60],最近推出的混合现实分析工具包。 MRAT 可以紧密集成到 Microsoft HoloLens 的 Unity 应用程序中,并允许用户数据可视化,包括支持数据收集和预处理。作者介绍了危机模拟和分类培训应用程序的示例用例。

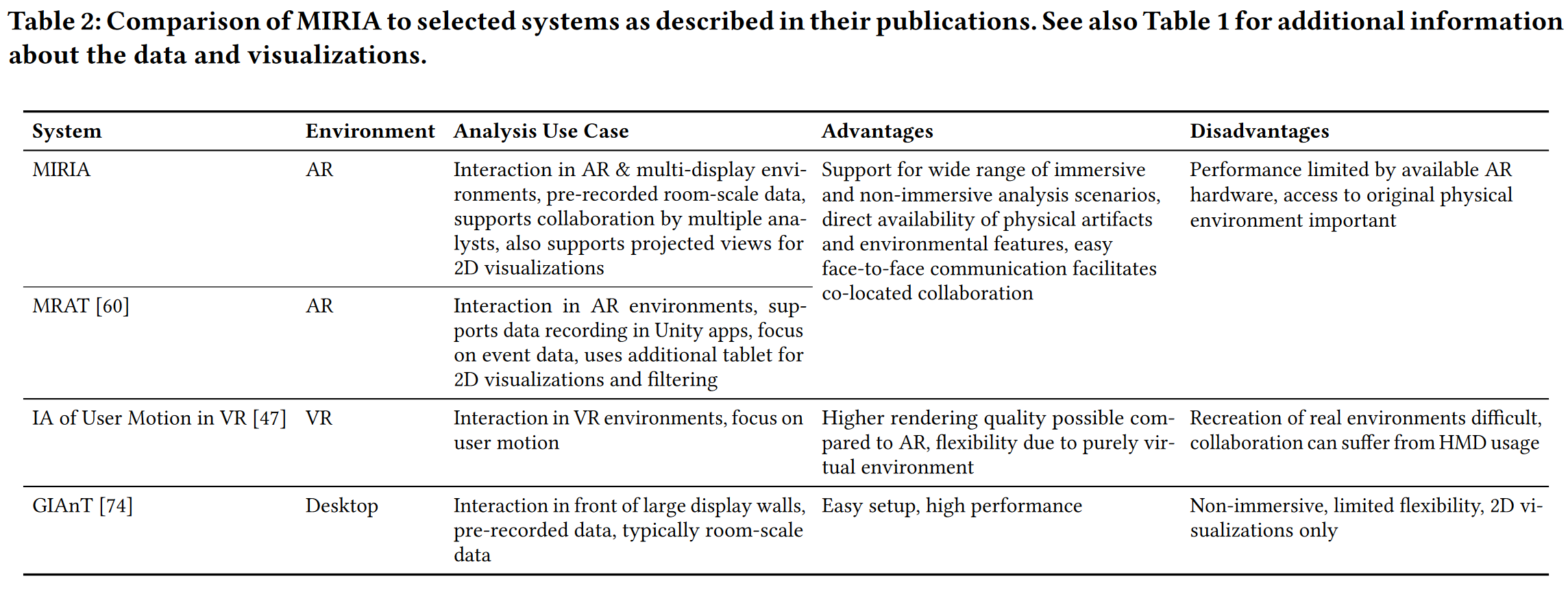

与以前的工作相比,我们较少关注应用程序集成和评估,而更多地关注物理环境中记录的研究数据的分析。此外,我们还提出了 MRAT [60] 或 Kloiber 等人不支持的各种可组合的现场可视化。 [47],包括一组可以自由放置在 AR 环境中的 2D 可视化。此外,与 [38, 47] 等 VR 系统相比,使用增强现实使我们能够保留各种 AR 和多显示环境中通常重要的现实世界背景。表2更详细地分析了AR、VR和基于桌面的交互分析系统之间的差异。

3 时空用户交互分析

在本节中,我们将更详细地研究空间用户交互的现场可视化分析的具体研究问题和要求,并报告先前工作中使用的数据、任务和可视化技术。在此基础上,我们描述了时空用户交互的混合现实分析的需求。

3.1 现有系统的用例和分析

在新颖、沉浸式或多显示环境中进行用户研究期间,研究人员捕获了大量基于用户的异构时空数据。这包括用户的动作、记录的交互事件或执行的交互序列,以及交互表面的使用,包括触摸和笔交互。信息可视化领域中此类设置的示例包括大型交互式显示墙上的可视化数据分析 [4, 48] 和 AR 可视化 [13, 41, 52]。在检查他们的系统时,研究人员通常对不同的空间和时间相关的影响和事件感兴趣。他们观察到或识别出的行为模式会对用户界面 (UI) 的设计以及技术设备和装置的布置或使用产生影响。例如,可能的研究兴趣包括:

空间利用率:用户需要走动多少距离来完成所检查的任务?交互在空间的什么位置进行以及空间交互体积有多大?这会影响交互环境的总体布置和设置以及有关跟踪量或分辨率的技术决策。

表面及其周围的交互:用户在哪里触摸交互式显示器?我们可以识别特定区域吗?显示器之间的交互是否有所不同,例如,由于尺寸和排列的原因?这些问题影响 UI 设计(UI 对象/应用程序部分的放置、面向用户的菜单部分)和技术设备的使用,例如显示安排。

用户之间的社交互动:多用户系统中的运动和移动路径是什么?用户之间是否存在干扰?我们可以检测邻近区域[34]吗?这对工作流程和支持工具的应用产生影响。

对协作者行为的意识:用户如何在空间上相互关联?合作者及其行为能够被感知吗?用户合作的紧密程度如何?这些问题会影响协作工具和工作流程的 UI 设计,提出合适的交互方式,并告知可能的(社交)冲突。

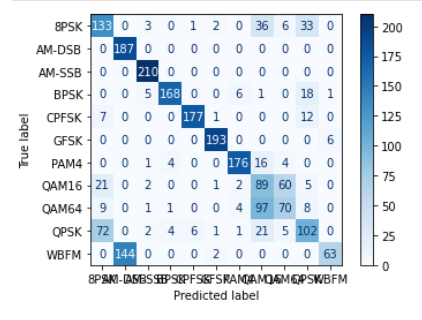

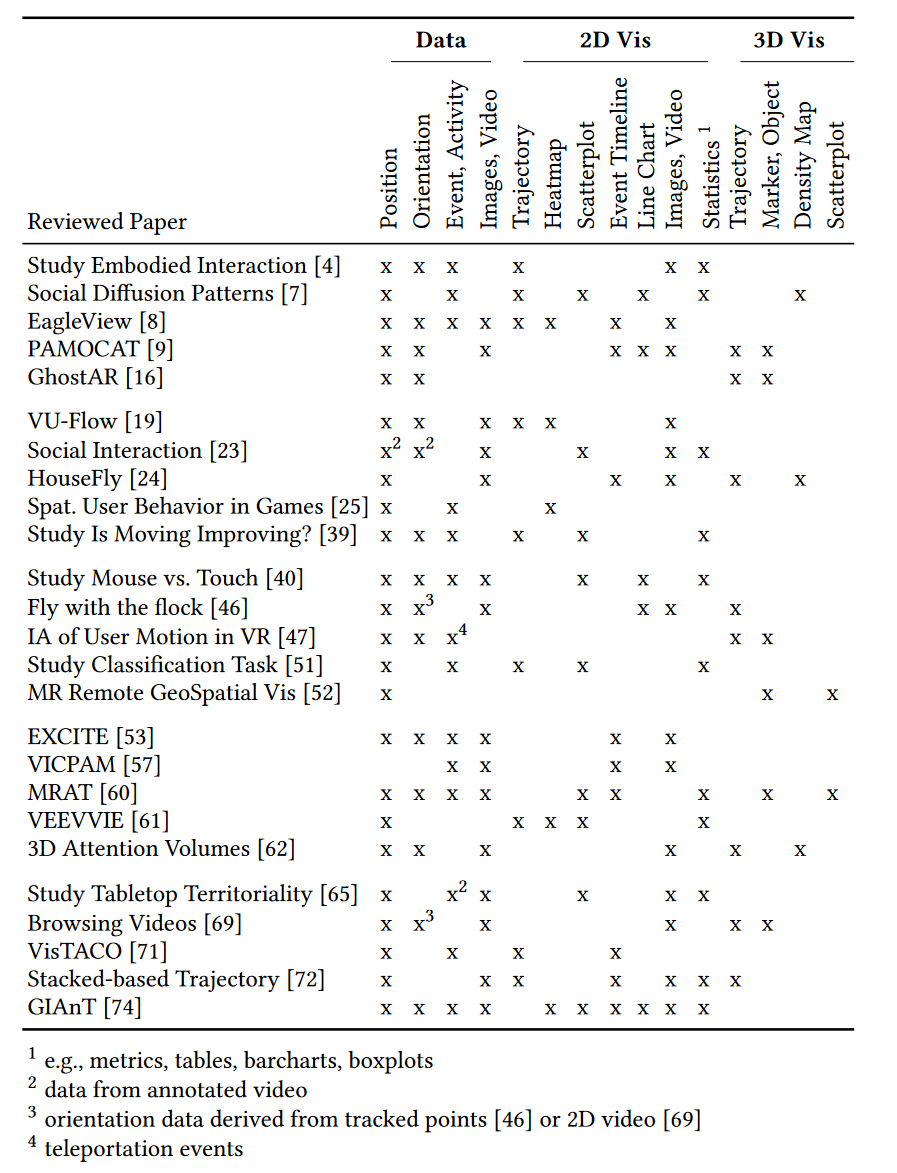

为了进一步分析,我们检查了来自不同领域的 25 篇研究论文,涉及空间分析,例如混合现实、邻近交互 [34]、计算机游戏分析和视频监控。这不是一个单一的、狭窄的研究领域,因此不可能涵盖所有相关论文。相反,我们的目标是提供来自不同领域的相关研究的良好横截面。为此,我们从 ACM CHI、IEEE VIS 或 ACM UIST 等主要会议、ACM ISS 等小型专业会议以及它们引用的论文中抽取了样本。所选论文涵盖工具包(例如,[7,8,47,60])以及特定方面的研究(例如,[39,51,65])或用例(例如,[25,46,52]) )用于空间数据分析。尽管与空间数据相关,但我们不会深入考虑经典的 GeoVis,因为它通常涉及更大的尺度,我们也不会考虑不专门支持空间交互分析的通用可视化框架。我们对典型的分析任务、数据以及用于分析的可视化感兴趣。有关论文概述和下面讨论的一些发现,请参见表 1。

一般来说,大多数系统都是基于桌面的,只有少数系统支持现场分析(例如[16,46,47,52,60])。所有检查的系统都允许对空间交互或运动数据进行一般探索,旨在了解运动或使用模式。许多还支持过滤(例如,[57, 71])或查询(例如,[8, 53])。一些系统(例如,[19,24,47,61])特别支持比较来自多个实体的运动数据。基于此和[10]中的概述,我们认为我们至少需要支持以下典型的分析任务:数据和视图规范任务(即编码/可视化、过滤、导出、重新配置)、视图操作任务(即、选择、导航/探索、组织)和处理/出处任务(即注释)。

数据通常由位置和方向组成(例如,来自用户和移动设备),有时还添加轨迹参数,例如速度 [9,19,46,47] 或曲折度 [72]。该跟踪数据通常记录为 2D 或 3D 位置及其方向(如果可能),基于所使用的跟踪或捕获系统。此外,在适用的情况下,事件数据也可以可视化,包括任务完成时间等研究数据、有关用户活动的信息(例如用户触摸、应用程序事件)和语音/文本。事件数据可能非常异构,例如事件的发生(例如,任务开始或完成)、点(例如,显示表面上的触摸)或 2D 矢量(例如,触摸轨迹)。大多数数据都以带有时间戳的时间序列记录。许多系统还使用视频记录,例如提取位置信息[23,24,69]或活动[65],以及支持稍后的分析过程(例如[8,24,40,57, 74])。

在所检查的系统中,使用以下可视化技术来分析捕获的数据:2D 可视化通常包括简单的热图(例如,[8,19,25,61,74]),2D 轨迹/路径(例如,[19,61] , 71, 72])和位置数据的散点图(例如,[7, 60, 74])。在某些情况下,使用流量图 [7, 19] 或可视化方向 [8, 74]。通常,一些(事件)时间线可视化也是可用的(例如,[57,60,71,74])。这些可视化有时与抽象可视化[61,72,74]相结合,例如折线图、平行坐标图或条形图。只有少数系统支持 3D 可视化。如果是这样,它们会显示实体位置(有时还有方向)[9,16,47,60],3D轨迹[24,46,47,69,72]或3D密度图[7,24,62]。有时,时间而不是高度被映射到垂直轴,通常用于时空轨迹。

3.2 要求

根据上述发现,我们得出的结论是,在沉浸式现场环境中巧妙结合基本 2D 和 3D 可视化有助于支持一系列基本视觉分析任务。下面,我们列出了从这些发现中得出的功能要求。我们还通过建议初始可视化和交互概念来简要解释如何在 MIRIA 等系统中满足这些要求。

(R1) 位置和运动数据的可视化:在研究沉浸式或多显示环境中的用户行为时,最重要的数据之一是用户随时间的位置和运动。在这里,我们必须考虑个人用户的移动轨迹、人们站立的区域以及他们的观看或注视方向。

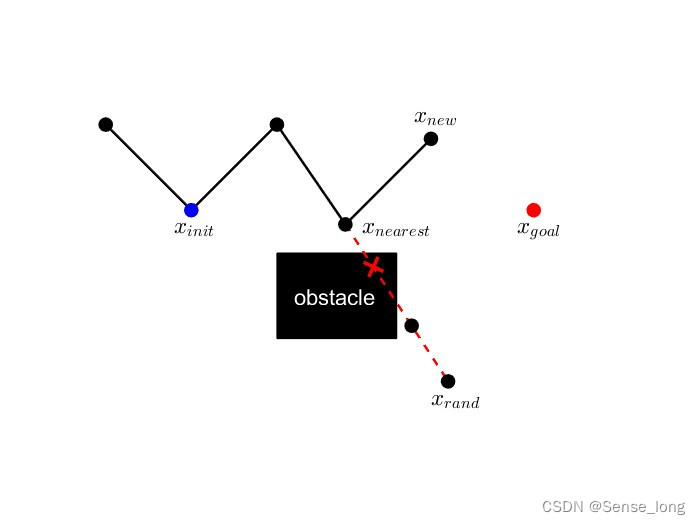

根据文献,我们建议使用时空轨迹的 3D 图来可视化跟踪对象和用户移动路径(图 2、2)。通过以 3D 方式直接可视化空间对象随时间的位置,分析人员可以查看与其上下文相关的数据,并有助于显示运动模式。数据中的当前时间步应该被标记(例如,用一个简单的字形或用户及其手的可视化,如[47]中)。对象的其他属性可以映射到颜色或线条粗细上(例如,移动速度,参见图 4 左侧)。对于所有这些方法,可视化的复杂性是可编码的信息量和由此产生的视觉混乱程度之间的权衡。

(R2) 事件数据的可视化:除了空间跟踪数据之外,基于事件的数据通常也在用户会话期间被记录。这些数据包括用户交互(如触摸、笔、语音或其他输入事件)和应用程序事件(如模式切换或任务完成),这对于模式观察和识别非常有用。这些事件的顺序和同时发生对于数据分析通常至关重要,可以显示可能的模式和依赖性。

与经典工具类似,我们建议在时间轴中呈现此类事件(图 2、6),时间在水平轴上表示,事件在垂直轴上显示(例如,作为字形或排序的堆叠带)。然而,不仅事件的时间方面很重要,而且事件发生的地点也很重要。此外,我们建议还现场显示这些事件,指示交互事件的位置和方向(例如,使用 3D 标记,如[60]中所示)。因此,分析人员可以探索首选交互距离之间的关系、物理环境如何影响用户交互以及设备的空间布置如何影响交互位置。

当交互事件在交互式显示器的表面上执行时,它们在该表面上的位置显然与数据分析相关。我们建议用二维关系(例如散点图)来显示这些事件。

(R3) 研究背景和刺激的可视化:我们认为,提供尽可能多的用户研究背景,包括有关研究环境、任务或刺激的信息,是其分析的重要要求。分析师经常使用视频或图像来记录研究设置和应用程序状态,并跟踪研究期间发生的用户操作、时间和原因。该数据可以由单个快照(例如屏幕截图或照片)或视频组成。我们建议在现场自由放置视频记录或图像,例如在墙上,以防止其他数据的遮挡。例如,对于截屏视频,我们建议将它们与录制期间使用的实际显示器耦合。对于移动设备,这意味着视频可以在播放期间随着虚拟设备表示动态移动;在固定显示器上,截屏视频可以显示为叠加层。延时或图像条等附加选项很有帮助,以便分析人员可以快速导航到有趣的时间点。

此外,3D模型可用于原位分析,以显示原始研究应用程序的重要虚拟内容,例如可视化其任务或原始数据。它们还允许在位置发生变化的情况下准确地重建研究环境(例如,如果家具或学习设备已被移除,见图 5)。

(R4) 过滤:过滤是评估和比较数据的分析过程的重要组成部分。因此,应该在多个层面上予以支持。在最基本的层面上,分析师应该能够仅显示选定课程和研究条件的数据。然后,可以通过选择应显示哪些跟踪对象或用户来执行进一步的过滤。此外,基于时间的过滤至关重要:分析师在可视化中指定特定的时间段来详细分析并与合作者进行讨论。

最后,我们建议还支持基于位置的过滤。分析师可能想要详细分析在特定位置执行的操作。例如,他们可以选择其附近的所有数据点。在实践中,上述过滤方法可以组合使用,但需要在分析过程中协作伙伴之间进行充分的口头沟通。

(R5) 注释:注释是可视化数据分析的重要组成部分。在人机交互研究中,一个典型的任务是视频编码,分析师在其中标记观察到的情况或行为。因此,我们建议注释和标记应该由现场分析工具支持,例如通过在空间中放置注释。此外,用户定义的标签可用于过滤和聚类特定的观察结果或在分析过程中突出显示它们。此外,注释不仅可以耦合到某个时间点,还可以耦合到特定位置。最后,此类标签和注释的导入和导出功能可帮助分析师在现场分析和经典桌面设置之间进行转换。

(R6) 灵活性和用户偏好:对于我们旨在通过 MIRIA 支持的原位混合现实分析,可视化的放置必须与用户在研究期间执行交互的原始位置一致。因此,分析人员需要能够在应用程序中手动重新排列虚拟场景的原点,将其与记录数据的坐标空间注册。因此,表面交互的可视化(例如,触摸的散点图、鼠标轨迹的 2D 轨迹、截屏视频的图像平面)应虚拟投影到空间中的物理显示器(或其虚拟 3D 代表)上(图 2、6)。具有聚类或聚合数据的可视化(例如,访问位置的热图)应放置在靠近空间数据可视化的位置,例如,放在地板上的轨迹(图 2、4)。然而,可视化的合适位置取决于所调查的 HCI 研究及其记录的数据,这些数据可能因研究而异(例如,请参阅第 5 节)。我们建议可以从记录的数据自动推断初始配置,但我们建议还支持初始设置的配置文件,并允许在运行时手动重新排列。

4 MIRIA 工具包

根据需求,根据文献综述以及我们自己在构建和评估混合现实和多显示环境方面的经验,我们提出了一个概念来促进时空用户交互数据的可视化分析。下面,我们首先更详细地描述这个概念。随后,我们介绍 MIRIA 工具包的实现,描述技术设置、MIRIA 管道(例如数据导入、数据处理和数据探索)以及根据所列要求实现的可视化和交互概念。

4.1 一般概念

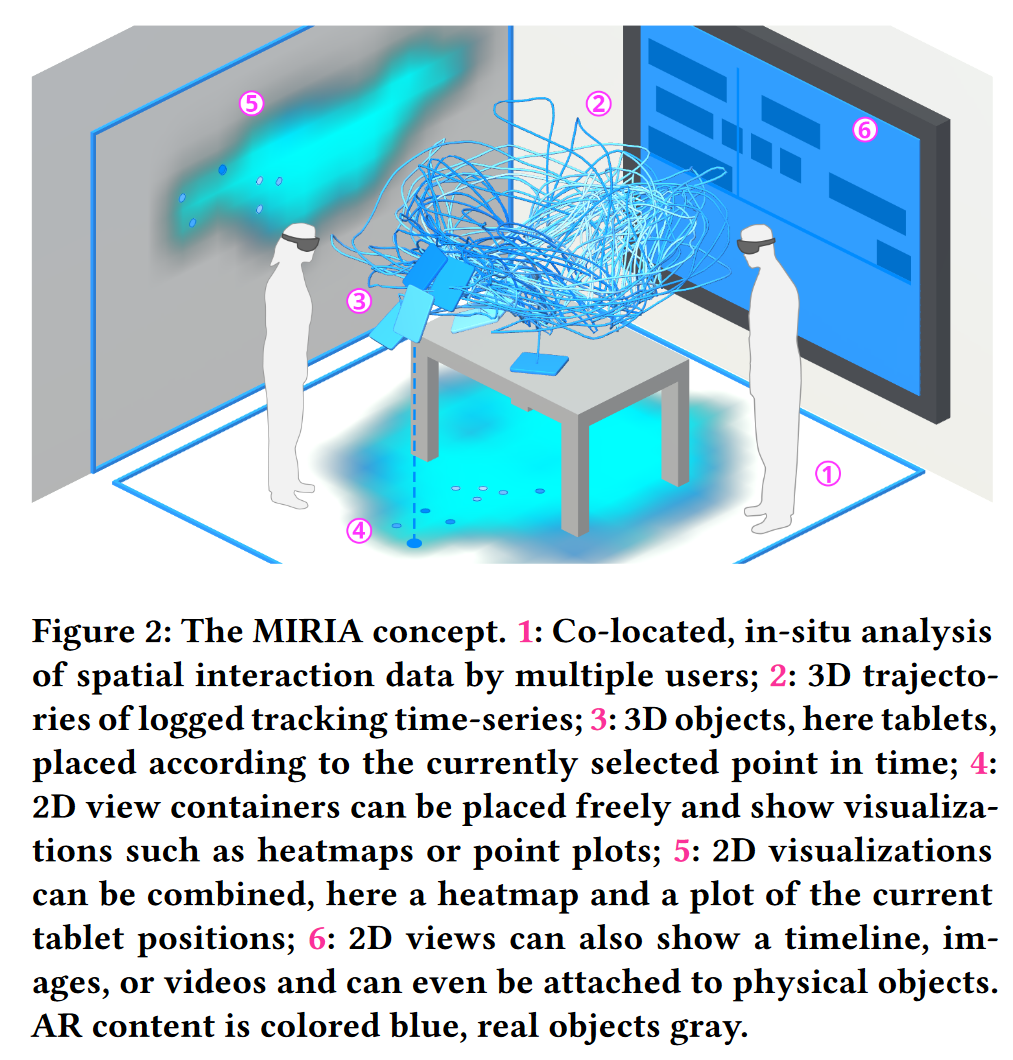

借助 MIRIA,我们的目标是让同一地点的分析师在混合现实中协作探索和分析研究数据(图 2、1)。虽然我们也认识到 VR 系统对于沉浸式分析的重要性,但我们特别关注 AR 或多显示环境中研究数据的视觉分析,从而明确针对具有物理现实世界背景的环境。对于一般设置,我们使用 HMD 来实现沉浸式 AR 体验,支持现场分析(图 2)。在我们的分析工具包中,我们将 3D 和 2D 可视化结合在一个混合现实环境中。这使我们能够利用立体视觉或运动等视觉线索的优势来改善空间 3D 数据的感知(图 2、2 和 3)。同时,2D 视图(图 2、4-6)用于可视化本机二维数据(例如,交互式表面上的触摸)或 3D 数据的 2D 投影(例如,用户在地板上的位置)。

我们方法的中心范式是实现现场分析。我们通过多种方式支持这一点:首先,通过选择 AR 而不是 VR 技术,我们可以同时感知数据和最初使用的物理环境。其次,我们支持嵌入场景几何的 3D 模型,该模型在分析期间不可用,但在捕获数据时是环境的一部分。示例可能像桌子或椅子一样简单,但也可能包括特殊设备,甚至是在 AR 研究中向参与者呈现的虚拟内容。由此,我们解决了实验室设置可能会随着时间的推移而改变的问题,原始位置甚至可能在分析阶段完全无法访问。第三,二维可视化采用虚拟矩形容器的形式。这些视图容器可以放置在场景中。我们不仅支持自由放置,还允许将视图附加到环境中的相关表面或对象(图 2、4-6)。如上所述,这使我们能够可视化地面上的运动或显示墙上的触摸位置,类似于网络分析中使用的点击地图。通过这种方式,我们支持将数据与它们在概念上链接到的设备或位置相关联。这不限于静态放置。相反,可视化还可以与研究期间移动的移动设备的跟踪动态位置相结合,例如显示触摸行为如何根据设备位置而变化。

由于经典系统中经常使用视频分析,因此我们还建议在 MIRIA 中支持视频录制的回放和图片的显示。任何经典观察摄像机的镜头都可以放置在房间中,展示从更抽象的数据日志中可能不明显的细节。更重要的是,我们还支持显示录制或屏幕截图,对此进行了扩展。在这里,我们再次看到了在记录期间使用的实际显示器的(甚至是动态的)位置现场显示用户和系统行为的记录的附加值。最后,我们认为对多名同地分析师的支持是我们概念的重要基石。因此,与大多数现有系统相比,我们支持在共享混合现实空间中进行分析,例如,允许来自不同领域的专家一起工作。

4.2 实施概述

我们在工作系统中实施了 MIRIA 概念的大部分内容。2 此实施有两个目标:首先,它证明了我们的概念在当今技术下的技术可行性。其次,MIRIA 工具包可供 HCI 研究人员使用,用于用户交互数据的可视化探索和分析。

MIRIA 工具包针对 AR 耳机,特别是 Microsoft HoloLens v2,并使用 Unity 3D 引擎和 Microsoft 的 Unity 混合现实工具包。我们开发的 MIRIA 具有多用户功能,其中一台 HoloLens 设备充当所有其他客户端连接到的服务器。因此,不需要进一步的基础设施。这使得我们只需很少的设置就可以在各种环境中使用 MIRIA。

我们的框架支持放置在 AR 环境中的不同虚拟视图:可视化视图,用于可视化记录的数据集(例如,3D 轨迹视图、热图)和应用程序视图,用于托管系统控制和可视化设置的用户界面,并提供有关当前加载的研究数据的信息。

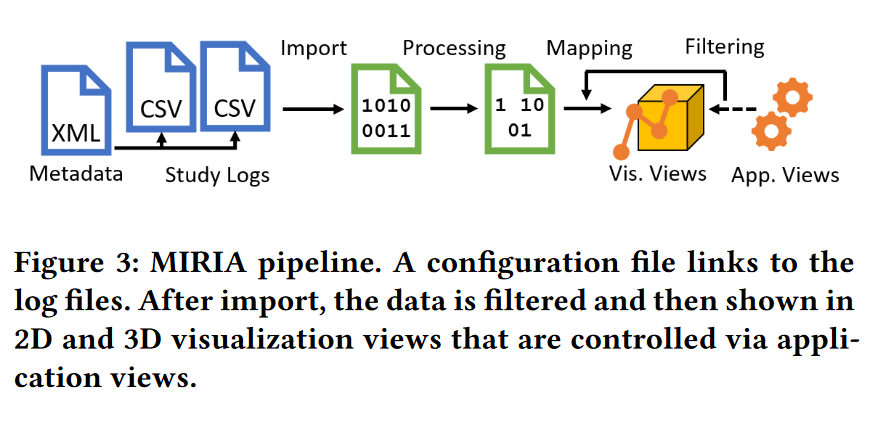

MIRIA 的底层可视化工作流程如图 3 所示:首先,导入研究数据,并将附加元数据存储在配置文件中。导入后,对数据进行预处理。然后将其显示在放置在空间中的可视化视图中。然后,分析师可以使用其他应用程序视图来过滤数据或重新配置可视化。

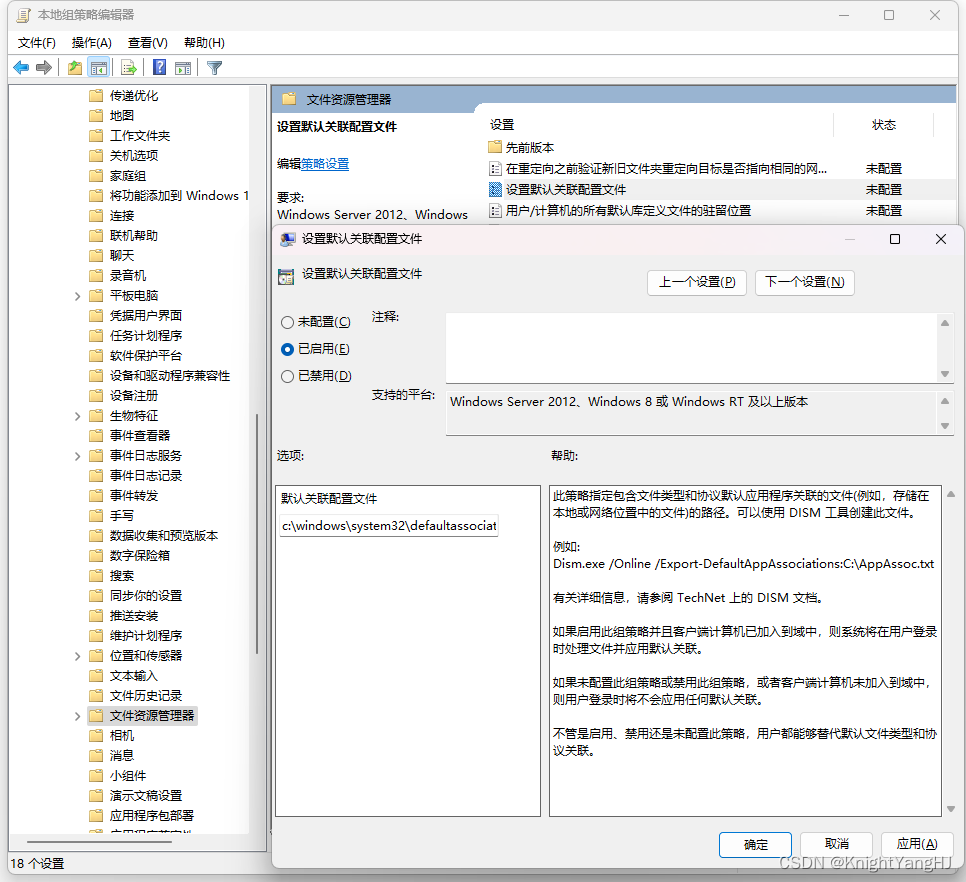

4.3 元数据描述及数据导入

为了支持广泛的应用并满足 R6 要求,我们特别注意使 MIRIA 在研究数据和设置方面尽可能灵活。捕获的跟踪和事件数据(例如时间戳、空间用户和设备位置以及触摸事件等交互)是从 CSV 文件导入的。配置 XML 文件提供有关研究的所有相关元数据。它包含研究条件和会话的定义、有关跟踪和静态场景实体的信息(例如类型或 ID)、原始坐标系的轴定义、2D 视图的初始位置,并定义定义的对象与其记录数据之间的映射在 CSV 文件中。此外,还可以加载录制的视频数据和图片,并且XML配置文件指定这些媒体对象的场景位置。这使得分析人员可以在最初拍摄的地方显示视频,例如研究期间使用的移动设备的截屏视频。

应用程序启动时,将解析所有代表一项研究的 XML 文件。然后,我们显示应用程序中所有研究的列表,允许用户选择并加载他们选择的研究。目前,所有文件都保存在 AR 耳机上并在本地加载。然而,原则上,它们也可以从服务器流式传输。

4.4 数据处理

为了应对 HoloLens 的内存和渲染限制,在导入步骤之后使用数据预处理来过滤显示的数据。特定的预处理取决于可视化,但一般来说,我们目前使用两种策略:首先,我们使用时间下采样将高频跟踪数据降低至 15 Hz。其次,我们删除与最后一个点距离非常小(< 3 cm)的跟踪点,根据我们的经验,这些点可能是跟踪中的噪声。通过这些策略以及我们研究中使用的数据,我们通常可以将要绘制的数据点数量减少约 90%。这些值可以根据用例和未来技术轻松调整。

4.5 可视化视图

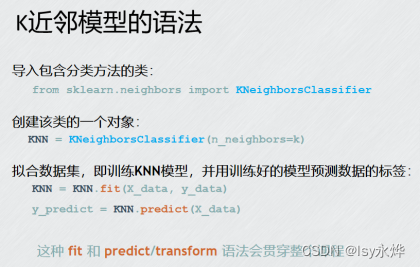

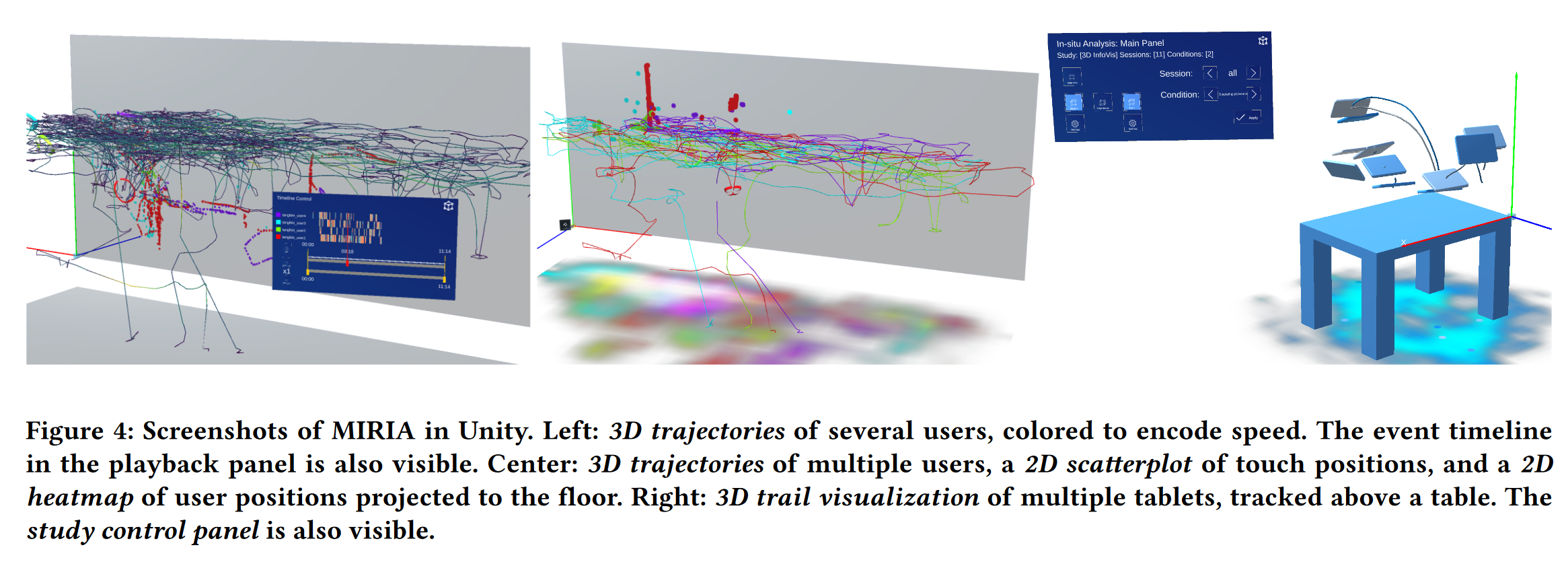

目前,我们的 MIRIA 实现支持 3D 轨迹图、3D 轨迹、2D 热图、2D 散点图、2D 点图、媒体视图和 2D 事件时间线。 3D 可视化直接渲染到 AR 环境中,而所有 2D 可视化都绘制在 3D 空间中的矩形平面上。这些容器或 2D 视图的大小、位置和方向可以通过元数据进行配置。因此,分析师可以根据研究设置或计划的分析任务轻松放置它们(图 4)。在运行时,还可以通过简单地拖动和移动 2D 视图来重新定位它们。每个 2D 视图可以同时保存多个不同的 2D 可视化,从而允许分析师组合多个可视化。例如,放置在地板上的 2D 视图可以同时显示热图和跟踪对象的当前 2D 位置,从而概述数据的分布,并显示当前位置(图 4,右)。

4.5.1 3D 可视化。在我们当前的 MIRIA 实现中,3D 轨迹(图 4,左和中)用于可视化跟踪对象(例如主体或移动设备)的空间运动,满足要求 R1。我们使用连接的三维管段来可视化物体随时间的移动,并使用简单的阴影来支持用户的深度感知。轨迹采用颜色编码,以匹配配置文件中定义的对象颜色。在我们当前的实现中,如果同时显示多个会话,则通过操纵每个可视化会话的颜色饱和度来区分轨迹和标记(图 2、2)。另外,由于跟踪对象的速度可能特别令人感兴趣,我们提供了直接在轨迹上编码该速度的选项(图 4,左)。为此,我们目前使用 Viridis 颜色图 [68]。使用相应的设置按钮,用户可以打开配置菜单,在其中可以选择要显示的轨迹,以及对于每个轨迹,是否应显示本地速度或对象颜色(R4、R5)。作为显示跟踪对象的完整路径的替代方案,我们还实现了 3D 轨迹,它仅显示当前所选时间代码的最后几秒(图 4,右)。除了这种动态的、基于时间的过滤之外,它们在功能上等同于上述 3D 轨迹。

轨迹或踪迹上的当前数据点可以由 3D 对象(例如平板电脑或风格化的 HoloLens)标记,可在配置文件中定义。这些 3D 模型可以独立于轨迹激活或停用。除了用作动态位置标记(R1)之外,我们还支持任意数量的静态对象。正如第 4.1 节中提到的,这些模型可以用于重新创建环境中已更改的部分(例如,参见图 5 中的虚拟表)或显示有关研究任务的其他上下文 (R3)。

4.5.2 2D 可视化。被跟踪对象或交互事件相对于 2D 平面(例如,显示器上的触摸)的当前位置通过 2D 点图进行可视化(图 2、2)。它将位置显示为小的彩色圆圈,并适合与 3D 轨迹或热图等结合。

我们还实现了二维散点图,以在两个空间维度 (R2) 上可视化整个此类交互事件。例如,我们使用散点图来显示截至当前时间点的所有触摸事件,并按用户进行颜色编码(图 6,左和中)。通常,没有进一步的语义信息,例如区分触摸向下/向上、拖动或按住动作。因此,我们将所有事件显示为单个、不相连的点。因此,在当前的实现中没有可视化连续的拖动动作。

在 MIRIA 中,我们还支持 2D 热图(图 4,中)。他们以聚合形式可视化位置的频率和密度(例如,交互式表面上的触摸、用户在显示器前面或旁边的位置)。为了渲染热图,我们将所有样本或事件位置投影到视图所在的目标平面,并累积每个网格单元的数量。然后,这些值被标准化、映射为颜色值,并应用于热图纹理中相应的纹素。为了提高视觉质量,我们还应用了适度的高斯模糊。对于颜色映射,我们使用对象颜色作为色调和饱和度,使用样本密度作为 HSV 颜色空间中的值。这会产生一系列不同色调的单色颜色图,我们通过 alpha 混合将其组合起来,与 [74] 中使用的过程非常相似。

在事件时间线中,我们显示事件的时间和持续时间 (R2)。可用事件的对象垂直堆叠,当前状态/事件采用颜色编码,时间映射到水平轴(图 4,左)。除了在任何 2D 视图上显示它的选项之外,我们目前还直接在播放面板上显示此时间轴可视化(比较 4.6.2)。

最后,媒体视图用于显示研究期间捕获的视频和图像数据,使我们能够向分析师提供有关研究刺激或应用环境的附加信息 (R3)。与其他 2D 可视化一样,媒体视图可以分配给任何 2D 视图。这些可以耦合到任何静态场景对象(例如,对应于用户研究期间的摄像机位置或固定的墙壁显示器)或被跟踪的可移动对象(例如平板电脑)(R6)。如前所述,媒体文件在 XML 文件中引用。在这里,分析人员还可以定义记录数据的时间偏移以及应显示视频的哪一部分。

4.6 系统和时间线控制

在介绍了 MIRIA 的各种可视化视图之后,我们描述了用户如何在物理环境中定位虚拟内容、用于控制系统的不同应用程序视图以及我们当前如何支持数据过滤。

4.6.1 数据对齐。当第一个用户创建分析会话时,场景的原点放置在他们附近,并使用简单的 3D 标记进行可视化。这一立场也与参加会议的所有其他分析师共享。然而,在任何时候,用户只需抓住场景就可以移动和旋转场景,从而使他们能够匹配记录的跟踪数据的底层坐标系。这不能自动化,因为即使对于一种给定的环境,不同研究之间的坐标系也可能有很大差异。

4.6.2 应用程序视图。应用程序视图包括用于设置和控制 MIRIA 应用程序以及分析过程的所有视图。为简洁起见,我们在此仅介绍两个最重要的视图,即学习控制面板和播放面板(图 4,左和右)。其他包括用于加入现有分析会话的会话面板或前面提到的设置面板,可以在其中即时配置可视化 (R6)。

研究控制面板根据预加载的 XML 配置文件(参见第 4.3 节)显示可用的用户研究,并允许加载所需的用户研究数据。此外,加载研究后,它会显示当前选择的研究条件和参与者等信息。它还允许用户激活或停用 3D 可视化(2D 可视化直接从其 2D 视图面板控制),并在当前数据集中的会话/参与者和条件之间进行交互切换。

MIRIA 工具的核心部分是播放面板(图 4,左)。与媒体播放器的控制界面类似,它显示当前时间点(也标记在进度条上)以及所选会话的总持续时间。按钮允许分析师开始和停止播放与时间相关的数据。默认情况下,播放是实时进行的,但我们也支持正常速度 0.25 到 8 倍之间的播放速度。我们还允许用户通过拖动滑块或单击进度栏上的任意位置来快速跳转到其他时间点。

如果一次显示多个会话,则所有数据均按第一个样本的时间代码对齐。所有与时间相关的非聚合视图都是同步的。这意味着,视频或截屏视频(如果适用于会话)也会同步播放。如上所述,我们还在该面板中显示事件时间线,与进度条对齐。

4.6.3 过滤。我们当前的 MIRIA 实现支持多种方法来过滤可视化数据,满足 R4 要求。首先,用户可以选择研究的单个或所有会话和条件进行可视化。我们还通过在任何可视化的设置面板中启用或禁用数据对象来支持对数据对象的简单过滤。此外,我们支持基于时间的数据对象过滤。为此,分析人员可以在播放面板中设置输入和输出标记来定义所需的时间段。仅考虑该时间段内的样本进行可视化。过滤适用于所有当前使用的可视化和所有对象/实体。计划在后续版本中支持基于位置的过滤,例如靠近对象或在定义的体积内。

4.6.4 协作和注释。我们决定使用同地、现场 AR 系统而不是 VR 或远程协作,这意味着多个用户对研究数据的分析自然可以得到口头交流和非语言提示(例如指向)的支持。因此,我们没有包含支持协作的特定软件功能。然而,我们发现有关设备之间的跟踪和同步状态的实时信息可以帮助确保用户正确放置数字内容。因此,我们添加了一个小指示器来标记每个用户的当前位置和方向。任何跟踪错误都会导致该指示器冻结或偏离用户位置。在我们当前的 MIRIA 实现中,我们为标签或注释提供了一些初步支持 (R5)。用户可以在空间中放置标记,以指示数据集中的有趣点等。这些标记在用户之间同步。

除了扩展注释的可能性之外,我们计划稍后添加其他功能。特别是,我们还希望包括先进的过滤方法,例如轨迹的空间过滤(例如[36])或示例过滤[43]。当前的实现可以支持研究数据的可视化分析,我们相信它清楚地表明了我们概念的可行性。因此,在下一节中,我们将描述专家在现场数据分析期间如何使用不同的 MIRIA 可视化。

5 分析工作流程以及实际示例和专家反馈

作为初步评估并说明我们的方法对现实世界分析任务的有用性,我们使用了几个具有真实数据的示例用例,并结合了不同的验证方法:我们的实施作为我们概念的技术验证,并表明典型的 HCI 研究数据可以在当前的 AR 设备上使用 MIRIA 进行可视化。此外,专家演练通过实际示例说明了 MIRIA 的使用,并为我们提供了有用的见解和反馈。不幸的是,由于疫情持续,目前无法与外部参与者进行全面评估。相反,我们邀请了我们研究所的四位同事(三名男性,一名女性),他们是 HCI 或可视化专家,熟悉一些示例用户研究,但没有直接参与 MIRIA 实施或本文。我们与每一位专家 (E1-E4) 一起进行了协作式现场数据分析,作为指导演练(每次约一小时),其中一位作者解释了软件并帮助控制它。对于这些专家反馈会议,我们使用了先前发表的论文 [12, 73] 中的两项用户研究,详细描述如下。此外,我们简要报告了两位作者对另外两个示例研究的演练,仅强调了这些场景中的一些关键点。每个实际研究示例都有不同的重点,即观察交互过程中空间交互或物理空间的使用。我们选择这些 HCI 研究示例来展示我们的工具包在数据可视化探索中的各个方面,从单用户 3D 数据分析到协作多人游戏。接下来,我们将介绍这些演练,总结专家反馈,并以对 MIRIA 工具包的讨论作为结束。

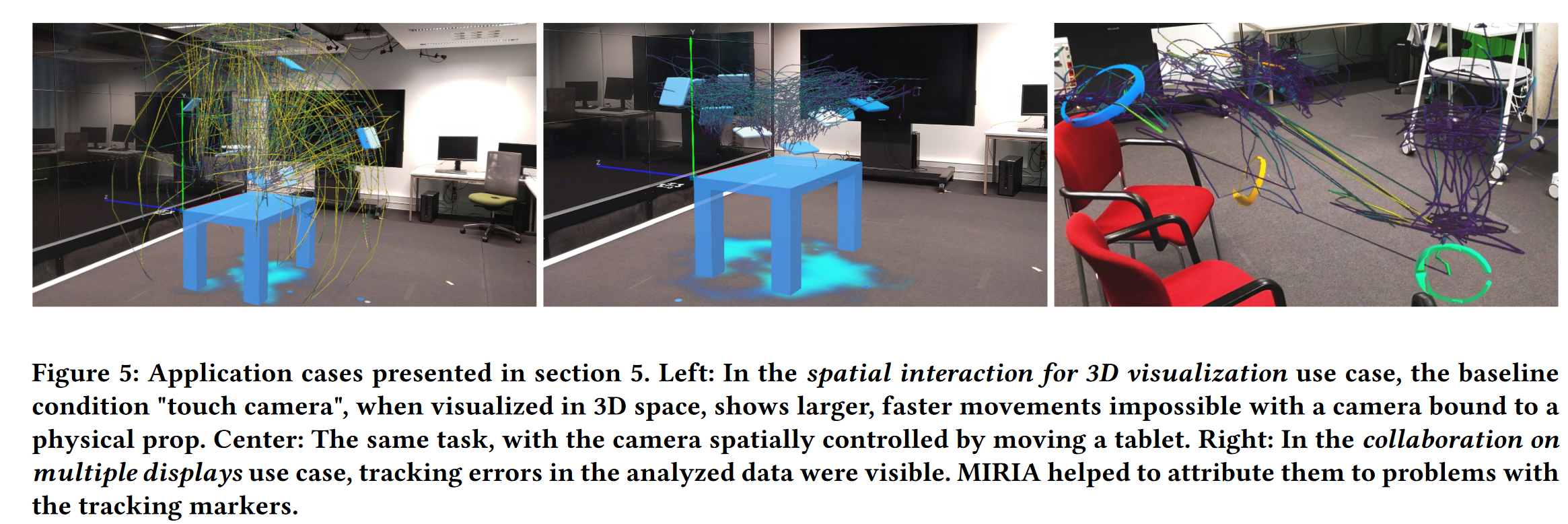

5.1 基于平板电脑的 3D 可视化空间交互

我们的第一个例子是 Büschel 等人的用户研究。 [12] 关于使用空间交互来探索 3D 可视化。具体来说,该论文比较了用户探索虚拟放置在真实桌子上的 AR 可视化与跟踪平板电脑的性能,其中基线条件是平板电脑上带有触摸控件的经典移动 3D 可视化。在这两种情况下,数据均由原始应用程序中记录的虚拟相机的 3D 位置和前向矢量(视图方向)组成。在空间交互条件下,该虚拟相机对应于从红外跟踪系统获得的平板电脑的跟踪数据。根据研究数据,我们选择了 11 名受试者的子集,这些受试者具有两种条件(空间和触摸相机)和一项任务([12] 中描述的导航任务),从而产生了超过 155,000 个样本。

为了模拟原始研究期间存在的物理表,我们在配置文件中包含了一个简单的 3D 网格作为静态场景对象。加载研究数据后,我们手动调整场景的位置,使虚拟桌子放置在地面上。由于我们的专家希望更好地了解所有数据,因此他们选择同时显示所有受试者的数据(图 5,左和中)。然后我们演示了可用的可视化。例如,我们为 2D 视图分配了位置热图和 2D 点图,使专家能够更好地感知当前平板电脑位置及其在整个任务持续时间内的分布。例如,两位专家(E3、E4)提到热图显示所有研究对象都从一个位置开始,并且一些对象绕着桌子走动。二维视图被表格部分遮挡,专家们随后根据他们关注的可视化内容选择打开和关闭表格。 3D轨迹使专家能够清楚地看到数据中触摸控制摄像机的典型模式(例如E2和E3提到的到达天花板的轨迹)。在最初的研究论文 [12] 中,已经强调了现场可视化此类交互数据的重要性,并通过物理环境来透视数据。因此,专家 (E2-E4) 可以立即看出,在此模式下相机到桌子的典型距离比研究的 AR 条件下可能的距离要大(图 5,左)。相比之下,AR 条件下的轨迹分布更密集(图 5,中)。此外,颜色编码速度还表明,触摸条件下相机移动速度更快。在回放过程中,很明显,与触摸条件类似,参与者试图通过后退一步来获得概览,并且大概在找到目标位置后,迅速将注意力集中在该点上。

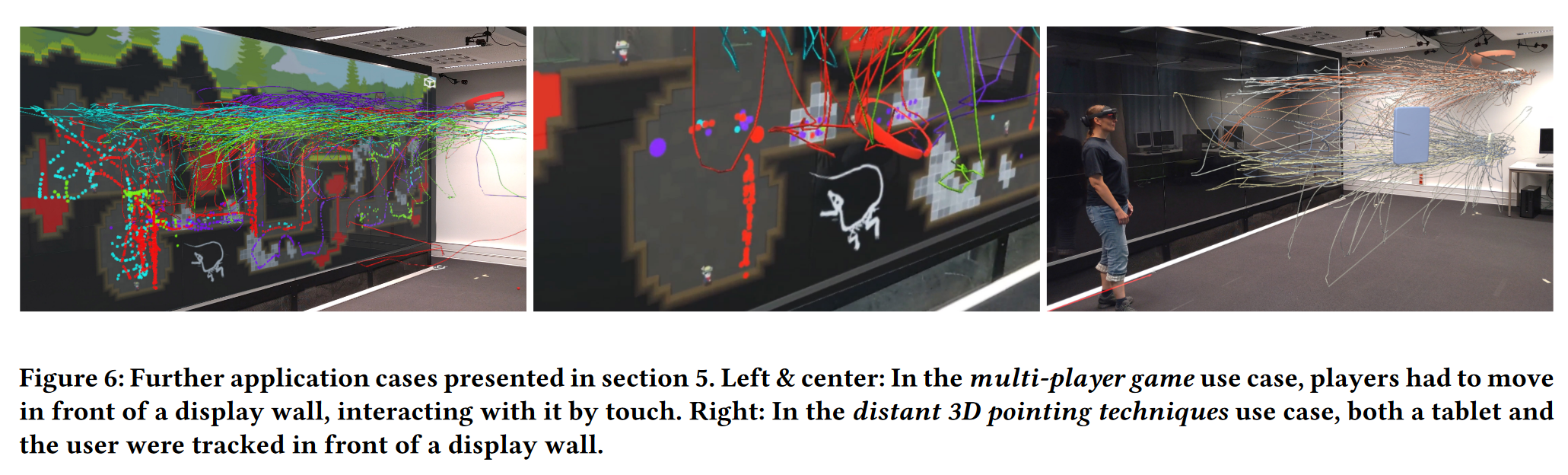

5.2 多人游戏

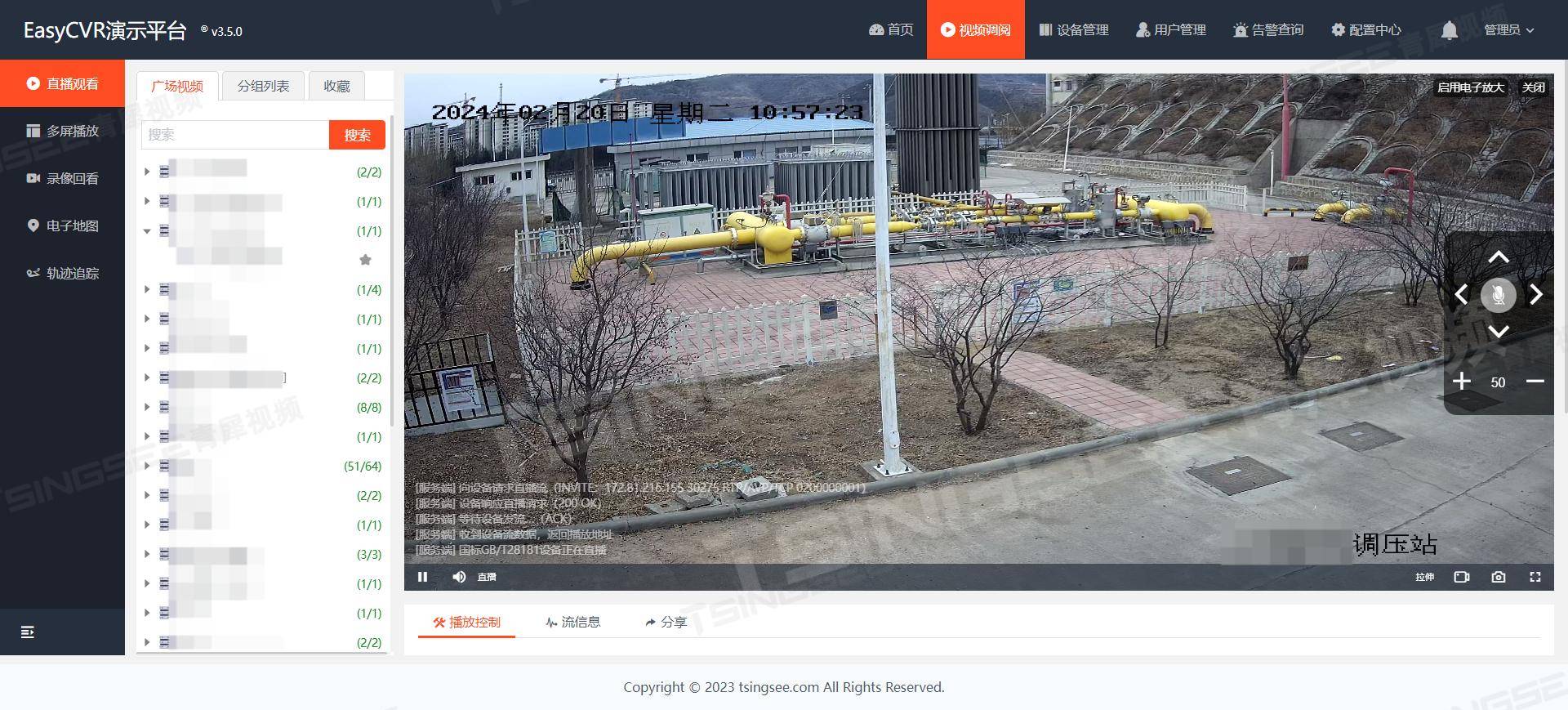

对于第二个示例,我们希望特别关注多个用户的交互数据。我们选择了 von Zadow 等人的观察研究。 [73] 关于用户在墙壁大小的显示器上进行快节奏、协作多人游戏期间的运动和意识。在这款游戏中,四名玩家必须在时间压力下,巧妙地使用墙壁表面的个人工具,引导迷失在山洞中的矿工回家。对于每个玩家,可用数据包括跟踪日志(头部位置和方向,再次由红外跟踪系统捕获)、分配的工具以及显示墙上的触摸位置。我们将自己局限于其中两个组的数据,导致大约。 9,800 个触摸位置和超过 262,000 个跟踪样本。

我们可以访问研究期间使用的显示墙 [73],使我们能够在真实的环境中使用 MIRIA 可视化和探索研究数据。此外,我们在分析过程中将游戏的屏幕截图显示为显示墙上的 AR 叠加层,提供了强大的上下文提示,这在经典分析工具中很难获得(图 1 和图 6,左和中)。

该用例中的数据量导致视觉混乱。 MIRIA 使我们能够通过在分析过程中过滤掉初始规划阶段、专注于实际游戏玩法以及根据需要打开和关闭轨迹来解决这一问题。除了玩家的 3D 轨迹之外,我们还选择在直接放置在显示墙上的 2D 视图上可视化他们的触摸位置。这使得专家能够在游戏环境中的回放过程中看到触摸(例如,参见图 6 中表示触摸的彩色点)。在这里,一位专家(E3)指出,他们可以通过视觉行为模式轻松识别出使用了哪个指定的游戏工具。游戏迫使玩家与显示墙的大部分进行交互。这在数据中立即可见。通过观察墙壁上的触摸位置以及物理环境中相应的轨迹,专家们还发现,在某些情况下,玩家必须弯腰或跪下,如图 1 和图 1 中轨迹的下部所示。在录制的研究视频中得到证实。据观察,如果没有 MIRIA 等系统,可能需要进行耗时的视频分析。随着播放速度的增加,随着时间的推移可视化数据,我们还发现玩家会非常接近地工作,但有时也会分开,这证实了[73]中提出的发现。此外,MIRIA 提供的可视化和应用视图帮助我们的专家验证记录的数据。例如,事件数据视图显示用户长达 5 分钟(游戏关卡的持续时间)的操作,但 3D 轨迹视图显示长达 10 分钟的用户动作,因为用户正在等待下一个关卡开始(例如,游戏关卡的持续时间)。 ,E3提到)。此外,MIRIA 对环境中轨迹的可视化显示,游戏结束后几分钟内,头显都放在桌子上。

5.3 进一步的应用示例

我们还使用额外的研究数据测试了我们的概念和实施,简要总结如下。

多显示器上的协作。在这项用户研究 [32] 中,观察了三人小组在多显示环境中协作、共处一地的网络搜索任务。我们获取了三个会话的人员位置跟踪数据和观察视频,会话时长约为 30 分钟。在这种情况下,存在一个具体的分析问题:部分记录的跟踪数据存在无法解释的错误。与之前的系统相比,MIRIA 的现场分析使我们能够检查跟踪摄像机与 3D 轨迹上的用户位置之间的视线。通过将 AR 可视化与物理环境结合使用,我们能够确认跟踪问题不是由所使用的大型显示器遮挡跟踪摄像机引起的,而可能是由于用于跟踪的帽子上的标记问题造成的参与者(图 5,右)。此外,在分析设置过程中,我们能够使用多个会话的 3D 轨迹和研究照片作为参考,快速轻松地重建实验室中物理对象(桌子、椅子、移动大型显示器)的一般研究布置。此外,单个受试者的 3D 轨迹和 3D 轨迹之间的轻松切换有助于更仔细地查看短数据片段,并使我们能够轻松查明长时间会话中跟踪丢失的短暂阶段。

远距离 3D 指向技术。在一项未发表的内部研究中,研究了几种基于智能手机的远程指向显示墙的技术(图 6,右)。这些数据包括用户和移动设备的跟踪数据,使我们能够在一个场景中将它们一起可视化。通过查看投射在地板上的二维热图,我们可以看到每次研究试验中从起始位置“蜂拥而出”的全球模式。此外,3D 轨迹还显示出对其中一种技术的偏好,以指向更远的地方。最后,通过同时显示用户和手机的 3D 轨迹,用户和手机之间的空间关系变得显而易见,例如,用户可以看到用户拿着手机的距离有多远,是否倾斜手机,以及当用户靠近墙壁时行为如何变化。

5.4 专家反馈和工具改进

我们所有的专家参与者 (E1-E4) 对 MIRIA 提出的现场数据分析给予了积极评价。所有专家在会议期间都非常感兴趣并积极参与,物理导航被认为很有帮助(E2、E3、E4),并且在数据探索过程中运行良好(E2、E3)。专家们提到,从分析的角度来看,播放模式最有用。其中一些人还积极提到设置播放速度(E1、E3、E4)。除了 3D 轨迹之外,同时显示多个会话的 3D 轨迹也被指出很有帮助 (E3)。所有专家都赞赏为数据分析而可视化研究背景(例如,物理显示器上的截屏视频、捕获的视频)所做的努力(E1-E4)。此外,在某些情况下,3D 轨迹可视化有助于在心理上重建研究环境的物理设置。

专家反馈还解决了一些关键问题,例如视野有限(E2、E4)以及长时间佩戴 HoloLens 时会感到疲劳(E2)。还评论了对注释的更好支持以及分析会话的配置以供重用(E3)。 4.6.4 节中提到的简单注释功能是朝这个方向迈出的第一步。此外,专家还要求能够交互式地同步多个会话的时间线 (E4) 或支持跳转标记 (E3)。为了改进 3D 轨迹可视化,专家建议对轨迹进行标记,以及配置颜色编码属性(E1、E3、E4)的可能性。

5.5 讨论和限制

前面的示例研究显示了我们当前实施和 MIRIA 概念的通用性。特别是,各种研究强调了用户交互的中心空间方面对于许多不同的沉浸式和多显示应用程序来说是多么重要;因此,对这种固有的三维数据进行视觉探索是多么重要。在某些情况下,直接在原始环境中进行的原位分析使分析人员能够更好地了解运动路径的规模或其与物理对象的关系。这也得到了立体渲染的支持,并且使用传统工具(例如[8,53,74])会更困难。在这方面,MIRIA 在各种室内环境中的部署简便性和灵活性,不需要服务器或任何房间仪表,是有利的。事实证明,针对物理空间的可视化手动校准对于我们的用例来说足够快速和精确。

此外,能够在同一空间中协作工作创造了一种引人入胜的体验,并支持我们同时研究不同的领域。虽然这也可以在基于网络的分析系统等中完成,但事实证明,关于每个用户当前位置和感兴趣区域的即时且自然的交换是有帮助的。我们想指出的是,我们通常看到的高水平的用户参与度可以使像我们这样的新颖系统对于向他人报告发现或现场讲述数据故事也很有趣。

除了我们的工具包所提供的功能和演示的适用性之外,它也有一些局限性。一个问题是,尽管有很多优点,但“在数据中”有时会妨碍从外到内的视图,而这种视图可能是获得数据初步概览所需的。我们建议允许分析师暂时缩小整个 AR 场景的规模。这样,仍然可以对 3D 交互数据进行沉浸式视觉分析,同时在与物理环境一致的现场视图和易于访问甚至可以虚拟放置在桌子上的概览之间无缝切换。我们与受邀专家讨论了这个问题,并得出结论:根据用例,该策略可能有用。此外,虽然我们工具包的技术设置很简单,但由于 MIRIA 的灵活性,手动为数据集编写配置文件可能会很麻烦。应用程序本身的更多配置选项可以解决这个问题。我们计划在该工具包的未来版本中添加这些新增功能,以及第 4 节中指出的其他当前未实现的功能,最值得注意的是扩展注释和过滤支持。有了这些功能,就需要与 MIRIA 工具包进行更复杂的用户交互,例如指定过滤器参数或输入文本。在这里,移动设备的额外使用,如[11, 84]中所研究的,对于界面控制来说可能是有希望的。最近,莉莉娅等人。 [50]提出了一种直接操纵方法来导航 VR 记录中的时间,这对于我们的用例来说可能也很有趣。

在技术方面,根据我们初步评估中使用的研究数据,MIRIA 通常可以达到 HoloLens 2 60 fps 的目标帧速率。如上所述,这些数据集包含多达 100,000 个样本(在 MIRIA 中进行任何过滤之前),代表了典型大小和持续时间的不同研究日志。然而,硬件的性能目前仍然限制了在保持交互式帧速率的同时可以显示的数据量以及渲染质量,特别是在同时显示多个可视化效果时。此外,还必须考虑色彩保真度和分辨率等感知问题。重要的是,狭窄的视野会让用户更难获得分布在更大区域的数据的概览,从而迫使用户移动头部。虽然这些考虑因素不在本文的讨论范围内,但我们相信制造商将在未来的迭代中继续解决硬件限制。

上述 MIRIA 的一些优点和局限性是 AR 应用所固有的。表 2 显示了 MIRIA 与类似系统的简要比较,并强调了与 VR 和基于桌面的解决方案的一些差异。最重要的是,MIRIA 等 AR 系统直接将物理环境与虚拟数据表示相结合,并支持面对面的交流,而 VR 系统则可以更轻松地(重新)创建任意大小的虚拟环境。因此,MIRIA 并不是要取代现有系统,而是作为专门为依赖物理人工制品或环境线索的环境而设计的替代方案。

6 结论和未来的工作

在本文中,我们提出了 MIRIA,一个用于空间用户交互数据的沉浸式视觉分析的概念和示例工具包。通过分析现有的相关系统,并根据我们自己在混合现实和多显示环境的人机交互领域的经验,我们为这种新型分析系统提出了一系列可视化概念。我们的中心思想是通过提供用于交互和事件数据的现场可视化分析的混合现实解决方案来支持研究人员和从业者。在我们的方法中,轨迹或踪迹等 3D 视图可以与视频或图像以及热图、散点图或事件时间线等 2D 可视化集成,所有这些都虚拟地放置在物理世界中,保留有价值的上下文和环境线索。我们概述了当前的实现,详细介绍了其总体结构和迄今为止实现的各个可视化。最后,我们在初步评估中证明了我们的方法的有用性。为此,我们结合了专家反馈会议和我们自己的演练,在几个实际应用示例中使用真实研究数据验证了 MIRIA,并展示了他们的设置和发现。未来,我们计划研究当前交互和可视化概念的扩展,继续开发 MIRIA 工具包,并在正式的用户研究中进一步评估我们的系统。计划添加的内容包括更强大的过滤工具、恢复分析会话和导出结果的方法,以及支持更高级别分析目标的更具体的工具,例如,可视化常见的交互区域、视线和遮挡。

参考文献

![[NewStarCTF 2023 公开赛道]R!C!E!](https://img-blog.csdnimg.cn/direct/b4d86ef72d234aaaa922d3c0d5ab953d.png)