通用具身机器人

具身智能定义

从图灵定义看,知识由感知、智能体环境交互获得,具身智能要拥有足够的知识完成机器人任务。从字面上理解就是具有身体的智能,可以从交互中学习并有可能涌现新能力。近期的具身智能更多和大模型和端到端有关,是通过学习的方式涌现的智能。

机器人形态

未来机器人的四种形态:人形机器人、仿生机器人、变胞机器人、共融机器人。

人形机器人是近期最受关注的机器人形态,人形机器人的一个潜在的好处是可以最大程度利用真人的大量视频数据。那人形是不是最终的通用机器人形态,也有反对的声音,觉得人的形态从进化上是为了从海洋走到大陆生存,人形不一定是最佳形态。

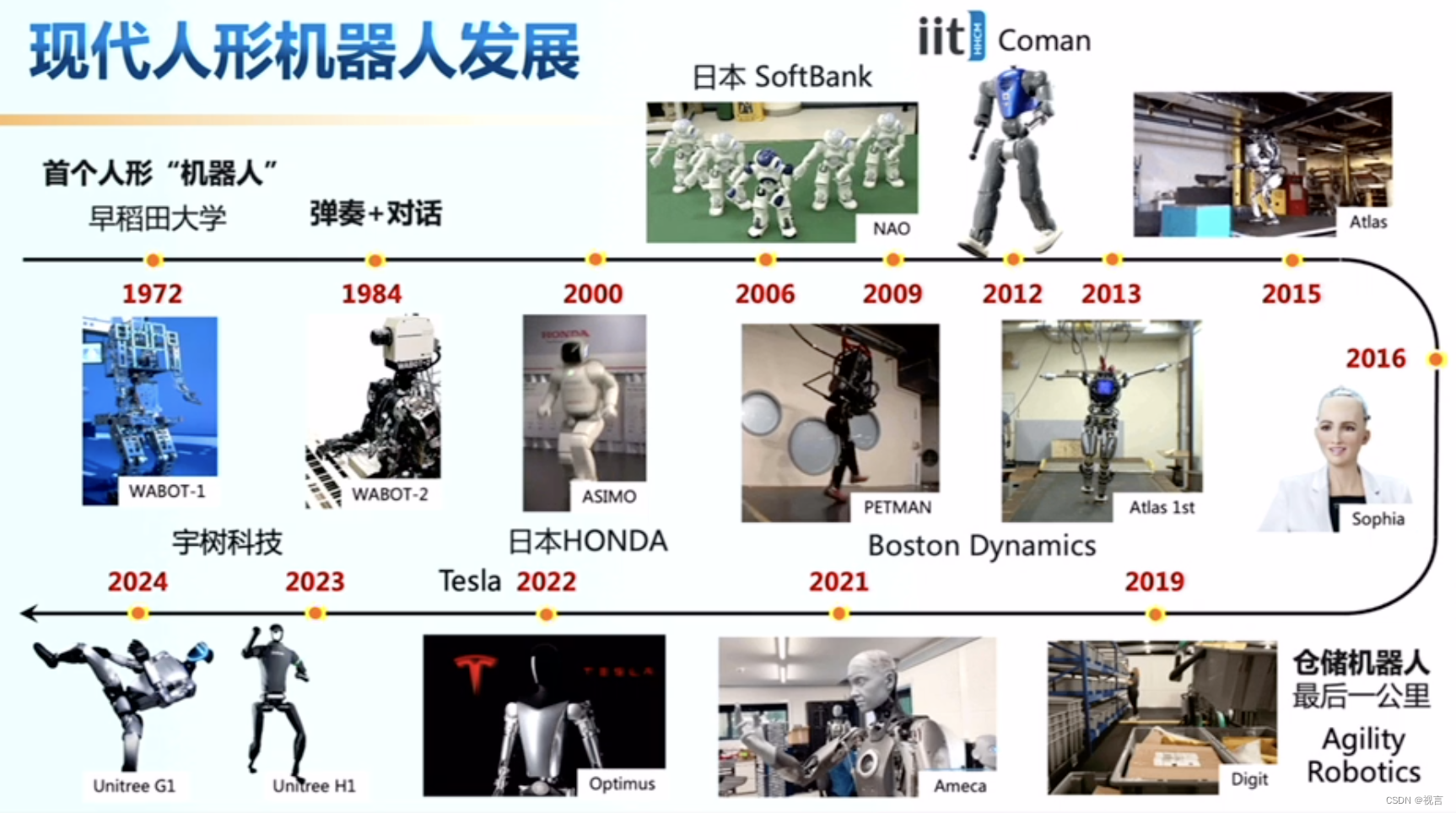

人形本体

现代人形机器人的本体经过了很长时间的发展,产生了很多有代表性的产品,如下图所示。

实现阻碍

而要实现具身智能的通用机器人,还存在一些问题和阻碍。

数据来源有限:谷歌在美国加州办公室采集17个月,得到13万数据,使得其机器人在厨房表现很好 ,但出了这个环境就从成功率97%降到30%,数据集没有办法做到scalable。

响应速度太慢:openai 和figure ai合作用的是小模型,有200hz的动作输出频率,但其泛化能力有限,如果用大模型该如何做到高频,这里面也有大量软硬件的加速工作。

自我进化能力:在数据和软硬件都满足的情况下,当前的算法能否满足复杂场景操作的能力,这仍然是一个未知数。

具身智能程度:当前的大模型对于空间时间的感知都很弱,大模型领域需要大量机器人数据

数据

机器人获取数据的形式有多种,可以通过硬件采集,仿真,利用互联网人类视频数据预训练,以及使得机器人具备足够先验后自己在环境中尝试提升。

硬件采集

动作捕捉

- Xsens 。XsensMVN全身动作捕捉,全球性能最优的惯性动作捕捉设备,可以在任何环境下实时动态捕捉人体全身欧拉角、四元数、关节角度、角速度、角加速度、重心、速度、加速度、方向、位置等运动数据及图像,纯净的动作捕捉数据不需要进行后处理即可直接使用,非常适用于人体运动数据采集。

特斯拉的工厂里包含了动捕的采集方式,

遥操作

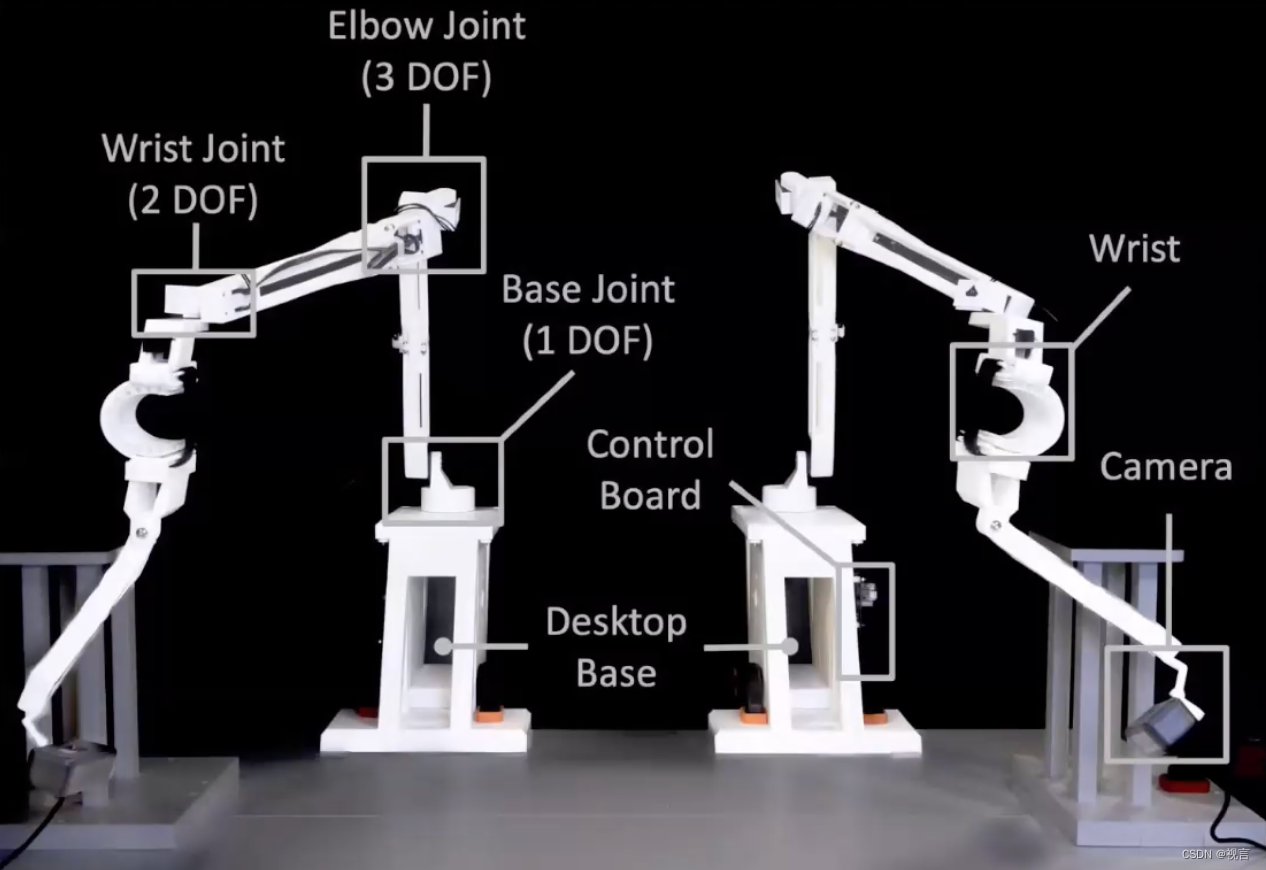

- 2024年初斯坦福mobile ALOHA火了一阵,在其被推出之前,其实在23年Q1便已有了ALOHA,所谓ALOHA,即是A Low-cost Open-source Hardware System for Bimanual Teleoperation,该系统可以通过定制远程操作接口收集实际演示,从而进行端到端的模仿学习。

而mobile ALOHA同时将其功能扩展到桌面操作之外,且做到了以下4点。移动能力:移动速度与人类行走速度相当,约为1.42m/s;稳定性:在操作重型家用物品(比如锅和橱柜)时它能保持稳定;全身遥控操作:手臂和底盘可以同时运动;无线:具有机载电源和计算设备(数据收集和推断期间的所有计算都是在配备了Nvidia 3070 Ti GPU (8GB VRAM)和Intel i7-12800H的消费级笔记本电脑上进行)。

关于ALOHA的详细介绍可以参见大模型时代的具身智能系列专题(八)。

另外一种遥操作利用外骨骼辅助操作。

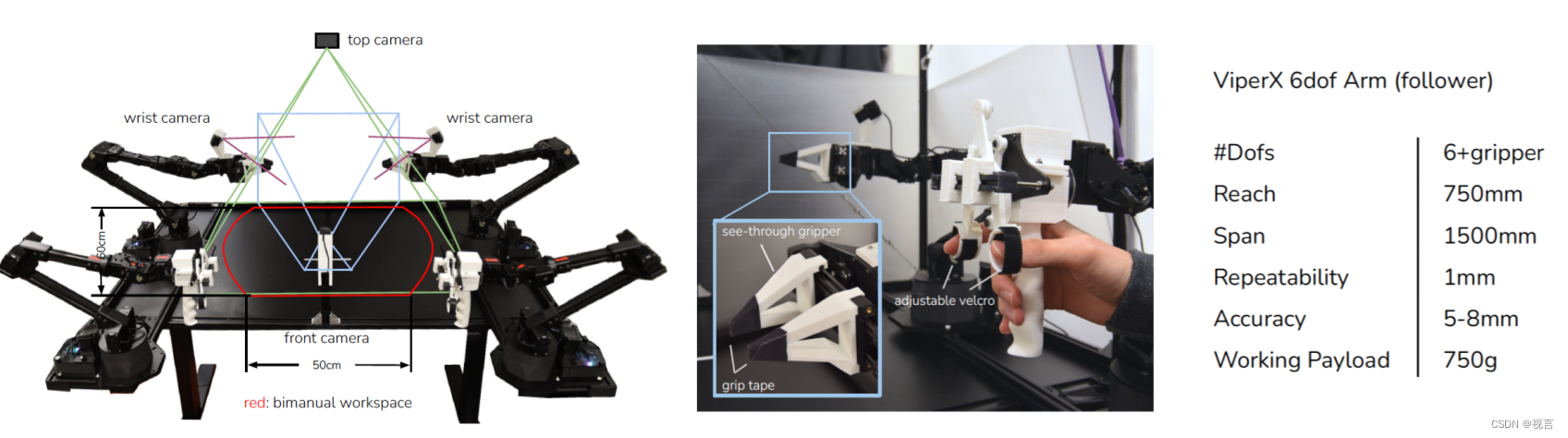

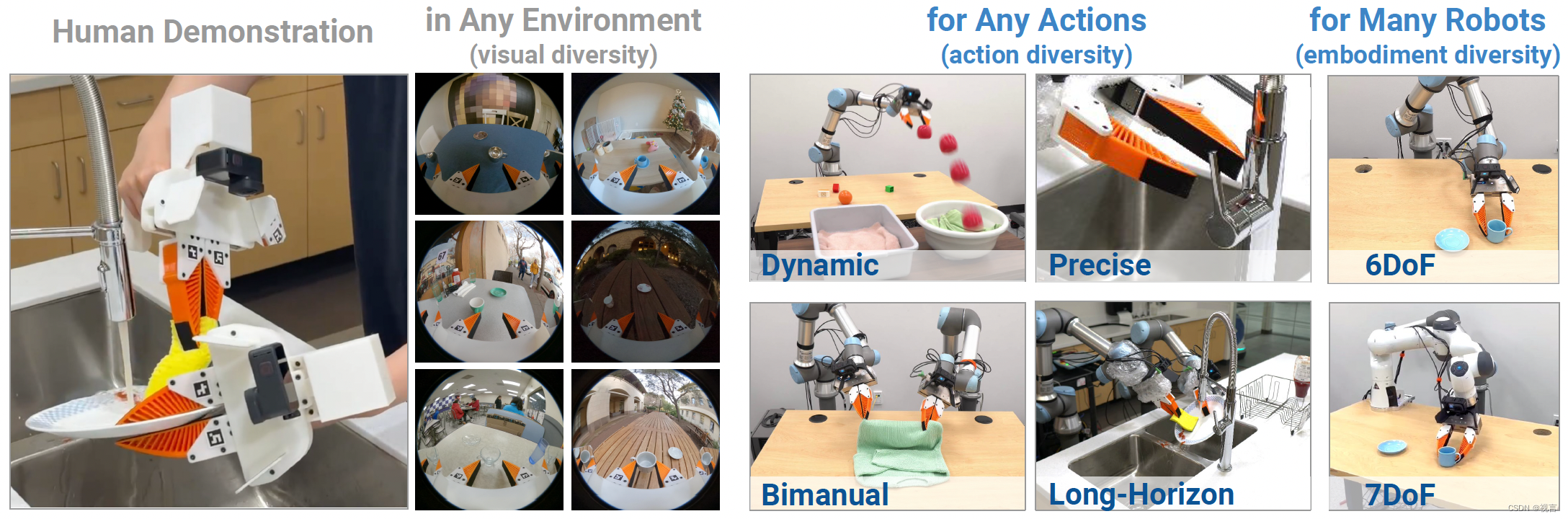

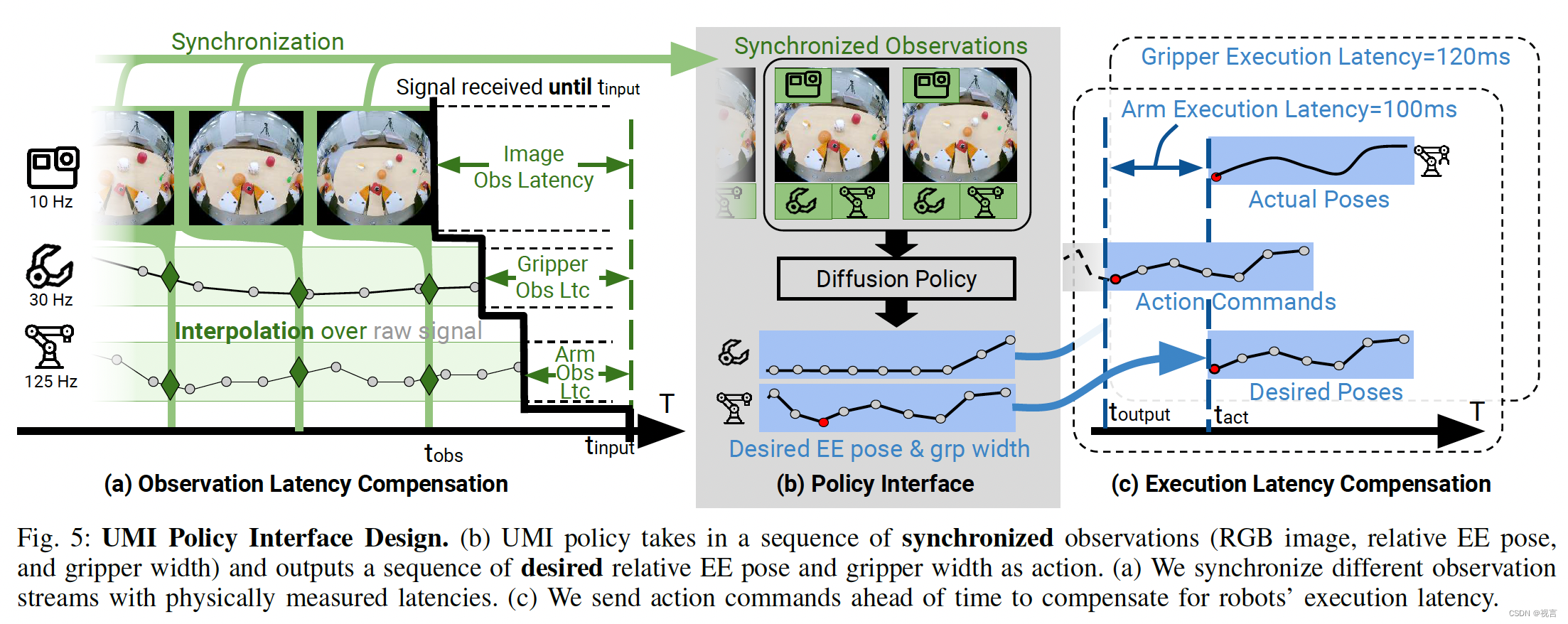

手持夹持器

紧接着在2024年2月19日,斯坦福和哥伦比亚大学、丰田研究所的研究者发布了一个通用操控界面UMI,其使用手持夹持器简单快速且低成本(比mobile ALOHA成本还低)的收集一系列机器人训练数据,借助这个UMI,可以自由的完成刷盘等各种任务。

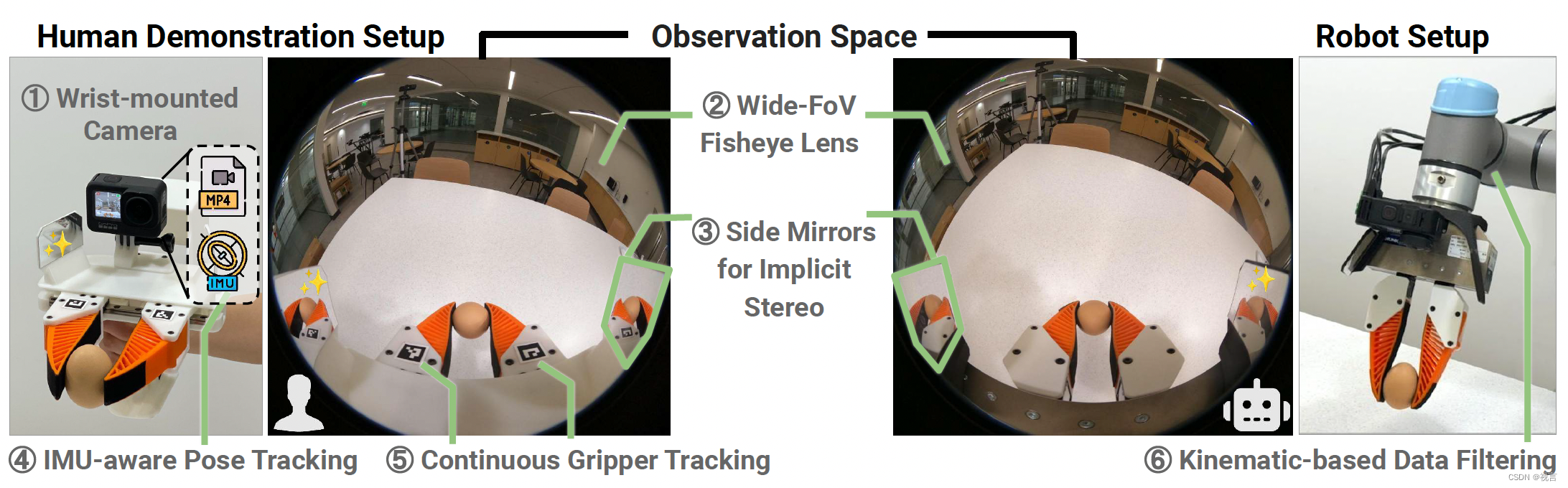

UMI使用鱼眼镜头感知环境,且通过改造SLAM与GoPro内置的IMU传感器结合使用,并在夹持器上的两端各自添加一面镜子,以提供立体观察。

①是一个相机,④是“相机① ”中自带的IMU感知姿态跟踪器

②是带有广角视野的鱼眼镜头,③是两个侧面镜用于提供立体视觉,⑤是对夹持器的跟踪

⑥是基于运动学的数据过滤

其他

脑机接口未来或许也是数据采集的方式,由人类大脑信号控制机器人操作。

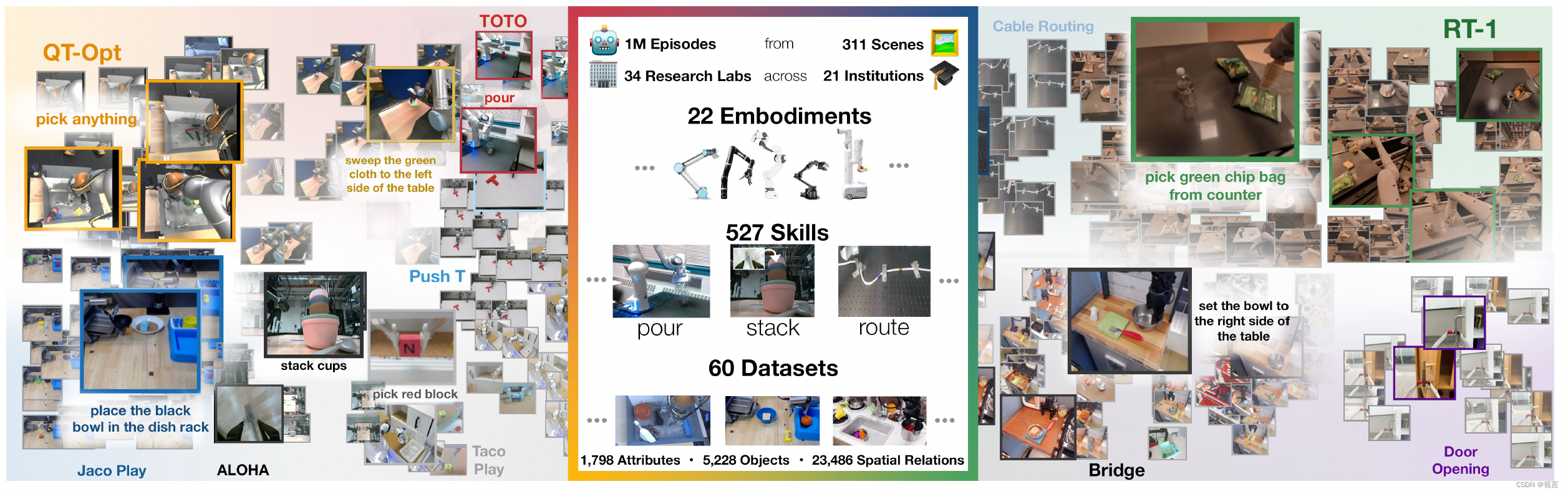

数据汇总

DeepMind汇集了来自 22 种不同机器人类型的数据,创建了 Open X-Embodiment 数据集并开源了出来。该数据集汇集了21个科研机构,22个机器人, 60个已有数据集的融合,包含 527个技能,160,266个任务,1,402,930条数据(共约3600G)。

仿真

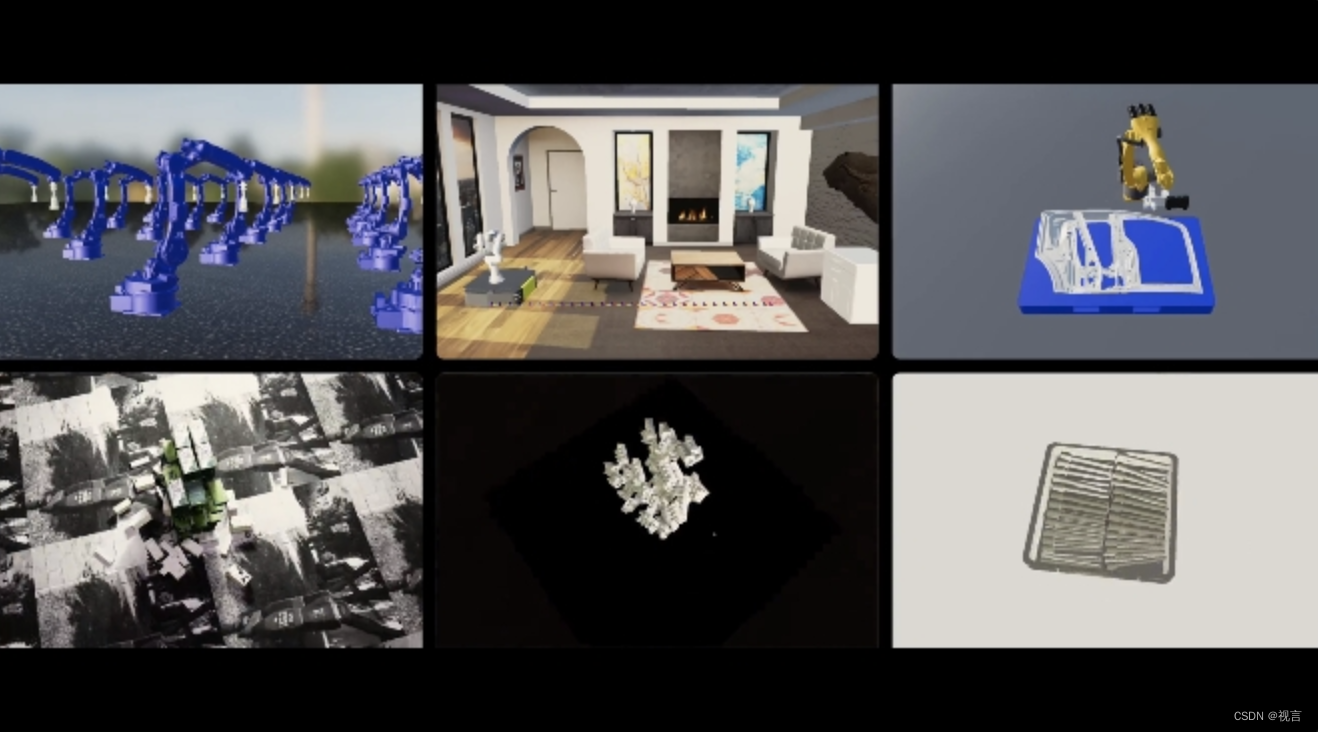

真实机器人数据的采集效率较低,且采用硬件不同,难以一起使用。而通过仿真也许是获取大规模不同分布数据的捷径。

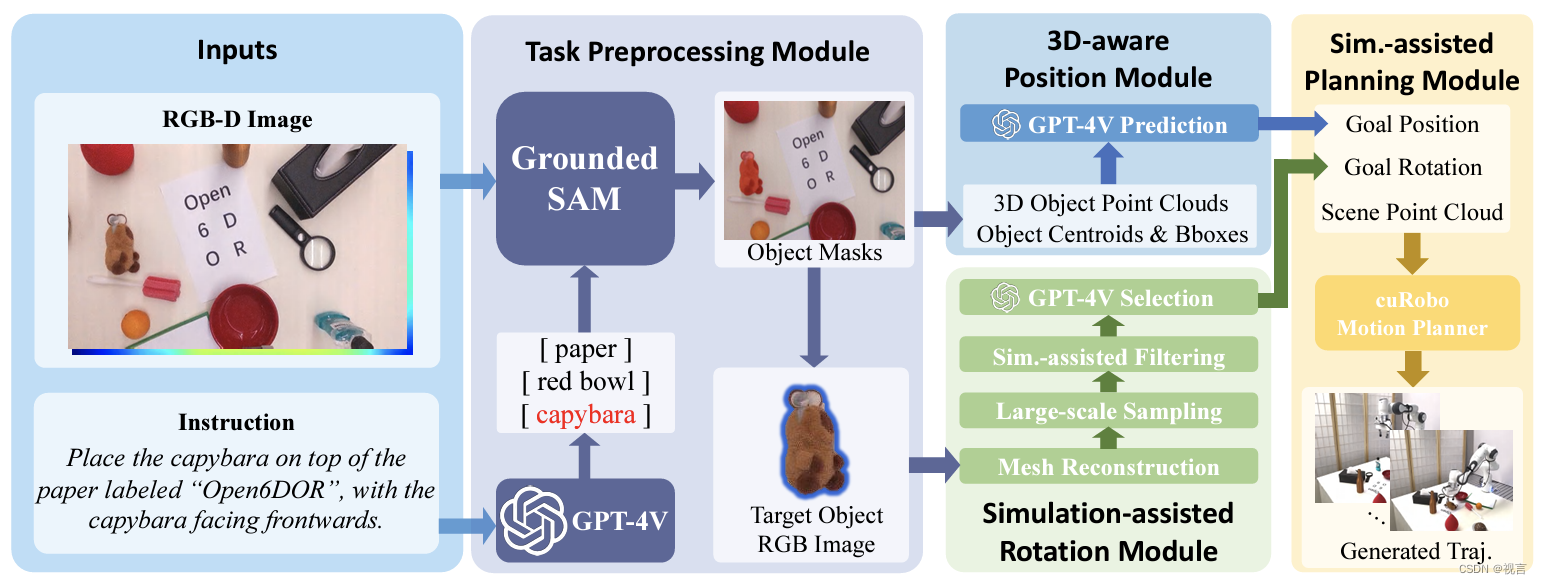

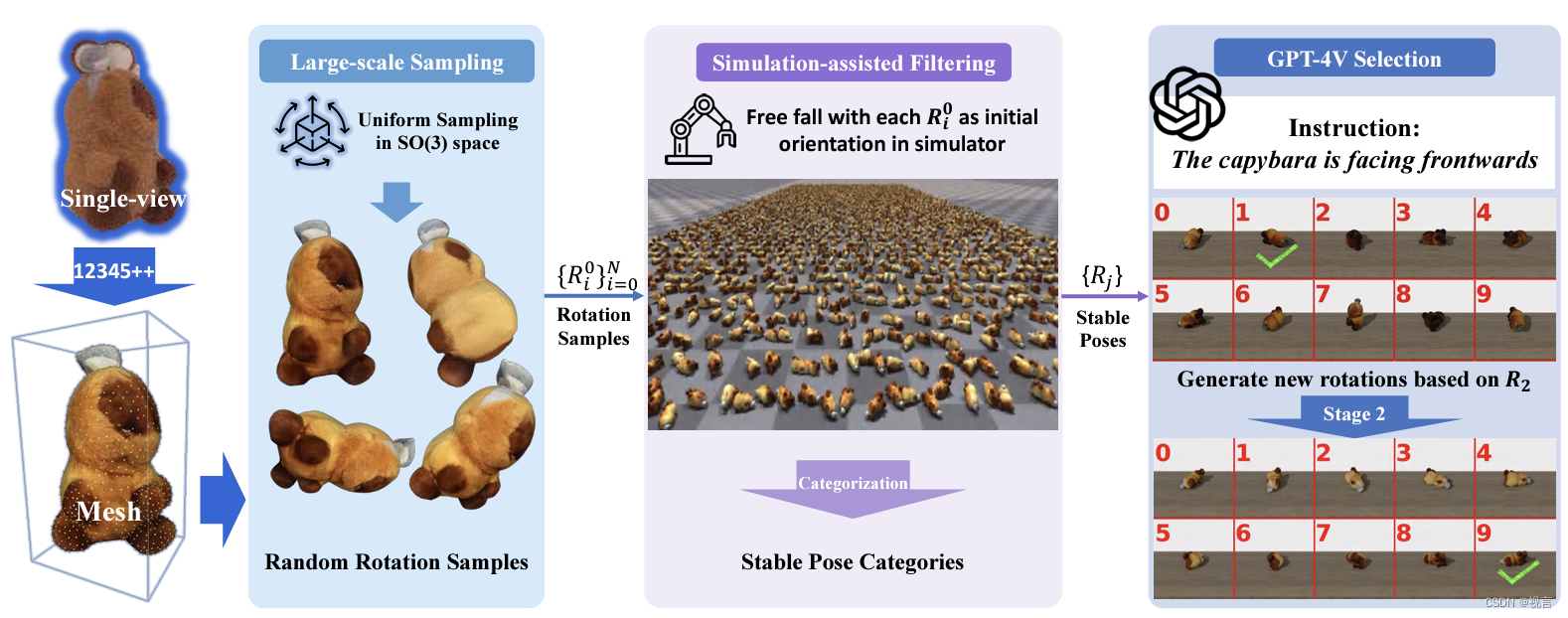

王鹤老师的大型仿真平台open6dor,包含2500个任务,它从世界上第一个零部件数据集中获取零部件并放到仿真环境中,并标注位姿、所有轴使用方法。

UCSD的王小龙老师提出了GENSIM,通过利用大型语言模型(LLM)的grounding和编码能力来自动生成丰富的仿真环境和专家演示。GENSIM有两种模式:目标导向生成,目标任务给到LLM, LLM提出一个任务课程来解决目标任务;探索性生成,在LLM中,从以前的任务中引导并迭代地提出有助于解决更复杂任务的新任务。

跨维智能以 Sim2Real AI为核心,研发了DexVerse具身智能引擎,基于3D VLA (3D Vision Language Action) 大模型的成像感知套件,通过自适应数据生成策略和可微渲染能力为大模型训练提供了在线仿真数据。

当前仿真技术在localmotion、pick和place可以做好,对于高动态、接触复杂的操作真实数据更好,比如UCSD王小龙老师就提到在尝试做转笔这个任务时,仿真一直失败,而真实数据直接follow 轨迹就可以work。

互联网人类数据

真实的机器人数据采集代价太高,仿真数据的保真性又存在问题,那能否利用大量的互联网人类日常动作视频作为预训练,真实机器人少量数据作为finetune以快速适配。比如大模型时代的具身智能系列专题(三)中的ATM算法。

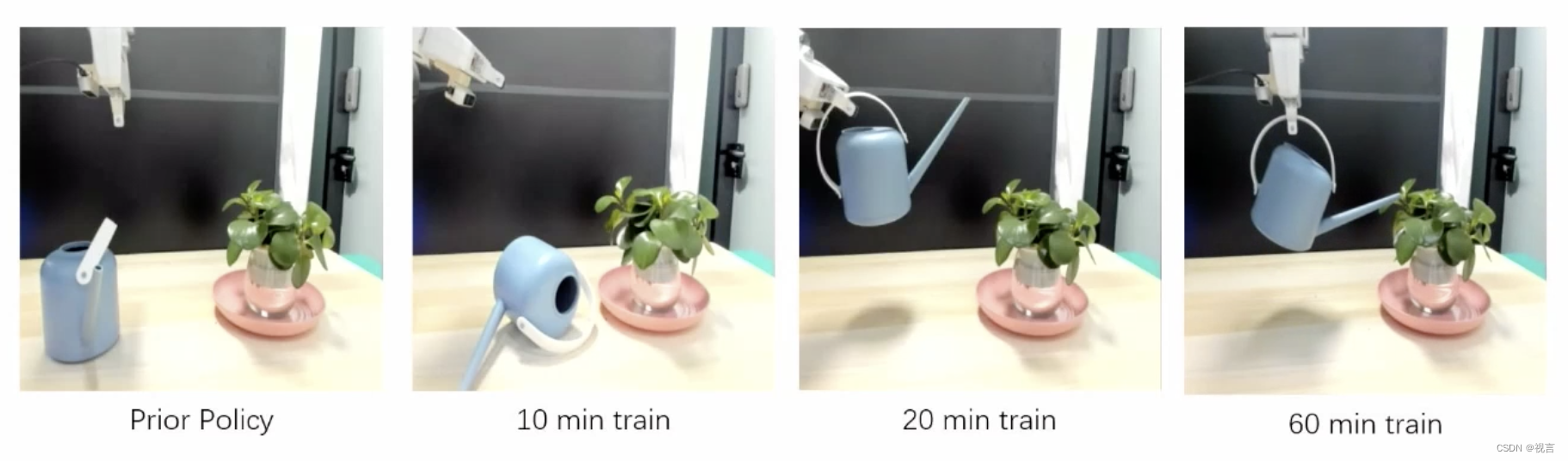

机器人在真实环境自我学习

这里展示了机械臂学习浇花的过程,从失败到能完成一部分,到可以缓慢完成,再到可以快速完成。

方法

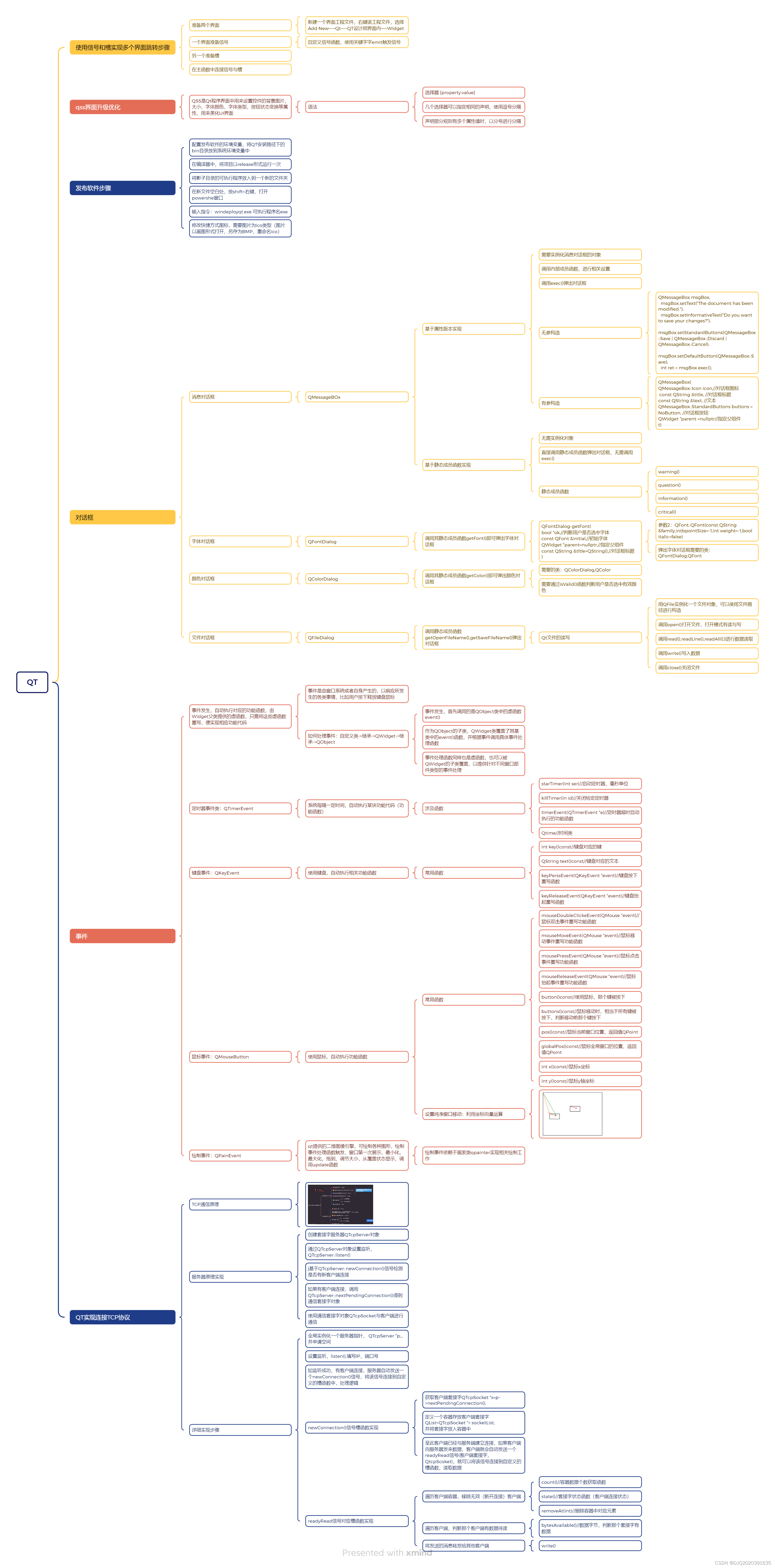

模仿学习

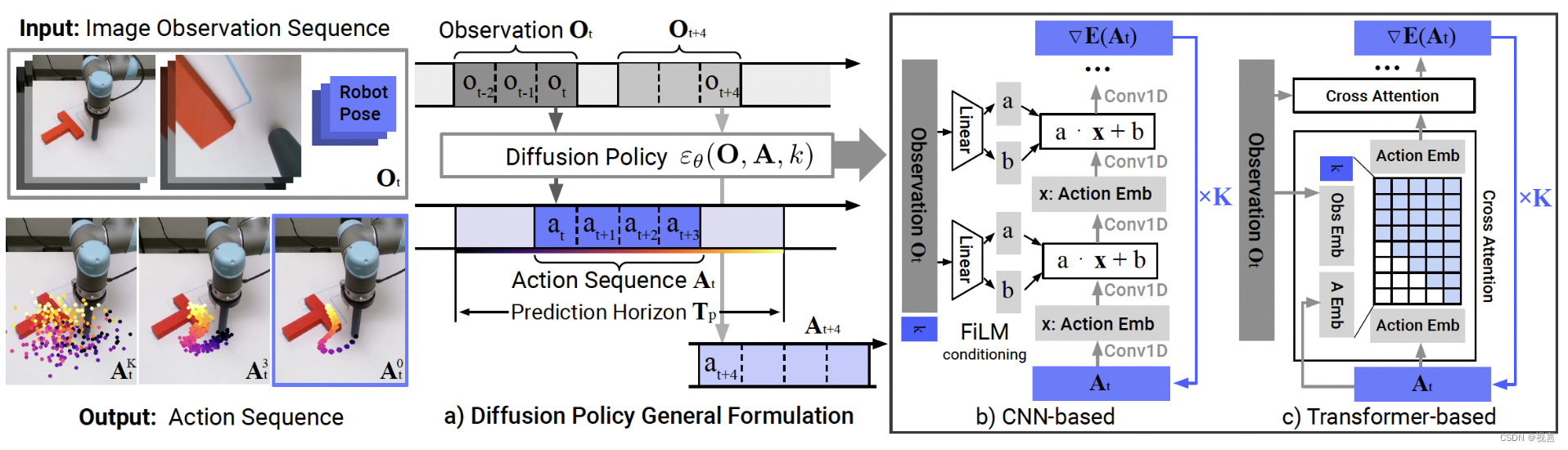

近期,模仿学习在机器人领域的应用迎来了大爆发,从Dobb·E、Gello到斯坦福Mobile ALOHA、UMI、DexCap、伯克利FMB。斯坦福大学宋舒然团队提出了diffusion policy,将机器人的视觉运动策略(visuomotor policy)表示为条件去噪扩散过程(conditional denoising diffusion process),UMI沿用diffusion policy方案。diffusion policy的具体方案见大模型时代的具身智能系列专题(五)。

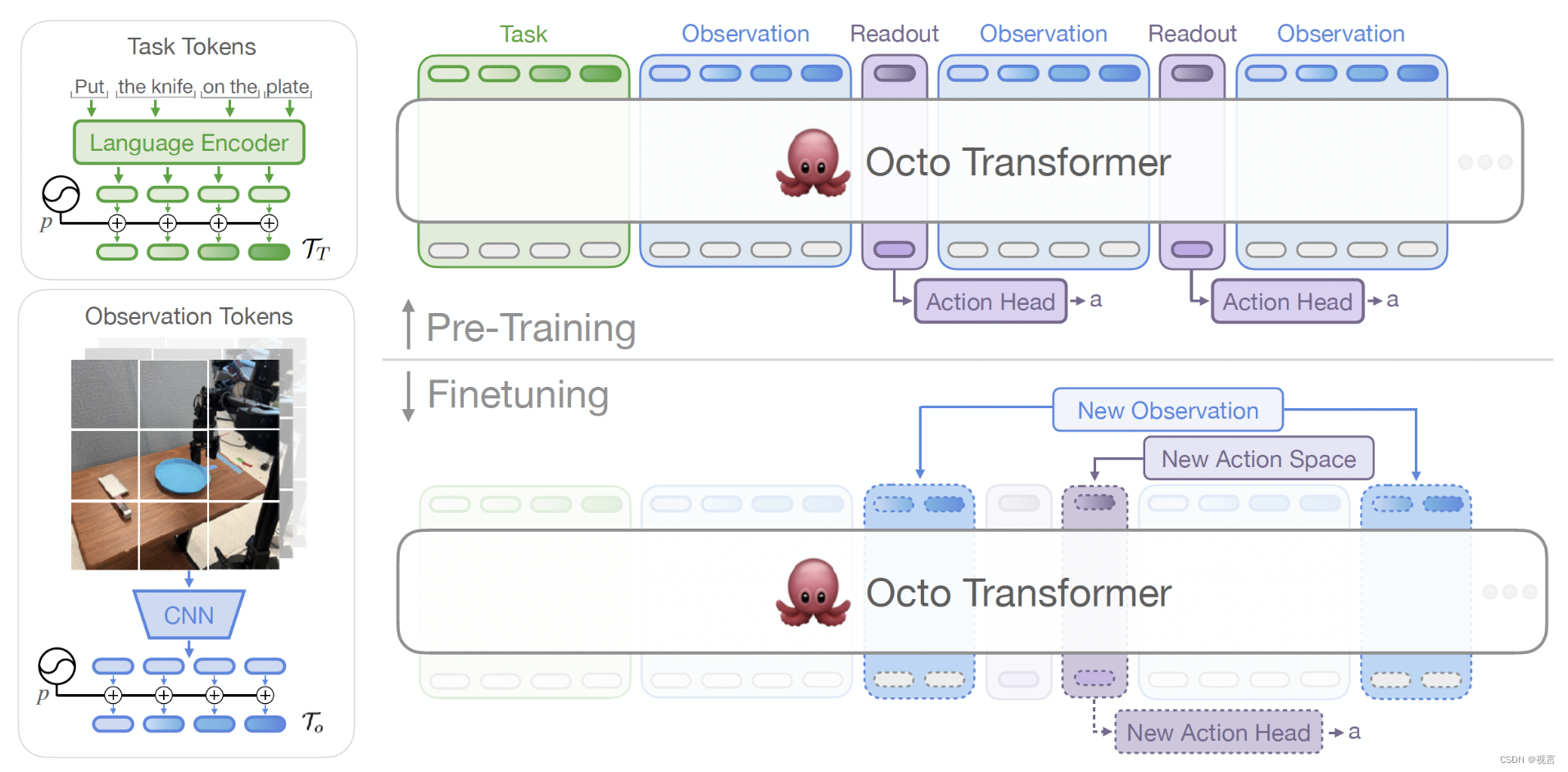

Sergey Levine团队提出了Octo,该方法设计了一种块状注意力和输出head的transformer结构,在迁移学习到新机器人或任务时,可以很方便地增删输入输出modalities,而无需重新初始化或训练模型的大部分参数,因此Octo具备通用的机器人控制策略。详细内容见 h大模型时代的具身智能系列专题(十)。

NYU的 Lerrel Pinto团队提出的Dobb-E是一个行为克隆框架,而行为克隆是模仿学习的一种形式,通过观察和模仿人类或其他专家代理的行为来学习执行任务。行为克隆涉及训练模型以模仿演示的动作或行为,并通常使用标记的训练数据将观察映射到期望的动作。详见 大模型时代的具身智能系列专题(九)。

standford Chelsea Finn团队提出的ALOHA和mobile ALOHA在2024年初风靡一时,其设计的ACT(Action Chunking with Transformers)算法减轻了随时间推移产生的复合错误,详见大模型时代的具身智能系列专题(八)。

预训练+强化学习

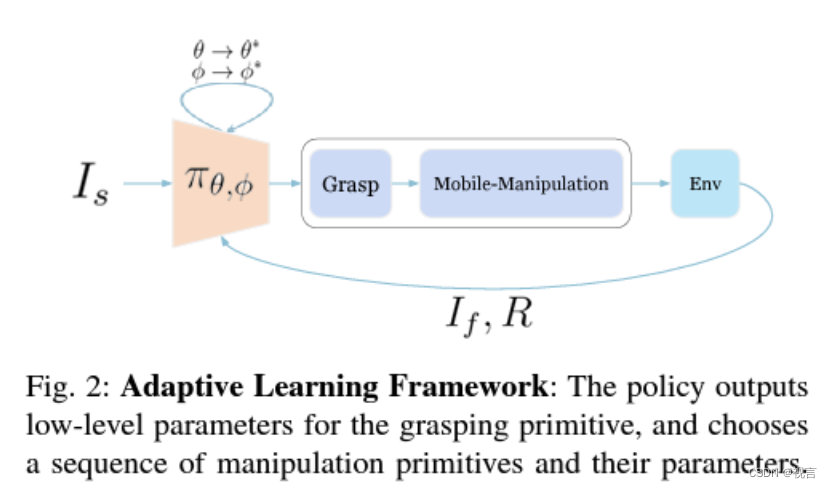

CMU一团队提出了开放世界移动操作系统(Open-World Mobile Manipu-lation System),用于解决开放世界中真实关节物体的移动操作问题,该方法首先通过收集到的演示数据进行行为克隆以完成策略的初始化,后进行在线RL训练(通过CLIP视觉语言模型给予环境反馈)。

NUS邵林老师研发了一个任意机器人对任意物体进行任意操作任务的foundation models,是一个典型的预训练模型。

视觉语言模型

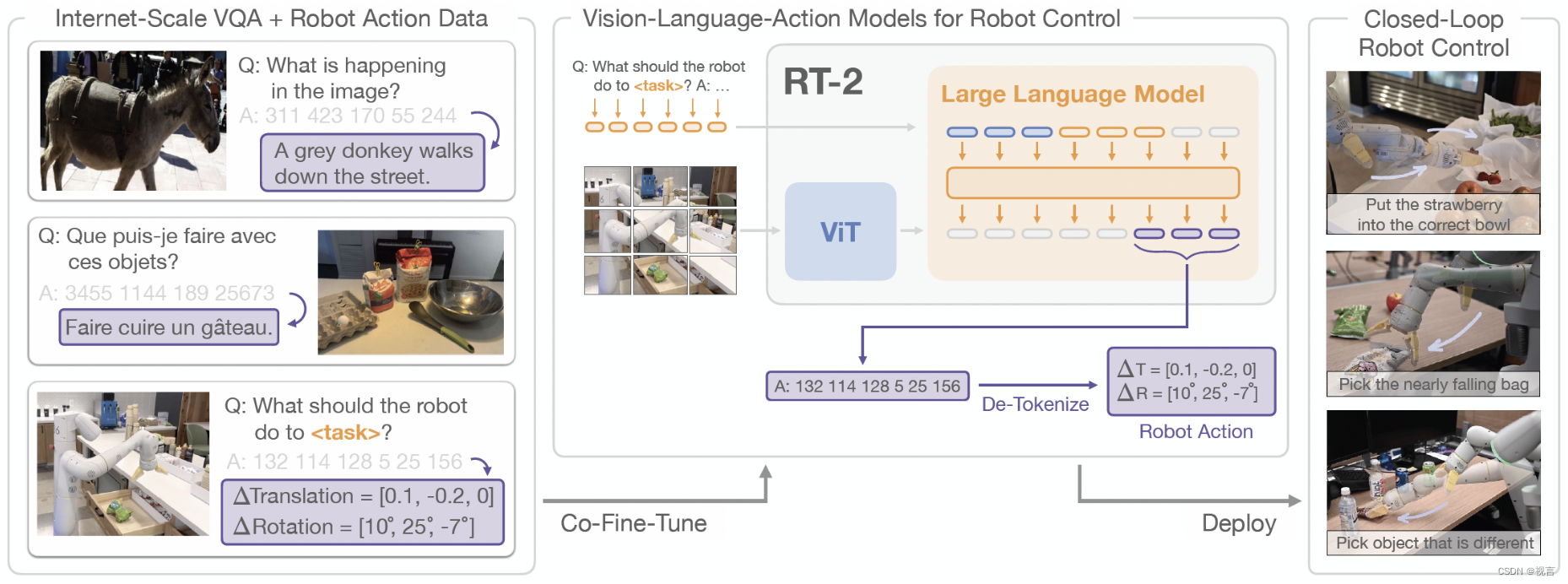

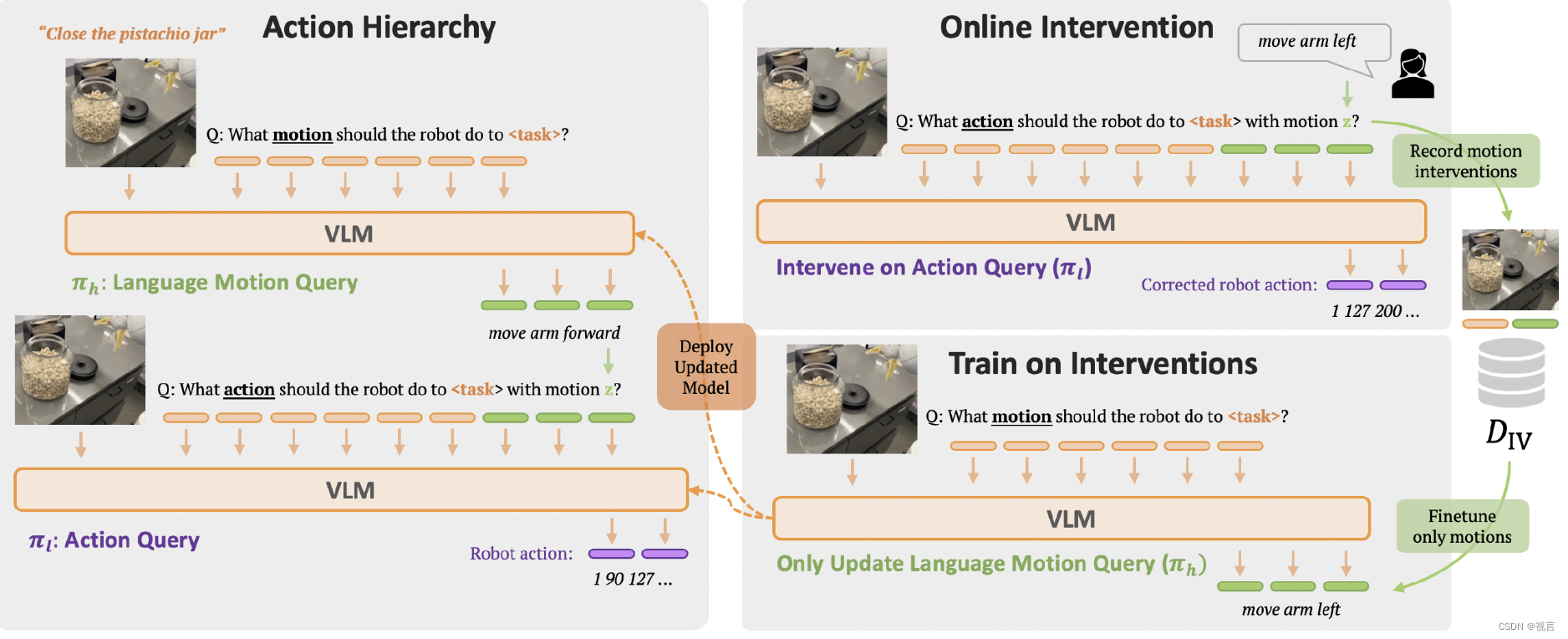

近期使用大模型帮助机器人任务泛化的工作如deepmid的RT-2、RT-H,具体方法见大模型时代的具身智能系列专题(四)。

斯坦福大学李飞飞组的工作voxposer采用了大语言模型+视觉语言模型,详见大模型时代的具身智能系列专题(二)。

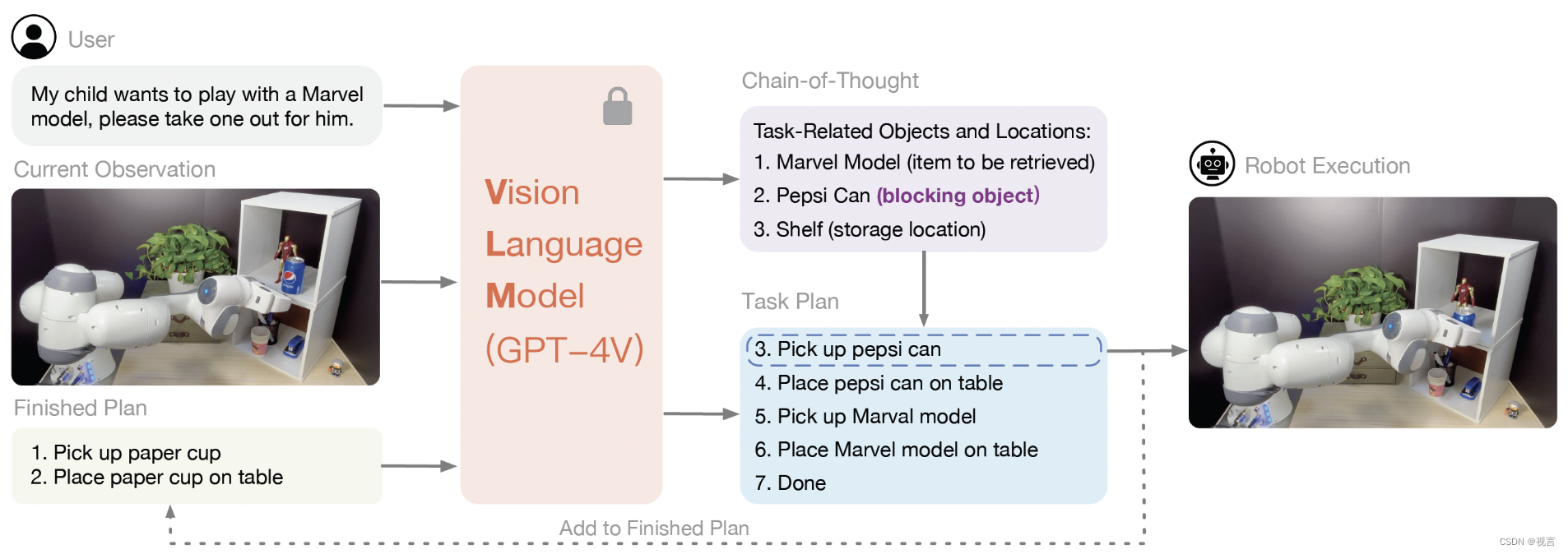

清华高阳组的两个工作ViLA+CoPA都基于视觉语言大模型GPT-4V,ViLA侧重于高层任务规划,CoPA侧重低层具体任务执行,详见大模型时代的具身智能系列专题(三)。

UCSD 王小龙组的GENSIM利用大型语言模型(LLM)的grounding和编码能力来自动生成丰富的仿真环境和专家演示。该方法有两种模式:目标导向生成,目标任务给到LLM, LLM提出一个任务课程来解决目标任务;探索性生成,在LLM中,从以前的任务中引导并迭代地提出有助于解决更复杂任务的新任务。详见大模型时代的具身智能系列专题(六)。

UMass Amherst 淦创团队提出了一个多感官具身大语言模型MultiPLY,该模型可以将视觉、听觉、触觉和热信息等多感官交互数据整合到大语言模型中,从而建立单词、动作和感知之间的相关性。详见大模型时代的具身智能系列专题(十一)。

其他方案

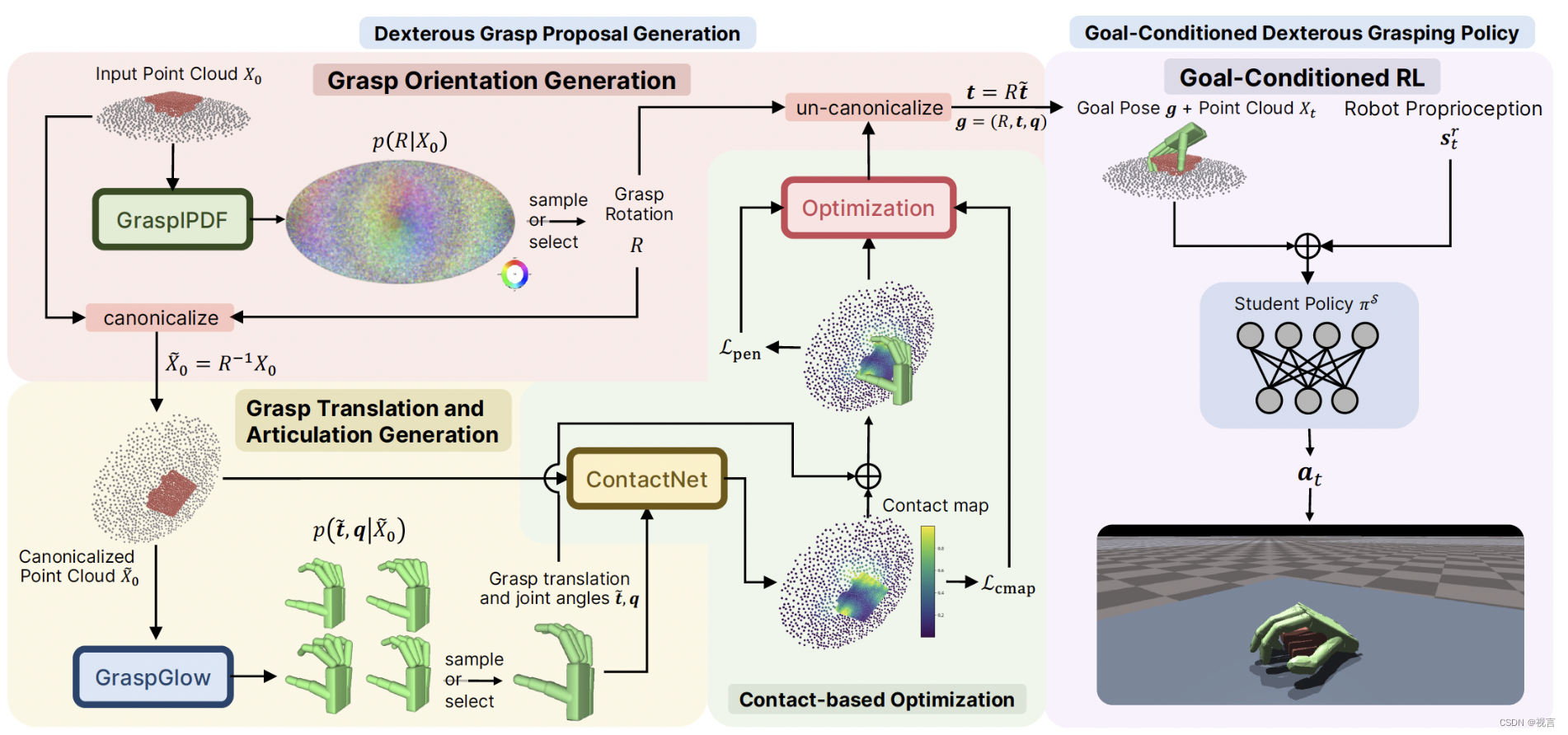

北大王鹤团队提出了UniDexGrasp将灵巧手抓取分成两个阶段:第一阶段针对物体点云输入生成若干抓取手势,从中挑选一个作为目标手势之后,第二阶段使用基于目标手势的强化学习策略来执行抓取。详见大模型时代的具身智能系列专题(七)。

落地与商业化

工业机器人已经比较成熟,人形机器人能否在工业赛道获得优势还是充满了未知数,当然我们也看到优选人形机器人已经入驻蔚来造车工厂,特斯拉在工厂分拣插电池等尝试;而这波具身智能大多在服务行业的简单落地场景展开探索,服务行业的细分赛道包括家庭护理、餐饮、按摩、医美等。对于困难场景,如果能用来干人类不愿意干的事或者很危险的事情,长期深耕是很有意义的事。

国内近期诞生了许多具身智能加持的机器人初创企业,以高校和企业合作为主,比如千寻智能、银河通用、逐际动力、星海图、穹彻智能、星动纪元、南栖仙策等,这样的合作模式能否成功值得拭目以待。

相比于AI,机器人的硬件十年来未有大的变化,本体的同质化竞争尚无必要,短期其销售主体是高校和科研机构,然后在一些固定场景或有泛化需求的工厂小规模尝试落地。总体来看,机器人市场尚未成熟,不得不面对供应链挑战,中国制造业的优势在于规模生产降低成本,而需求量不足以支撑大规模生产。

时间线预测

Rodney Brooks 2024年更新的他对于未来科技的预测,列举几个。一个可以在任何美国人家里走动的机器人(应对杂乱的东西,梯子,狭窄的家具等):实验室版2026以后,昂贵的版本2030以后,便宜的版本2035以后。灵巧的机械手变的普遍,2030年以后,希望2040年以前可以。自动驾驶能在一个主要的美国城市任何地点接送人:2032年以后。尽管我们希望科技树被快点点亮,但是MIT教授和iRobot创始人CTO,同时也是硅谷VC的判断应该多少有一些参考价值。

综合从业者的规划、数据和方法演进的速度,个人对具身机器人的落地速度相对乐观,1-2年硬件设备及其数据采集方案的收敛,再经过2-3年垂类场景的数据积累和问题发现,然后再经过2-3年在垂类场景的打磨实现第一代方案的成熟,完成第一次螺旋上升。

参考文献

- https://rodneybrooks.com/predictions-scorecard-2024-january-01/

- https://mp.weixin.qq.com/s/yVlSOIrPRLiRW4GlqZ5Ixw

- https://mp.weixin.qq.com/s/ZW25sAvAOUnzJz9EYWRgTw

- https://www.leaderobot.com/news/4295

- https://blog.csdn.net/v_JULY_v/article/details/136773017

- https://mp.weixin.qq.com/s/VSDXkTtiJvaHfOdp0O3bVw

- https://2024.baai.ac.cn/schedule

- https://wx.vzan.com/live/channelpage-275544?ver=638535487705515635&vprid=0&shareuid=443416292&shauid=tVQ6C7v4JrUKj2qJAUOpQA**

- https://blog.csdn.net/v_july_v/category_12547596.html

- https://mp.weixin.qq.com/s/AnQlpf6N6iMO1xGbL-vOWA

- https://mp.weixin.qq.com/s/KZmhIsvm6QvZnwSL8bEyMA