DSNet: A Novel Way to Use Atrous Convolutions in Semantic Segmentation

论文链接:http://arxiv.org/abs/2406.03702

代码链接:https://github.com/takaniwa/DSNet

一、摘要

重新审视了现代卷积神经网络(CNNs)中的atrous卷积的设计,并证明了使用大内核应用atrous卷积的概念可能是一种更强大的范例。作者提出了三个指导原则来更有效地应用atrous卷积。根据这些指导原则,提出了DSNet,一种双分支CNN架构,它将atrous卷积结合到模型架构的浅层,并在ImageNet上对几乎整个编码器进行预训练以实现更好的性能。为了证明所提方法的有效性,DSNet模型在ADE20K、Cityscapes和BDD数据集上实现了准确性和速度之间的新的最佳平衡。具体而言,DSNet在ADE20K上以179.2 FPS的推理速度实现了40.0%的mIOU,在Cityscapes上以81.9 FPS的速度实现了80.4%的mIOU。

目录

- DSNet: A Novel Way to Use Atrous Convolutions in Semantic Segmentation

- 一、摘要

- 二、创新点

- 三、原理

- Network design

- DSNet: A novel Dual-Branch Network

- MFACB: Learning of different scales

- MSAF: Balancing the Details and Contexts

- SPASPP: Further extracting context information

- 四、实验

- Dataset

- Implementation Detail

- Ablation Study

- Comparison

- 五、总结

二、创新点

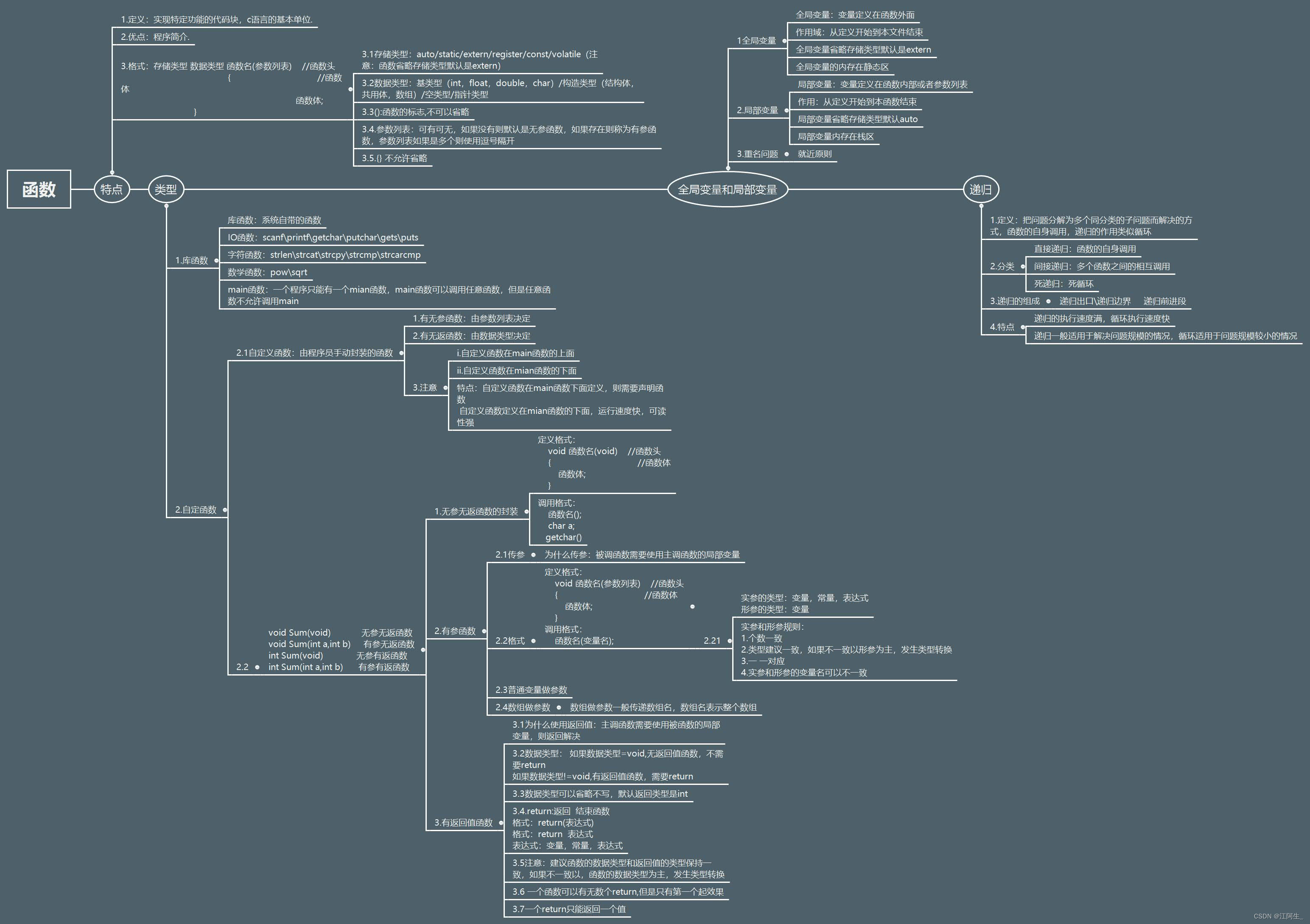

从网络的浅层开始堆叠空洞卷积会产生什么效果?

三个空洞卷积的经验指导原则:

- 不仅仅使用空洞卷积。将空洞卷积与稠密卷积结合使用可能是更好的选择。

- 避免“Atrous灾难”。为了达到更高的准确性,选择合适的空洞率至关重要。

- 适当的融合机制。使用适当的融合机制将不同层次的信息整合起来,可以提高模型的性能。

创新点:

1、重新审视了在CNNs中使用空洞卷积的设计,并探索了三个经验指导原则。基于上述指导原则,提出了一种新颖的双分支网络。

2、DSNet 在 ADE20K、Cityscapes 和 BDD 数据集上实现了准确性和速度之间的新最佳平衡。DSNet 同时在不同数据集上优于实时 Transformer-based 和卷积神经网络-based 模型。

三、原理

Network design

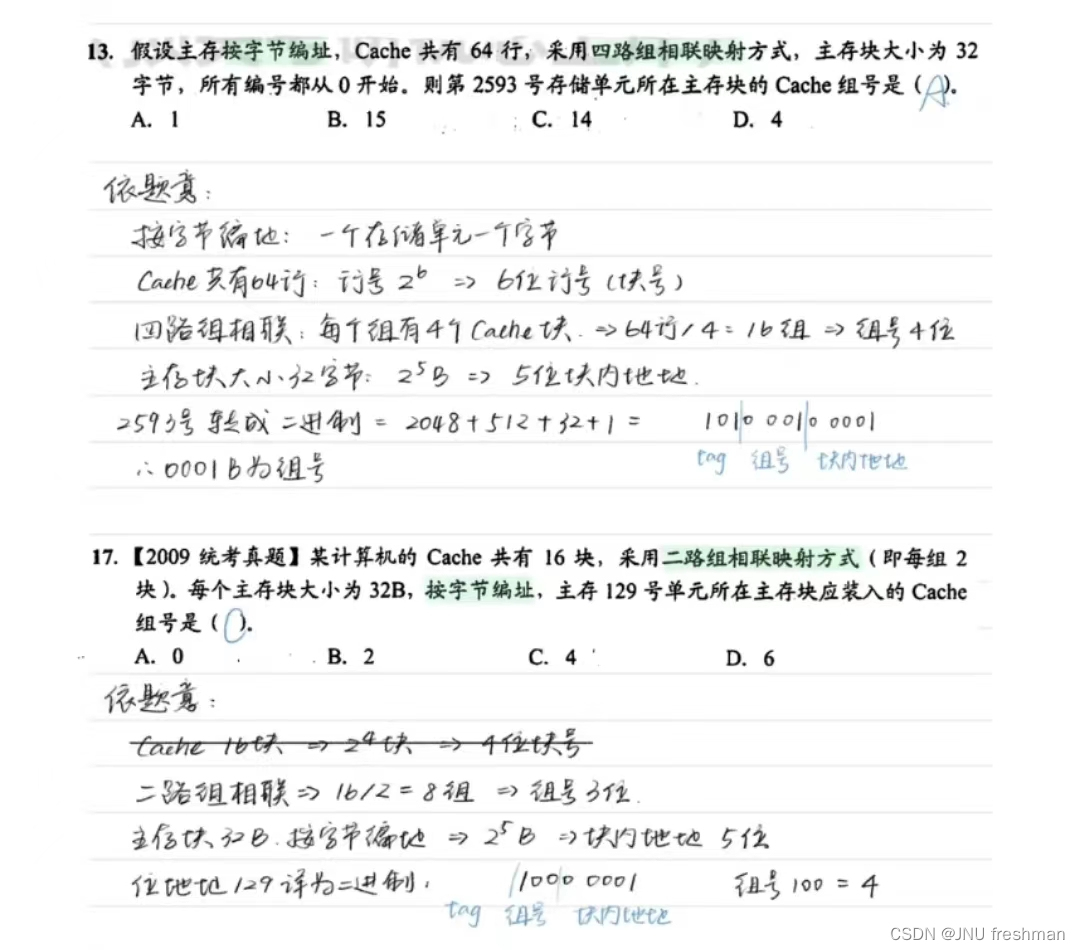

CNNs中空洞卷积设计的三个经验指南:

-

不仅使用空洞卷积,提出使用空洞卷积和稠密卷积结合,以保持细节信息,消除“网格效应”和难以在上下文和细节信息之间保持平衡的缺点。从表1可以看出,仅使用空洞卷积时,网络在分类和分割任务上的准确性相对较低。然而,一旦采用这种方法,网络的准确性显著提高。

-

避免“空洞灾难”。

-

适当的融合机制。适当的融合机制可以有效地引导两个分支的融合,增强不同层级特征之间的信息传递,并提高模型的表征能力。

对于具有较大空洞率(例如d = 15)的空洞卷积,尽管它们在没有在ImageNet上进行预训练的分割任务中略有优势,但它们的分割性能在在ImageNet上进行预训练后明显落后于使用较小空洞率的模型。将这种现象称为“空洞灾难”。

如果希望通过在ImageNet上进行预训练来实现语义分割的更高准确性,则选择适当的空洞率至关重要。为了进一步扩大语义分割中的感受野,考虑将一个上下文模块集成到主干网络之外,这样可以在利用上提供更大的灵活性。

DSNet: A novel Dual-Branch Network

-

将网络分为两个分支,空间分支和上下文分支。上下文分支主要由空洞卷积组成,实现为MFACB,而空间分支由 3 × 3 3 \times 3 3×3的稠密卷积组成。

-

为了充分整合空间分支和上下文分支的信息,使用MSAF在两个分支之间建立了三个水平连接。

-

网络主干主要使用小的空洞卷积率(如2、3和5)的空洞卷积来减轻“空洞灾难”。此外,主干网络在ImageNet上进行预训练,以增强特征表征能力。

-

提出了一个名为SPASPP的上下文模块,用于在分割任务中插入主干网络以快速增加感受野。

由于两个分支具有相同的分辨率,将其称为具有相同分辨率的的双分支网络(DSNet)。设计了两个版本:DSNet是轻量级版本,具有快速推理能力,而DSNet-Base具有更高的准确性。与DSNet相比,DSNet-Base是一个更深的版本,具有更多的通道。

MFACB: Learning of different scales

引入了一种新的编码器模块用于语义分割,称为多尺度融合空洞卷积块(MFACB)。如图3所示,MFACB由三个空洞卷积层组成,每个层使用不同的空洞率来扩展感受野。经过三次卷积操作后,中间特征图被连接并使用 1 × 1 1 \times 1 1×1卷积进行通道压缩。最后,压缩后的特征图与输入特征图进行残差连接。

可以通过观察表2来深入了解该模块的作用。在具有[2, 2, 2]空洞率的第一个MFACB模块之后,三个中间特征图的感受野分别为

5

×

5

5 \times 5

5×5,

9

×

9

9 \times 9

9×9和

13

×

13

13 \times 13

13×13。随后,通过串联和

1

×

1

1 \times 1

1×1卷积,输出特征图同时聚合了这三个不同尺度的感受野。在第二个MFACB模块中的串联和融合操作之后,由于同样的原因,当前层的感受野尺度开始增加。在主干网络中使用MFACB使得模型能够有效地学习不同尺度的语义信息。

MSAF: Balancing the Details and Contexts

跳跃连接增强了不同层次或尺度上特征图之间的信息传输,从而提高了模型的表示能力。遵循第三个原则适当的融合机制,引入了一种新颖的多尺度注意力融合模块(MSAF),旨在实现两个不同层次分支之间的选择性学习。其主要思想是让网络根据损失学习特征权重,使模型能够有选择地融合不同尺度的信息。该模块主要分为两部分:多尺度注意力(MSA)和多尺度注意力融合模块(MSAF)。

多尺度注意力(MSA) 如图4所示,MSA的主要目的是

学习权重

α

\alpha

α,作为不同层级分支融合的基础。MSA模块主要分为两个部分:区域注意力和像素注意力。为了更详细地解释MSA,将通道数、特征图宽度和高度分别表示为

C

C

C、

W

W

W和

H

H

H。

-

(1): 区域注意力: 区域注意力衡量了特征图中不同

区域的重要性。在使用注意力时考虑感受野是必要的。为了方便起见,将特征图分成相同大小的块,例如通道为 1 × 1 1 \times 1 1×1,4块 2 × 2 2 ×2 2×2,16块 4 × 4 4 \times 4 4×4。在DSNet中,将特征图分成大小相等的区域,分别为 1 × 1 1 \times 1 1×1, 4 × 4 4 \times 4 4×4, 8 × 8 8 \times 8 8×8和 16 × 16 16 \times 16 16×16。以 4 × 4 4 \times 4 4×4为例,首先对特征图 F F u s e ∈ R C × H × W F_{Fuse} \in R^{C \times H \times W} FFuse∈RC×H×W进行平均池化,得到 f c 4 ∈ R C × 4 × 4 f_{c4} \in R^{C \times 4 \times 4} fc4∈RC×4×4,然后进行通道压缩和扩展,得到 f c 4 ˉ ∈ R C × 4 × 4 \bar{f_{c4}} \in R^{C \times 4 \times 4} fc4ˉ∈RC×4×4。为了与像素注意力兼容,将其重新调整为 f c 4 ˉ ∈ R C × H × W \bar{f_{c4}} \in R^{C \times H \times W} fc4ˉ∈RC×H×W。区域注意力的数学公式可以表示为方程2。与SE注意力[20]类似,通道压缩和扩展的目的是减少计算复杂度并增强非线性。 G O N V GONV GONV表示通道扩展和压缩的操作。

F F u s e = F C o n t e x t + F S p a t i a l ( 1 ) F_{Fuse} = F_{Context} + F_{Spatial} \ (1) FFuse=FContext+FSpatial (1)

f r e g ˉ = ∑ i = 1 , 4 , 8 , 16 U n i P o o l ( G o n v ( A v g P o o l [ i ] ( F F u s e ) ) ) ( 2 ) \bar{f_{reg}} = \sum_{i=1,4,8,16}UniPool(Gonv(AvgPool[i](F_{Fuse}))) \ (2) fregˉ=i=1,4,8,16∑UniPool(Gonv(AvgPool[i](FFuse))) (2) -

(2)像素注意力: 像素注意力模块用于衡量每个像素的重要性。该模块不需要池化和重塑操作。如公式3所示,直接对 F F u s e ∈ R C × H × W F_{Fuse} \in R^{C \times H \times W} FFuse∈RC×H×W进行通道压缩和扩展,得到 → f S ∈ R C × H × W 。出于同样的原因, \rightarrow{f_{S}} \in R^{C \times H \times W}。出于同样的原因, →fS∈RC×H×W。出于同样的原因,\rightarrow{f_{S}}$ 可以衡量每个像素的重要性。

→ f S = G o n v ( F F u s e ) ( 3 ) \rightarrow{f_{S}} = Gonv(F_{Fuse}) \ (3) →fS=Gonv(FFuse) (3)

多尺度注意力融合模块。通过叠加像素注意力和区域注意力来获得特征图中不同位置的权重,并且权重的计算公式可以用公式4表示。如图4所示,最终通过逐元素相乘来融合这两个分支。区域注意力的数学公式可以描述为公式5。

α

=

S

i

g

m

o

i

d

(

A

d

d

(

f

s

ˉ

,

f

r

e

g

ˉ

)

)

(

4

)

\alpha = Sigmoid(Add(\bar{f_{s}}, \bar{f_{reg}})) \ (4)

α=Sigmoid(Add(fsˉ,fregˉ)) (4)

F o u t = F C o n t e x t × α + F S p a t i a l × ( 1 − a l p h a ) ( 5 ) F_{out} = F_{Context} \times \alpha + F_{Spatial} \times (1 - alpha) \ (5) Fout=FContext×α+FSpatial×(1−alpha) (5)

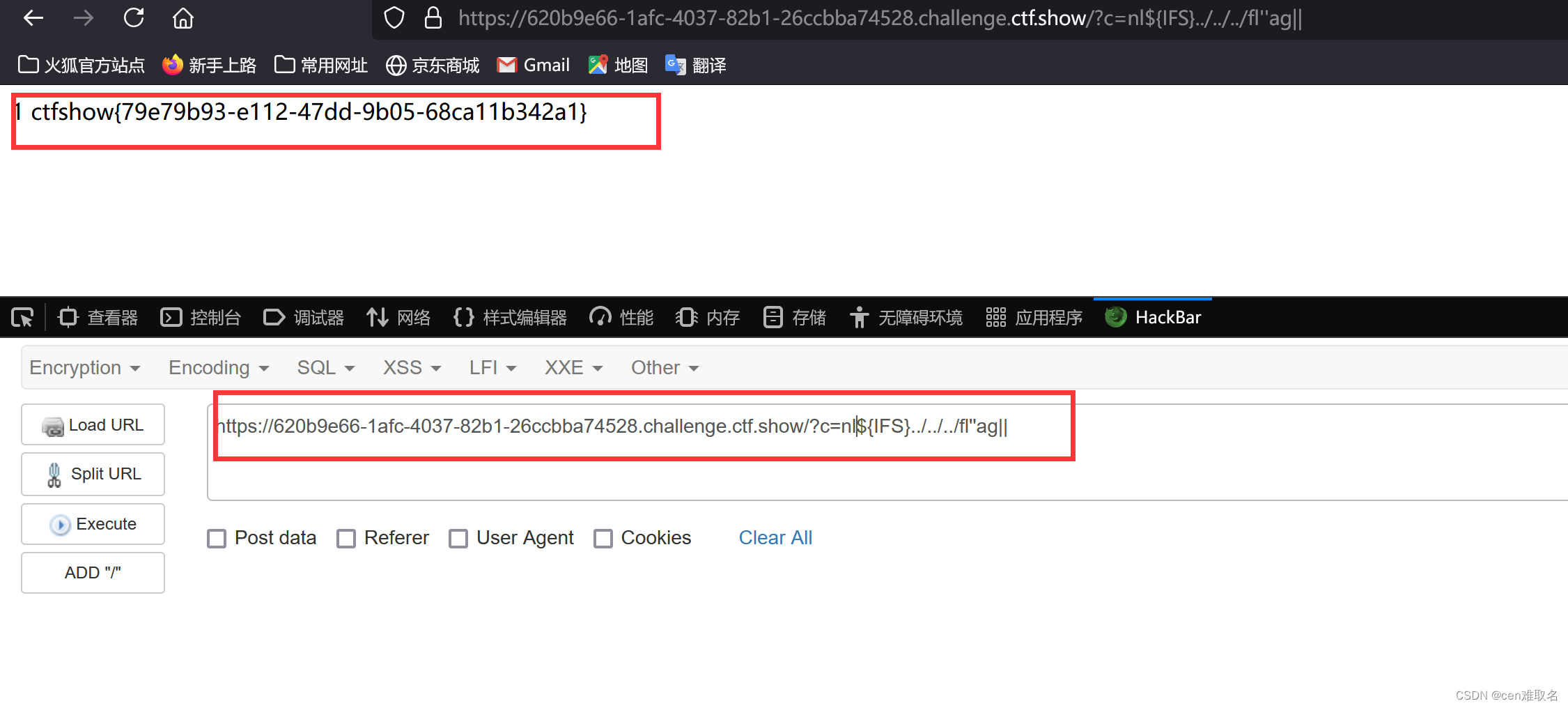

SPASPP: Further extracting context information

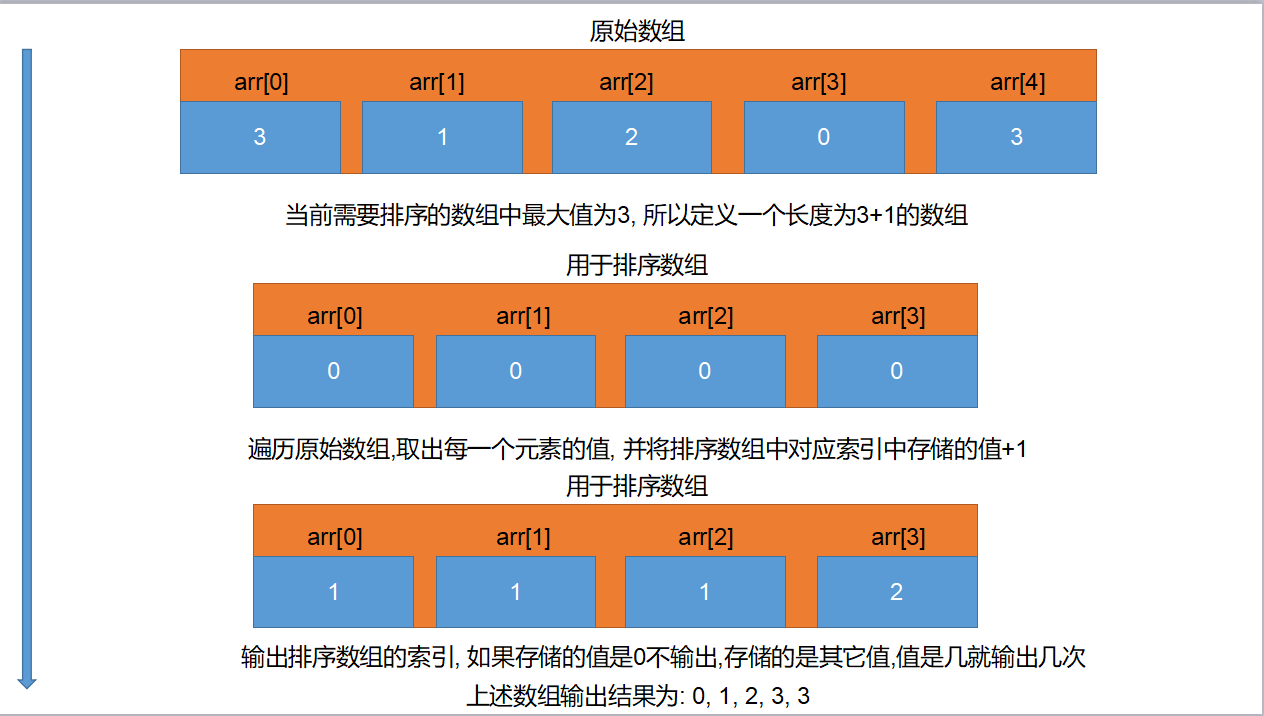

提出了一种新模块,用于从特征图中进一步提取上下文信息。图5展示了**串行-并行空洞空间金字塔池化(SPASPP)**的内部结构。与ASPP[6]的完全并行结构不同,堆叠了几个

3

×

3

3 \times 3

3×3的空洞卷积。随后,从堆叠的空洞卷积得到的中间特征图与全局池化后的上采样特征图进行拼接。堆叠空洞卷积和拼接的目的是在预训练的ImageNet骨干网络之外,通过这个上下文模块快速增加感受野,同时获取不同尺度的上下文信息。然后,使用

1

×

1

1 \times 1

1×1卷积对通道进行压缩,并与输入进行残差连接。图5不同空洞率的卷积核的融合形成了多尺度特性。使用加法模式而不是完全并行模式的目的是使模型获得更丰富的上下文信息并进一步扩大感受野,从而在需要较大感受野的任务中表现更好。表3表明,相比于没有额外卷积层的ASPP,SPASPP可以提供更丰富的上下文信息,同时保持与ASPP基本相当的速度。

四、实验

Dataset

在ADE20K、Cityscapes和BDD上进行了分割实验。ADE20K[50]数据集涵盖了150个类别,包含25,000张图像,其中20,000张用于训练,2,000张用于验证,3,000张用于测试。在测试过程中,所有图像都被调整为 512 × 512 512 \times 512 512×512的大小。Cityscapes[9]是一个公开可用的资源,专为语义分割任务设计。它包含了2975张精细注释的训练图像,500张验证图像和1525张测试图像。图像分辨率为 2048 × 1024 2048 \times 1024 2048×1024,对于实时模型来说是具有挑战性的。这里只使用了精细注释的数据集。BDD[46]数据集是一个专为自动驾驶应用而定制的综合性资源,包含19个不同的类别。它包括一个由7,000张图像组成的训练集和一个由1,000张图像组成的验证集,每张图像的尺寸为 1280 × 720 1280 \times 720 1280×720像素。

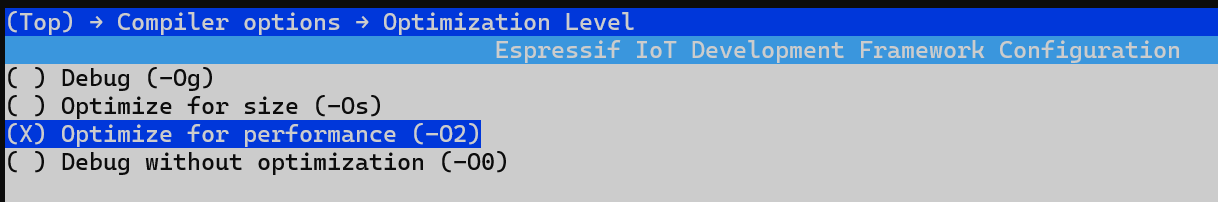

Implementation Detail

Training 在ImageNet[32]上进行预训练后,在语义分割任务上的训练方式与之前的工作[17, 23, 24, 29, 41]几乎相同。使用动量为0.9的SGD优化器。作为常见做法,采用poly学习率策略来衰减初始学习率。数据增强包括随机水平翻转、随机尺度调整(范围为[0.4, 1.6])和随机裁剪。对于DSNet,Cityscapes、ADE20K和BDD的迭代次数、初始学习率、权重衰减、裁剪尺寸和批量大小可以总结如下: [ 120 k , 0.01 , 0.0005 , 1024 × 1024 , 24 ] [120k, 0.01, 0.0005, 1024 × 1024, 24] [120k,0.01,0.0005,1024×1024,24], [ 150 k , 0.02 , 0.0001 , 512 × 512 , 32 ] [150k, 0.02, 0.0001, 512 ×512, 32] [150k,0.02,0.0001,512×512,32], [ 87 k , 0.01 , 0.0005 , 512 × 512 , 24 ] [87k, 0.01, 0.0005, 512 ×512, 24] [87k,0.01,0.0005,512×512,24]。对于DSNet-Base,Cityscapes、ADE20K和BDD的迭代次数、初始学习率、权重衰减、裁剪尺寸和批量大小可以总结如下: [ 120 k , 0.01 , 0.0005 , 1024 × 1024 , 32 ] [120k, 0.01, 0.0005, 1024 ×1024, 32] [120k,0.01,0.0005,1024×1024,32], [ 160 k , 0.02 , 0.0001 , 512 × 512 , 32 ] [160k, 0.02, 0.0001, 512 ×512, 32] [160k,0.02,0.0001,512×512,32], [ 108 k , 0.01 , 0.0005 , 512 × 512 , 16 ] [108k, 0.01, 0.0005, 512 ×512, 16] [108k,0.01,0.0005,512×512,16]。

Inference 在一个由单个RTX 4090、PyTorch 1.10、CUDA 11.3、cuDNN 8.0和Ubuntu环境组成的平台上测量推断速度。根据[29, 41],将批量归一化集成到卷积层中,并将批量大小设置为1,以测量推断速度。特殊速度比较。特别地,为了方便与基于mmcv框架[8]开发的一些模型进行速度比较,还使用了RTX3090来推断速度,将模型移植到mmcv框架或将基于mmcv框架的模型移植到环境中都需要显著的时间开销。mmcv框架的速度可以在SCTNet[42]中找到。

Ablation Study

两分支网络的多尺度注意力融合(MSAF)方法

将不同的融合方法应用于模型的三个侧连接。实验结果如表4所示。与逐元素相加(Add)相比,所有三种注意力融合方法在分割任务中都表现出优势,提高了准确性,同时速度损失最小。特别是提出的多尺度融合模块在分类和分割任务中表现出卓越的性能,在Imagenet1k分类任务上提高了0.9%,在Cityscapes上提高了0.7%。与AFF和iAFF[10]相比,它仍然在准确性上增加了近0.4%。本实验评估了第三个原则,使用适当的空洞卷积融合方法。

MFACB的效率

为了展示MFACB的有效性,作者进行了一个简单的对比实验。采用了两种不同的策略,分别称为 E X P 1 EXP \ 1 EXP 1和 E X P 2 EXP \ 2 EXP 2,如表5所示。为了保证实验的公平性,采用了相同的训练策略,使用两个RTX 4090 GPU,批量大小为12,对于两个实验都进行了50,000次迭代。从表中可以看出,使用相同的空洞率和相同数量的空洞卷积,MFACB相比于BasicBlock[19]取得了更好的性能。

SPASPP的效率

将SPASPP与其他上下文提取模块进行了比较,包括Atrous Spatial Pyramid Pooling (ASPP)[6]和Deep Aggregation Pyramid Pooling Module (DAPPM)[29]。为了获得更高的基准线,没有减少DAPPM的中间通道。从表6可以看出,本文提出的SPASPP将准确率从77.3%提高到80.4%,仅增加了1-2ms的推理时间。此外,SPASPP在几乎没有速度损失。

Comparison

ADE20K. 最近,大多数实时的基于CNN的分割方法主要关注Cityscapes数据集,对ADE20K数据集的关注较少。最近的一项工作[42]指出,由于ADE20K收集了超过150个类别的大量图像,它对轻量级的基于CNN的模型构成了相当大的挑战。然而,从表7中可以看出,所提方法在ADE20K上取得了良好的结果,而其他基于CNN的模型则没有。实验结果表明,DSNet在推理速度和准确性之间取得了最佳的平衡。具体而言,DSNet的准确性高于SegFormerB0、TopFormer-B和RTFormer-S,分别超过它们2.6%、0.8%和3.3%。此外,DSNet的运行速度大约是这些模型的两倍。DSNet-Base在准确性上也优于SeaFormer-B和SegNext-T,同时保持更快的速度。与RTFormer-B相比,DSNet-Base仍然保持着1.3%的准确性优势。BDD. 对 于BDD[46]数据集,只有SFNet和SFNet-Lite可以 与所提方 法 进行 比 较。SFNet-Lite[24]和SFNet[23]目前是BDD实时语义分割的最新技术。可以从表8中观察到实验结果。

在实时BDD语义分割方面取得了新的最先进成果。具体而言,DSNet的准确率比SFNet(ResNet18)和SFNet-Lite (ResNet18)高出2.2%,速度更快。与SFNet系列的更快版本相比,所提方法在准确率上比SFNet-Lite(STDC-2)高出3.4%mIoU,速度仅降低了0.3毫秒。此外,DSNet-Base在非实时领域实现了最高准确率。

Cityscapes.

之前基于CNN的实时工作将Cityscapes视为标准基准。从表9可以看出,所提方法在实时性和高准确性之间取得了新的最佳平衡。具体而言,DSNet在保持实时性能的同时实现了最高准确性。与SeaFormer-B-Seg100、AFFormer-B-Seg100和SegNext-T-Seg100相比,DSNet分别实现了2.7%、1.7%和0.6%的mIOU准确性提升,同时保持更快的推理速度。与SFNet、DDRNet23和PIDNet-M等最先进的CNN模型相比,DSNet仍然实现了最高准确性。此外,从表10还可以观察到,与HRNet和DeepLabV3等其他高准确性模型相比,DSNet-Base仍然具有很强的竞争力。

五、总结

本文重新审视了空洞卷积的应用,并提出了一种基于几个简单准则的新型双分支网络,其分辨率相同。DSNet在三个大型数据集上取得了更好的结果。由于所提方法是实时的,在实际应用中应用它可以带来显著的好处。