在如今AI技术飞速发展的时代,AI加速芯片已经成为了大模型时代必不可少的核心组件。从CPU到GPU,再到TPU和NPU,各种芯片不断涌现,但都面临着能耗和算力的平衡问题。那么,有没有一种AI芯片能够同时满足低功耗和高算力的需求呢?

今天我们将重点探讨基于一组器(RERAM,Resistive Random Access Memory)的存算一体芯片,这种芯片有望成为大模型时代继GPU之后的下一个产业蓝海。

1. 存算一体芯片的背景

1.1 传统AI芯片的局限性

传统的AI计算芯片主要基于冯·诺依曼架构,该架构下存储和计算是分离的,这导致了大量的数据搬运,带来了计算延迟和能耗增加的问题。随着AI技术的发展,计算速度的提升远远超过了数据搬运速度的提升,导致了算力提升面临瓶颈。阿姆达尔定律告诉我们,数据搬运的时间越长,硬件加速的能力就越差。

1.2 存算一体架构的优势

存算一体架构通过底层架构创新,将存储和计算同时进行,避免了数据搬运,从而大幅减少了计算延迟和能耗。这种架构能够充分利用存储介质的特性,实现更高效的计算。

2. 存算一体芯片的技术原理

2.1 存储介质的选择

目前常见的存储介质有SRAM、DRAM和Flash三种,分别对应缓存、内存和固态硬盘。在存算一体芯片中,SRAM和Flash的研究较为广泛,因为它们属于较为成熟的存储介质,可以快速搭建原型产品。

- SRAM:利用六个晶体管实现双稳态电路存储数据,读写速度快,但功耗高,成本高。

- DRAM:利用一个电容和一个晶体管实现数据存储,读写速度快,但需要动态刷新,导致能耗高,控制复杂。

- Flash:利用带有浮栅极的晶体管,通过电压变化控制电荷存储数据,读写速度较慢,但功耗低,存储密度高。

2.2 RERAM的技术原理

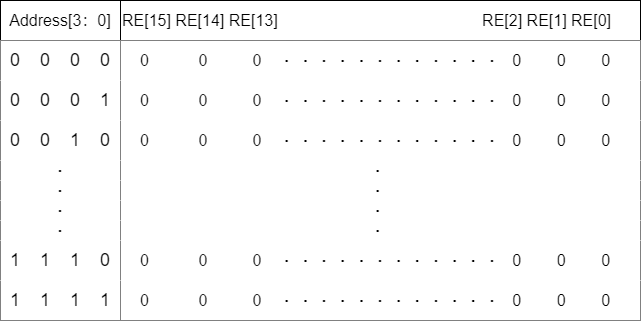

RERAM(电阻式随机存取存储器)是一种基于改变材料电阻值来存储数据的存储介质,可以分为基于氧空穴和导电桥的两种原理。RERAM天然适合实现AI计算中的乘法操作,通过输入电压作为输入数据,电阻的倒数作为权重,测出的电流大小即为乘积。这种基于物理定律的计算方法不仅设计简单,还能实现高密度集成和低功耗。

2.3 模拟计算与数字计算

传统的RERAM计算属于模拟计算,虽然可以获得更高的算力功耗比和算力面积比,但模拟计算需要大量的数模和模数转换操作,导致芯片面积和功耗增加,精度也受限。因此,纯数字化的RERAM存算一体架构逐渐成为趋势,这种架构通过一组器构建数字逻辑门,实现存储和计算的同时进行,避免了大量转换操作,更接近产业化。

3. RERAM存算一体芯片的优势

3.1 高密度和灵活性

RERAM基于物理原理,可以提供更细粒度的状态控制,带来了更大的存储密度和数据表示灵活性。这使得RERAM非常适合大算力推理场景,既能快速读写,又能保持低功耗。

3.2 长寿命和低成本

RERAM的写入次数虽然相对较低,但在推理场景中,模型加载后更新频率很低,数万次的写入寿命足以满足需求。同时,RERAM的制造成本较低,可以大幅降低大算力芯片的整体成本。

3.3 低功耗和高性能

RERAM存算一体芯片能够实现极低的功耗和高性能,避免了传统架构中的数据搬运问题,提高了整体计算效率。这种优势在大规模AI模型的推理过程中尤为显著。

4. 存算一体芯片的应用与前景

4.1 现实应用案例

目前,基于RERAM的存算一体芯片已经在POC级别的产品中落地,展示了其在AI推理中的巨大潜力。例如,在人脸识别、自动驾驶和语音识别等高精度大算力应用中,RERAM芯片表现出了优异的性能和能效比。

4.2 未来发展趋势

随着上游材料和工艺的成熟,RERAM芯片的产业链也逐渐完善,预计未来几年内,RERAM存算一体芯片将在AI推理和大算力应用中占据重要地位。与此同时,数模混合和纯数字化RERAM设计将不断优化,推动技术的进一步发展。

5. 结论与展望

总的来说,RERAM存算一体芯片以其高密度、低功耗和高性能的优势,有望成为大模型时代AI推理的理想选择。虽然目前还存在一些技术挑战,但随着产业链的完善和技术的进步,RERAM芯片将在未来发挥越来越重要的作用。

未来,随着AI技术的不断发展和应用场景的不断拓展,存算一体芯片将迎来更多创新和突破,成为AI计算的核心引擎。