引言

Qwen 2 模型家族最近引起了广泛关注,作为继 Qwen 1.5 的升级版,这些模型在多语言支持、推理能力和长上下文处理等方面表现出色。本文将深入探讨 Qwen 2 模型的特点、应用场景以及具体的代码示例,帮助读者更好地理解和使用这些模型。

Qwen 2 模型概述

Qwen 2 模型家族涵盖了从5亿参数到72亿参数的多个版本,展示了显著的性能提升。本文将主要关注两个模型:Qwen 7B(7亿参数)和 Qwen 72B(72亿参数)。

多语言支持

Qwen 2 的多语言支持是其一大亮点。与许多仅限于英语的模型不同,Qwen 2 支持包括东南亚语言(如塔加拉族语、印尼语、马来语)和南亚语言(如印地语、乌尔都语)在内的多种语言,这使其在全球范围内具有更广泛的应用潜力。

推理和数学能力

Qwen 2 在推理和数学问题上表现优异。本文将通过具体的代码示例展示其在 GSM8K(数学问题数据集)上的出色表现。

长上下文处理

Qwen 2 支持长上下文处理,最高可达128,000个token。这对于需要处理长文档和复杂上下文的应用场景非常有用。

Qwen 2 模型的应用探索

Qwen 7B 模型的使用示例

我们将从 Qwen 7B 模型开始,通过具体代码展示如何使用该模型进行推理和数学问题求解。

colab 代码:https://colab.research.google.com/drive/1ErO_WmKrHJWnJjM2RV6-uiY3ud_ZjN_w?usp=sharing

代码示例

以下是使用 Qwen 7B 模型的代码示例,运行环境为 Google Colab。

!pip install transformers

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载Qwen 7B模型和tokenizer

model_name = "Qwen/Qwen-7B"

model = AutoModelForCausalLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 定义推理函数

def generate_response(prompt):

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(inputs.input_ids, max_length=512)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

return response

# 示例:数学问题求解

prompt = "What is the result of 3 + 5?"

response = generate_response(prompt)

print("Response:", response)

运行结果

上述代码将加载 Qwen 7B 模型并进行简单的数学问题求解。结果显示,模型能够准确计算出 3 + 5 的结果,并返回答案。

Qwen 72B 模型的使用示例

Qwen 72B 模型参数更大,适用于更复杂的推理任务。我们将展示如何使用该模型处理复杂的数学问题。

代码示例

以下是使用 Qwen 72B 模型的代码示例,同样在 Google Colab 中运行。

!pip install transformers

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载Qwen 72B模型和tokenizer

model_name = "Qwen/Qwen-72B"

model = AutoModelForCausalLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 定义推理函数

def generate_response(prompt):

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(inputs.input_ids, max_length=1024)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

return response

# 示例:复杂数学问题求解

prompt = "Calculate the result of (1234 + 5678) * (91011 - 1213)."

response = generate_response(prompt)

print("Response:", response)

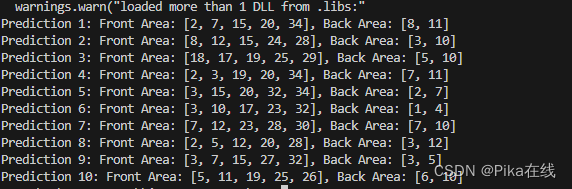

运行结果

Qwen 72B 模型能够处理更复杂的数学问题,并返回准确的结果。其强大的计算能力和推理能力使其在科学研究、数据分析等领域具有广泛的应用前景。

模型在其他领域的应用

除了数学和推理问题,Qwen 2 模型还可以应用于其他领域,例如:

- 多语言文本生成:利用其多语言支持能力,可以生成和处理多种语言的文本。

- 代码生成与分析:Qwen 2 在编程和代码生成方面表现出色,可以用于自动代码生成、代码审查等任务。

- 长文档处理:利用其长上下文处理能力,可以处理和生成长文档内容,适用于法律文档分析、长篇小说创作等。

结论

Qwen 2 模型家族展示了强大的多语言支持、推理能力和长上下文处理能力。通过本文的介绍和代码示例,读者可以更好地理解和应用这些模型,充分发挥其在不同领域的潜力。未来,随着更多技术报告和应用案例的发布,我们期待Qwen 2 模型能够在更多领域取得突破。

参考资料

- Qwen 模型在 HuggingFace 上的介绍

- Ollama 平台

希望本文对您理解和应用Qwen 2 模型有所帮助。如果您有任何问题或建议,欢迎在评论区留言。谢谢阅读!