摘自:Meta-Transfer Learning for Zero-Shot Super-Resolution

近年来,提出了各种元学习算法。它们可以分为三类:

- 基于度量的方法:这些方法通过学习度量空间,使得在少量样本内进行高效的学习。例如[35, 38, 39]。

- 基于记忆网络的方法:这些方法利用网络学习跨任务知识,并且能够很好地泛化到未见过的任务。例如[31, 28, 25]。

- 基于优化的方法:在这些方法中,梯度下降作为元学习者的优化工具。例如[10, 18, 9, 8]。

在这些方法中,MAML(Model-Agnostic Meta-Learning)[8]在研究社区中产生了巨大的影响,并且还提出了多种变体。例如:

- MAML 本质上需要计算二阶导数项,而文献[27]提出了只需要一阶导数的算法。

- 为了解决 MAML 训练过程中的不稳定性,提出了 MAML++[3]。

- 此外,还提出了在嵌入空间中应用 MAML 的方法[30]。

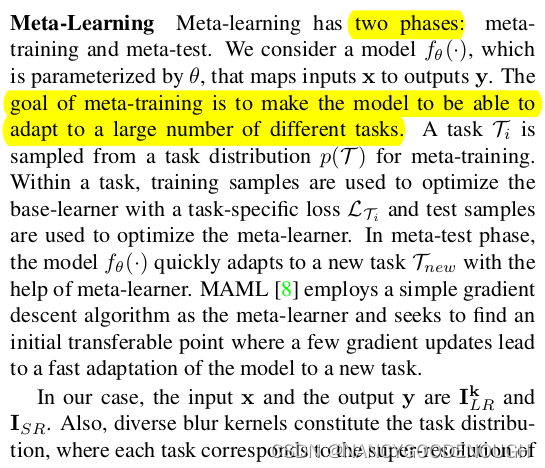

Model-Agnostic Meta-Learning (MAML) 是一种元学习(meta-learning)方法,旨在通过学习模型的最佳初始状态,使得基本学习器(base-learner)可以在少量梯度更新中快速适应新任务。以下是关于 MAML 及其应用的一些详细信息:

1. MAML 的基本概念

1.1 目标

MAML 的目标是找到模型参数的一个良好初始状态,这样当面对新的任务时,模型可以通过几次梯度下降就实现较好的性能。它的核心思想是通过在多任务上进行训练,学习一种通用的初始化参数。

1.2 训练过程

MAML 的训练过程可以分为两个阶段:

- 内循环(Inner Loop):对每个任务进行几次梯度下降,以调整模型参数。

- 外循环(Outer Loop):通过对内循环后的模型性能进行评价,并使用这些评价结果来更新初始模型参数。

具体步骤如下:

2. MAML 的影响和性能

MAML 通过学习初始参数,使得模型能够在面对新任务时通过少量的训练数据和训练步骤快速适应,这对于少样本学习(few-shot learning)特别有用。MAML 展示了在图像分类、强化学习等领域的优越性能。

3. 梯度下降的普适性

MAML 利用梯度更新作为元学习器,而研究表明,梯度下降可以逼近任何学习算法。因此,MAML 具有广泛的适用性,并能够应用于各种模型和任务。

4. 结合迁移学习的应用

Sun 等人提出的方法将 MAML 与迁移学习结合,通过利用大规模数据来提升少样本学习的效果。这种方法可以总结为以下几点:

- 预训练阶段:在大规模数据集上预训练模型,以获取良好的初始参数。

- 元学习阶段:使用 MAML 方法在多个少样本任务上进行元训练,进一步调整模型的初始参数。

这种方法利用了迁移学习的优势,通过大规模数据预训练获得强大的表示能力,再通过 MAML 的元学习步骤,进一步优化初始参数,使其更适应少样本任务。

5. 具体应用场景

MAML 及其改进方法在多个领域展示了强大的性能,包括但不限于:

- 图像分类:在少样本情况下快速适应新类别的分类任务。

- 强化学习:在新环境中快速学习有效的策略。

- 自然语言处理:处理少量文本样本的新任务,如意图识别和对话生成。

- 超分辨率应用:

- an image degraded by a specific blur kernel.

结论

MAML 是一种强大的元学习方法,通过学习模型的最佳初始状态,使模型能够在少量梯度更新中快速适应新任务。结合迁移学习的方法进一步提升了 MAML 在少样本学习中的性能。通过在不同任务上的应用,MAML 展示了其广泛的适用性和优越的性能。