一 目标检测和边界框

在图像分类任务中,我们假设图像中只有一个主要物体对象,我们只关注如何识别其类别。然而,很多时候图像里有多个我们感兴趣的目标,我们不仅想知 道它们的类别,还想得到它们在图像中的具体位置。在计算机视觉里,我们将这类任务称为 目标检测(object detection)或目标识别(object recognition)。

目标检测在多个领域中被广泛使用。例如,在无人驾驶里,我们需要通过识别拍摄到的视频图像里的车辆、行 人、道路和障碍物的位置 来规划行进线路。机器人也常通过该任务来检测感兴趣的目标。安防领域则需要检测异常目标,如歹徒或者炸弹。

接下来的几节将介绍几种用于目标检测的深度学习方法。我们将首先介绍目标的位置。

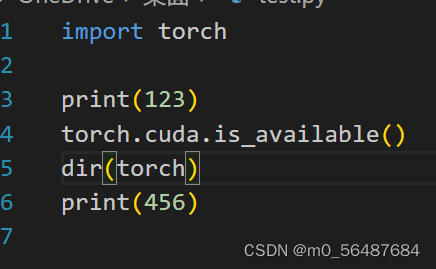

%matplotlib inline

import torch

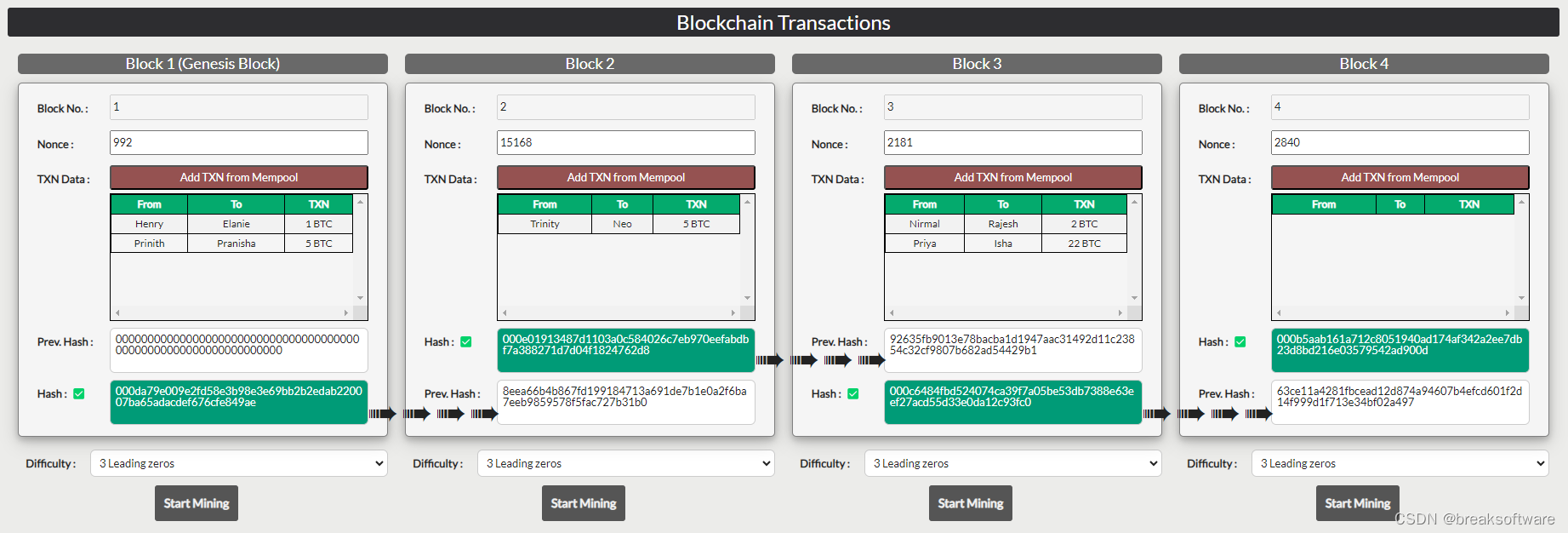

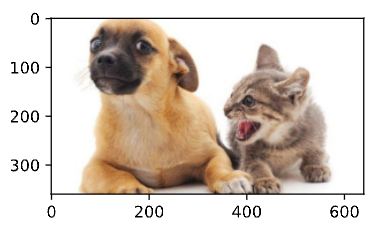

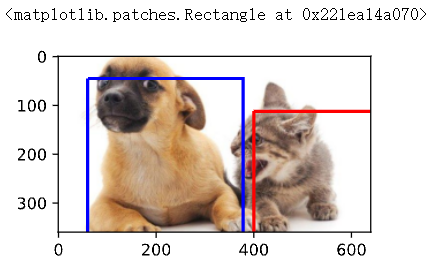

from d2l import torch as d2l下面加载本节将使用的示例图像。可以看到图像左边是一只狗,右边是一只猫。它们是这张图像里的两个主要目标。

d2l.set_figsize()

img = d2l.plt.imread('../img/catdog.jpg')

d2l.plt.imshow(img)

1.1 边界框

在目标检测中,我们通常使用 边界框(bounding box)来描述对象的空间位置。边界框是矩形的,由矩形左上角的以及右下角的x和y坐标决定。另一种常用的边界框表示方法是边界框中心的(x, y)轴坐标以及框的宽 度和高度。 在这里,我们定义在这两种表示法之间进行转换的函数:box_corner_to_center从两角表示法转换为中心宽度表示法,而box_center_to_corner反之亦然。输入参数boxes可以是长度为4的张量,也可以是形状为(n, 4)的二维张量,其中 n是边界框的数量。

#@save

def box_corner_to_center(boxes):

x1, y1, x2, y2 = boxes[:, 0], boxes[:, 1], boxes[:, 2], boxes[:, 3]

cx = (x1 + x2) / 2

cy = (y1 + y2) / 2

w = x2 - x1

h = y2 - y1

boxes = torch.stack((cx, cy, w, h), axis=-1)

return boxes

#@save

def box_center_to_corner(boxes):

cx, cy, w, h = boxes[:, 0], boxes[:, 1], boxes[:, 2], boxes[:, 3]

x1 = cx - 0.5 * w

y1 = cy - 0.5 * h

x2 = cx - 0.5 * w

y2 = cy - 0.5 * h

boxes = torch.stack((x1, y1, x2, y2), axis=-1)

return boxes我们将根据坐标信息定义图像中狗和猫的边界框。图像中坐标的原点是图像的左上角,向右的方向为x轴的 正方向,向下的方向为y轴的正方向。

dog_bbox, cat_bbox = [60.0, 45.0, 378.0, 516.0], [400.0, 112.0, 655.0, 493.0]我们可以通过转换两次来验证边界框转换函数的正确性。

boxes = torch.tensor((dog_bbox, cat_bbox))

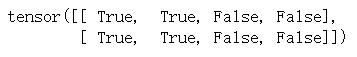

box_center_to_corner(box_corner_to_center(boxes)) == boxes

我们可以 将边界框在图中画出,以检查其是否准确。画之前,我们定义一个辅助函数bbox_to_rect。它将边 界框表示成matplotlib的边界框格式。

#@save

def bbox_to_rect(bbox, color):

return d2l.plt.Rectangle(

xy=(bbox[0], bbox[1]), width=bbox[2] - bbox[0], height=bbox[3]-bbox[1],

fill=False, edgecolor=color, linewidth=2

)fig = d2l.plt.imshow(img)

fig.axes.add_patch(bbox_to_rect(dog_bbox, 'blue'))

fig.axes.add_patch(bbox_to_rect(cat_bbox, 'red'))

小结:

- 目标检测不仅可以识别图像中所有感兴趣的物体,还能识别它们的位置,该位置通常由矩形边界框表示。

- 我们可以在两种常用的边界框表示(中间,宽度,高度)和(左上,右下)坐标之间进行转换。

1.2 锚框

目标检测算法通常会在输入图像中采样大量的区域,然后判断这些区域中是否包含我们感兴趣的目标,并调整区域边界从而更准确地预测目标的真实边界框(ground‐truth bounding box)。不同的模型使用的区域采样方法可能不同。这里我们介绍其中的一种方法:以每个像素为中心,生成多个缩放比和宽高比(aspect ratio) 不同的边界框。这些边界框被称为锚框(anchor box)我们将设计一个基于锚框的目标检测模型。

首先,让我们修改输出精度,以获得更简洁的输出。

1.2.1 生成多个锚框

假设输入图像的高度为h,宽度为w。我们以图像的每个像素为中心生成不同形状的锚框:缩放比为s ∈ (0, 1], 宽高比为r > 0。那么锚框的宽度和高度分别是hs√ r和hs/ √ r。请注意,当中心位置给定时,已知宽和高的锚框是确定的。

#@save

def multibox_prior(data, sizes, ratios):

in_height, in_width = data.shape[-2:]

device, num_sizes, num_ratios = data.device, len(sizes), len(ratios)

boxes_per_pixel = (num_sizes + num_ratios - 1)

size_tensor = torch.tensor(sizes, device=device)

ratio_tensor = torch.tensor(ratios, device=device)

offset_h, offset_w = 0.5, 0.5

steps_h = 1.0 / in_height

steps_w = 1.0 / in_width

center_h = (torch.arange(in_height, device=device) + offset_h) * steps_h

center_w = (torch.arange(in_width, device=device) + offset_w) * steps_w

shift_y, shift_x = torch.meshgrid(center_h, center_w, indexing='ij')

shift_y, shift_x = shift_y.reshape(-1), shift_x.reshape(-1)

w = torch.cat((size_tensor * torch.sqrt(ratio_tensor[0]),

sizes[0] * torch.sqrt(ratio_tensor[1:]))) * in_height / in_width

h = torch.cat((size_tensor / torch.sqrt(ratio_tensor[0]),

sizes[0] / torch.sqrt(ratio_tensor[1:])))

anchor_manipulations = torch.stack((-w, -h, w, h)).T.repeat(

in_height * in_width, 1) / 2

out_grid = torch.stack([shift_x, shift_y, shift_x, shift_y],

dim=1).repeat_interleave(boxes_per_pixel, dim=0)

output = out_grid + anchor_manipulations

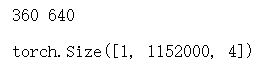

return output.unsqueeze(0)可以看到返回的锚框变量Y的形状是(批量大小,锚框的数量,4)。

img = d2l.plt.imread('../img/catdog.jpg')

h, w = img.shape[:2]

print(h, w)

X = torch.rand(size=(1, 3, h, w))

Y = multibox_prior(X, sizes=[0.75, 0.5, 0.25], ratios=[1, 2, 0.5])

Y.shape

将锚框变量Y的形状更改为(图像高度,图像宽度,以同一像素为中心的锚框的数量,4)后,我们可以获得以指定像素的位置为中心的所有锚框。在接下来的内容中,我们访问以(250,250)为中心的第一个锚框。它有四个元素:锚框左上角的(x, y)轴坐标和右下角的(x, y)轴坐标。输出中两个轴的坐标各分别除以了图像的宽度和 高度。

boxes = Y.reshape(h, w, 5, 4)

boxes[250, 250, 0, :]

# tensor([0.1805, 0.3208, 0.6023, 1.0708])为了显示以图像中以某个像素为中心的所有锚框,定义下面的show_bboxes函数来在图像上 绘制多个边界框。

#@save

def show_bboxes(axes, bboxes, labels=None, colors=None):

def _make_list(obj, default_values=None):

if obj is None:

obj = default_values

elif not isinstance(obj, (list, tuple)):

obj = [obj]

return obj

labels = _make_list(labels)

colors = _make_list(colors, ['b', 'g', 'r', 'm', 'c'])

for i, bbox in enumerate(bboxes):

color = colors[i % len(colors)]

rect = d2l.bbox_to_rect(bbox.detach().numpy(), color)

axes.add_patch(rect)

if labels and len(labels) > i:

text_color = 'k' if color == 'w' else 'w'

axes.text(rect.xy[0], rect.xy[1], labels[i],

va='center', ha='center', fontsize=9, color=text_color,

bbox=dict(facecolor=color, lw=0))正如从上面代码中所看到的,变量boxes中x轴和y轴的坐标值已分别除以图像的宽度和高度。绘制锚框时,我们需要恢复它们原始的坐标值。因此,在下面定义了变量bbox_scale。现在可以绘制出图像中所有以(250,250)为 中心的锚框了。如下所示,缩放比为0.75且宽高比为1的蓝色锚框很好地围绕着图像中的狗。

d2l.set_figsize()

bbox_scale = torch.tensor((w, h, w, h))

fig = d2l.plt.imshow(img)

show_bboxes(fig.axes, boxes[250, 250, :, :] * bbox_scale,

['s=0.75, r=1', 's=0.5, r=1', 's=0.25, r=1', 's=0.75, r=2',

's=0.75, r=0.5'])

1.2.2 交并比(IoU)

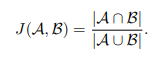

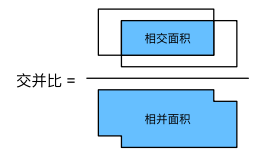

我们刚刚提到某个锚框“较好地”覆盖了图像中的狗。如果已知目标的真实边界框,那么这里的“好”该如 何如何量化呢?直观地说,可以衡量锚框和真实边界框之间的相似性。杰卡德系数(Jaccard)可以衡量两组 之间的相似性。杰卡德系数(Jaccard)可以衡量两组 之间的相似性。给定集合A和B,他们的杰卡德系数是他们 交集的大小除以他们并集 的大小:

事实上,我们可以将任何边界框的像素区域视为一组像素。通过这种方式,我们可以通过其像素集的杰卡德系数来测量两个边界框的相似性。对于两个边界框,它们的杰卡德系数通常称为交并比(intersection over union,IoU),即两个边界框相交面积与相并面积之比。交并比的 取值范围在0和1之间:0表 示两个边界框无重合像素,1表示两个边界框完全重合。

接下来部分将使用交并比来衡量锚框和真实边界框之间、以及不同锚框之间的相似度。给定两个锚框或边界框的列表,以下 box_iou函数将在这两个列表中计算它们成对的交并比。

#@save

def box_iou(boxes1, boxes2):

box_area = lambda boxes: ((boxes[:, 2] - boxes[:, 0]) *

(boxes[:, 3] - boxes[:, 1]))

areas1 = box_area(boxes1)

areas2 = box_area(boxes2)

inter_upperlefts = torch.max(boxes1[:, None, :2], boxes2[:, :2])

inter_lowerrights = torch.min(boxes1[:, None, 2:], boxes2[:, 2:])

inters = (inter_lowerrights - inter_upperlefts).clamp(min=0)

inter_areas = inters[:, :, 0] * inters[:, :, 1]

union_areas = areas[: None] + areas2 - inter_areas

return inter_areas / union_areas1.2.3 在训练数据中标注锚框

在训练集中,我们将每个锚框视为一个训练样本。为了训练目标检测模型,我们需要每个锚框的类别(class) 和偏移量(offset)标签,其中前者是与锚框相关的对象的类别,后者是真实边界框相对于锚框的偏移量。在 预测时,我们为每个图像生成多个锚框,预测所有锚框的类别和偏移量,根据预测的偏移量调整它们的位置 以获得预测的边界框,最后只输出符合特定条件的预测边界框。

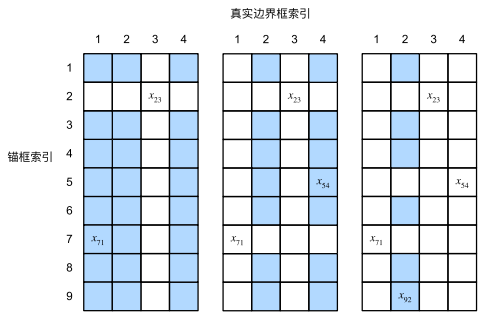

将真实边界框分配给锚框,给定图像,假设锚框 是A1, A2, . . . , Ana,真实边界框 是B1, B2, . . . , Bnb,其中na ≥ nb。让我们定义一个矩 阵X ∈ R na×nb,其中第i行、第j列的元素xij是锚框Ai和真实边界框Bj的IoU。该算法包含以下步骤。

- 在矩阵X中找到最大的元素,并将它的行索引和列索引分别表示为i1和j1。然后将真实边界框Bj1分配给 锚框Ai1。这很直观,因为Ai1和Bj1是所有锚框和真实边界框配对中最相近的。在第一个分配完成后,丢弃矩阵中i1 th行和j1 th列中的所有元素。

- 在矩阵X中找到剩余元素中最大的元素,并将它的行索引和列索引分别表示为i2和j2。我们将真实边界 框Bj2分配给锚框Ai2,并丢弃矩阵中i2 th行和j2 th列中的所有元素。

- 此时,矩阵X中两行和两列中的元素已被丢弃。我们继续,直到丢弃掉矩阵X中nb列中的所有元素。此时已经为这nb个锚框各自分配了一个真实边界框。

- 只遍历剩下的na − nb个锚框。例如,给定任何锚框Ai,在矩阵X的第i th行中找到与Ai的IoU最大的真实边界框Bj,只有当此IoU大于预定义的阈值时,才将Bj分配给Ai。

下面用一个具体的例子来说明上述算法。如下图(左)所示,假设矩阵X中的最大值为x23,我们将真实边界框B3分配给锚框A2。然后,我们丢弃矩阵第2行和第3列中的所有元素,在剩余元素(阴影区域)中找到 最大的x71,然后将真实边界框B1分配给锚框A7。接下来,如 下图(中)所示,丢弃矩阵第7行和第1列 中的所有元素,在剩余元素(阴影区域)中找到最大的x54,然后将真实边界框B4分配给锚框A5。最后,如 下图(右)所示,丢弃矩阵第5行和第4列中的所有元素,在剩余元素(阴影区域)中找到最大的x92,然 后将真实边界框B2分配给锚框A9。之后,我们只需要遍历剩余的锚框A1, A3, A4, A6, A8,然后根据阈值确定是否为它们分配真实边界框。

此算法在下面的assign_anchor_to_bbox函数中实现。

#@save

def assign_anchor_to_bbox(ground_truth, anchors, device, iou_threshold=0.5):

num_anchors, num_gt_boxes = anchors.shape[0], ground_truth.shape[0]

jaccard = box_iou(anchors, ground_truth)

anchors_bbox_map = torch.full((num_anchors,), -1, dtype=torch.long,

device=device)

max_ious, indices = torch.max(jaccard, dim=1)

anc_i = torch.nonzero(max_ious >= iou_threshold).reshape(-1)

box_j = indices[max_ious >= iou_threshold]

anchors_bbox_map[anc_i] = box_j

col_discard = torch.full((num_anchors,), -1)

row_discard = torch.full((num_anchors,), -1)

for _ in range(num_gt_boxes):

max_idx = torch.argmax(jaccard)

box_idx = (max_idx % num_gt_boxes).long()

anx_idx = (max_idx / num_gt_boxes).long()

anchors_bbox_map[anc_idx] = box_idx

jaccard[:, box_idx] = col_discard

jaccard[anc_idx, :] = row_discard

return anchors_bbox_map1.2.4 标记类别和偏移量

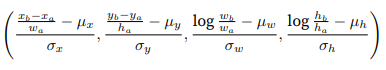

现在我们可以为每个锚框 标记类别和偏移量了。假设一个锚框A被分配了一个真实边界框B。一方面,锚 框A的类别将被标记为与B相同。另一方面,锚框A的偏移量将根据B和A中心坐标的相对位置以及这两个 框的相对大小进行标记。鉴于数据集内不同的框的位置和大小不同,我们可以对那些相对位置和大小应用 变换,使其获得分布更均匀且易于拟合的偏移量。这里介绍一种常见的变换。给定框A和B,中心坐标分别 为(xa, ya)和(xb, yb),宽度分别为wa和wb,高度分别为ha和hb,可以将A的偏移量标记为:

#@save

def offset_boxes(anchors, assigned_bb, eps=1e-6):

c_anc = d2l.box_corner_to_center(anchors)

c_assigned_bb = d2l.box_corner_to_center(assigned_bb)

offset_xy = 10 * (c_assigned_bb[:, :2] - c_anc[:, :2]) / c_anc[:, 2:]

offset_wh = 5 * torch.log(eps + c_assigned_bb[:, 2:] / c_anc[:, 2:])

offset = torch.cat([offset_xy, offset_wh], axis=1)

return offset如果一个锚框没有被分配真实边界框,我们只需将锚框的类别标记为背景(background)。背景类别的锚框通常被称为负类锚框,其余的被称为正类锚框。我们使用真实边界框(labels参数)实现以下multibox_target函 数,来标记锚框的类别和偏移量(anchors参数)。此函数将背景类别的索引设置为零,然后将新类别的整数索引递增一。

#@save

def multibox_target(anchors, labels):

batch_size, anchors =labels.shape[0], anchors.squeeze(0)

batch_offset, batch_mask, batch_class_labels = [], [], []

device, num_anchors = anchors.device, anchors.shape[0]

for i in range(batch_size):

label = labels[i, :, :]

anchors_bbox_map = assign_anchor_to_bbox(

label[:, 1:], anchors, device)

bbox_mask = ((anchors_bbox_map >= 0).float().unsqueeze(-1)).repeat(1, 4)

class_labels = torch.zeros(num_anchors, dtype=torch.long, device=device)

assigned_bb = torch.zeros((num_anchors, 4), dtype=torch.float32, device=device)

indices_true = torch.nonzero(anchors_bbox_map >= 0)

bb_idx = anchors_bbox_map[indices_true]

class_labels[indices_true] = label[bb_idx, 0].long() + 1

assigned_bb[indices_true] = label[bb_idx, 1:]

offset = offset_boxes(anchors, assigned_bb) * bbox_mask

batch_offset.append(offset.reshape(-1))

batch_class_labels.append(class_labels)

bbox_offset = torch.stack(batch_offset)

bbox_mask = torch.stack(batch_mask)

class_labels = torch.stack(batch_class_labels)

return (bbox_offset, bbox_mask, class_labels)

![[ue5]建模场景学习笔记(5)——必修内容可交互的地形,交互沙(3)](https://img-blog.csdnimg.cn/direct/1d6b503f4b894614bab27861914d6ea3.png)