目录

第一步:启动ollama

第二步:启动dify

第三步:配置模型(截图)

最近llama3很火,本文追击热点,做一个本地化部署的尝试,结果还成功了!

当然也是站在别人的肩膀上,文章最后有具体的参考文章,由于他们都是单独讲各自的部署,这里进行了整合。也就是说,如果你想本地化部署llama3大模型,本文是一套完整的部署方案。

第一步:启动ollama

ollama是可以本地部署的模型,其他模型,大多需要key才能进行连接。并不能做到本地化部署,而ollama作为轻量级,可本地化部署的模型,就是我们当下最好的选择了。

安装ollama很简单,只要你安装了docker,一条命令就可以了。

docker pull ollama/ollama

docker run -d -v $PWD/ollama:/root/.ollama -p 11434:11434 \--name ollama ollama/ollama

docker exec -it ollama /bin/bash

ollama run llama3安装成功并且run以后,就可以看到下面的提示符,说明模型已经部署成功了!

需要注意的是:

如果已启动过,需要删除原有的容器,当你再次重启以后,这个容器是不会自动运行的,需要手动,如下代码。当然也可以采用docker compose的方式,这里就偷懒了。

docker restart ollama

docker exec -it ollama /bin/bash

ollama run llama3还有一种方法就是把容器删除,重新启动,浪费时间就不推荐了。

docker rm 容器名称

第二步:启动dify

第一步完成以后,后面就是安装dify框架了,dify的介绍和功能,在下面的参考文章中都有,有兴趣可以去看看,这里就不多说了,直接上代码。

git clone https://github.com/langgenius/dify.git

cd /dify/docker

docker-compose up -d当dify安装成功以后,首先要进行管理员配置,傻瓜式操作。

需要注意的是,当你添加新用户的时候,是采用邀请的方式,并不能直接设定用户的密码,这一点与其他平台有点儿不同。

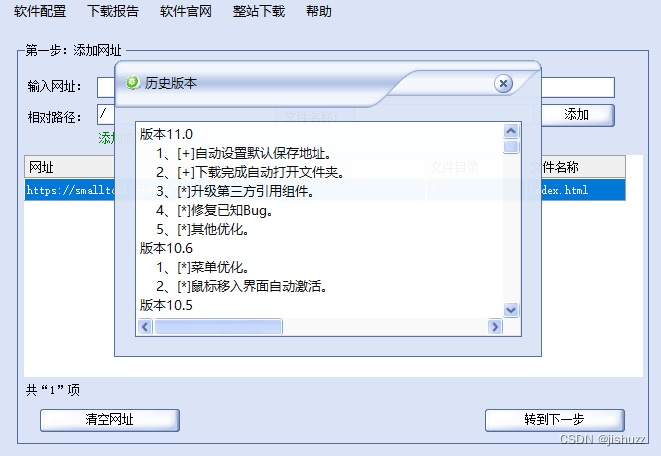

第三步:配置模型(截图)

最后一步是在dify里配置ollama模型,如下图:

如果能够保存成功,就大功告成了!

需要注意的是,本文采用的是纯CPU模式,如果要上生产,还是要用到GPU的,否则生成回答的时候,会很慢很卡。

参考文章:

58k+star!ollama快速部署llama3大模型 - 大模型知识库|大模型训练|开箱即用的企业大模型应用平台|智能体开发|53AI

内网穿透的应用-如何使用Docker本地部署Dify LLM结合内网穿透实现公网访问本地开发平台_difydocker部署-CSDN博客

接入 Ollama 部署的本地模型 | 中文 | Dify