『大模型笔记』Transformer系列技术博文汇总!

文章目录

第1篇:矩阵乘法概念解释 第2篇:使用缩放点积方法的自注意力 第3篇:深入探讨多头注意力、自注意力和交叉注意力 第4篇:Transformer 架构 第5篇:PostLN,PreLN和ResiDual Transformers 第6篇:多头注意力的变种:多查询(MQA)和分组查询注意力(GQA) 第7篇:Transformer模型的高效自注意力机制 第8篇:注意力机制中的线性复杂度:PyTorch中的逐步实现 第9篇:相对自注意力解释

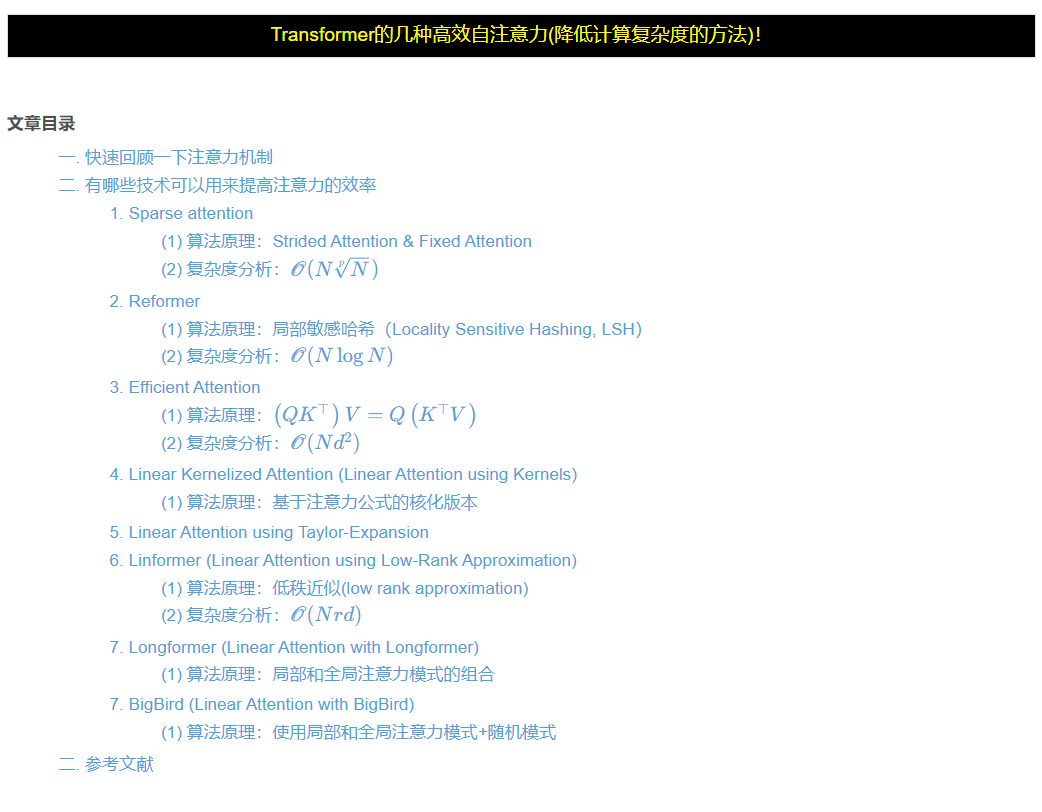

Matrix Multiplication Concept Explained(矩阵乘法概念解释) Self-Attention Using Scaled Dot-Product Approach(使用缩放点积方法的自注意力) A Dive Into Multihead Attention, Self-Attention and Cross-Attention(深入探讨多头注意力、自注意力和交叉注意力) Transformer Architecture(Transformer 架构) PostLN, PreLN and ResiDual Transformers Variants of Multi-head attention: Multi-query (MQA) and CGrouped-query attention (GQA)(多头注意力的变种:多查询(MQA)和分组查询注意力(GQA)) Efficient Self-Attention for Transformers(Transformer模型的高效自注意力机制) 文章链接: 『大模型笔记』Transformer的几种高效自注意力(降低计算复杂度的方法)!

Linear Complexity in Attention Mechanism: A step-by-stepimplementation in PyTorch(注意力机制中的线性复杂度:PyTorch中的逐步实现) Relative Self-Attention Explained(相对自注意力解释)

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/1800456.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!