目录

迎接 AGI 时代

什么是 AI?

AGI 和AIGC

大模型 AI 能干什么?

大模型落地情况综述

Killer App 没有影

AI 原生待证明

成功落地大模型五要素

大模型是怎样工作的?

通俗原理

略深一点的通俗原理

再深一点点

用好 AI 的核心心法

大模型应用产品架构

大模型应用技术架构

纯 Prompt

Agent + Function Calling

RAG(Retrieval-Augmented Generation)

Fine-tuning(精调/微调)

如何选择技术路线

如何选择基础模型

迎接 AGI 时代

AGI(Artificial General Intelligence)多久会到来?

- 乐观预测:明年

- 主流预测:3-5 年(OpenAI、DeepMind、NVIDIA 持此观点)

- 悲观预测:10 年

AGI 时代,AI 无处不在,形成新的社会分层:

- AI 使用者,使用别人开发的 AI 产品

- AI 产品开发者,设计和开发 AI 产品

- 基础模型相关,训练基础大模型,或为大模型提供基础设施

越向下层,重要性越高,从业人数越少。

什么是 AI?

一种观点:基于机器学习、神经网络的是 AI,基于规则、搜索的不是 AI。

AGI 和AIGC

AGI: Artificial General Intelligence,通用人工智能。是一个人工智能理论研究领域,研究如何开发具有类人智能和自学能力的软件。其目标是让软件能够执行训练或开发目的之外的任务。 AGI 旨在开发具有自主自我控制、合理的自我理解以及新技能学习能力的人工智能系统。AGI 是AI发展的终极目标。

AIGC:是指由AI自动创作生成的内容( AI Generated Content),即AI接收到人下达的任务指令,通过处理人的自然语言,自动生成图片、视频、音频等。

大模型 AI 能干什么?

大模型,全称「大语言模型」,英文「Large Language Model」,缩写「LLM」。

注意,我们所说的大模型和大模型应用产品是两个概念。例如,OpenAI 的gpt3.5、gpt4.0是大模型,Chatgpt是基于gpt大模型生成的上层应用产品。

大模型的特点:

- 大模型就是一个函数,给输入,生成输出

- 任何可以用语言描述的问题,都可以输入文本给大模型,就能生成问题的结果文本。任意数据,都可以输入给大模型,生成任意数据

大模型落地情况综述

Killer App 没有影

- AI 没有创造新的使用场景,只是旧场景的增强,所以没有 Killer App 的土壤

- 可以乐观期待 Killer App,但别苦苦追求

- 请忽略一切张嘴就是 Killer App 的人

AI 原生待证明

AI 原生,是指产品的核心功能是 AI,而不是 AI 作为辅助功能。典型特点是,有 AI 后才出现。

- 助手类,打不过 Siri 们

- ChatGPT

- Kimi Chat

- 文心一言

- 通义千问

- 智谱清言

- ……

- 搜索类,谷歌百度不会袖手旁观

- Perplexity

- 秘塔 ai

- Devv

- 情感陪伴类,社交巨头正谨慎观察

- Character.AI

- 星野

- Replika

- 定制 Agent,商业模式待验证

- ChatGPT GPTs

- 扣子

- Dify

成功落地大模型五要素

- 业务人员的积极

- 对 AI 能力的认知

- 业务团队自带编程能力

- 小处着手

- 老板的耐心

找落地场景的思路:

- 从最熟悉的领域入手

- 尽量找能用语言描述的任务

- 别求大而全。将任务拆解,先解决小任务、小场景

- 让 AI 学最厉害员工的能力,再让 ta 辅助其他员工,实现降本增效

大模型是怎样工作的?

通俗原理

其实,它只是根据上文,猜下一个词(的概率)……

OpenAI 的接口名就叫「completion」,也证明了其只会「生成」的本质。

下面用程序演示「生成下一个字」。你可以自己修改 prompt 试试。还可以使用相同的 prompt 运行多次。

略深一点的通俗原理

训练和推理是大模型工作的两个核心过程。

用人类比,训练就是学,推理就是用。学以致用,如是也。

训练:

- 大模型阅读了人类说过的所有的话。这就是「机器学习」

- 训练过程会把不同 token 同时出现的概率存入「神经网络」文件。保存的数据就是「参数」,也叫「权重」

推理:

- 我们给推理程序若干 token,程序会加载大模型权重,算出概率最高的下一个 token 是什么

- 用生成的 token,再加上上文,就能继续生成下一个 token。以此类推,生成更多文字

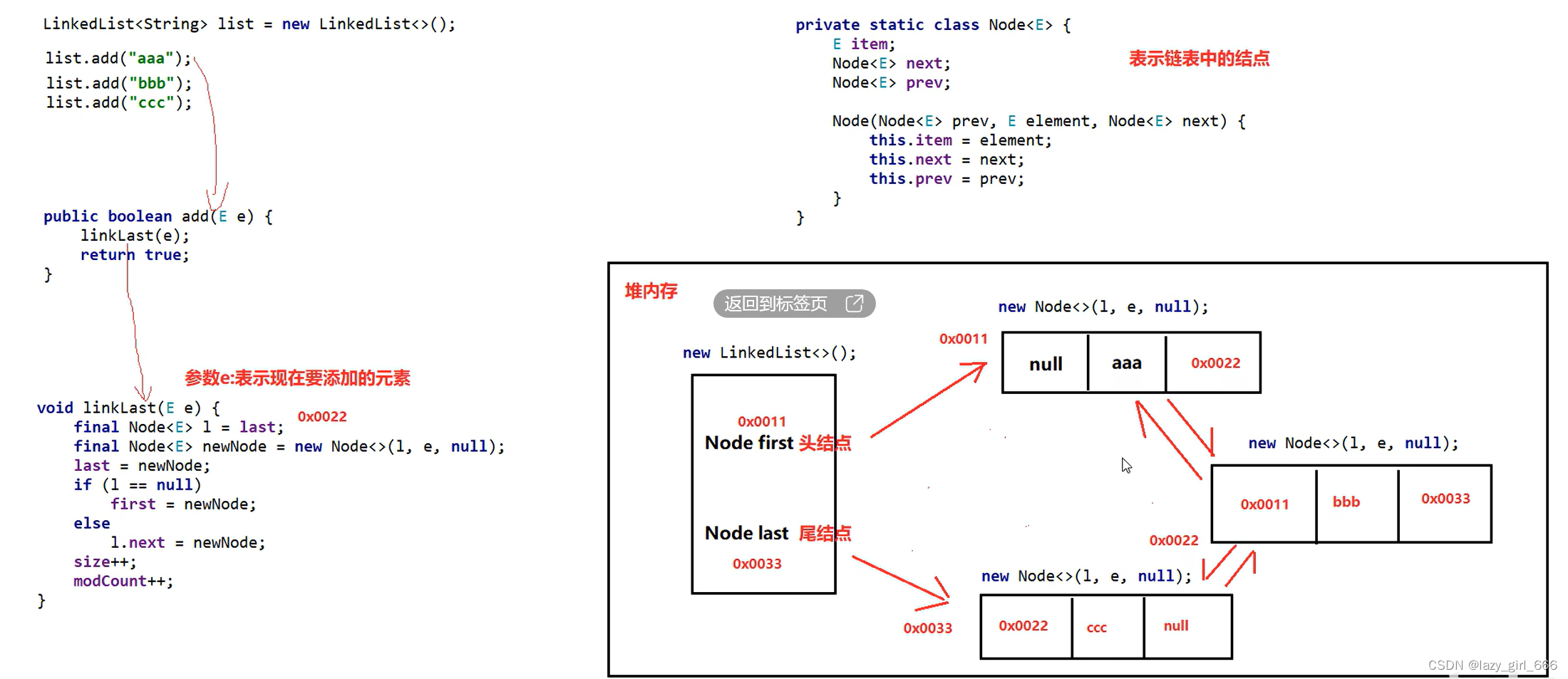

Token 是什么?

- 可能是一个英文单词,也可能是半个,三分之一个

- 可能是一个中文词,或者一个汉字,也可能是半个汉字,甚至三分之一个汉字

- 大模型在开训前,需要先训练一个 tokenizer 模型。它能把所有的文本,切成 token

再深一点点

- 这套生成机制的内核叫「Transformer 架构」

- Transformer 是目前人工智能领域最广泛流行的架构,被用在各个领域

- Transformer 仍是主流,但并不是最先进的

目前只有 transformer 被证明了符合 scaling-law。

用好 AI 的核心心法

- 把 AI 当人看

- 把 AI 当人看

- 把 AI 当人看

大模型应用产品架构

Agent 模式还太超前,Copilot 是当前主流。

实现 Copilot 的主流架构是多 Agent 架构

- 模仿人做事,将业务拆成工作流(workflow、SOP、pipeline)

- 每个 Agent 负责一个工作流节点

大模型应用技术架构

纯 Prompt

- Prompt 是操作大模型的唯一接口

- 当人看:你说一句,ta 回一句,你再说一句,ta 再回一句……

Agent + Function Calling

- Agent:AI 主动提要求

- Function Calling:AI 要求执行某个函数

- 当人看:你问 ta「我明天去杭州出差,要带伞吗?」,ta 让你先看天气预报,你看了告诉 ta,ta 再告诉你要不要带伞

RAG(Retrieval-Augmented Generation)

- Embeddings:把文字转换为更易于相似度计算的编码。这种编码叫向量

- 向量数据库:把向量存起来,方便查找

- 向量搜索:根据输入向量,找到最相似的向量

- 当人看:考试答题时,到书上找相关内容,再结合题目组成答案,然后,就都忘了

Fine-tuning(精调/微调)

当人看:努力学习考试内容,长期记住,活学活用。

如何选择技术路线

面对一个需求,如何开始,如何选择技术方案?下面是个不严谨但常用思路。

其中最容易被忽略的,是准备测试数据

值得尝试 Fine-tuning 的情况:

- 提高模型输出的稳定性

- 用户量大,降低推理成本的意义很大

- 提高大模型的生成速度

- 需要私有部署

如何选择基础模型

划重点:没有最好的大模型,只有最适合的大模型

基础模型选型,合规和安全是首要考量因素。

然后用测试数据,在可以选择的模型里,做测试,找出最合适的。

为什么不要依赖榜单?

- 榜单已被应试教育污染。唯一值得相信的榜单:LMSYS Chatbot Arena Leaderboard

- 榜单体现的是整体能力。放到一件具体事情上,排名低的可能反倒更好

- 榜单体现不出成本差异