有时通过selenium打开网站时,发现有些网站需要扫码登录,就很头疼,导致爬虫进展不下去。

如果继续想使用selenium进行数据抓取,下一步应该怎么办呢?

步骤一:创建文件夹

在电脑的D盘或者F盘或者合适的盘创建一个文件夹。

例如:在D盘创建了一个名为“AutomationProfile”的文件夹,路径为 D:\AutomationProfile

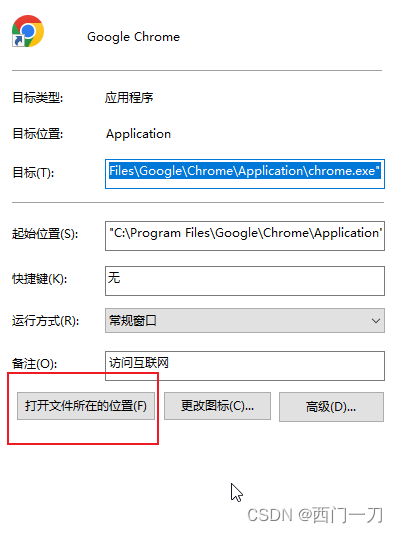

步骤二:找到谷歌浏览器路径

谷歌浏览器快捷方式点击右键,选择属性,打开文件所在位置

步骤三:在谷歌浏览器路径下打开命令提示符

在谷歌浏览器路径下打开cmd窗口

步骤四:输入指令

cmd窗口中输入:chrome.exe --remote-debugging-port=9527 --user-data-dir=“D:\AutomationProfile” ,并回车。

这句代码的意思是启动 chrome浏览器 的调试模式。

- user-data-dir=“D:\AutomationProfile” 其中的 D:\AutomationProfile 就是刚才新创建文件夹的路径。

- 其中 9527 为端口号,可自行指定。

如果成功,就会看到已经打开新的浏览器窗口。

步骤五:运行代码

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from time import sleep

from selenium.webdriver.common.by import By

options = Options()

options.add_experimental_option("debuggerAddress", "127.0.0.1:9527")

bro = webdriver.Chrome(options=options)

url = 'https://www.baidu.com'

bro.get(url)