数据库管理196期 2024-05-28

- 数据库管理-第196期 实战RDMA(20240528)

- 1 环境

- 2 操作系统配置

- 3 配置NVMe over RDMA

- 4 挂载磁盘

- 处理并挂载磁盘:

- 5 RDMA性能测试

- 6 iSCSI部署

- 7 iSCSI性能测试

- 8 性能对比

- 总结

数据库管理-第196期 实战RDMA(20240528)

作者:胖头鱼的鱼缸(尹海文)

Oracle ACE Associate: Database(Oracle与MySQL)

PostgreSQL ACE Partner

青学会(青年数据库学习互助会)外部顾问

10年数据库行业经验,现主要从事数据库服务工作

拥有OCM 11g/12c/19c、MySQL 8.0 OCP、Exadata、CDP等认证

墨天轮MVP、认证技术专家、年度墨力之星,ITPUB认证专家、专家百人团成员,OCM讲师,PolarDB开源社区技术顾问,OceanBase观察团成员

圈内拥有“总监”、“保安”、“国产数据库最大敌人”等称号,非著名社恐(社交恐怖分子)

公众号:胖头鱼的鱼缸;CSDN:胖头鱼的鱼缸(尹海文);墨天轮:胖头鱼的鱼缸;ITPUB:yhw1809。

除授权转载并标明出处外,均为“非法”抄袭

本期使用最新的Oracle Linux 8.9来做测试,这里也使用VMware Workstation Pro 17.5.0来做测试,基于Soft-RoCE进行演示。

1 环境

具体虚拟机配置如下:

| 主机名 | IP地址 | 内存 | 本机磁盘 | 存储磁盘 | 操作系统版本 |

|---|---|---|---|---|---|

| ol8-app | 10.10.10.51 | 2G | 20G | - | Oracle Linux 8.9 |

| ol8-storage | 10.10.10.52 | 8G | 20G | 10G | Oracle Linux 8.9 |

2 操作系统配置

#关闭防火墙

systemctl stop firewalld.service

systemctl disable firewalld.service

#关闭SELinux

sed -i 's/^SELINUX=enforcing$/SELINUX=disabled/' /etc/selinux/config

setenforce 0

#配置hosts

cat >> /etc/hosts <<EOF

10.10.10.51 ol8-app

10.10.10.52 ol8-storage

EOF

#安装NVMe工具

dnf -y install nvme-cli

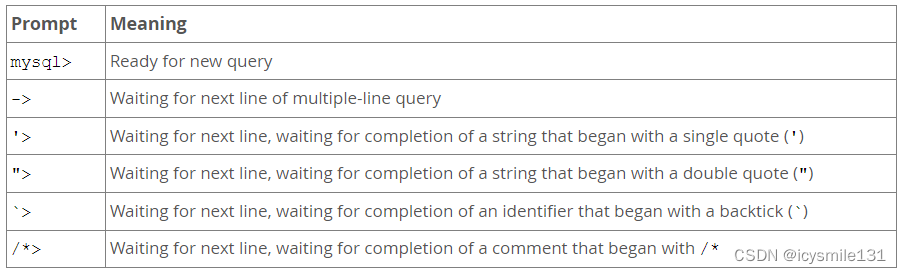

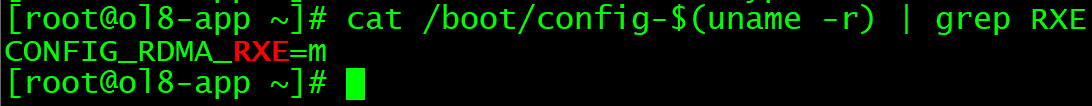

#检查内核RDMA支持

cat /boot/config-$(uname -r) | grep RXE

y或m代表支持

#安装RDMA软件

dnf -y install rdma-core libibverbs-utils libibverbs librdmacm libibumad

#配置网卡RDMA

rdma link add rxe_0 type rxe netdev ens160

##其中rex_0为配置RDMA设备名,ens160则是物理网卡名称

#检查网卡RDMA配置

rdma link

3 配置NVMe over RDMA

在主机ol8-storage操作:

#配置RDMA网卡

rdma link add rxe_0 type rxe netdev ens160

#加载RXE与NVMe模块

modprobe rdma_rxe

modprobe nvmet

modprobe nvmet-rdma

modprobe nvme-rdma

#创建NVMe子系统

mkdir /sys/kernel/config/nvmet/subsystems/nvme-subsys01

cd /sys/kernel/config/nvmet/subsystems/nvme-subsys01

#允许所有主机访问

echo 1 > attr_allow_any_host

#创建namespace

mkdir namespaces/10

cd namespaces/10

#指定对应磁盘并启用

echo -n /dev/nvme0n2> device_path

echo 1 > enable

#创建端口

mkdir /sys/kernel/config/nvmet/ports/1

cd /sys/kernel/config/nvmet/ports/1

echo "10.10.10.52" > addr_traddr

#配置模式、端口及IPv4

echo rdma > addr_trtype

echo 4420 > addr_trsvcid

echo ipv4 > addr_adrfam

#创建软连接映射端口与磁盘

ln -s /sys/kernel/config/nvmet/subsystems/nvme-subsys01 /sys/kernel/config/nvmet/ports/1/subsystems/nvme-subsys01

#检查端口

dmesg -T| grep "enabling port"

4 挂载磁盘

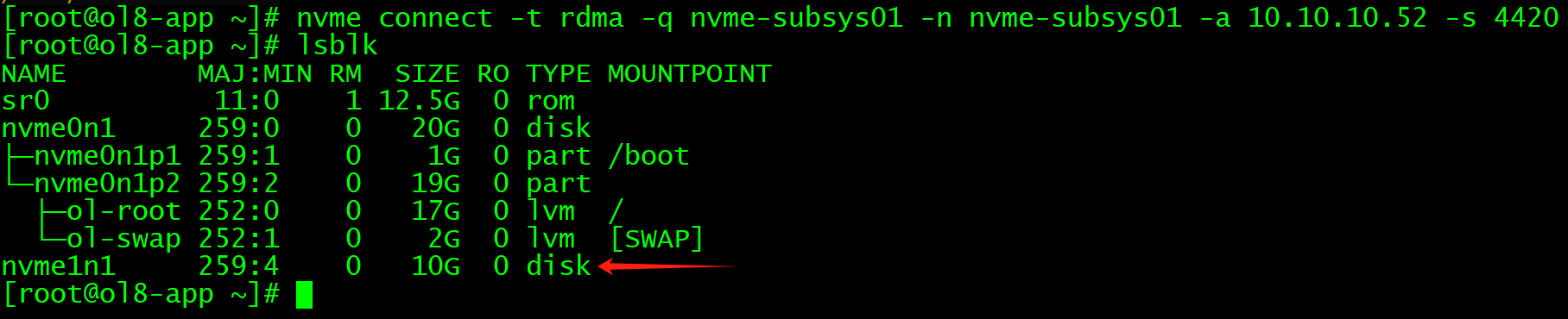

在主机ol8-app操作:

#配置RDMA网卡

rdma link add rxe_0 type rxe netdev ens160

#加载NVMe模块

modprobe nvmet

modprobe nvmet-rdma

modprobe nvme-rdma

#搜索磁盘

nvme discover -t rdma -q nvme-subsys01 -a 10.10.10.52 -s 4420

#连接磁盘

nvme connect -t rdma -q nvme-subsys01 -n nvme-subsys01 -a 10.10.10.52 -s 4420

#如需取消挂载:

nvme disconnect -n nvme-subsys01

#如有多块磁盘则重复第三节中的部分操作

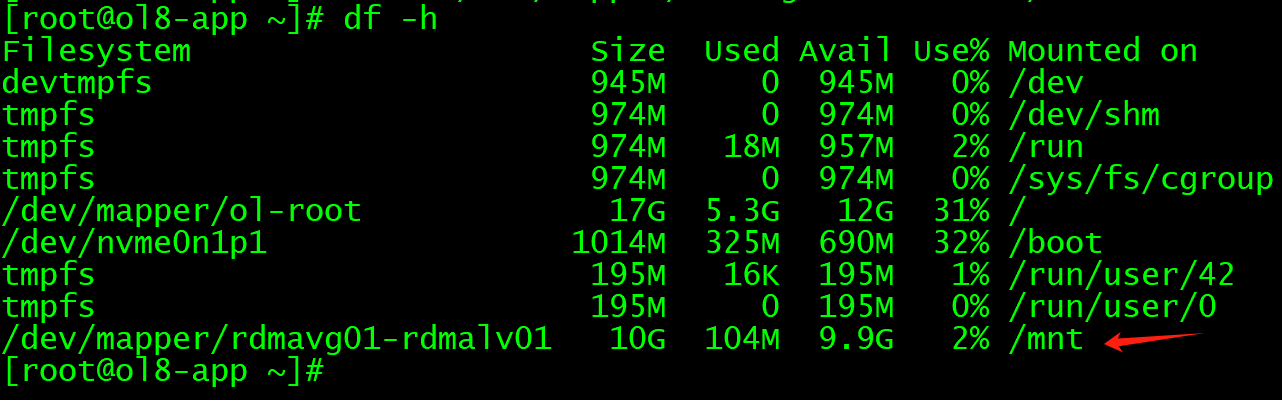

处理并挂载磁盘:

pvcreate /dev/nvme1n1

vgcreate rdmavg01 /dev/nvme1n1

lvcreate -l 100%VG -n rdmalv01 rdmavg01

mkfs.xfs /dev/mapper/rdmavg01-rdmalv01

mount /dev/mapper/rdmavg01-rdmalv01 /mnt

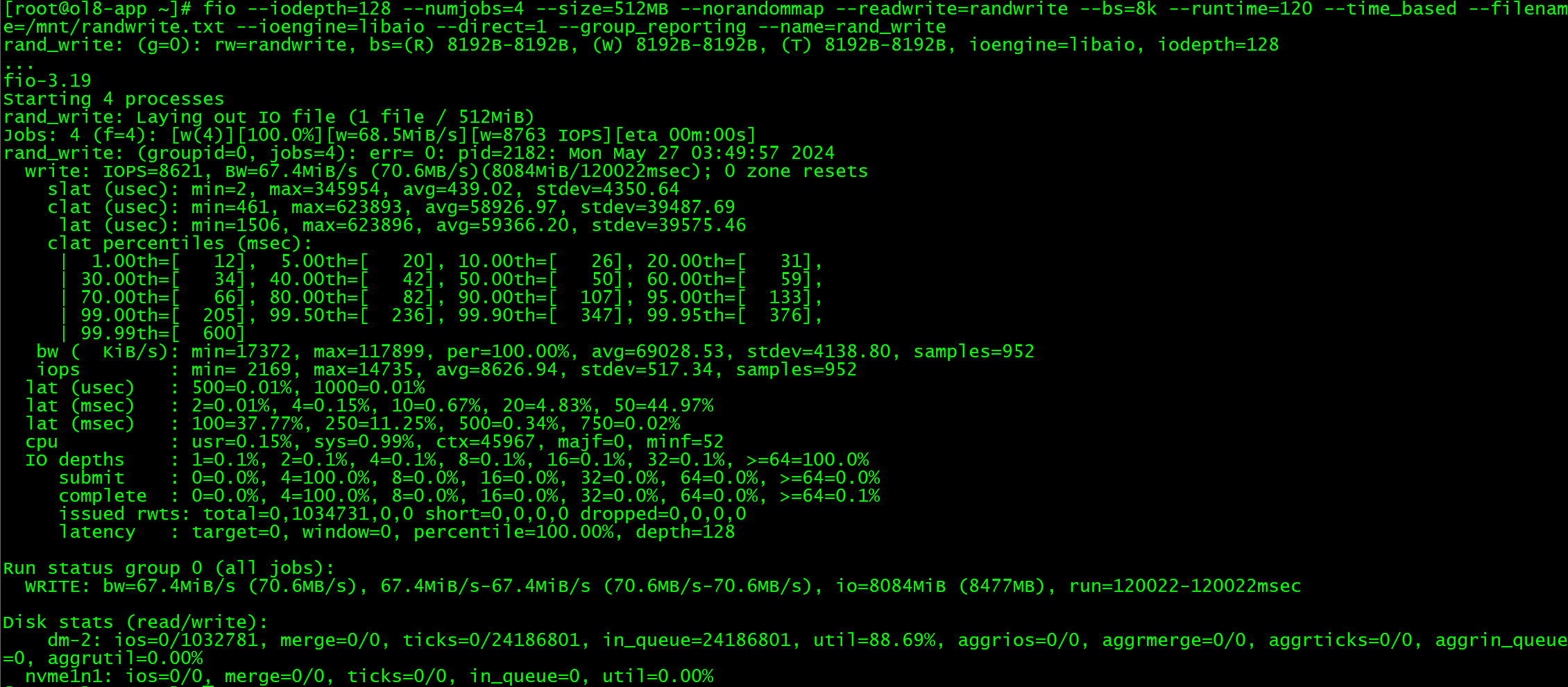

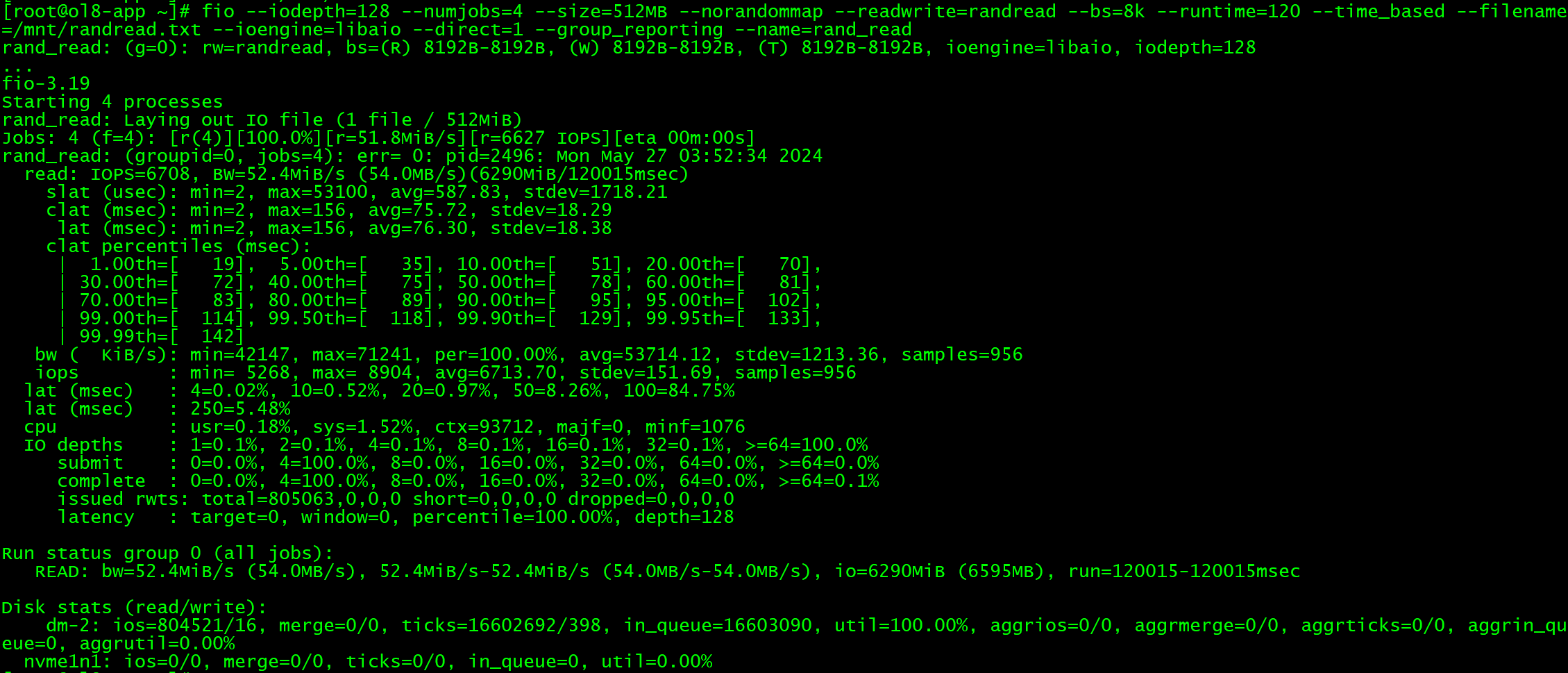

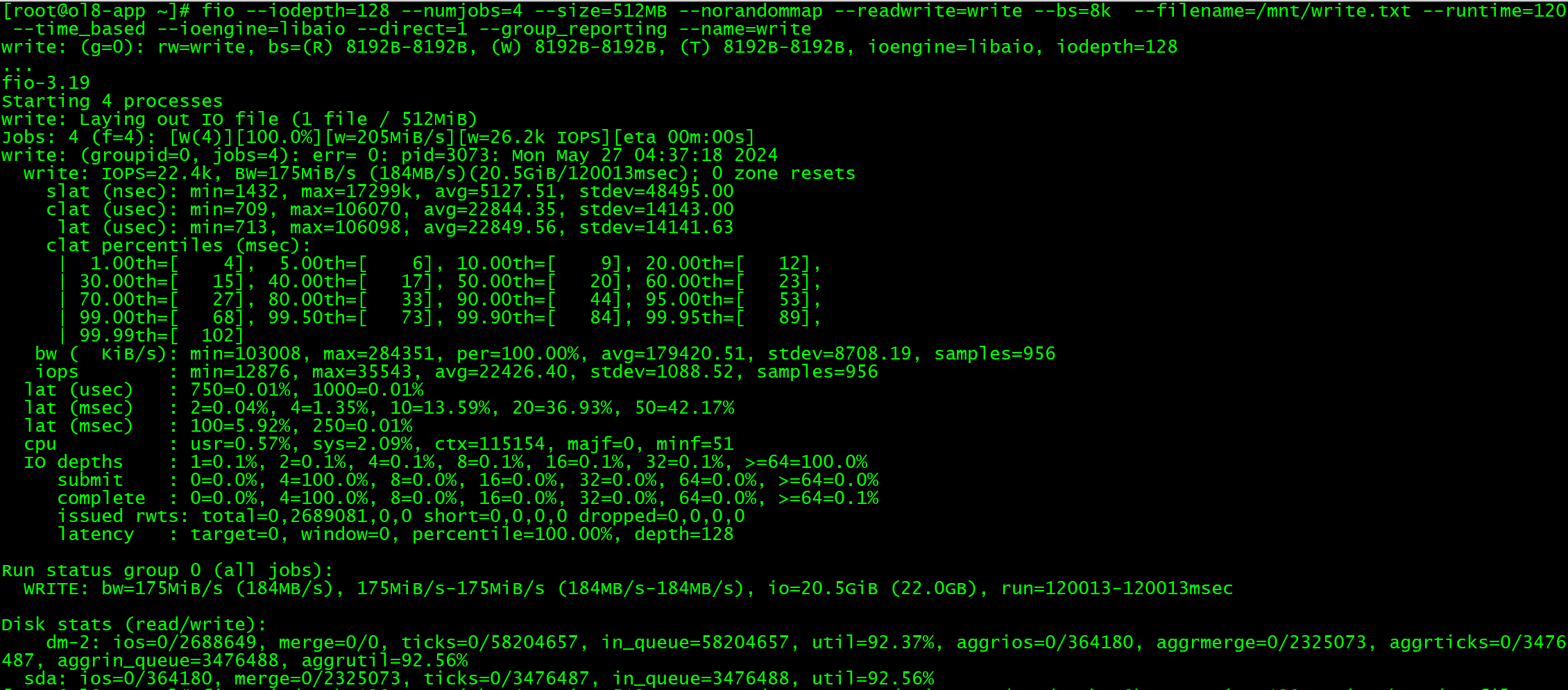

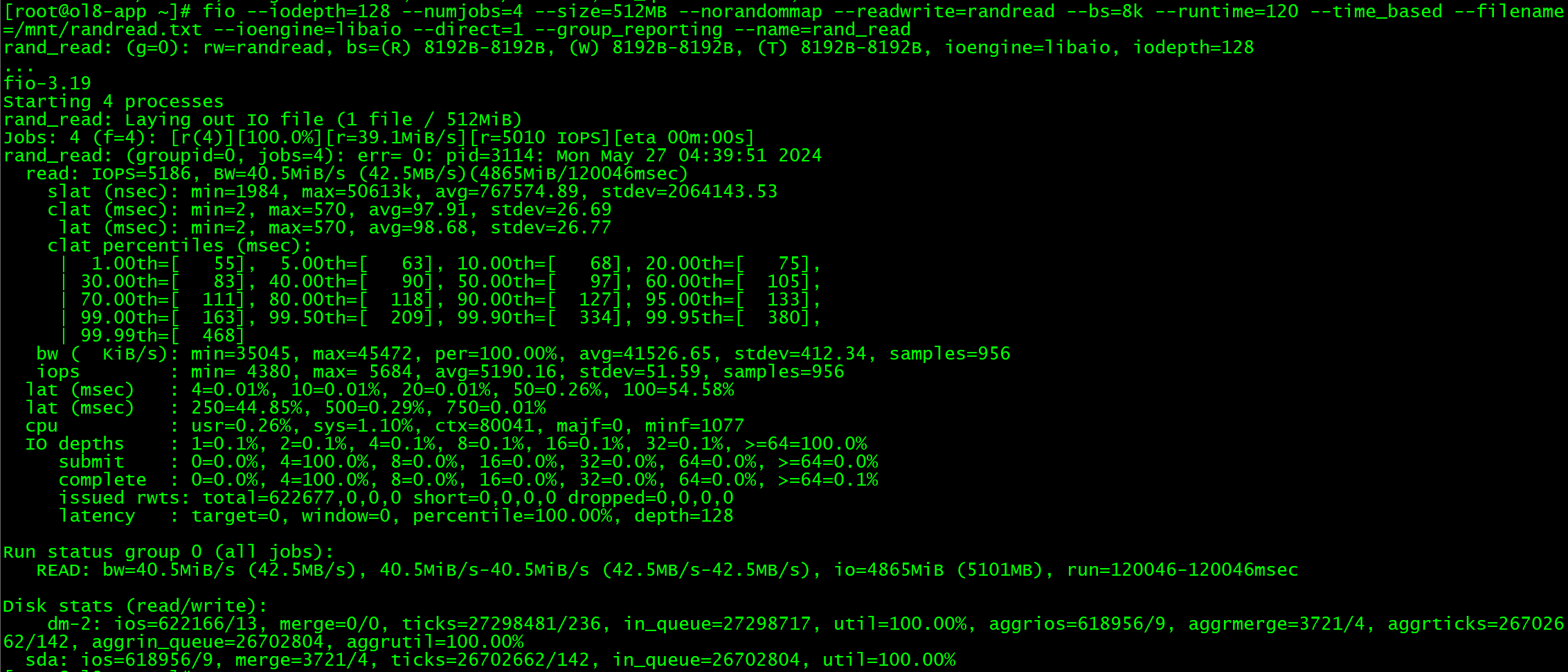

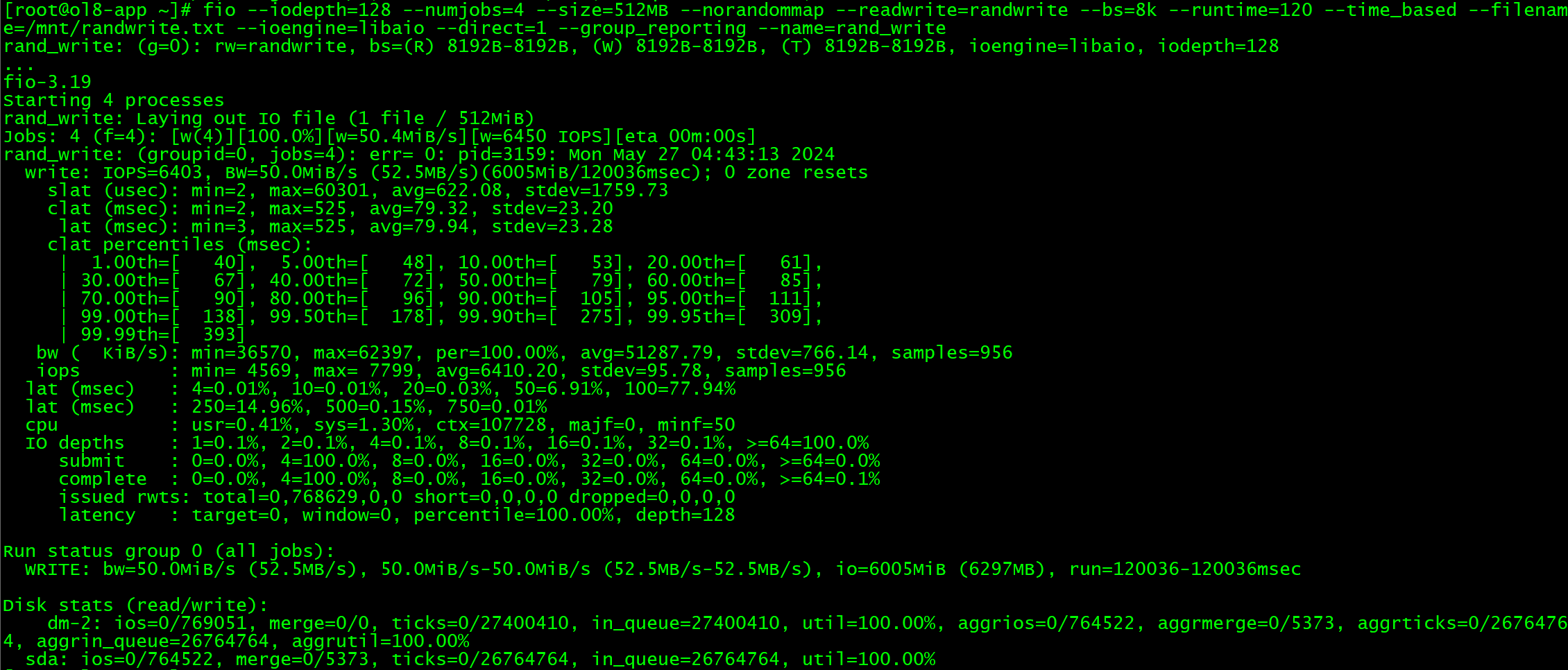

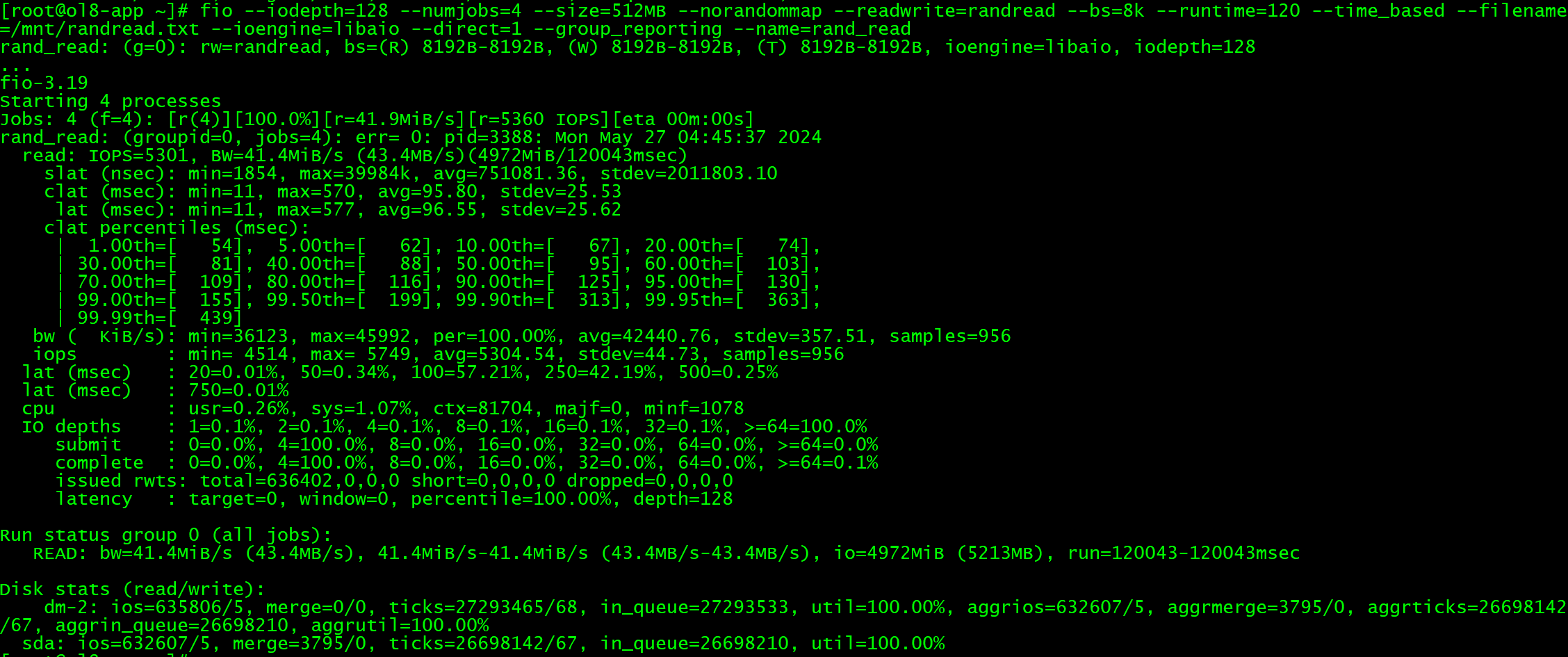

5 RDMA性能测试

这里在源端和目标端使用fio分别进行针对数据库8K块的测试,先通过fio写满磁盘1次,再进行测试:

#顺序写

fio --iodepth=128 --numjobs=4 --size=512MB --norandommap --readwrite=write --bs=8k --filename=/mnt/write.txt --runtime=120 --time_based --ioengine=libaio --direct=1 --group_reporting --name=write

#顺序读

fio --iodepth=128 --numjobs=4 --size=512MB --norandommap --readwrite=read --bs=8k --filename=/mnt/read.txt --runtime=120 --time_based --ioengine=libaio --direct=1 --group_reporting --name=read

#随机写

fio --iodepth=128 --numjobs=4 --size=512MB --norandommap --readwrite=randwrite --bs=8k --runtime=120 --time_based --filename=/mnt/randwrite.txt --ioengine=libaio --direct=1 --group_reporting --name=rand_write

#随机读

fio --iodepth=128 --numjobs=4 --size=512MB --norandommap --readwrite=randread --bs=8k --runtime=120 --time_based --filename=/mnt/randread.txt --ioengine=libaio --direct=1 --group_reporting --name=rand_read

6 iSCSI部署

在主机ol8-storage操作:

#安装targetcli(iSCSI相关软件默认安装)

dnf -y install targetcli

#删除逻辑卷

lvremove /dev/mapper/rdmavg01-rdmalv01

vgremove rdmavg01

pvremove /dev/nvme0n2

targetcli #进入终端

> cd /backstores/block

> create slave /dev/nvme0n2 #创建并制定共享磁盘

> cd /iscsi

> create iqn.2024-05.com.iscsi.www:oracle #创建iqn标签,需要全网唯一

> cd iqn.2024-05.com.iscsi.www:oracle/tpg1/acls

> create iqn.2024-05.com.iscsi.www:oracle #创建ACL访问规则

> cd /iscsi/iqn.2024-05.com.iscsi.www:oracle/tpg1/luns

> create /backstores/block/slave

> exit

#指定iqn标签,与ACL制定名称一致

echo "InitiatorName=iqn.2024-05.com.iscsi.www:oracle">/etc/iscsi/initiatorname.iscsi

#启动iSCSI相关服务

systemctl restart iscsi

systemctl restart iscsid

systemctl start target.service

systemctl enable target.service

在主机ol8-app操作:

#指定iqn标签,与ACL制定名称一致

echo "InitiatorName=iqn.2024-05.com.iscsi.www:oracle">/etc/iscsi/initiatorname.iscsi

#搜索并连接磁盘

iscsiadm -m discovery -t st -p 10.10.10.52

iscsiadm -m node -T iqn.2024-05.com.iscsi.www:oracle --login

pvcreate /dev/sda

vgcreate iscsivg01 /dev/sda

lvcreate -l 100%VG -n iscsilv01 iscsivg01

mkfs.xfs /dev/mapper/iscsivg01-iscsilv01

mount /dev/mapper/iscsivg01-iscsilv01 /mnt

7 iSCSI性能测试

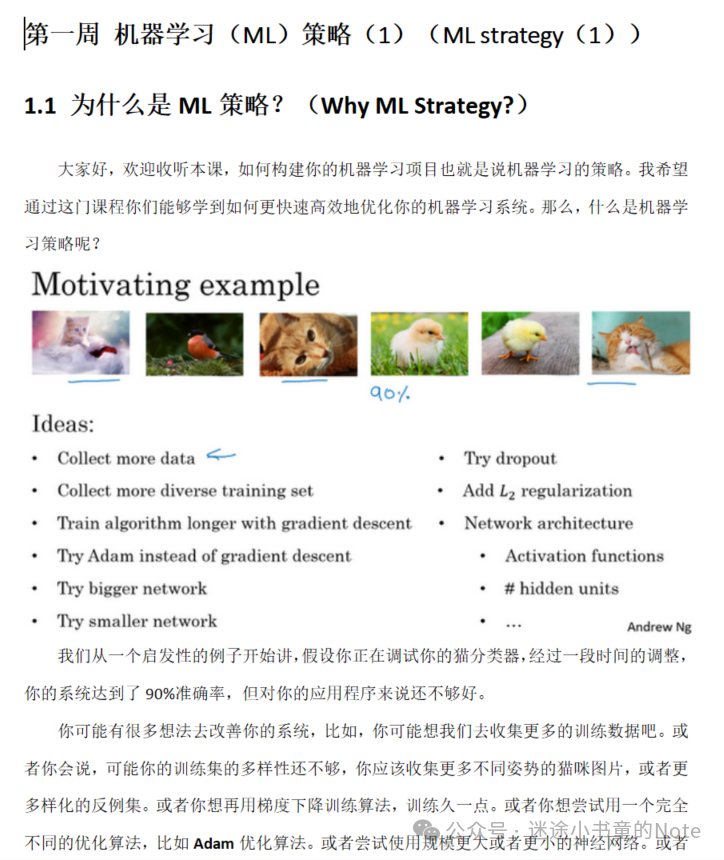

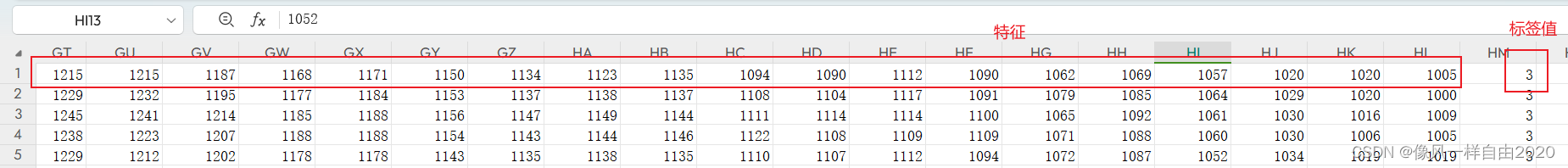

8 性能对比

| 项目 | NVMe over iSCSI TCP/IP | NVMe over Soft-RoCE RDMA | 趋势 |

|---|---|---|---|

| 顺序写MB/s | 184 | 69.2 | ↓ 61.72% |

| 顺序写IOPS | 22.4k | 8450 | ↓ 62.28% |

| 顺序读MB/s | 42.5 | 56 | ↑ 31.76% |

| 顺序读IOPS | 5186 | 6954 | ↑ 34.09% |

| 随机写MB/s | 52.5 | 70.6 | ↑ 34.48% |

| 随机写IOPS | 6403 | 8621 | ↑ 34.64% |

| 随机读MB/s | 43.4 | 54 | ↑ 24.42% |

| 随机读IOPS | 5301 | 6708 | ↑ 26.54% |

这里可以看到,除了在顺序写场景下出现性能下降(不知道为啥,可能是因为硬件条件和虚拟化的原因),但是使用RDMA在其余场景下都能带来24%以上的性能提升。在生产环境使用合适的硬件并优化配置,对网络环境的提升是十分可观的。

总结

虽然在本期测试结果中出现了一些意外,但是整体来看,使用RDMA还是可以显著提升网络性能的。

老规矩,知道写了些啥。