重要参考:

课程链接:https://www.bilibili.com/video/BV1Ci4y1L7ZZ

讲义链接:Introduction · Autolabor-ROS机器人入门课程《ROS理论与实践》零基础教程

8.6.1 传感器_激光雷达简介

激光雷达是现今机器人尤其是无人车领域及最重要、最关键也是最常见的传感器之一,是机器人感知外界的一种重要手段。

概念

激光雷达(LiDAR),英文全称为:Light Detection And Ranging,即光探测与测量。

原理

激光雷达可以发射激光束,光束照射到物体上,再反射回激光雷达,可以通过三角法测距或TOF测距计算出激光雷达与物体的距离。甚至也可以通过测量反射回来的信号中的某些特性而确定物体特征,比如:物体的材质。

注意:如果物体表面光滑(比如镜子),光束照射后产生镜面反射,可能无法捕获返回的激光而出现识别失误的情况。

优点

激光雷达在测距方面精准(激光雷达的测量精度可达厘米级)、高效,是机器人测距的不二之选。

-

具有极高的分辨率:激光雷达工作于光学波段,频率比微波高2~3个数量级以上,因此,与微波雷达相比,激光雷达具有极高的距离分辨率、角分辨率和速度分辨率;

-

抗干扰能力强:激光波长短,可发射发散角非常小(μrad量级)的激光束,多路径效应小(不会形成定向发射与微波或者毫米波产生多路径效应),可探测低空/超低空目标;

-

获取的信息量丰富:可直接获取目标的距离、角度、反射强度、速度等信息,生成目标多维度图像;

-

可全天时工作:激光主动探测,不依赖于外界光照条件或目标本身的辐射特性。它只需发射自己的激光束,通过探测发射激光束的回波信号来获取目标信息。

缺点

激光雷达虽然优点多多,但也存在一些局限性:

- 成本:居高不下

- 环境:易受天气影响(大雾、雨天、烟尘)

- 属性识别能力弱:激光雷达的点云数据是物体的几何外形呈现,无法如同人类视觉一样,分辨物体的物理特征,比如:颜色、纹理...

分类

根据线束数量的多少,激光雷达可分为单线束激光雷达与多线束(4线、8线、16线、32线、64线)激光雷达。单线激光雷达扫描一次只产生一条扫描线, 其所获得的数据为2D数据,因此无法区别有关目标物体的3D信息。多线束激光雷达就是将多个横向扫描结果纵向叠加,从而获得3D数据,当然,线束越多,纵向的垂直视野角度越大。

8.6.2 传感器_雷达使用

思岚A1激光雷达(下图)是一款性价比较高的单线激光雷达。

使用流程如下:

- 硬件准备;

- 软件安装;

- 启动并测试。

1.硬件准备

1.雷达连接上位机

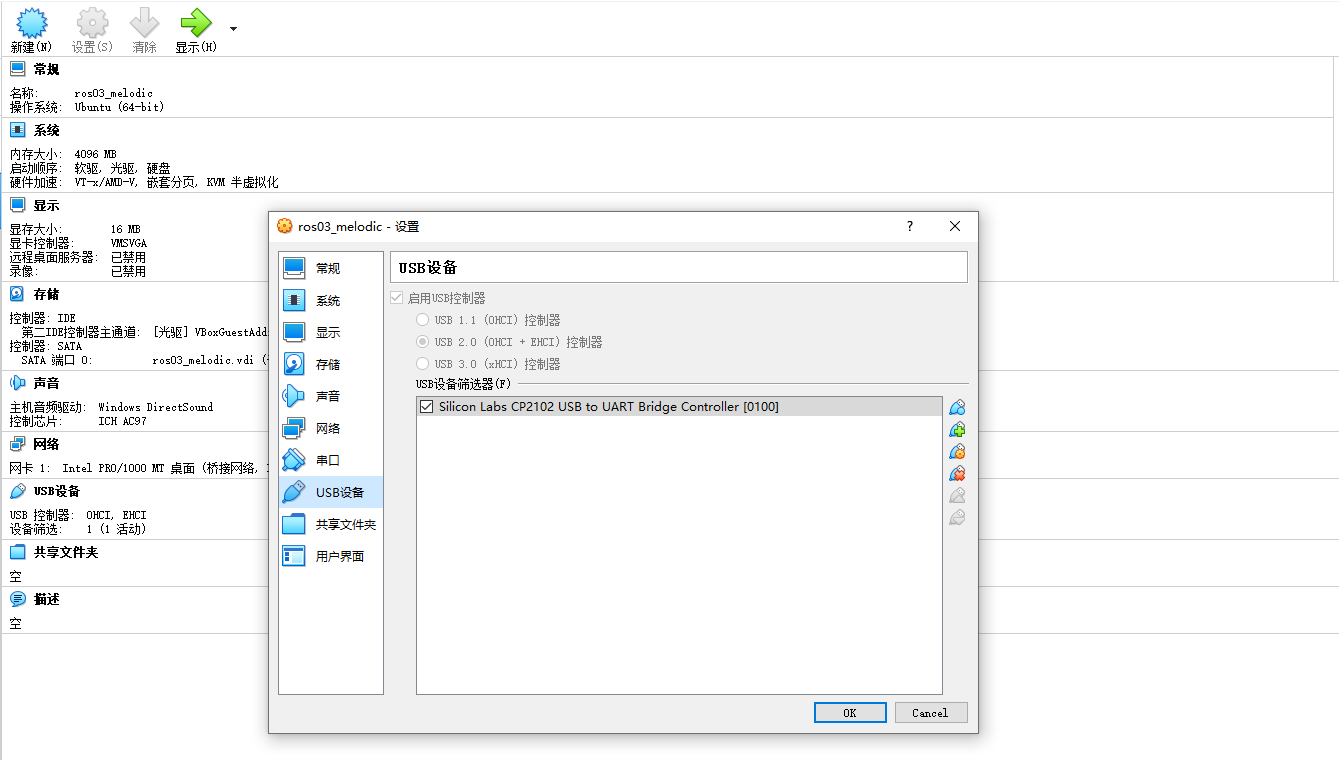

当前直接连接树莓派即可,如果连接的是虚拟机,注意VirtualBox或VMware的相关设置。

2.确认当前的 USB 转串口终端并修改权限

USB查看命令:

ll /dev/ttyUSB*授权(将当前用户添加进dialout组,与arduino类似):

sudo usermod -a -G dialout your_user_name不要忘记重启,重启之后才可以生效。

2.软件安装

进入工作空间的src目录,下载相关雷达驱动包,下载命令如下:

git clone https://github.com/slamtec/rplidar_ros返回工作空间,调用 catkin_make 编译,并 source ./devel/setup.bash ,为端口设置别名(将端口 ttyUSBX 映射到 rplidar):

cd src/rplidar_ros/scripts/

./create_udev_rules.sh3.启动并测试

1.rplidar.launch文件准备

首先确认端口,编辑 rplidar.launch 文件

<launch>

<node name="rplidarNode" pkg="rplidar_ros" type="rplidarNode" output="screen">

<param name="serial_port" type="string" value="/dev/rplidar"/>

<param name="serial_baudrate" type="int" value="115200"/><!--A1/A2 -->

<!--param name="serial_baudrate" type="int" value="256000"--><!--A3 -->

<param name="frame_id" type="string" value="laser"/>

<param name="inverted" type="bool" value="false"/>

<param name="angle_compensate" type="bool" value="true"/>

</node>

</launch>frame_id 也可以修改,当使用URDF显示机器人模型时,需要与 URDF 中雷达 id 一致

2.终端中执行 launch 文件

终端工作空间下输入命令:

roslaunch rplidar_ros rplidar.launch如果异常,雷达开始旋转

3.rviz中订阅雷达相关消息

启动 rviz,添加 LaserScan 插件:

注意: Fixed Frame 设置需要参考 rplidar.launch 中设置的 frame_id,Topic 一般设置为 /scan,Size 可以自由调整。

8.6.3 传感器_相机简介

相机是机器人系统中另一比较重要的传感器,与雷达类似的,相机也是机器人感知外界环境的重要手段之一,并且随着机器视觉、无人驾驶等技术的兴起,相机在物体识别、行为识别、SLAM中等都有着广泛的应用。

根据工作原理的差异可以将相机大致划分成三类:单目相机、双目相机与深度相机。

1.单目相机

单目相机是将三维世界二维化,它是将拍摄场景在相机的成像平面上留下一个投影,静止状态下是无法通过单目相机确定深度信息。向如下动图展示的一样,在二维图形中,甚至不能根据图片中物体的大小来判断物体距离。

2.双目相机

识破上面的“骗局”只需要移动单目相机,再换一个角度拍摄一张照片即可,当角度切换后,可以将两张照片组合还原为一个立体的三维世界。

双目相机的原理也是如此,双目相机是由两个单目相机组成的,即便在静止状态下,也可以生成两张图片,两个单目相机之间存在一定的距离也称之为基线,通过这个基线以及两个单目项目分别生成的图片,可以来估算每个象素的空间位置。

3.深度相机

深度相机也称之为RGB-D相机,顾名思义,深度相机也可以用于获取物体深度信息。深度相机一般基于结构光或ToF(Time-of-Flight)原理实现测距。

前者是通过近红外激光器,将具有一定结构特征的光线投射到被拍摄物体上,再由专门的红外摄像头进行采集。光线照射到不同深度的物体上时,会采集到不同的图像相位信息,然后通过运算单元将这种结构的变化换算成深度信息,后者实现则类似于激光雷达,也是根据光线的往返时间来计算深度信息。

8.6.4 传感器_相机使用

使用流程如下:

- 硬件准备;

- 软件安装;

- 启动并测试。

1.硬件准备

当前直接连接树莓派即可,如果连接的是虚拟机,注意VirtualBox或VMware的相关设置。

2.软件准备

安装USB摄像头软件包,命令如下:

sudo apt-get install ros-ROS版本-usb-cam或者也可以从 github 直接下载源码:

git clone https://github.com/ros-drivers/usb_cam.git3.测试

1.launch文件准备

在软件包中内置了测试用的launch文件,内容如下:

<launch>

<node name="usb_cam" pkg="usb_cam" type="usb_cam_node" output="screen" >

<param name="video_device" value="/dev/video0" />

<param name="image_width" value="640" />

<param name="image_height" value="480" />

<param name="pixel_format" value="yuyv" />

<param name="camera_frame_id" value="usb_cam" />

<param name="io_method" value="mmap"/>

</node>

<node name="image_view" pkg="image_view" type="image_view" respawn="false" output="screen">

<remap from="image" to="/usb_cam/image_raw"/>

<param name="autosize" value="true" />

</node>

</launch>节点 usb_cam 用于启动相机,节点 image_view 以图形化窗口的方式显示图像数据,需要查看相机的端口并修改 usb_cam 中的 video_device 参数,并且如果将摄像头连接到了树莓派,且通过 ssh 远程访问树莓派的话,需要注释 image_view 节点,因为在终端中无法显示图形化界面。

2.启动launch文件

roslaunch usb_cam usb_cam-test.launch3.rviz显示

启动 rviz,添加 Image 插件:

8.6.5 传感器_集成

之前已经分别介绍了底盘、雷达、相机等相关节点的安装、配置以及使用,不过之前的实现还存在一些问题:

1.机器人启动时,需要逐一启动底盘控制、相机与激光雷达,操作冗余;

2.如果只是简单的启动这些节点,那么在 rviz 中显示时,会发现出现了TF转换异常,比如参考坐标系设置为odom时,雷达信息显示失败。

本节将介绍如何把传感器(激光雷达与相机)集成以解决上述问题,所谓集成主要是优化底盘、雷达、相机相关节点的启动并通过坐标变换实现机器人底盘与里程计、雷达和相机的关联,实现步骤如下:

- 编写用于集成的 launch 文件;

- 发布TF坐标变换;

- 启动并测试。

1.launch文件

新建功能包:

catkin_create_pkg mycar_start roscpp rospy std_msgs ros_arduino_python usb_cam rplidar_ros功能包下创建launch文件夹,launch文件夹中新建launch文件,文件名自定义。

内容如下:

<!-- 机器人启动文件:

1.启动底盘

2.启动激光雷达

3.启动摄像头

-->

<launch>

<include file="$(find ros_arduino_python)/launch/arduino.launch" />

<include file="$(find usb_cam)/launch/usb_cam-test.launch" />

<include file="$(find rplidar_ros)/launch/rplidar.launch" />

</launch>2.坐标变换

如果启动时加载了机器人模型,且模型中设置的坐标系名称与机器人实体中设置的坐标系一致,那么可以不再添加坐标变换,因为机器人模型可以发布坐标变换信息,如果没有启动机器人模型,就需要自定义坐标变换实现了,继续新建launch文件。

内容如下:

<!-- 机器人启动文件:

当不包含机器人模型时,需要发布坐标变换

-->

<launch>

<include file="$(find mycar_start)/launch/start.launch" />

<node name="camera2basefootprint" pkg="tf2_ros" type="static_transform_publisher" args="0.08 0 0.1 0 0 0 /base_footprint /camera_link"/>

<node name="rplidar2basefootprint" pkg="tf2_ros" type="static_transform_publisher" args="0 0 0.1 0 0 0 /base_footprint /laser"/>

</launch>3.测试

最后,就可以启动PC端与树莓派端相关节点并运行查看结果了:

1.树莓派

直接执行上一步的机器人启动launch文件:

roslaunch 自定义包 自定义launch文件2.PC端

启动键盘控制节点:

rosrun teleop_twist_keyboard teleop_twist_keyboard.py还需要启动rviz:

rviz3.结果显示

在rviz中添加laserscan、image等插件,并通过键盘控制机器人运动,查看rviz中的显示结果: