介绍

在金融领域,准确及时的数据收集对于市场分析和投资决策至关重要。股票价格作为金融市场的重要指标之一,通过网络爬虫技术可以高效地从多个网站获取实时股票价格信息。本文将介绍网络爬虫在金融领域中的应用,重点讨论如何利用Scrapy框架和代理IP技术实现股票数据的收集。

技术分析

网络爬虫(Web Crawler)是一种自动化程序,用于从互联网上提取数据。其工作流程包括发送HTTP请求获取网页、解析网页内容并提取所需数据、存储数据供后续分析使用。为了应对目标网站的反爬虫措施,使用代理IP可以有效绕过访问限制。本文将使用Scrapy框架编写爬虫程序,通过爬虫代理提高数据采集效果。

1. Scrapy 框架

Scrapy 是一个开源的爬虫框架,具有高效、灵活和可扩展的特点。它能够处理复杂的网页抓取任务,支持多种数据导出格式,如JSON、CSV和数据库。

2. 代理IP技术

使用代理IP可以隐藏爬虫的真实IP,避免被目标网站封禁。爬虫代理提供了高效稳定的代理服务,通过简单的配置即可实现代理IP的切换。

3. 实现步骤

- 安装Scrapy和所需库

- 创建Scrapy项目和爬虫文件

- 配置爬虫代理

- 编写爬虫代码,抓取股票价格数据

- 解析并存储数据

代码实现

首先,安装Scrapy和PyMongo(用于存储数据到MongoDB):

pip install scrapy pymongo

接下来,创建Scrapy项目和爬虫文件:

scrapy startproject stockcrawler

cd stockcrawler

scrapy genspider stock_spider example.com

在settings.py中配置爬虫代理:

# settings.py

DOWNLOADER_MIDDLEWARES = {

'scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware': 543,

'stockcrawler.middlewares.EinyProxyMiddleware': 544,

}

# 亿牛云爬虫代理加强版***代理IP配置

EINY_PROXY = {

'proxy': 'http://代理IP域名:端口', # 官网 www.16yun.cn

'user': '用户名',

'password': '密码'

}

编写middlewares.py,实现代理中间件:

# middlewares.py

from scrapy import signals

import base64

class EinyProxyMiddleware:

def __init__(self, proxy):

self.proxy = proxy

@classmethod

def from_crawler(cls, crawler):

return cls(

proxy=crawler.settings.get('EINY_PROXY')

)

def process_request(self, request, spider):

request.meta['proxy'] = self.proxy['proxy']

encoded_user_pass = base64.b64encode(

bytes(f"{self.proxy['user']}:{self.proxy['password']}", 'utf-8')

).decode('utf-8')

request.headers['Proxy-Authorization'] = f'Basic {encoded_user_pass}'

编写爬虫代码,抓取股票价格数据:

# stock_spider.py

import scrapy

from pymongo import MongoClient

class StockSpider(scrapy.Spider):

name = "stock_spider"

start_urls = [

'https://finance.yahoo.com/quote/AAPL',

'https://finance.yahoo.com/quote/GOOGL',

'https://finance.yahoo.com/quote/AMZN'

]

def __init__(self):

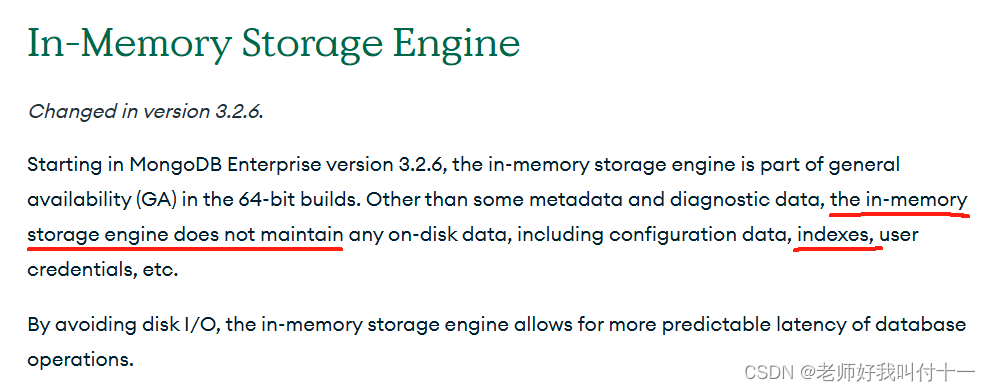

self.client = MongoClient('mongodb://localhost:27017/')

self.db = self.client['financial_data']

self.collection = self.db['stocks']

def parse(self, response):

stock_name = response.xpath('//h1/text()').get()

stock_price = response.xpath('//span[@data-reactid="32"]/text()').get()

if stock_name and stock_price:

stock_data = {

'name': stock_name,

'price': stock_price,

'url': response.url

}

self.collection.insert_one(stock_data)

yield stock_data

结论

通过Scrapy框架结合代理IP技术,可以高效地从多个网站收集股票价格数据。这些数据在金融市场分析和投资决策中具有重要价值。本文介绍了从技术分析到实际代码实现的完整过程,希望能为读者提供有价值的参考。利用先进的爬虫技术和工具,可以大大提升数据采集的效率和效果,为金融分析提供坚实的数据基础。