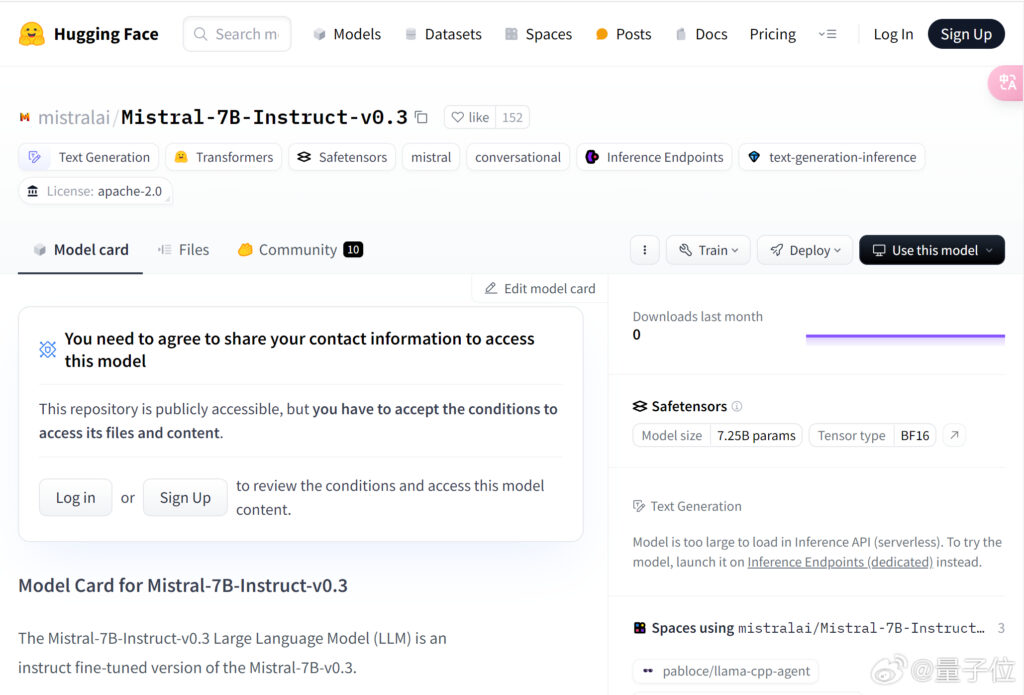

抱抱脸上线了 Mistral-7B-v0.3 的基础版和指令微调版。

相比于Mistral-7B-v0.2,新版本更新如下:

– 词汇量从 32000 扩展到 32768

– 支持 v3 分词器

– 支持函数调用

Mistral-7B-v0.3:网页链接

Mistral-7B-Instruct-v0.3:网页链接

从Hugging Face安装

pip install mistral_inference

从Hugging Face下载

from huggingface_hub import snapshot_download

from pathlib import Path

mistral_models_path = Path.home().joinpath('mistral_models', '7B-Instruct-v0.3')

mistral_models_path.mkdir(parents=True, exist_ok=True)

snapshot_download(repo_id="mistralai/Mistral-7B-Instruct-v0.3", allow_patterns=["params.json", "consolidated.safetensors", "tokenizer.model.v3"], local_dir=mistral_models_path)

Mistral-7B-Instruct-v0.3 模型的性能评估表明,与早期版本相比,该模型有重大改进。该模型已显示出根据用户指令生成连贯且适合上下文的文本的非凡能力。Mistral-7B-Instruct-v0.3 模型在实际测试中优于以前的模型,突出了其处理复杂语言任务的增强能力。例如,该模型可以高效管理多达 72.5 亿个参数,确保高细节和输出精度。但是,需要注意的是,此模型目前缺乏审核机制,这对于在需要审核输出以避免不适当或有害内容的环境中进行部署至关重要。

总之,Mistral-7B-Instruct-v0.3 模型解决了语言理解和生成的挑战;研究人员通过一系列战略改进增强了模型的功能。其中包括扩展词汇表、改进的分词器支持以及创新引入函数调用。Mistral-7B-Instruct-v0.3 模型展示了令人鼓舞的结果,强调了它对各种人工智能驱动应用程序的潜在影响。持续发展和社区参与对于进一步完善这一模式至关重要,特别是在实施必要的安全部署审核机制方面。