目录

引言

为什么要创建虚拟环境,好处在哪里?

源码

我修改的部分

调用本地数据

修改第二层卷积层

引言

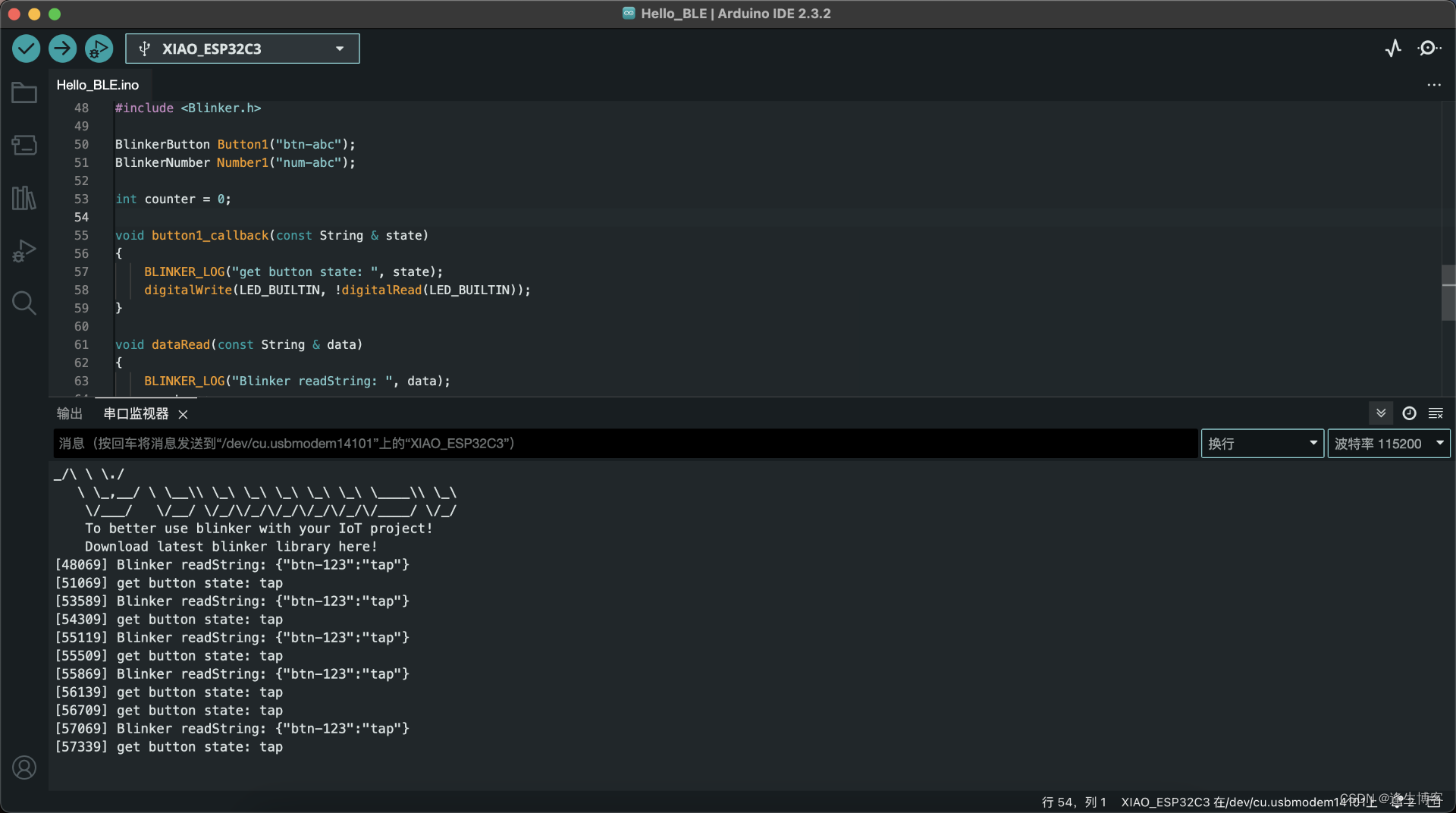

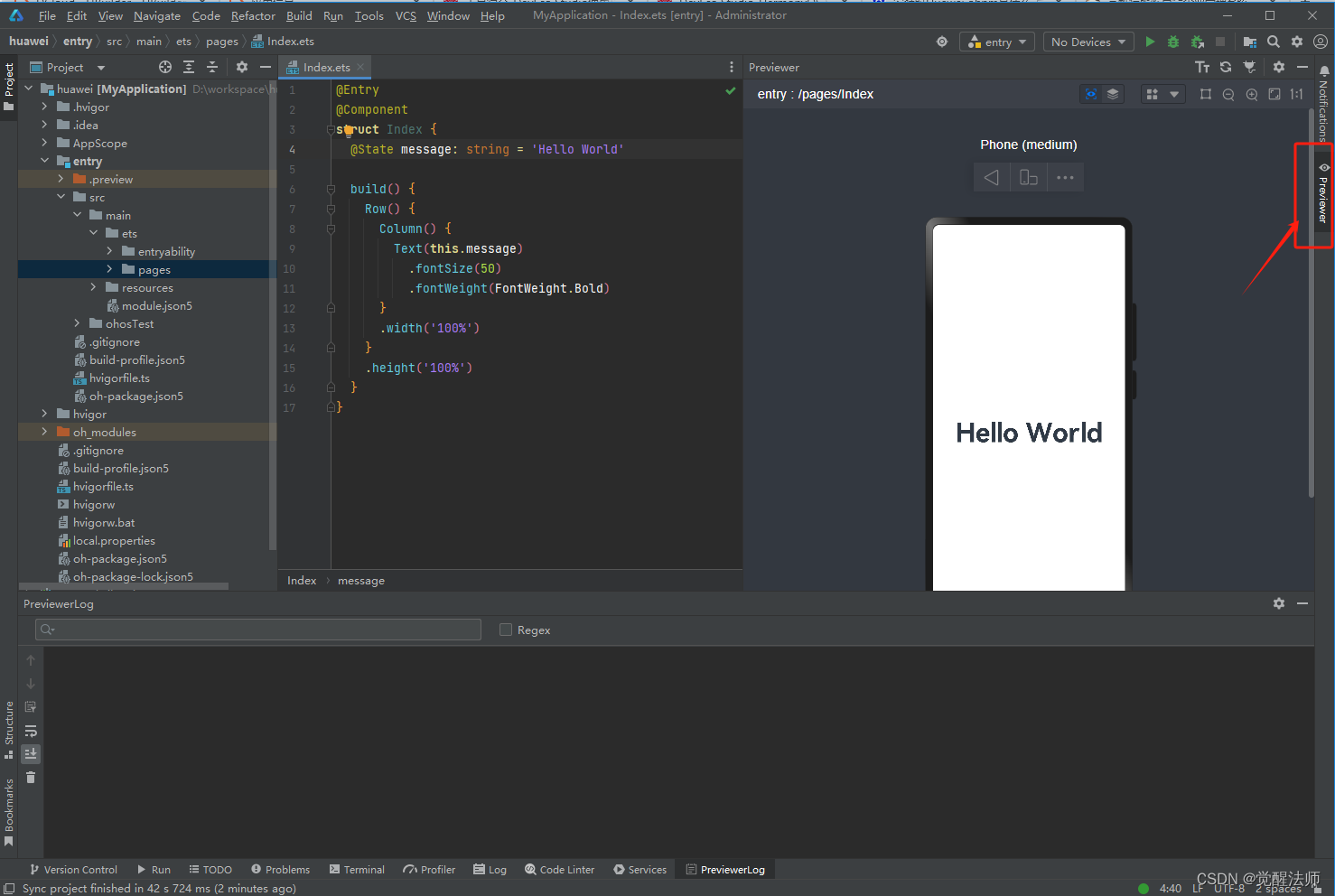

本文是博主为了记录一个好的开源代码而写,下面是代码出处!强烈建议收藏!【深度学习实战—1】:基于Keras的手写数字识别(非常详细、代码开源)

写的非常好,但是复现这篇博客却让我吃了很多苦头, 大家要先下载Anaconda3然后创建一个虚拟环境,在虚拟环境里面主要下载以下三个东西,版本号只要对应好,肯定能运行,其他的库少什么安装什么!如果用显卡跑模型,原博客有提及配置!

| 库 | 版本号 |

|---|---|

| Python版本 | 3.7.3 |

| Keras版本 | 2.4.3 |

| tensorflow版本 | 2.4.0 |

为什么要创建虚拟环境,好处在哪里?

在进行机器学习项目时,我们经常会遇到需要为不同的模型安装不同版本的Python或相关库的情况。这是因为每个模型可能依赖于特定版本的库,这些版本之间可能存在兼容性差异。如果不使用虚拟环境,而是在主环境中直接安装这些库,可能会遇到以下问题:

首先,当你为新的模型安装特定版本的库时,可能会覆盖掉主环境中已经存在的其他模型所需的库版本,导致之前的模型无法正常运行。

其次,不同的Python版本之间也可能存在兼容性问题。如果你直接在主环境中升级或降级Python版本,可能会影响到依赖于特定Python版本的其他项目。

为了避免这些问题,使用虚拟环境变得尤为重要。虚拟环境是一个隔离的Python环境,其中可以安装特定版本的Python和库,而不会影响到主环境或其他虚拟环境。这样,你可以为每个机器学习模型创建一个独立的虚拟环境,并在其中安装所需的Python版本和库版本,从而确保每个模型都能在其特定的环境中稳定运行。

通过这种方法,你可以轻松地管理多个项目,而无需担心库版本冲突或Python版本不兼容的问题。希望这样的解释能帮助大家更好地理解虚拟环境在机器学习项目中的重要性。

源码

import matplotlib.pyplot as plt

import numpy as np

import pandas as pd

from keras.datasets import mnist

from sklearn.metrics import confusion_matrix

import seaborn as sns

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from keras.utils import np_utils

import tensorflow as tf

config = tf.compat.v1.ConfigProto()

config.gpu_options.allow_growth = True

sess = tf.compat.v1.Session(config=config)

# 设定随机数种子,使得每个网络层的权重初始化一致

# np.random.seed(10)

# x_train_original和y_train_original代表训练集的图像与标签, x_test_original与y_test_original代表测试集的图像与标签

(x_train_original, y_train_original), (x_test_original, y_test_original) = mnist.load_data()

# 假设你已经知道mnist.npz文件的路径

# file_path = 'mnist.npz' # 替换为你的mnist.npz文件的实际路径

#

# # 加载npz文件

# with np.load(file_path, allow_pickle=True) as f:

# x_train_original = f['x_train']

# y_train_original = f['y_train']

# x_test_original = f['x_test']

# y_test_original = f['y_test']

"""

数据可视化

"""

# 单张图像可视化

def mnist_visualize_single(mode, idx):

if mode == 0:

plt.imshow(x_train_original[idx], cmap=plt.get_cmap('gray'))

title = 'label=' + str(y_train_original[idx])

plt.title(title)

plt.xticks([]) # 不显示x轴

plt.yticks([]) # 不显示y轴

plt.show()

else:

plt.imshow(x_test_original[idx], cmap=plt.get_cmap('gray'))

title = 'label=' + str(y_test_original[idx])

plt.title(title)

plt.xticks([]) # 不显示x轴

plt.yticks([]) # 不显示y轴

plt.show()

# 多张图像可视化

def mnist_visualize_multiple(mode, start, end, length, width):

if mode == 0:

for i in range(start, end):

plt.subplot(length, width, 1 + i)

plt.imshow(x_train_original[i], cmap=plt.get_cmap('gray'))

title = 'label=' + str(y_train_original[i])

plt.title(title)

plt.xticks([])

plt.yticks([])

plt.show()

else:

for i in range(start, end):

plt.subplot(length, width, 1 + i)

plt.imshow(x_test_original[i], cmap=plt.get_cmap('gray'))

title = 'label=' + str(y_test_original[i])

plt.title(title)

plt.xticks([])

plt.yticks([])

plt.show()

mnist_visualize_multiple(mode=0, start=0, end=4, length=2, width=2)

# 原始数据量可视化

print('训练集图像的尺寸:', x_train_original.shape)

print('训练集标签的尺寸:', y_train_original.shape)

print('测试集图像的尺寸:', x_test_original.shape)

print('测试集标签的尺寸:', y_test_original.shape)

"""

数据预处理

"""

#

# 从训练集中分配验证集

x_val = x_train_original[50000:]

y_val = y_train_original[50000:]

x_train = x_train_original[:50000]

y_train = y_train_original[:50000]

print('======================')

# 打印验证集数据量

print('验证集图像的尺寸:', x_val.shape)

print('验证集标签的尺寸:', y_val.shape)

print('======================')

# 将图像转换为四维矩阵(nums,rows,cols,channels), 这里把数据从unint类型转化为float32类型, 提高训练精度。

x_train = x_train.reshape(x_train.shape[0], 28, 28, 1).astype('float32')

x_val = x_val.reshape(x_val.shape[0], 28, 28, 1).astype('float32')

x_test = x_test_original.reshape(x_test_original.shape[0], 28, 28, 1).astype('float32')

#

# 原始图像的像素灰度值为0-255,为了提高模型的训练精度,通常将数值归一化映射到0-1。

x_train = x_train / 255

x_val = x_val / 255

x_test = x_test / 255

#

print('训练集传入网络的图像尺寸:', x_train.shape)

print('验证集传入网络的图像尺寸:', x_val.shape)

print('测试集传入网络的图像尺寸:', x_test.shape)

# #

# 图像标签一共有10个类别即0-9,这里将其转化为独热编码(One-hot)向量

y_train = np_utils.to_categorical(y_train)

print(y_train[0])

y_val = np_utils.to_categorical(y_val)

y_test = np_utils.to_categorical(y_test_original)

#

# """

# 定义网络模型

# """

#

#

def CNN_model():

model = Sequential()

model.add(Conv2D(filters=16, kernel_size=(5, 5), activation='relu', input_shape=(28, 28, 1))) # 卷积层

model.add(MaxPooling2D(pool_size=(2, 2), strides=(2, 2))) # 池化层

# model.add(Conv2D(filters=32, kernel_size=(5, 5), activation='relu', input_shape=(28, 28, 1))) # 卷积层

model.add(Conv2D(filters=32, kernel_size=(5, 5), activation='relu')) # 卷积层

model.add(MaxPooling2D(pool_size=(2, 2), strides=(2, 2))) # 池化层

model.add(Flatten()) # 平铺层

model.add(Dense(100, activation='relu')) # 全连接层

model.add(Dense(10, activation='softmax')) # 全连接层

print(model.summary())

return model

#

#

# """

# 训练网络

# """

#

model = CNN_model()

# #

# 编译网络(定义损失函数、优化器、评估指标)

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 开始网络训练(定义训练数据与验证数据、定义训练代数,定义训练批大小) 原来20

train_history = model.fit(x_train, y_train, validation_data=(x_val, y_val), epochs=20, batch_size=32, verbose=2)

# 模型保存

model.save('handwritten_numeral_recognition.h5')

#

#

# #

# #

# 定义训练过程可视化函数(训练集损失、验证集损失、训练集精度、验证集精度)

def show_train_history(train_history, train, validation):

plt.plot(train_history.history[train])

plt.plot(train_history.history[validation])

plt.title('Train History')

plt.ylabel(train)

plt.xlabel('Epoch')

plt.legend(['train', 'validation'], loc='best')

plt.show()

show_train_history(train_history, 'accuracy', 'val_accuracy')

show_train_history(train_history, 'loss', 'val_loss')

# 输出网络在测试集上的损失与精度

score = model.evaluate(x_test, y_test)

print('Test loss:', score[0])

print('Test accuracy:', score[1])

# 测试集结果预测

predictions = model.predict(x_test)

predictions = np.argmax(predictions, axis=1)

print('前9张图片预测结果:', predictions[:9])

# 预测结果图像可视化

def mnist_visualize_multiple_predict(start, end, length, width):

for i in range(start, end):

plt.subplot(length, width, 1 + i)

plt.imshow(x_test_original[i], cmap=plt.get_cmap('gray'))

title_true = 'true=' + str(y_test_original[i])

title_prediction = ',' + 'prediction' + str(model.predict_classes(np.expand_dims(x_test[i], axis=0)))

title = title_true + title_prediction

plt.title(title)

plt.xticks([])

plt.yticks([])

plt.show()

mnist_visualize_multiple_predict(start=0, end=9, length=3, width=3)

# 混淆矩阵

cm = confusion_matrix(y_test_original, predictions)

cm = pd.DataFrame(cm)

class_names = ['0', '1', '2', '3', '4', '5', '6', '7', '8', '9']

def plot_confusion_matrix(cm):

plt.figure(figsize=(10, 10))

sns.heatmap(cm, cmap='Oranges', linecolor='black', linewidth=1, annot=True, fmt='', xticklabels=class_names,

yticklabels=class_names)

plt.xlabel("Predicted")

plt.ylabel("Actual")

plt.title("Confusion Matrix")

plt.show()

plot_confusion_matrix(cm)

我修改的部分

调用本地数据

# x_train_original和y_train_original代表训练集的图像与标签, x_test_original与y_test_original代表测试集的图像与标签

# (x_train_original, y_train_original), (x_test_original, y_test_original) = mnist.load_data()

# 假设你已经知道mnist.npz文件的路径

file_path = 'mnist.npz' # 替换为你的mnist.npz文件的实际路径

# 加载npz文件

with np.load(file_path, allow_pickle=True) as f:

x_train_original = f['x_train']

y_train_original = f['y_train']

x_test_original = f['x_test']

y_test_original = f['y_test']因为原来的代码是每次运行都请求下载网上的在线数据,这是没必要的,当你运行了一次,可以把数据存在本地,然后以后本地调用

修改第二层卷积层

def CNN_model():

model = Sequential()

model.add(Conv2D(filters=16, kernel_size=(5, 5), activation='relu', input_shape=(28, 28, 1))) # 卷积层

model.add(MaxPooling2D(pool_size=(2, 2), strides=(2, 2))) # 池化层

# model.add(Conv2D(filters=32, kernel_size=(5, 5), activation='relu', input_shape=(28, 28, 1))) # 卷积层

model.add(Conv2D(filters=32, kernel_size=(5, 5), activation='relu')) # 卷积层

model.add(MaxPooling2D(pool_size=(2, 2), strides=(2, 2))) # 池化层

model.add(Flatten()) # 平铺层

model.add(Dense(100, activation='relu')) # 全连接层

model.add(Dense(10, activation='softmax')) # 全连接层

print(model.summary())

return model 原文中的第二层卷积层的输入是规定为(28,28,1),但是这是有问题的,应该是不设置参数,这样子的话,会自动将第一个池化层的输出当作输入