BLIP:统一理解和生成的自举多模态模型研究

- 摘要

- 引言

- 一、BLIP模型概述

- 二、 BLIP模型在多模态任务中的应用

- 三、总结

摘要

本文介绍了BLIP(Bootstrapping Language-Image Pre-training)模型,一个前沿的多模态模型,通过自举学习的方式实现了对视觉和语言信息的统一理解和生成。文章首先概述了BLIP模型的基本架构和核心思想,随后详细阐述了BLIP在图像-文本检索、图像描述生成、视觉问答等多种多模态任务中的应用和效果。最后,文章对BLIP模型的局限性和未来发展方向进行了讨论。

引言

随着人工智能技术的快速发展,多模态信息处理已成为研究热点。传统的单模态模型在处理图像、文本等复杂信息时存在局限性,而多模态模型能够同时处理不同模态的信息,具有更强的理解和生成能力。BLIP模型作为多模态模型中的佼佼者,通过自举学习的方式实现了对视觉和语言信息的统一理解和生成,具有重要的研究价值和应用前景。

一、BLIP模型概述

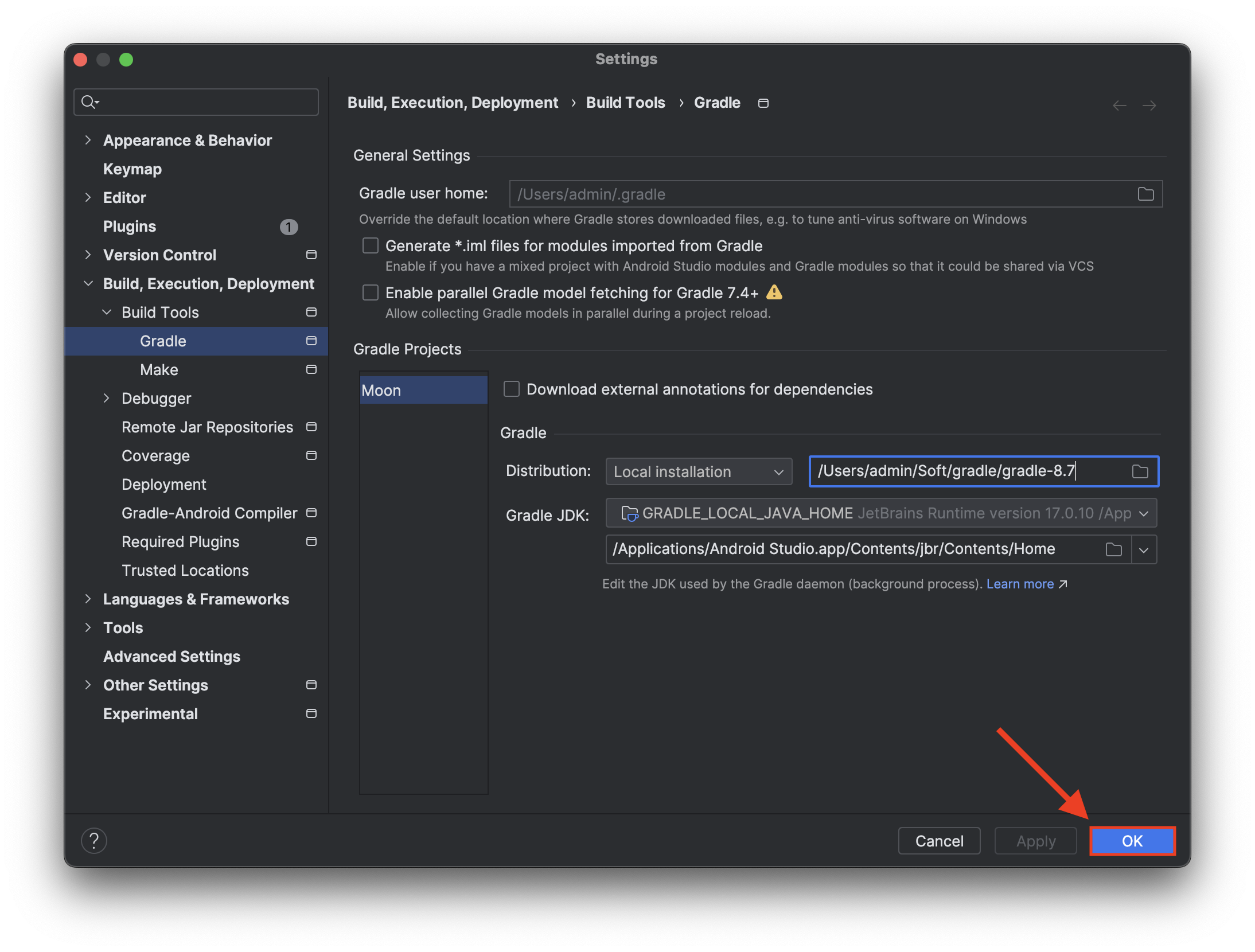

BLIP模型是一个基于自举学习的多模态预训练模型,旨在实现对视觉和语言信息的统一理解和生成。该模型采用了一种创新的预训练策略,通过联合训练图像编码器和文本编码器,使模型能够同时理解图像和文本的信息。在预训练阶段,BLIP通过大量无标注的图像-文本对数据学习视觉和语言之间的关联,从而实现对多模态信息的理解和生成。

BLIP模型的核心优势在于其统一理解和生成的能力。传统的多模态模型往往需要在不同的任务上分别进行训练和优化,而BLIP通过自举学习的方式实现了对多模态任务的统一处理。这使得BLIP在多个多模态任务上都取得了显著的性能提升,包括图像-文本检索、图像描述生成、视觉问答等。

二、 BLIP模型在多模态任务中的应用

1.图像-文本检索

在图像-文本检索任务中,BLIP模型通过将图像和文本信息编码成相同的向量空间,实现了图像和文本之间的相似度匹配。实验表明,BLIP在多个图像-文本检索数据集上都取得了优异的性能,相比于传统方法具有更高的准确率和召回率。

2.图像描述生成

在图像描述生成任务中,BLIP模型能够根据输入的图像生成相应的文本描述。通过联合训练图像编码器和文本解码器,BLIP能够学习到图像和文本之间的对应关系,从而生成准确的文本描述。实验表明,BLIP生成的文本描述不仅准确度高,而且具有较好的流畅性和可读性。

3.视觉问答

在视觉问答任务中,BLIP模型需要根据输入的图像和问题生成相应的答案。该任务要求模型同时理解图像和文本的信息,并能够根据问题对图像进行推理和解答。BLIP通过自举学习的方式实现了对图像和文本信息的统一理解,从而在视觉问答任务中取得了良好的性能。

三、总结

BLIP模型作为一个前沿的多模态模型,通过自举学习的方式实现了对视觉和语言信息的统一理解和生成。该模型在多个多模态任务中都取得了显著的性能提升,具有重要的研究价值和应用前景。然而,BLIP模型仍存在一些局限性,例如对噪声数据的敏感性、对复杂场景的理解能力等。未来的研究可以从以下几个方面展开:

1.优化预训练策略:进一步探索更有效的预训练策略,以提高模型对噪声数据的鲁棒性和对复杂场景的理解能力。

2.扩展应用场景:将BLIP模型应用于更多的多模态任务中,如视频理解、音频识别等,以验证其通用性和泛化能力。

3.结合其他技术:结合其他先进技术,如强化学习、知识图谱等,以进一步提升BLIP模型的性能和效果。