深度神经网络(Deep Neural Networks, DNN)是机器学习和人工智能的核心技术之一,已经广泛应用于图像识别、自然语言处理、语音识别、自动驾驶等领域。本文将详细介绍深度神经网络的背景、基本原理、架构、训练方法、优化技巧以及常见应用。

一、深度神经网络的背景

1.1 历史发展

深度神经网络的起源可以追溯到20世纪40年代,当时McCulloch和Pitts提出了MP神经元模型,这是现代神经网络的雏形。1958年,Rosenblatt发明了感知器(Perceptron),成为第一个实现了二分类问题的神经网络模型。1986年,Rumelhart、Hinton和Williams提出了反向传播算法(Backpropagation),使多层神经网络的训练成为可能。

进入21世纪后,随着计算能力的提升和大规模数据的积累,深度学习逐渐崭露头角。2006年,Hinton提出了深度信念网络(Deep Belief Networks, DBN),标志着深度学习的兴起。2012年,Krizhevsky等人提出的AlexNet在ImageNet竞赛中取得了显著成果,进一步推动了深度学习的发展。

1.2 应用领域

深度神经网络在多个领域取得了显著成就,主要包括:

- 图像处理:如图像分类、目标检测、图像生成等。

- 自然语言处理:如机器翻译、情感分析、文本生成等。

- 语音识别:如语音转文字、语音生成等。

- 自动驾驶:如物体检测、路径规划、车道线检测等。

二、深度神经网络的基本原理

2.1 神经元和神经网络

**神经元(Neuron)**是神经网络的基本单元,模拟生物神经元的功能。一个神经元接收多个输入信号,经过加权求和和激活函数处理后输出一个信号。

**神经网络(Neural Network)**由多个神经元按层次结构连接而成。常见的神经网络包括输入层(Input Layer)、隐藏层(Hidden Layer)和输出层(Output Layer)。

2.2 前向传播(Forward Propagation)

前向传播是指输入数据经过各层神经元的加权求和和激活函数处理,最终得到输出结果的过程。公式如下:

对于输入 x,权重矩阵 W,偏置 b 和激活函数 f:

2.3 激活函数(Activation Function)

激活函数引入非线性,使神经网络能够逼近复杂的函数。常见的激活函数包括:

- Sigmoid 函数:

- Tanh 函数:

- ReLU(Rectified Linear Unit)函数:

2.4 损失函数(Loss Function)

损失函数用于衡量模型预测结果与真实值之间的差异。常见的损失函数包括:

- 均方误差(Mean Squared Error, MSE):

- 交叉熵(Cross-Entropy):

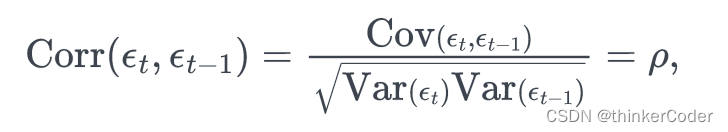

2.5 反向传播(Backward Propagation)

反向传播是指通过计算损失函数关于各层参数的梯度,利用梯度下降法更新参数,使得损失函数最小化的过程。反向传播算法的核心步骤包括:

- 计算损失函数对输出的梯度。

- 利用链式法则计算各层参数的梯度。

- 更新参数。

三、深度神经网络的架构

3.1 全连接网络(Fully Connected Network, FCN)

全连接网络中,每一层的每一个神经元都与下一层的每一个神经元相连。全连接网络适用于各种任务,但参数量较大,计算开销较高。

3.2 卷积神经网络(Convolutional Neural Network, CNN)

卷积神经网络通过卷积层、池化层和全连接层构建,特别适用于图像处理任务。卷积层通过卷积核提取图像的局部特征,池化层通过降采样减少特征图的尺寸。

3.3 循环神经网络(Recurrent Neural Network, RNN)

循环神经网络适用于处理序列数据,如时间序列、自然语言等。RNN通过循环连接在时间步之间传递信息。LSTM(Long Short-Term Memory)和GRU(Gated Recurrent Unit)是RNN的改进版本,解决了长序列中梯度消失和梯度爆炸的问题。

3.4 生成对抗网络(Generative Adversarial Network, GAN)

生成对抗网络由生成器(Generator)和判别器(Discriminator)组成。生成器生成伪造数据,判别器区分真实数据和伪造数据,两者通过对抗训练提升生成数据的质量。

四、深度神经网络的训练方法

4.1 数据预处理

数据预处理是训练深度神经网络的基础步骤。包括数据归一化、标准化、数据增强等。

4.2 梯度下降算法(Gradient Descent)

梯度下降算法通过不断更新参数,使得损失函数最小化。常见的梯度下降算法包括:

- 批量梯度下降(Batch Gradient Descent):使用整个训练集计算梯度,收敛稳定,但计算开销大。

- 随机梯度下降(Stochastic Gradient Descent, SGD):每次使用一个样本计算梯度,计算开销小,但收敛不稳定。

- 小批量梯度下降(Mini-Batch Gradient Descent):每次使用一个小批量样本计算梯度,兼具收敛速度和稳定性。

4.3 学习率调度(Learning Rate Scheduling)

学习率调度通过动态调整学习率,提高训练效率。常见的方法包括:

- 学习率衰减:随着训练进行,逐步减小学习率。

- 自适应学习率:如AdaGrad、RMSprop、Adam等算法,根据梯度信息自适应调整学习率。

4.4 正则化(Regularization)

正则化技术用于防止过拟合,提高模型的泛化能力。常见的正则化方法包括:

- L2正则化(权重衰减):在损失函数中加入权重的平方和惩罚项。

- Dropout:在训练过程中随机丢弃部分神经元,减少对特定神经元的依赖。

- 数据增强:通过对训练数据进行各种变换,增加数据的多样性。

五、深度神经网络的优化技巧

5.1 Batch Normalization

批量归一化通过在每一层进行归一化,缓解梯度消失和梯度爆炸问题,加速模型训练,增强模型稳定性。

5.2 数据增强

数据增强通过对训练数据进行各种变换,如旋转、缩放、裁剪、翻转等,增加数据的多样性,提升模型的泛化能力。

5.3 超参数调优

超参数调优通过网格搜索、随机搜索、贝叶斯优化等方法,选择最佳的超参数组合,提高模型性能。

5.4 迁移学习

迁移学习通过利用在一个任务上训练好的模型参数,在相似任务上进行微调,提高模型训练效率和性能。

六、深度神经网络的常见应用

6.1 图像分类

使用卷积神经网络(CNN)进行图像分类任务,如MNIST手写数字识别、CIFAR-10图像分类等。

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

import matplotlib.pyplot as plt

# 加载数据

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()

# 预处理数据

train_images, test_images = train_images / 255.0, test_images / 255.0

# 构建模型

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10))

# 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

# 训练模型

history = model.fit(train_images, train_labels, epochs=10,

validation_data=(test_images, test_labels))

# 评估模型

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label='val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0, 1])

plt.legend(loc='lower right')

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print(test_acc)

6.2 自然语言处理

使用循环神经网络(RNN)进行文本分类、机器翻译、情感分析等任务。

import tensorflow as tf

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

from tensorflow.keras import layers, models

# 示例数据

sentences = ["I love machine learning", "Deep learning is amazing", "Natural language processing is a branch of AI"]

labels = [1, 1, 0] # 1: positive, 0: negative

# 文本预处理

tokenizer = Tokenizer(num_words=10000)

tokenizer.fit_on_texts(sentences)

sequences = tokenizer.texts_to_sequences(sentences)

padded_sequences = pad_sequences(sequences, maxlen=10)

# 构建模型

model = models.Sequential()

model.add(layers.Embedding(input_dim=10000, output_dim=16, input_length=10))

model.add(layers.LSTM(32))

model.add(layers.Dense(1, activation='sigmoid'))

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(padded_sequences, labels, epochs=10)

# 预测

test_sentence = ["I love AI"]

test_sequence = tokenizer.texts_to_sequences(test_sentence)

padded_test_sequence = pad_sequences(test_sequence, maxlen=10)

prediction = model.predict(padded_test_sequence)

print(prediction)

6.3 自动驾驶

使用深度神经网络进行物体检测、路径规划、车道线检测等任务,提升自动驾驶技术。

6.4 生成对抗网络

使用生成对抗网络(GAN)生成图像、音频、文本等,应用于图像生成、图像修复、风格转换等任务。

import tensorflow as tf

from tensorflow.keras import layers, models

import numpy as np

# 构建生成器

def build_generator():

model = models.Sequential()

model.add(layers.Dense(256, input_dim=100))

model.add(layers.LeakyReLU(alpha=0.2))

model.add(layers.BatchNormalization(momentum=0.8))

model.add(layers.Dense(512))

model.add(layers.LeakyReLU(alpha=0.2))

model.add(layers.BatchNormalization(momentum=0.8))

model.add(layers.Dense(1024))

model.add(layers.LeakyReLU(alpha=0.2))

model.add(layers.BatchNormalization(momentum=0.8))

model.add(layers.Dense(28 * 28 * 1, activation='tanh'))

model.add(layers.Reshape((28, 28, 1)))

return model

# 构建判别器

def build_discriminator():

model = models.Sequential()

model.add(layers.Flatten(input_shape=(28, 28, 1)))

model.add(layers.Dense(512))

model.add(layers.LeakyReLU(alpha=0.2))

model.add(layers.Dense(256))

model.add(layers.LeakyReLU(alpha=0.2))

model.add(layers.Dense(1, activation='sigmoid'))

return model

# 编译模型

discriminator = build_discriminator()

discriminator.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

generator = build_generator()

z = layers.Input(shape=(100,))

img = generator(z)

discriminator.trainable = False

valid = discriminator(img)

combined = models.Model(z, valid)

combined.compile(optimizer='adam', loss='binary_crossentropy')

# 训练GAN

def train_gan(epochs, batch_size=128, save_interval=50):

(X_train, _), (_, _) = tf.keras.datasets.mnist.load_data()

X_train = (X_train.astype(np.float32) - 127.5) / 127.5

X_train = np.expand_dims(X_train, axis=3)

valid = np.ones((batch_size, 1))

fake = np.zeros((batch_size, 1))

for epoch in range(epochs):

idx = np.random.randint(0, X_train.shape[0], batch_size)

imgs = X_train[idx]

noise = np.random.normal(0, 1, (batch_size, 100))

gen_imgs = generator.predict(noise)

d_loss_real = discriminator.train_on_batch(imgs, valid)

d_loss_fake = discriminator.train_on_batch(gen_imgs, fake)

d_loss = 0.5 * np.add(d_loss_real, d_loss_fake)

g_loss = combined.train_on_batch(noise, valid)

if epoch % save_interval == 0:

print(f"{epoch} [D loss: {d_loss[0]}] [D accuracy: {100 * d_loss[1]}] [G loss: {g_loss}]")

train_gan(epochs=10000, batch_size=64, save_interval=1000)

七、深度神经网络的优劣势

7.1 优势

- 强大的学习能力:深度神经网络通过多层次的非线性变换,能够学习和逼近复杂的函数关系。

- 自动特征提取:相比传统的机器学习方法,深度神经网络能够自动从数据中提取有用的特征,减少了人工特征工程的需求。

- 广泛的应用领域:深度神经网络在图像处理、自然语言处理、语音识别等多个领域取得了显著成果,表现出极强的通用性。

- 处理大规模数据:深度神经网络能够高效处理海量数据,适用于大数据环境。

7.2 劣势

- 计算资源需求高:训练深度神经网络通常需要大量的计算资源和时间,尤其是对于大规模数据和复杂模型。

- 参数调整复杂:深度神经网络的超参数众多,调整合适的参数组合需要大量的实验和调优。

- 过拟合风险:由于模型复杂度高,深度神经网络容易在训练数据上表现良好,但在测试数据上表现不佳,需要使用正则化等技术防止过拟合。

- 可解释性差:深度神经网络的内部结构复杂,决策过程难以解释,对于某些应用场景(如医疗)可能会受到限制。

八、总结

深度神经网络是现代机器学习和人工智能的核心技术,具有强大的学习和表达能力。本文详细介绍了深度神经网络的背景、基本原理、架构、训练方法、优化技巧、常见应用以及优劣势。通过这些内容的学习和实践,可以有效提高模型的性能和应用效果。

参考文献

- 《深度学习》 - Ian Goodfellow, Yoshua Bengio, Aaron Courville

- 《神经网络与深度学习》 - Michael Nielsen

- 《动手学深度学习》 - 李沐、阿斯顿·张等

- 《TensorFlow实战Google深度学习框架》 - 黄文坚

- 《深度学习实践:基于Python与Keras的快速入门与实战》 - Jeremy Howard