目录

- 一、报错场景

- 二、源码分析

- 三、实际原因(更加复杂)

- 四、解决思路

一、报错场景

今天写了一个历史数据处理程序,在开发环境、测试环境都可以正常执行,但是放到生产环境上就不行,报了一个这样的错误:

- org.postgresql.util.PSQLException: An I/O error occurred while sending to the backend.

意思大概是:当把数据发送给后端的时候,出现了一个 I/O 异常。

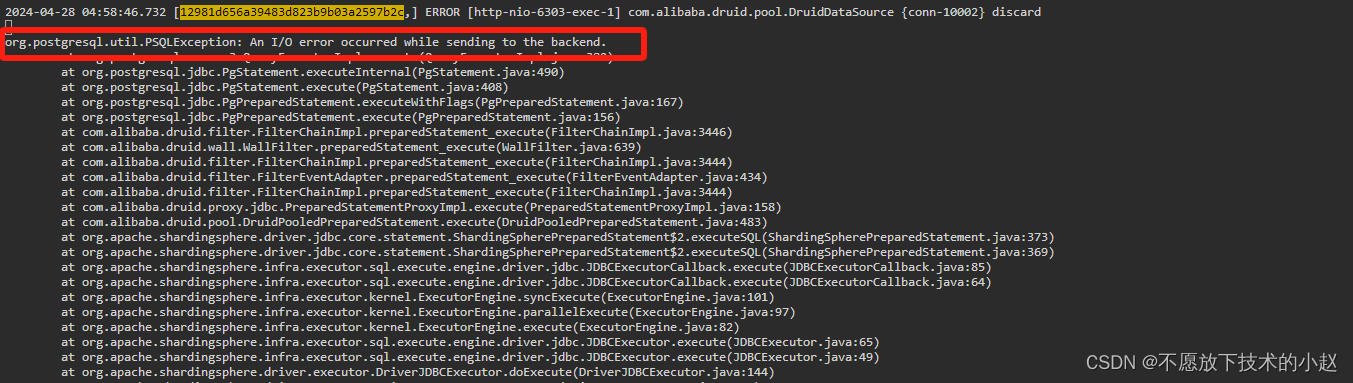

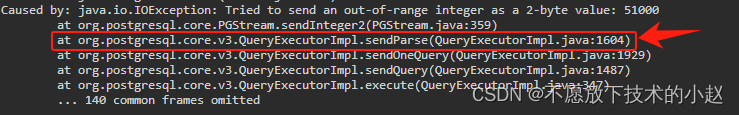

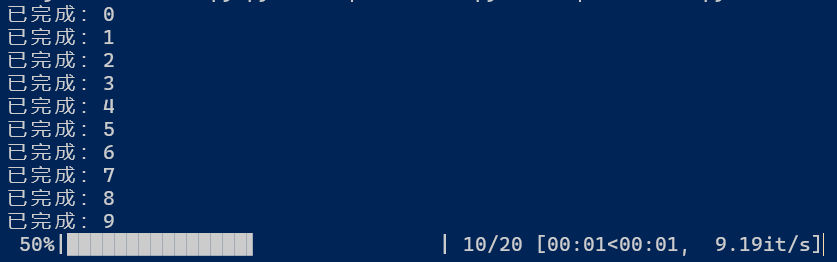

完整报错截图如下:

顺着日志中异常栈信息往下看,可以看到下面有一处具体的报错原因:

- Caused by: java.io.IOException: Tried to send an out-of-range integer as a 2-byte value: 51000

意思大概是:出现了一个IO异常,尝试发送一个二进制 int 类型数值时,当前数值超出了大小限制:5100

Caused by: java.io.IOException: Tried to send an out-of-range integer as a 2-byte value: 51000

at org.postgresql.core.PGStream.sendInteger2(PGStream.java:359)

at org.postgresql.core.v3.QueryExecutorImpl.sendParse(QueryExecutorImpl.java:1604)

at org.postgresql.core.v3.QueryExecutorImpl.sendOneQuery(QueryExecutorImpl.java:1929)

at org.postgresql.core.v3.QueryExecutorImpl.sendQuery(QueryExecutorImpl.java:1487)

at org.postgresql.core.v3.QueryExecutorImpl.execute(QueryExecutorImpl.java:347)

... 140 common frames omitted

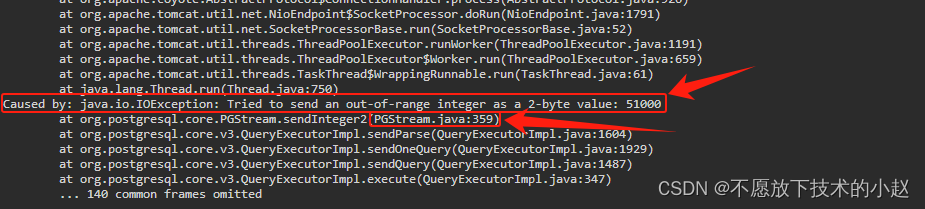

二、源码分析

我们根据报错提示,找到源码对应的位置,该源码位于 postgresql 依赖中,Maven坐标如下:

<!--postgresql 数据库驱动依赖 -->

<dependency>

<groupId>org.postgresql</groupId>

<artifactId>postgresql</artifactId>

<version>42.6.0</version>

<scope>runtime</scope>

</dependency>

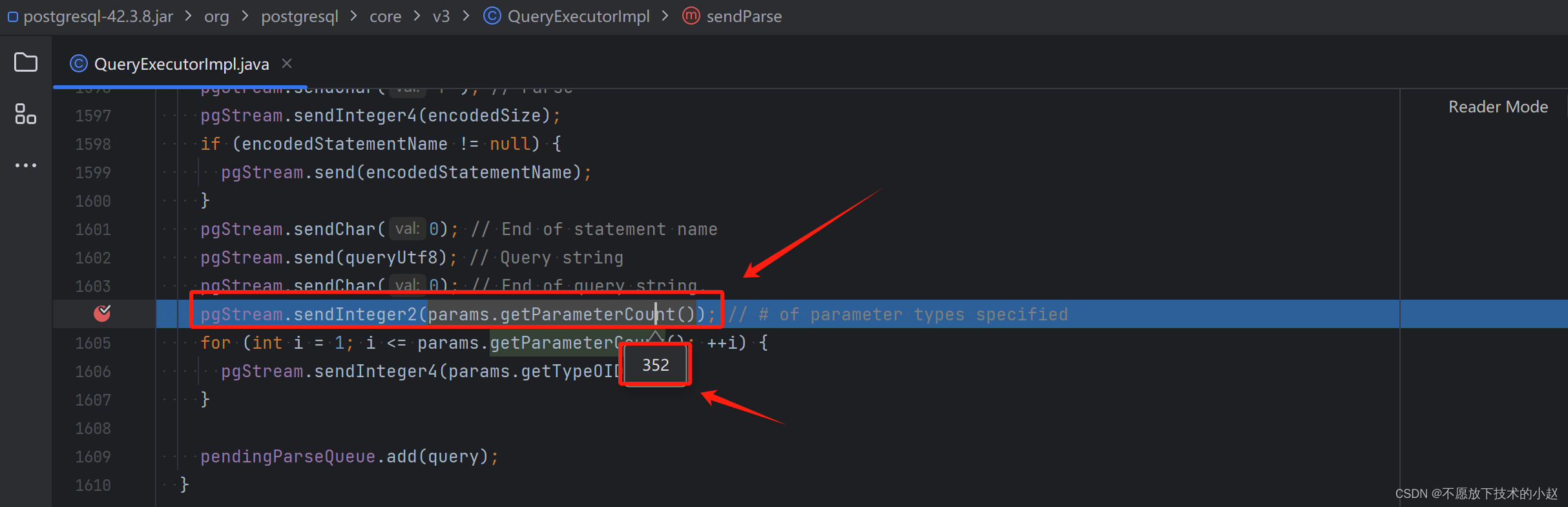

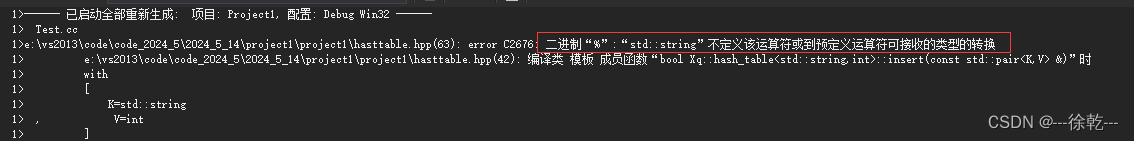

源码位置如下:

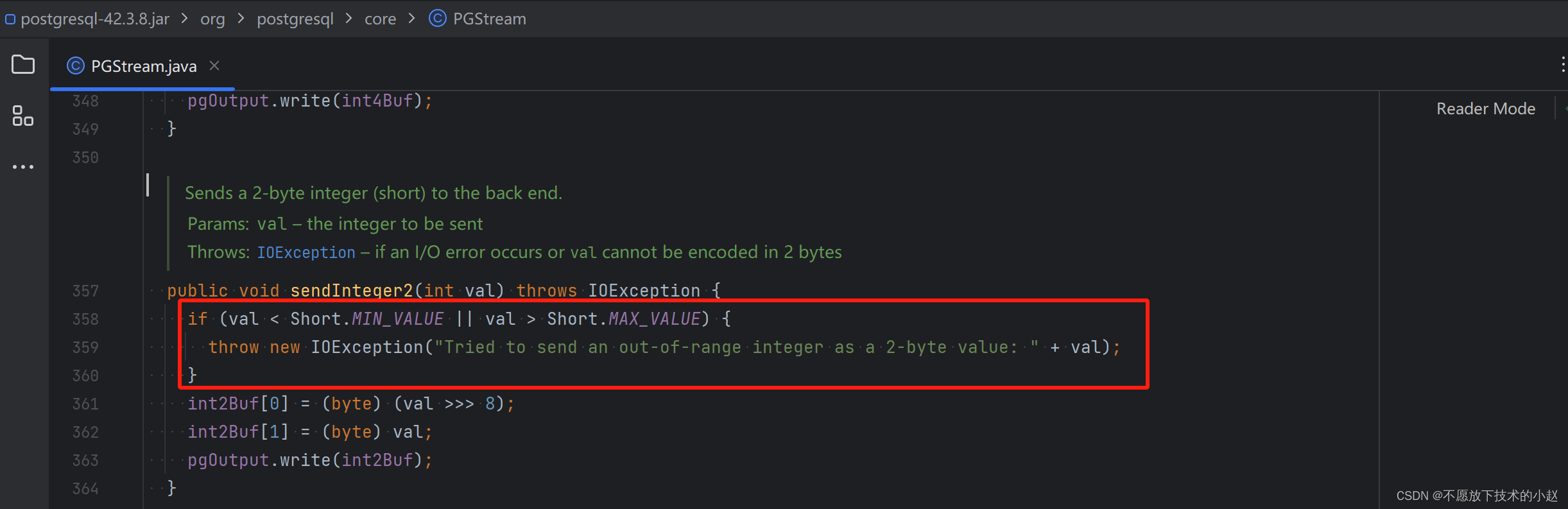

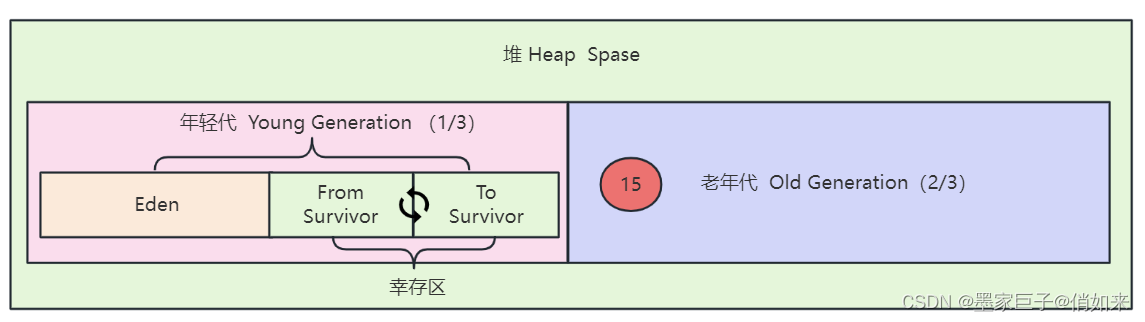

可以看到这里有一个大小限制,Short.MAX_VALUE 对应的就是 Short 类型的最大值,为 32767。也就是说,在 PostgreSQL 中,如果参数的数量超过 32767 之后,就会抛出 Tried to send an out-of-range integer 这个异常。

三、实际原因(更加复杂)

道理都懂,但是细想的话还是有以下两个问题:

- 我在代码中明明根据入参按照 1000 分页处理的,没有超出 32767,为什么还会报这个错?

- 报错信息中的 51000 又是哪来的?

于是我们继续根据上面的异常栈信息进行排查,针对第2层栈信息在本地打断点调试。

Caused by: java.io.IOException: Tried to send an out-of-range integer as a 2-byte value: 51000

at org.postgresql.core.PGStream.sendInteger2(PGStream.java:359)

at org.postgresql.core.v3.QueryExecutorImpl.sendParse(QueryExecutorImpl.java:1604)

at org.postgresql.core.v3.QueryExecutorImpl.sendOneQuery(QueryExecutorImpl.java:1929)

at org.postgresql.core.v3.QueryExecutorImpl.sendQuery(QueryExecutorImpl.java:1487)

at org.postgresql.core.v3.QueryExecutorImpl.execute(QueryExecutorImpl.java:347)

... 140 common frames omitted

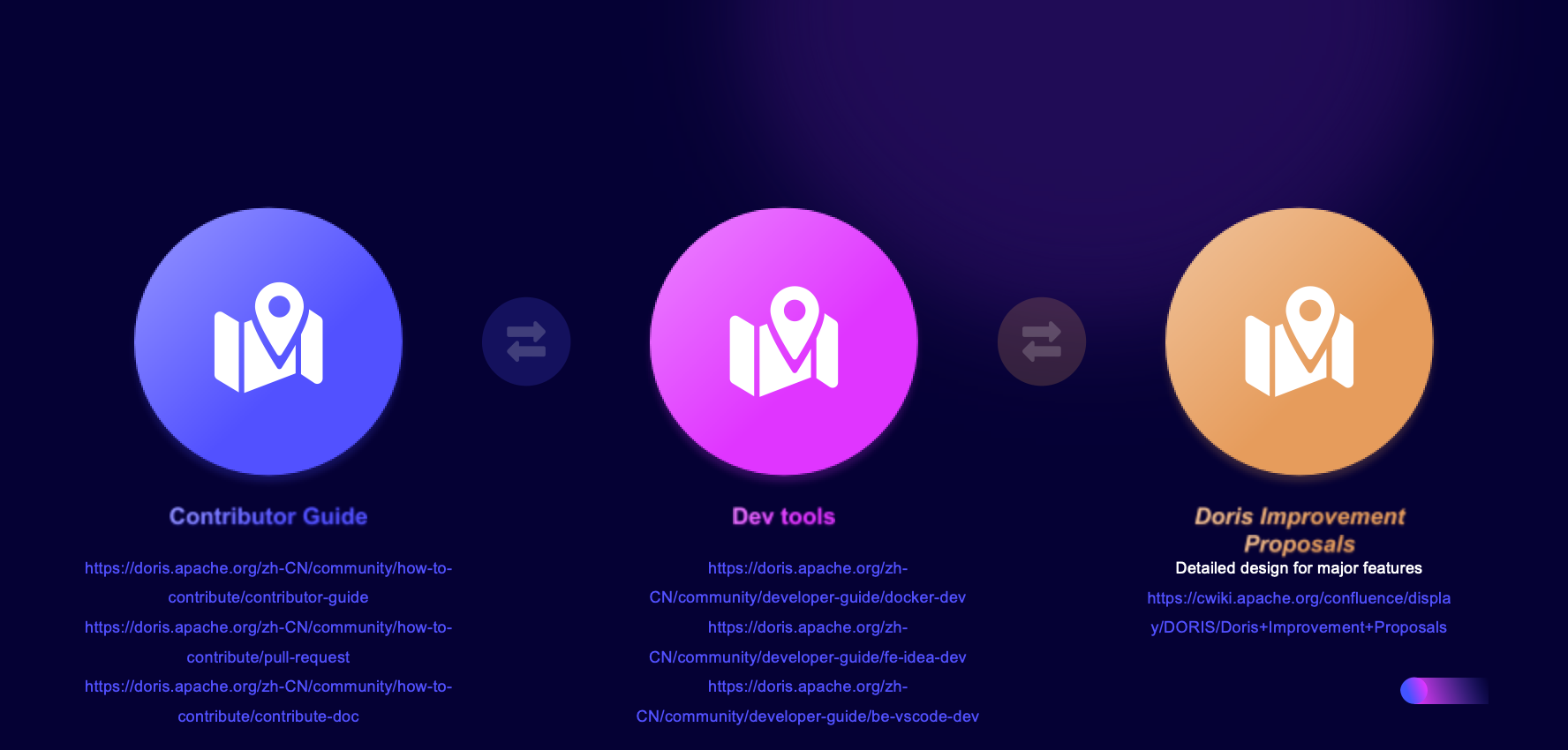

首先找到第二层栈信息对应的源码位置,并在本地进行debug:

这里我本地调试的时候,是传了 11 个参数,但是在第二层断点中入参却变成了 352 个,这是为什么呢?

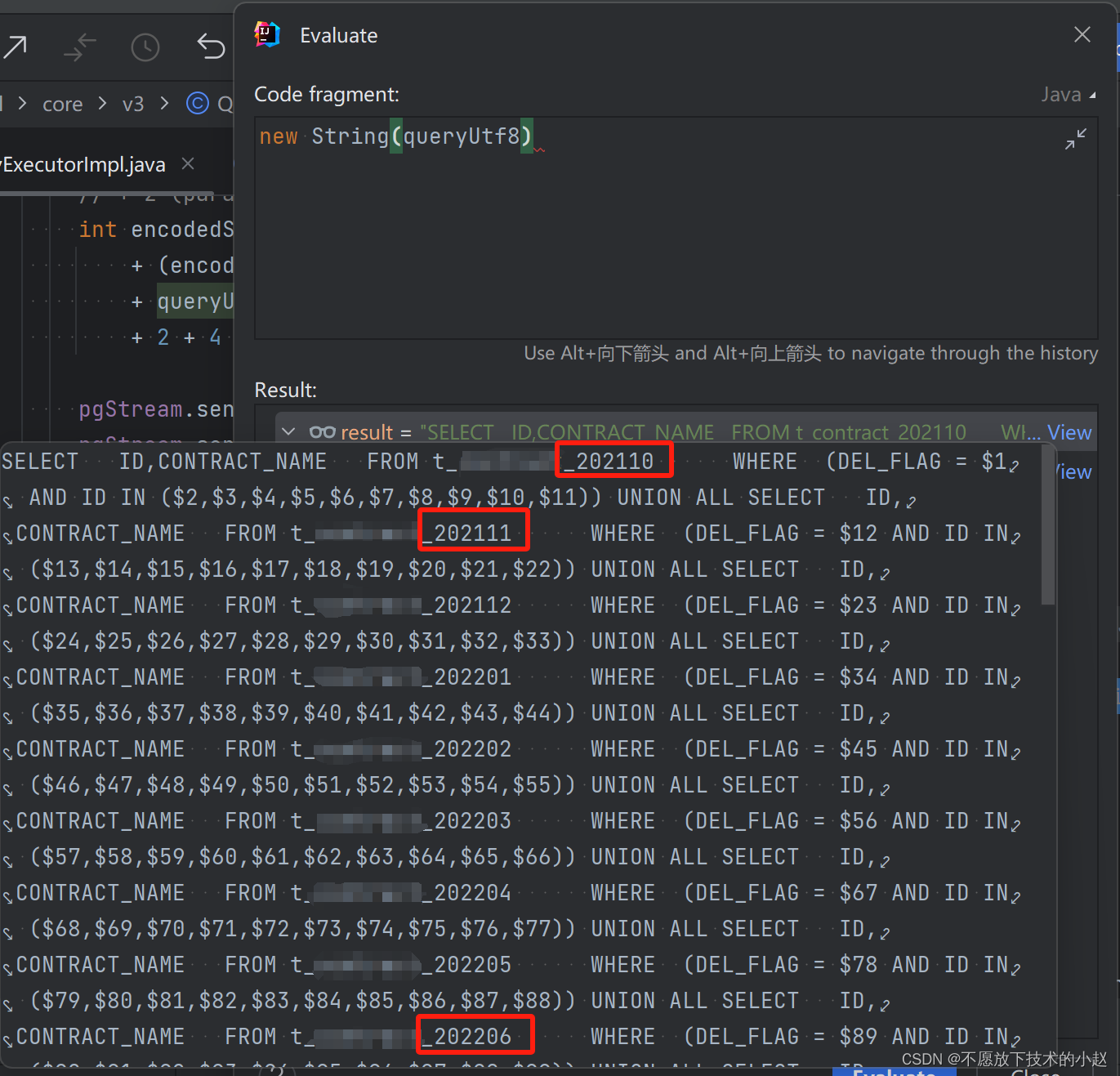

不要慌,其实这里的 queryUtf8 变量中存储的就是我们的 SQL 了,我们直接查看下这个变量的字符串即可:

终于,找到罪魁祸首了,由于项目中集成了 ShrdingJDBC,导致执行 SQL 的时候会自动拼接分表 SQL 并进行 UNION ALL,导致入参个数猛增几十倍。所以:

- 开发环境中,分表是 202110~202405,32张表 × 11个入参 = 352 个总入参。

- 生产环境中,分表是 202110~202512,51张表 × 1000个入参 = 51000 个总入参。

51000 远远超出 32767 的限制,所以抛出 IO 异常。

四、解决思路

可以根据以下两种情况,分别进行解决:

- 如果没有使用 ShardingJDBC 进行分表:建议分页处理。

- 如果已经使用 ShardingJDBC 进行分表:在单个SQL入参不超过 32767 的情况下,一方面可以将分片键加入参数中;另一方面可以再进一步分页,细化分页颗粒度。

整理完毕,完结撒花~🌻

![[Kubernetes] kube-proxy 详解](https://img-blog.csdnimg.cn/direct/11df666a203c4345aab9e4d6f1eac3a6.png)