LVS+Keepalived群集及搭建

- Keepalived 简介

- 什么是Keepalived ?

- Keepalived 的作用

- keepalived体系主要模块及作用

- Keepalived 选举策略

- 选举策略

- priority 和 weight 的设定

- Keepalived脑裂及解决方法

- 部署LVS+keepalived高可用集群

- 服务器准备

- 配置NFS共享

- 配置主DR服务器

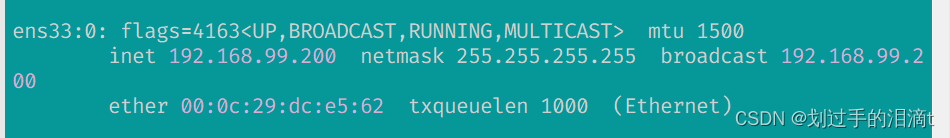

- 配置虚拟 IP 地址

- 安装keepalived

- ipvsadm服务

- 调整 proc 响应参数,关闭Linux 内核的重定向参数响应

- 配置备DR服务器

- 测试验证

Keepalived 简介

什么是Keepalived ?

Keepalived一个基于VRRP 协议来实现的 LVS 服务高可用方案,可以利用其来解决单点故障。一个LVS服务会有2台服务器运行Keepalived,一台为主服务器(MASTER),一台为备份服务器(BACKUP),但是对外表现为一个虚拟IP,主服务器会发送特定的消息给备份服务器,当备份服务器收不到这个消息的时候,即主服务器宕机的时候, 备份服务器就会接管虚拟IP,继续提供服务,从而保证了高可用性。

Keepalived 的作用

如上述所说,Keepalived 提供了很好的高可用性保障服务,它可以检查服务器的状态,如果有服务器出现问题,Keepalived 会将其从系统中移除,并且同时使用备份服务器代替该服务器的工作,当这台服务器可以正常工作后,Keepalived 再将其放入服务器群中,这个过程是 Keepalived 自动完成的,不需要人工干涉,我们只需要修复出现问题的服务器即可。

keepalived体系主要模块及作用

三个模块分别是core、check、vrrp

(1)core模块:为keepalived的核心 ,负责主进程启动,维护全局配置文件,加载和解析

(2)VRRP 模块:来实现VRRP协议

(3)check 模块:负责健康检查 常见的检查方式, 比如:端口URL

Keepalived 选举策略

keepalived的抢占与非抢占模式

抢占模式:MASTER从故障中恢复后,会将VIP从BACKUP节点中抢占过来。

非抢占模式:MASTER恢复后不抢占BACKUP升级为MASTER后的VIP

非抢占式俩节点state必须为bakcup,且必须配置nopreempt。

选举策略

首先,每个节点有一个初始优先级,由配置文件中的priority配置项指定,MASTER 节点的 priority 应比 BAKCUP 高。运行过程中 keepalived 根据 vrrp_script 的 weight 设定,增加或减小节点优先级。规则如下:

weight值为正时,脚本检测成功时”weight”值会加到”priority”上,检测失败时不加

- 主失败: 主priority < 备priority+weight之和时会切换

- 主成功: 主priority+weight之和 > 备priority+weight之和时,主依然为主,即不发生切换

weight为负数时,脚本检测成功时”weight”不影响”priority”,检测失败时,Master节点的权值将是“priority“值与“weight”值之差

- 主失败: 主priotity-abs(weight) < 备priority时会发生切换

- 主成功: 主priority > 备priority 不切换

当两个节点的优先级相同时,以节点发送VRRP通告的 IP 作为比较对象,IP较大者为MASTER。

priority 和 weight 的设定

主从的优先级初始值priority和变化量weight设置非常关键,配错的话会导致无法进行主从切换。比如,当MASTER初始值定得太高,即使script脚本执行失败,也比BACKUP的priority + weight大,就没法进行VIP漂移了。

所以priority和weight值的设定应遵循: abs(MASTER priority - BAKCUP priority) < abs(weight)。一般情况下,初始值MASTER的priority值应该比较BACKUP大,但不能超过weight的绝对值。 另外,当网络中不支持多播(例如某些云环境),或者出现网络分区的情况,keepalived BACKUP节点收不到MASTER的VRRP通告,就会出现脑裂(split brain)现象,此时集群中会存在多个MASTER节点。

Keepalived脑裂及解决方法

- keepalived脑裂

在高可用(HA)系统中,当联系2个节点的“心跳线”断开时,本来为一整体、动作协调的HA系统,就分裂成为2个独立的个体。由于相互失去了联系,都以为是对方出了故障。两个节点上的HA软件像“裂脑人”一样,争抢“共享资源”、争起“应用服务”,就会发生严重后果——或者共享资源被瓜分、2边“服务”都起不来了;或者2边“服务”都起来了,但同时读写“共享存储”,导致数据损坏(常见如数据库轮询的联机日志出错)。 - 脑裂的原因

高可用服务器对之间心跳线链路发生故障,导致无法正常通信。如心跳线坏了(包括断了,老化)。

因网卡及相关驱动坏了,ip配置及冲突问题(网卡直连)。

因心跳线间连接的设备故障(网卡及交换机)。

因仲裁的机器出问题(采用仲裁的方案)。

高可用服务器上开启了 iptables防火墙阻挡了心跳消息传输。

Keepalived配置里同一 VRRP实例如果 virtual_router_id两端参数配置不一致也会导致裂脑问题发生。

vrrp实例名字不一致、优先级一致。 - 解决对策

- 添加冗余的心跳线,例如:双线条线(心跳线也HA),尽量减少“裂脑”发生几率。

- 启用磁盘锁。正在服务一方锁住共享磁盘,“裂脑”发生时,让对方完全“抢不走”共享磁盘资源。但使用锁磁盘也会有一个不小的问题,如果占用共享盘的一方不主动“解锁”,另一方就永远得不到共享磁盘。现实中假如服务节点突然死机或崩溃,就不可能执行解锁命令。后备节点也就接管不了共享资源和应用服务。于是有人在HA中设计了“智能”锁。即:正在服务的一方只在发现心跳线全部断开(察觉不到对端)时才启用磁盘锁。平时就不上锁了。

- 设置仲裁机制。例如设置参考IP(如网关IP),当心跳线完全断开时,2个节点都各自ping一下参考IP,不通则表明断点就出在本端。不仅“心跳”、还兼对外“服务”的本端网络链路断了,即使启动(或继续)应用服务也没有用了,那就主动放弃竞争,让能够ping通参考IP的一端去起服务。更保险一些,ping不通参考IP的一方干脆就自我重启,以彻底释放有可能还占用着的那些共享资源。

部署LVS+keepalived高可用集群

服务器准备

| 服务器 | RIP | 应用 | VIP |

|---|---|---|---|

| 主DR | 192.168.99.130 | ipvsadm、keepalived | 192.168.99.200 ens33:0 |

| 从DR | 192.168.99.131 | ipvsadm、keepalived | 192.168.99.200 ens33:0 |

| web1 | 192.168.99.141 | nginx | 192.168.99.200 lo:0 |

| web2 | 192.168.99.142 | nginx | 192.168.99.200 lo:0 |

| NFS | 192.168.99.137 | nfs |

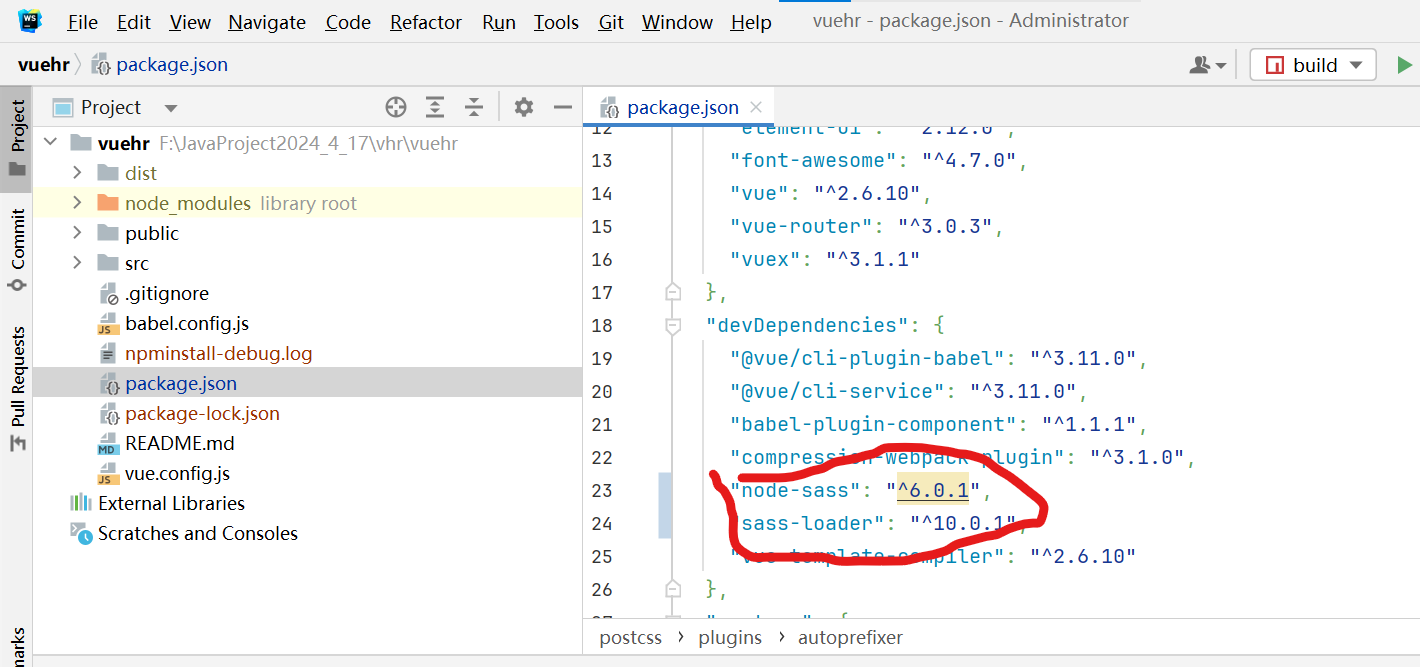

配置NFS共享

yum -y install nfs-utils rpcbind

mkdir /opt/web1 /opt/web2

chmod 777 /opt/web1 /opt/web2

vim /etc/exports

/usr/share *(ro,sync)

/opt/web1 192.168.99.0/24(rw,sync)

/opt/web2 192.168.99.0/24(rw,sync)

systemctl start nfs.service

systemctl start rpcbind.service

#发布共享

exportfs -rv

#查看共享

showmount -e

配置主DR服务器

hostnamectl set-hostname drmaster

systemctl stop firewalld.service

setenforce 0

modprobe ip_vs

cat /proc/net/ip_vs

yum -y install ipvsadm

配置虚拟 IP 地址

cd /etc/sysconfig/network-scripts/

cp ifcfg-ens33 ifcfg-ens33:0

vim ifcfg-ens33:0

DEVICE=ens33:0

ONBOOT=yes

IPADDR=192.168.99.200

NETMASK=255.255.255.255

systemctl restart network

安装keepalived

modprobe ip_vs

yum -y install ipvsadm keepalived

cd /etc/keepalived/

cp keepalived.conf keepalived.conf.bak

vim keepalived.conf

配置文件

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

#10行修改,邮件服务指向本地

smtp_server 127.0.0.1

smtp_connect_timeout 30

#12行--修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01

router_id LVS_01

vrrp_skip_check_adv_addr

#14行--注释掉,取消严格遵守VRRP协议功能,否则VIP无法被连接

#vrrp_strict

vrrp_garp_interval 0

vrrp_gna_interval 0

}

#定义VRRP热备实例参数

vrrp_instance VI_1 {

#20行--修改,指定热备状态,主为MASTER,备为BACKUP

state MASTER

#21行--修改,指定承载vip地址的物理接口

interface ens33

#22行--修改,指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 51

#nopreempt #如果设置非抢占模式,两个节点state必须为bakcup,并加上配置 nopreempt

#23行--修改,指定优先级,数值越大优先级越高,这里设置主为100

priority 100

#通告间隔秒数(心跳频率) ,MASTER与BACKUP同步检查的时间间隔

advert_int 1

#定义认证信息,每个热备组保持一致

authentication {

#认证类型

auth_type PASS

#27行--修改,指定验证密码,主备服务器保持一致

auth_pass 1111

}

virtual_ipaddress {

##指定群集vip地址

192.168.99.200

}

}

#修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.99.200 80 {

#健康检查的间隔时间(秒)

delay_loop 6

#指定调度算法,轮询(rr)

lb_algo rr

#修改,指定群集工作模式,直接路由(DR)

lb_kind DR

##连接保持时间(秒) 如果取消会话保持该值配置为false(不建议)

persistence_timeout 50

#应用服务采用的是 TCP协议

protocol TCP

#修改,指定第一个Web节点的地址、端口

real_server 192.168.99.141 80 {

#节点的权重

weight 1

#删除,添加以下健康检查方式

TCP_CHECK {

#添加检查的目标端口

connect_port 80

#添加连接超时(秒)

connect_timeout 3

#添加重试次数 高版本为retry

nb_get_retry 3

#添加重试间隔

delay_before_retry 3

}

}

#添加第二个 Web节点的地址、端口

real_server 192.168.99.142 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

##删除后面多余的配置##

}

#启动

systemctl start keepalived

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS_01

vrrp_skip_check_adv_addr

vrrp_garp_interval 0

vrrp_gna_interval 0

}

vrrp_instance VI_1 {

state MASTER

interface ens33

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.99.200

}

}

virtual_server 192.168.99.200 80 {

delay_loop 6

lb_algo rr

lb_kind DR

persistence_timeout 50

protocol TCP

real_server 192.168.99.141 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

real_server 192.168.99.142 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

}

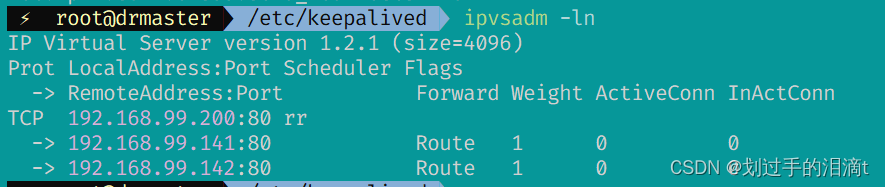

ipvsadm服务

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm

ipvsadm -C

ipvsadm -A -t 192.168.99.200:80 -s rr

ipvsadm -a -t 192.168.99.200:80 -r 192.168.99.141:80 -g

ipvsadm -a -t 192.168.99.200:80 -r 192.168.99.142:80 -g

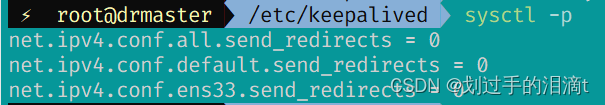

调整 proc 响应参数,关闭Linux 内核的重定向参数响应

vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

#检查

sysctl -p

配置备DR服务器

从DR除keepalive配置文件不同,其余与主DR一样

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

#10行修改,邮件服务指向本地

smtp_server 127.0.0.1

smtp_connect_timeout 30

#12行--修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01

router_id LVS_01

vrrp_skip_check_adv_addr

#14行--注释掉,取消严格遵守VRRP协议功能,否则VIP无法被连接

#vrrp_strict

vrrp_garp_interval 0

vrrp_gna_interval 0

}

#定义VRRP热备实例参数

vrrp_instance VI_1 {

#20行--修改,指定热备状态,主为MASTER,备为BACKUP

state MASTER

#21行--修改,指定承载vip地址的物理接口

interface ens33

#22行--修改,指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 51

#nopreempt #如果设置非抢占模式,两个节点state必须为bakcup,并加上配置 nopreempt

#23行--修改,指定优先级,数值越大优先级越高,这里设置主为100

priority 90

#通告间隔秒数(心跳频率) ,MASTER与BACKUP同步检查的时间间隔

advert_int 1

#定义认证信息,每个热备组保持一致

authentication {

#认证类型

auth_type PASS

#27行--修改,指定验证密码,主备服务器保持一致

auth_pass 1111

}

virtual_ipaddress {

##指定群集vip地址

192.168.99.200

}

}

#修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.99.200 80 {

#健康检查的间隔时间(秒)

delay_loop 6

#指定调度算法,轮询(rr)

lb_algo rr

#修改,指定群集工作模式,直接路由(DR)

lb_kind DR

##连接保持时间(秒) 如果取消会话保持该值配置为false(不建议)

persistence_timeout 50

#应用服务采用的是 TCP协议

protocol TCP

#修改,指定第一个Web节点的地址、端口

real_server 192.168.99.141 80 {

#节点的权重

weight 1

#删除,添加以下健康检查方式

TCP_CHECK {

#添加检查的目标端口

connect_port 80

#添加连接超时(秒)

connect_timeout 3

#添加重试次数 高版本为retry

nb_get_retry 3

#添加重试间隔

delay_before_retry 3

}

}

#添加第二个 Web节点的地址、端口

real_server 192.168.99.142 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

##删除后面多余的配置##

}

#启动

systemctl start keepalived

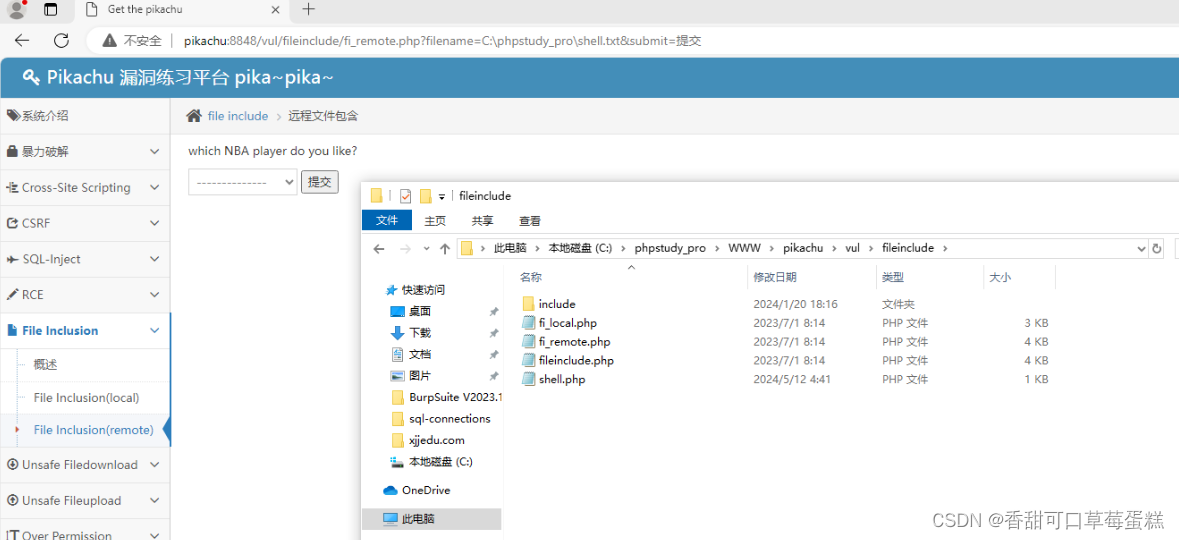

Web服务器1、2

#配置vip(虚拟ip)

vim /etc/sysconfig/network-scripts/ifcfg-lo:0

DEVICE=lo:0

ONBOOT=yes

IPADDR=192.168.99.200

NETMASK=255.255.255.255

NETWORK=127.0.0.0

BROADCAST=127.255.255.255

ONBOOT=yes

NAME=loopback

systemctl restart network

route add -host 192.168.99.200 dev lo:0

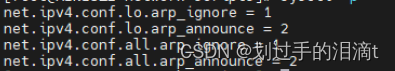

vim /etc/sysctl.conf

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

sysctl -p

yum install -y epel-release && yum install -y nginx nfs-utils rpcbind

systemctl start nginx

systemctl start rpcbind

systemctl start nfs

mount.nfs 192.168.99.137:/opt/web1/usr/share/nginx/html

echo 'web1' > /usr/share/nginx/html/index.html

#web2

mount.nfs 192.168.99.137:/opt/web2/usr/share/nginx/html

echo 'web2' > /usr/share/nginx/html/index.html

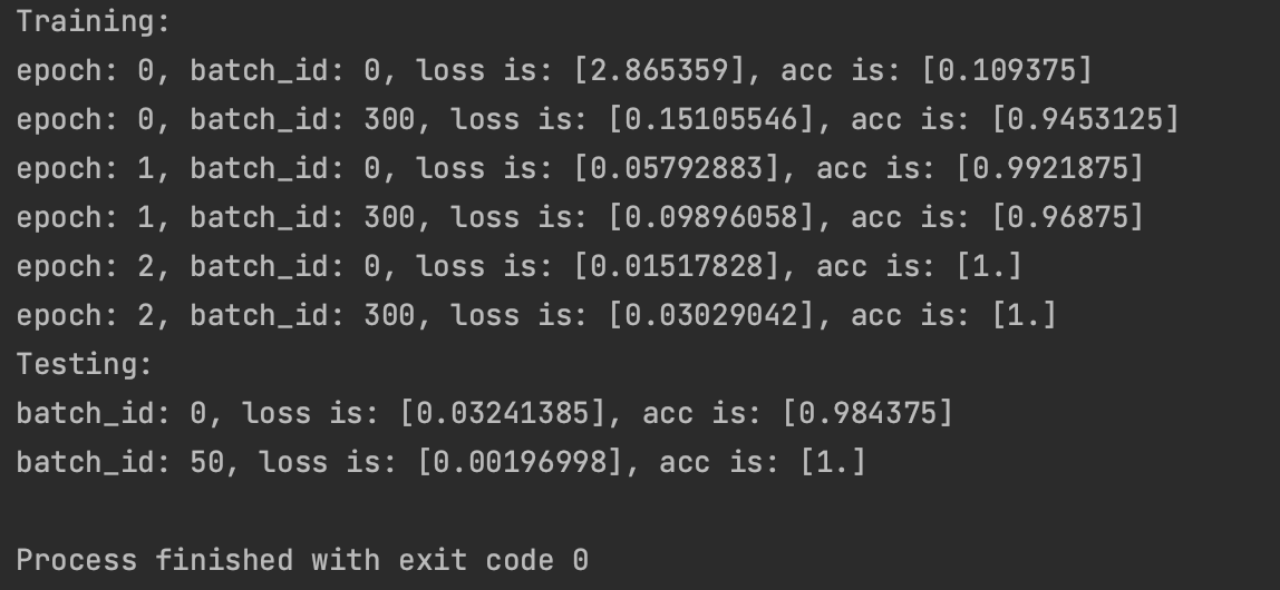

测试验证

浏览器访问http://192.168.99.200

#关闭主keepalived

systemctl stop keepalived

浏览器测试

刷新(时间间隔久一些)

![[图解]SysML和EA建模住宅安全系统-04](https://img-blog.csdnimg.cn/direct/5f854a210e154ddabb49e6bd925b967e.png)