ChatGPT

深度学习是一种使用神经网络来模拟人脑处理数据和创建模式的机器学习方法。下面是深度学习的一些主要知识点的总结:

1. 神经网络基础:

- 神经元:基本的计算单元,模拟人脑神经元。

- 激活函数:用于增加神经网络的非线性,常见的激活函数包括ReLU, Sigmoid, Tanh等。

- 前向传播:输入数据前向通过网络得到预测输出。

- 损失函数:评估模型预测值与真实值之间的差异,如均方误差(MSE), 交叉熵等。

- 反向传播:根据损失函数计算梯度,并更新网络权重以最小化损失。

- 梯度下降:最常见的优化算法,用于更新网络权重。

2. 网络架构:

- 多层感知机 (MLP):最简单的神经网络结构,由多个全连接层组成。

- 卷积神经网络 (CNN):用于图像处理,具有卷积层、池化层和全连接层。

- 循环神经网络 (RNN):用于处理序列数据,具有时间循环结构。

- 长短期记忆网络 (LSTM) 和门控循环单元 (GRU):RNN的变体,改进了长期依赖问题。

- Transformer及其变体:用于NLP(自然语言处理),基于自注意力机制。

3. 正则化与优化技术:

- Dropout:随机关闭网络中的一些神经元以防止过拟合。

- 批标准化 (Batch Normalization):规范化中间层输出以加速训练和稳定网络。

- 早停(Early Stopping):当验证集上的性能不再提升时停止训练。

- 学习率衰减:随着训练的进行逐渐减小学习率。

4. 训练技巧与策略:

- 数据增强:为训练数据通过不同的方式增加样本多样性。

- 微调 (Fine-tuning):使用预训练模型并在特定任务上进一步训练。

- Transfer Learning:将从一个任务中学到的知识应用于另一个任务。

5. 工具和框架:

- TensorFlow:由谷歌开发的开源机器学习框架。

- PyTorch:由Facebook AI研究院开发的开源机器学习库,易于实验和研究。

- Keras:高级神经网络API,运行在TensorFlow, Theano和CNTK之上。

6. 应用领域:

- 图像识别与分类

- 语音识别和生成

- 自然语言处理和理解

- 推荐系统

- 无人驾驶汽车

- 游戏AI

7. 关键概念及其实现:

- 数据预处理:使原始数据适用于神经网络。

- 特征学习:自动从数据中发现有助于任务的表示。

- 模型评估:使用验证数据和测试数据来评估模型性能。

- 参数和超参数:模型参数是训练过程中学习的,而超参数是人为设定的。

8. 挑战和研究方向:

- 解释性:理解和解释深度学习模型的决策过程。

- 广义性:提高模型在不同任务、不同数据上的泛化能力。

- 资源效率:设计更少计算资源消耗的模型。

- 安全性和隐私:确保深度学习应用的安全性和用户数据的隐私。

这些都是深度学习领域非常广泛和复杂的知识点概览,每个点都有很多细节和扩展的研究方向。在实践中,需要结合具体任务和数据来选择合适的模型和方法。

通义灵码

深度学习是机器学习的一个分支,它主要依赖于多层的神经网络来解决复杂的学习任务。以下是深度学习的一些关键知识点的总结:

-

神经网络基础:

- 感知机: 最简单的神经网络模型,用于二分类问题。

- 多层前馈网络(MLP): 基本的深度学习模型,包含输入层、隐藏层和输出层。

- 反向传播(Backpropagation): 用于更新权重的优化算法。

- 激活函数: 如Sigmoid、ReLU、Leaky ReLU、Tanh等,用于引入非线性。

-

卷积神经网络(CNN):

- 卷积层(Convolutional Layer): 用于提取特征。

- 池化层(Pooling Layer): 减少计算量,保持重要信息。

- 全连接层(Fully Connected Layer): 将卷积层或池化层的输出转换为分类或回归结果。

-

循环神经网络(RNN):

- 基本RNN结构: 有循环的神经网络,处理序列数据。

- 长短期记忆网络(LSTM): 解决RNN的梯度消失和爆炸问题。

- 门控循环单元(GRU): 类似LSTM但更简单,也有效防止梯度问题。

-

深度学习优化:

- 损失函数(Loss Function): 如均方误差(MSE)、交叉熵(Cross-Entropy)等。

- 优化器(Optimizers): 如随机梯度下降(SGD)、动量(Momentum)、Adam等。

- 正则化(Regularization): L1、L2正则化防止过拟合。

- 早停法(Early Stopping): 在验证集上性能不再提升时停止训练。

-

深度学习模型训练:

- 批量梯度下降(Batch Gradient Descent): 整个训练集一起更新权重。

- 随机梯度下降(Stochastic Gradient Descent): 每次迭代使用一个样本。

- 小批量梯度下降(Mini-Batch Gradient Descent): 每次迭代使用一小部分样本。

-

生成对抗网络(GANs):

- 生成器(Generator): 从噪声中生成新样本。

- 判别器(Discriminator): 判断样本是真实还是伪造。

- 对抗过程: 两个网络相互博弈以提高生成质量。

-

自编码器(Autoencoders): 用于数据降维和特征学习。

-

注意力机制(Attention Mechanism): 允许模型在处理序列数据时关注不同位置的重要性。

-

模型评估与验证:

- 交叉验证(Cross-validation): 分割数据集进行多次训练和评估。

- 混淆矩阵(Confusion Matrix): 用于分类任务的评估。

- ROC曲线和AUC: 用于二分类任务的评估。

-

深度学习框架:

- TensorFlow, PyTorch, Keras, MXNet, Caffe等,简化深度学习模型的构建和训练。

这些只是深度学习领域的一小部分概念,实际应用中还有更多如模型压缩、知识蒸馏、元学习、强化学习等高级主题。

Comate

深度学习是机器学习领域的一个重要研究方向,它旨在让机器能够像人一样具有分析学习能力,从而识别文字、图像和声音等数据。以下是对深度学习知识点的全面总结:

- 深度学习的定义与特点:

- 深度学习通过使用多层神经网络进行学习,能够处理大规模高维度的数据,并学习到更加复杂的特征和模式。

- 与传统的浅层神经网络相比,深度学习在诸如图像识别、语音识别、自然语言处理等领域取得了显著成果。

- 深度学习的基本方法:

- 基于卷积运算的神经网络系统,即卷积神经网络(CNN)。

- 基于多层神经元的自编码神经网络,包括自编码(Auto encoder)以及稀疏编码(Sparse Coding)。

- 以多层自编码神经网络的方式进行预训练,进而结合鉴别信息进一步优化神经网络权值的深度置信网络(DBN)。

- 深度学习的训练与优化:

- 深度学习方法预设了更多的模型参数,导致模型训练难度增大。因此,需要更多的数据参与训练。

- 常用的训练和优化算法包括反向传播、随机梯度下降等。

- 深度学习的应用场景:

- 图像识别:如人脸识别、车牌识别等。

- 语音识别:如语音指令识别、语音转文字等。

- 自然语言处理:如文本分类、情感分析、机器翻译等。

- 其他领域:如金融预测、医疗诊断、工业控制、自动驾驶、游戏智能等。

- 深度学习的发展趋势与未来展望:

- 多模态融合:未来的深度学习将更多地依赖于多种类型的信息融合,推动在多媒体分析、智能驾驶等领域的应用发展。

- 自动化模型设计:借助强化学习、遗传算法等方法,深度学习将朝着自动化模型设计的方向发展,提供智能化的模型设计工具。

- 算法优化:深度学习的算法将不断优化,探索更有效的训练方法,提高模型的学习速度和准确性。

- 边缘计算的应用:随着物联网、边缘计算的快速发展,深度学习将在这些领域发挥更大的作用。

总之,深度学习作为机器学习领域的重要分支,具有广泛的应用前景和发展潜力。通过不断的研究和创新,深度学习将在更多领域展现其强大的能力,推动人工智能技术的进一步发展。

文心一言

深度学习是机器学习领域中的一个新方向,主要是通过学习样本数据的内在规律和表示层次,让机器能够具有类似于人类的分析学习能力。以下是深度学习的一些关键知识点总结:

- 多层神经网络:深度学习的基础,由多层神经元组成,包括输入层、隐藏层和输出层。

- 反向传播算法:多层神经网络进行训练时的一种常用方法。该算法通过计算误差的梯度值,利用链式法则求得每个神经元的误差贡献,然后根据梯度下降法调整每个神经元的权重和偏置值。

- 激活函数:神经元接收到输入信号后生成输出信号的函数,如sigmoid函数、ReLU函数和tanh函数等。

- 卷积神经网络(CNN):一类包含卷积运算的神经网络系统,常用于处理具有网格结构的数据,如图像。

- 深度置信网络(DBN):通过多层自编码神经网络进行预训练,进而结合鉴别信息优化神经网络权值的网络结构。

- 残差网络(ResNet):目前最先进的深度神经网络结构之一。它的主要思想是通过引入残差模块解决深度神经网络的梯度消失和梯度爆炸问题。

- 端到端学习:在语音识别领域,这是一种新方法,即直接从语音信号中学习识别模型,而不再使用传统的语音识别系统。

此外,深度学习还涉及诸多应用领域,例如计算机视觉及图像识别、自然语言处理、语音识别及生成、推荐系统、游戏开发、医学影像识别、金融风控、智能制造、购物领域以及基因组学等。

在进行深度学习模型训练时,通常需要将数据集随机分成训练集、验证集和测试集。训练过程中,模型会经过多个epoch的训练,每个epoch都会将训练集反复输入模型。训练完成后,会使用测试集来评估模型的性能。

请注意,深度学习是一个复杂且不断发展的领域,上述总结仅为其中的一部分关键知识点。如需更深入地了解深度学习,建议参考相关书籍、在线课程或寻求专业人士的指导。

讯飞星火

深度学习是机器学习的一个子领域,它试图模拟人脑的工作原理,通过训练大量数据来自动学习数据的内在规律和表示层次。以下是一些关键的深度学习知识点:

-

神经网络(Neural Networks):这是深度学习的基础,由大量的神经元(或称为节点)按照不同的层次组织起来,每个神经元都与前一层的所有神经元相连。

-

前向传播(Forward Propagation):在神经网络中,数据从输入层流向输出层的过程。

-

反向传播(Backpropagation):这是一种优化策略,用于调整神经网络中的权重和偏置,以最小化损失函数。

-

激活函数(Activation Function):这是一个非线性函数,用于决定一个神经元是否应该被激活,以及激活的程度。常见的激活函数包括Sigmoid、ReLU和Tanh等。

-

损失函数(Loss Function):这是一个衡量模型预测结果与真实值之间差距的函数。常见的损失函数包括均方误差(MSE)、交叉熵损失(Cross-Entropy Loss)等。

-

优化器(Optimizers):这些算法用于更新网络的参数,以最小化损失函数。常见的优化器包括梯度下降(Gradient Descent)、随机梯度下降(Stochastic Gradient Descent, SGD)、Adam等。

-

卷积神经网络(Convolutional Neural Networks, CNNs):这是一种特殊类型的神经网络,主要用于处理图像数据。

-

循环神经网络(Recurrent Neural Networks, RNNs):这是一种处理序列数据的神经网络,例如时间序列数据或文本。

-

长短期记忆网络(Long Short-Term Memory, LSTM):这是一种特殊类型的RNN,能够解决传统RNN难以处理的长序列问题。

-

转移学习(Transfer Learning):这是一种利用预训练模型在新任务上进行微调的策略,可以显著减少训练时间和数据需求。

-

正则化(Regularization):这是一种防止模型过拟合的策略,包括L1和L2正则化、Dropout等。

-

批量归一化(Batch Normalization):这是一种在网络中加入额外层次,对输入进行归一化的策略,可以加速训练并提高模型性能。

-

注意力机制(Attention Mechanism):这是一种让模型在处理序列数据时,能够关注到输入数据的不同部分的策略。

以上只是深度学习的一部分知识点,实际上,深度学习是一个非常大且复杂的领域,包含了许多不同的模型和技术。

DeepSeek

深度学习是机器学习的一个分支,它通过构建多层的神经网络来模拟人脑处理信息的方式,从而实现对复杂数据的高效处理和分析。以下是深度学习的一些核心知识点总结:

1. 神经网络基础

-

感知机(Perceptron):单层神经网络,用于二分类问题。

-

多层感知机(MLP):包含多个隐藏层的神经网络,用于多分类问题。

-

激活函数:如Sigmoid、Tanh、ReLU等,用于引入非线性。

-

损失函数:如均方误差(MSE)、交叉熵损失(Cross-Entropy Loss)等,用于衡量模型预测与真实值之间的差异。

2. 反向传播算法

-

前向传播:计算网络输出。

-

反向传播:根据损失函数计算梯度,更新网络权重。

-

梯度下降:优化算法,用于最小化损失函数。

3. 卷积神经网络(CNN)

-

卷积层:通过卷积核提取图像特征。

-

池化层:降低特征维度,增强特征不变性。

-

全连接层:将提取的特征映射到输出空间。

4. 循环神经网络(RNN)

-

循环层:处理序列数据,记忆历史信息。

-

长短期记忆网络(LSTM):解决RNN中的梯度消失问题。

-

门控循环单元(GRU):LSTM的简化版。

5. 优化算法

-

随机梯度下降(SGD):每次迭代使用部分样本更新权重。

-

动量(Momentum):加速SGD在相关方向上的学习并抑制震荡。

-

自适应学习率方法:如Adam、RMSprop等,根据梯度自动调整学习率。

6. 正则化技术

-

L1/L2正则化:防止模型过拟合。

-

Dropout:随机丢弃神经元,减少神经元间的依赖性。

-

早停(Early Stopping):在验证集上性能不再提升时停止训练。

7. 数据预处理

-

归一化/标准化:将数据缩放到一定范围内,加速模型收敛。

-

数据增强:通过旋转、缩放等操作扩充数据集,提高模型泛化能力。

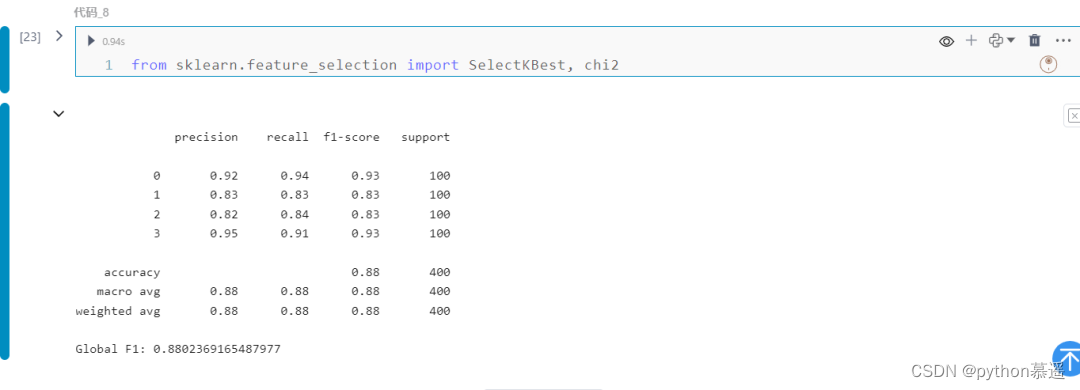

8. 模型评估

-

准确率(Accuracy):分类正确的样本占总样本的比例。

-

精确率(Precision):真正例占所有预测为正例的比例。

-

召回率(Recall):真正例占所有实际正例的比例。

-

F1分数:精确率和召回率的调和平均值。

9. 深度学习框架

-

TensorFlow:Google开发的开源深度学习框架。

-

PyTorch:Facebook开发的开源深度学习框架,以动态计算图著称。

-

Keras:高层次的神经网络API,可运行于TensorFlow、Theano等后端。

10. 应用领域

-

计算机视觉:图像分类、目标检测、图像分割等。

-

自然语言处理:文本分类、机器翻译、语音识别等。

-

强化学习:通过与环境交互学习策略。

深度学习是一个快速发展的领域,新的理论和技术不断涌现。上述知识点是深度学习的基础,掌握这些内容对于深入理解和应用深度学习至关重要。随着研究的深入,还会有更多高级的模型和算法被开发出来,推动深度学习技术的进步,以解决更加复杂的问题。

Kimi

深度学习是机器学习的一个子领域,它基于人工神经网络的学习算法。以下是深度学习的一些关键知识点的全面总结:

1. 基本概念

- 神经网络:模仿人脑工作方式的算法结构。

- 神经元:神经网络的基本单元,进行加权和、激活和输出。

- 激活函数:引入非线性,帮助网络学习复杂模式。

2. 主要架构

- 前馈神经网络(FNN):最基本的神经网络结构。

- 卷积神经网络(CNN):特别适用于处理图像数据。

- 循环神经网络(RNN):适合处理序列数据,如时间序列或自然语言。

- 长短期记忆网络(LSTM):一种特殊的RNN,能够学习长期依赖关系。

- 生成对抗网络(GAN):由两个网络组成,生成器和判别器,用于生成新的数据实例。

3. 训练过程

- 前向传播:数据通过网络的正向传递。

- 损失函数:衡量网络输出与真实值之间差异的函数。

- 反向传播:根据损失函数计算的梯度,更新网络权重。

4. 优化算法

- 梯度下降:最基本的优化算法。

- 随机梯度下降(SGD):每次更新只使用一个样本或一小批样本。

- Adam优化器:结合了动量和RMSProp的思想。

5. 正则化技术

- dropout:在训练过程中随机关闭一些神经元。

- 权重衰减:对权重的大小施加惩罚。

- 数据增强:通过变换数据来增加训练集的多样性。

6. 评估指标

- 准确率:正确分类的样本数占总样本数的比例。

- 精确度和召回率:用于不平衡数据集的评估。

- F1分数:精确度和召回率的调和平均。

7. 超参数

- 学习率:控制权重更新的步长。

- 批量大小:每次更新使用的样本数量。

- 迭代次数:训练过程中的迭代轮数。

8. 框架和工具

- TensorFlow:Google开发的开源框架。

- PyTorch:Facebook开发的开源框架。

- Keras:用户友好的高层神经网络API。

9. 应用领域

- 图像识别:使用CNN进行图像分类和检测。

- 自然语言处理(NLP):使用RNN和LSTM进行文本分析和生成。

- 语音识别:将语音转换为文本。

- 推荐系统:使用深度学习进行个性化推荐。

10. 伦理和社会影响

- 偏见和公平性:确保训练数据的多样性,避免算法偏见。

- 隐私:保护用户数据,遵守数据隐私法规。

- 可解释性:提高深度学习模型的透明度和可解释性。

11. 持续发展

- 迁移学习:利用预训练模型来加速学习过程。

- 强化学习:通过与环境的交互来学习策略。

- 分布式训练:使用多个GPU或TPU进行并行训练。

12. 挑战和限制

- 数据需求:需要大量标注数据。

- 计算资源:需要强大的硬件支持。

- 过拟合:模型在训练集上表现很好,但在未见数据上表现差。

这个总结提供了深度学习领域的一个高层次概览,每个主题都可以进一步深入研究和探索。随着技术的发展,新的算法、技术和应用将不断涌现。