大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。

本文主要介绍了2024年人工智能数据报告,希望能对学习人工智能的同学们有所帮助。

文章目录

- 1. 人工智能的发展现状

- 2. AI benchmark

- 2.1 NLP

- 2.2 CV

1. 人工智能的发展现状

到 2023 年为止,人工智能在多项任务中的表现已经超过了人类,下图清晰地展示了 AI 系统在九个代表性任务的 AI 基准测试中相对于人类基准的进步(比如,图像分类或基础阅读理解)。AI Index 团队针对每个任务选取了代表性的基准。

在过去几年中,AI 在诸如 2015 年的图像分类、2017 年的基础阅读理解、2020 年的视觉推理、2021 年的自然语言推理等多个领域已经超越了人类。然而到了 2023 年,AI 在一些领域,尤其是那些涉及更高级认知的任务如视觉常识推理和高级数学题目解题(竞赛级问题)中,还未能超过人类。

2. AI benchmark

2.1 NLP

如去年的报告所强调的,AI 技术性能的一个新兴主题是在多个基准测试中观察到的性能饱和现象,比如用来评价 AI 模型如 ImageNet 的熟练程度测试。这些测试的结果近几年趋于平稳,这可能意味着 AI 的能力已经达到一个顶峰,或者说明研究者们开始追求更高的复杂挑战。

由于这种饱和,2023 年的 AI 指标报告中的一些测试没有出现在今年的报告中。下图显示了那些包含在 2023 年但今年未展示的基准测试,以及这些测试自 2022 年以来的进展。其中“NA”表示无明显进步。

下图描绘了 2023 年 AI 指数报告中选定基准的年对年性能提升百分比。多数基准测试在初期会迅速实现显著性能增长,随后增速逐渐放缓。在最近几年,这些基准的进展微乎其微,甚至无任何提升。

为了解决基准测试普遍性饱和的问题,人工智能 (AI) 研究者们开始转向更具挑战性的测试。2024 年 AI Index 报告涵盖了多个新设的基准测试,包括编程、高级推理和主动性行为等领域,这些领域在以往的报告中鲜有涉及 (图 2.1.19)。

如上所述,近些年来,大语言模型已在包括 SQuAD(问题解答)和 SuperGLUE(语言理解)在内的传统英文基准测试中超越了人类。这种突飞猛进的发展促使我们需要更全面的评测标准。

2022 年,斯坦福的研究人员推出了 HELM,这是一个旨在全面评估大语言模型在多种场景下的表现的评测体系,涵盖阅读理解、语言理解和数学推理等领域。HELM 通过评估 Anthropic、Google、Meta 和 OpenAI 等领先企业的模型,并使用“平均胜率”作为衡量各场景平均表现的指标。到 2024 年 1 月,GPT-4 以 0.96 的高平均胜率领先于 HELM 的总排名;不过,在不同的任务类型中,有不同的模型表现最佳。

HELM 涵盖 10 种测试场景:包括 NarrativeQA(阅读理解)、两种 Natural Questions(开放书和封闭书的简答题回答)、OpenBookQA(常识问题回答)、MMLU(多学科理解)、GSM8K(小学级数学)、MATH(数学竞赛)、LegalBench(法律推理)、MedQA(医疗知识)和 WMT 2014(机器翻译)。

大规模多任务语言理解 (MMLU) 基准测试是用来评估模型在零样本 (zero-shot) 或少样本 (few-shot) 情景下的性能,涵盖了 57 个学科,包括人文学科、STEM 和社会科学 (图 2.2.5)。MMLU 已经成为评估大语言模型 (LLM) 能力的首选基准:许多最先进的模型,如 GPT-4、Claude 2 和 Gemini,都已经在 MMLU 上进行了评估。

2023 年初,GPT-4 在 MMLU 上取得了最先进的成绩,随后被 Google 的 Gemini Ultra 超越。图 2.2.6 显示了不同年份在 MMLU 基准测试上的顶尖模型分数。报告的分数是测试集的平均值。截至 2024 年 1 月,Gemini Ultra 保持最高分数 90.0%,自 2022 年以来增加了 14.8 个百分点,自 2019 年 MMLU 创立以来增加了 57.6 个百分点。Gemini Ultra 的分数是第一个超过 MMLU 的人类基线 89.8% 的。

在 2022 年的 ACL 大会上首次介绍的真实问答(TruthfulQA)是一个测试大语言模型 (LLMs) 答案真实性的标准。这个测试涵盖了包括健康、政治和金融在内的 38 个领域,共有约 800 个问题。这些问题专门设计来检验人们普遍存在的一些错误认知,这些认知往往会使人给出错误的答案 (图 2.2.9)。虽然研究发现更复杂的模型通常答案不够真实,但最新发布的 GPT-4 (RLHF) 在 2024 年早期已在这一标准测试中取得了最佳成绩,得分为 0.6 (图 2.2.10),这个成绩几乎是 2021 年基于 GPT-2 的模型的三倍,显示出大语言模型在不断进步,越来越能提供真实的答案。

正如我们之前提到的,大语言模型 (LLMs) 倾向于产生幻觉,这一点在它们被广泛应用于如法律和医疗这样的关键领域时尤其令人担忧。虽然很多研究都在探索幻觉的原因,但关于频繁发生幻觉的大语言模型及其特别容易出错的领域的研究还相对较少。

HaluEval 是在 2023 年推出的一个新的基准测试,专门用来评估大语言模型中的幻觉问题。它包含了超过 35,000 个样本,这些样本既有幻觉的也有正常的,用来通过大语言模型进行分析和评价。研究显示,ChatGPT 在其回答中大约 19.5% 的内容是捏造的不可验证信息,涉及语言、气候和技术等多个领域。此外,该研究还检验了目前的大语言模型在识别这些幻觉上的能力。下图展示了一些顶尖的大语言模型在不同任务中识别幻觉的能力,包括问答、知识驱动对话和文本总结等。这些发现强调了幻觉是一个严重且持续的问题。

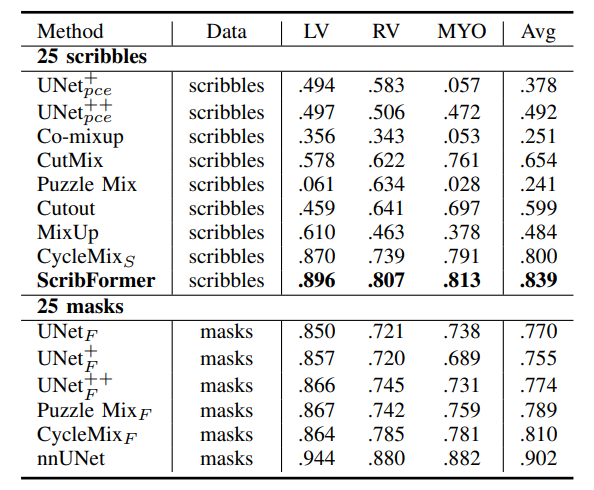

2.2 CV

随着 AI 文字转图片系统的快速进步,人们开发了更为复杂的评估方法。2023 年,斯坦福的研究者推出了全方位评估文转图模型 (HEIM) 的基准测试,该测试全面地从 12 个关键维度对图像生成器进行评估,这些维度在实际应用中极为重要,如图像与文本的对齐 (image-text alignment)、图像的质量 (image quality) 和美观度 (aesthetics)。[9] 该模型的评估依赖于人工评价,这一点非常关键,因为很多自动化指标难以精确地评价图像的各个方面。

HEIM 的研究结果显示,不存在一个模型能在所有标准上都是最佳的。在评估图像与文字的对齐度(即生成图像与输入文字的契合程度)时,OpenAI 的 DALL-E 2 表现最为出色。在图像质量(判断图像是否接近真实照片)、美观度(视觉吸引力的评估)及创新性(新颖图像生成和避免侵权的能力)上,基于 Stable Diffusion 的梦幻风格照相真实模型得分最高。

9 HEIM 的 12 个评价标准包括:(1) 对齐 (Alignment): 图像和给定文本的匹配程度有多高? (2) 质量 (Quality): 生成图像的质量如何? (3) 美感 (Aesthetic): 生成图像的审美水平怎样? (4) 创新性 (Originality): 图像展现了多少创意? (5) 推理能力 (Reasoning): 模型能否理解物体、数量及其空间关系? (6) 世界知识 (Knowledge): 模型对世界的了解程度如何? (7) 偏见 (Bias): 生成的图像中有无偏见? (8) 毒性 (Toxicity): 生成的图像是否包含不当内容? (9) 公正性 (Fairness): 生成图像是否有表现上的差异? (10) 稳健性 (Robust): 模型对输入变化的反应是否稳健? (11) 多语言支持 (Multilinguality): 模型是否支持多种语言? (12) 效率 (Efficiency): 模型处理速度快吗?

![【Pip】pip 安装第三方包异常:[SSL:CERTIFICATE_VERIFY_FAILED]解决方案](https://img-blog.csdnimg.cn/direct/a86a587fb65842c3a078c4dd54938aed.jpeg)