《博主简介》

小伙伴们好,我是阿旭。专注于人工智能、AIGC、python、计算机视觉相关分享研究。

✌更多学习资源,可关注公-仲-hao:【阿旭算法与机器学习】,共同学习交流~

👍感谢小伙伴们点赞、关注!

《------往期经典推荐------》

一、AI应用软件开发实战专栏【链接】

| 项目名称 | 项目名称 |

|---|---|

| 1.【人脸识别与管理系统开发】 | 2.【车牌识别与自动收费管理系统开发】 |

| 3.【手势识别系统开发】 | 4.【人脸面部活体检测系统开发】 |

| 5.【图片风格快速迁移软件开发】 | 6.【人脸表表情识别系统】 |

| 7.【YOLOv8多目标识别与自动标注软件开发】 | 8.【基于YOLOv8深度学习的行人跌倒检测系统】 |

| 9.【基于YOLOv8深度学习的PCB板缺陷检测系统】 | 10.【基于YOLOv8深度学习的生活垃圾分类目标检测系统】 |

| 11.【基于YOLOv8深度学习的安全帽目标检测系统】 | 12.【基于YOLOv8深度学习的120种犬类检测与识别系统】 |

| 13.【基于YOLOv8深度学习的路面坑洞检测系统】 | 14.【基于YOLOv8深度学习的火焰烟雾检测系统】 |

| 15.【基于YOLOv8深度学习的钢材表面缺陷检测系统】 | 16.【基于YOLOv8深度学习的舰船目标分类检测系统】 |

| 17.【基于YOLOv8深度学习的西红柿成熟度检测系统】 | 18.【基于YOLOv8深度学习的血细胞检测与计数系统】 |

| 19.【基于YOLOv8深度学习的吸烟/抽烟行为检测系统】 | 20.【基于YOLOv8深度学习的水稻害虫检测与识别系统】 |

| 21.【基于YOLOv8深度学习的高精度车辆行人检测与计数系统】 | 22.【基于YOLOv8深度学习的路面标志线检测与识别系统】 |

| 23.【基于YOLOv8深度学习的智能小麦害虫检测识别系统】 | 24.【基于YOLOv8深度学习的智能玉米害虫检测识别系统】 |

| 25.【基于YOLOv8深度学习的200种鸟类智能检测与识别系统】 | 26.【基于YOLOv8深度学习的45种交通标志智能检测与识别系统】 |

| 27.【基于YOLOv8深度学习的人脸面部表情识别系统】 | 28.【基于YOLOv8深度学习的苹果叶片病害智能诊断系统】 |

| 29.【基于YOLOv8深度学习的智能肺炎诊断系统】 | 30.【基于YOLOv8深度学习的葡萄簇目标检测系统】 |

| 31.【基于YOLOv8深度学习的100种中草药智能识别系统】 | 32.【基于YOLOv8深度学习的102种花卉智能识别系统】 |

| 33.【基于YOLOv8深度学习的100种蝴蝶智能识别系统】 | 34.【基于YOLOv8深度学习的水稻叶片病害智能诊断系统】 |

| 35.【基于YOLOv8与ByteTrack的车辆行人多目标检测与追踪系统】 | 36.【基于YOLOv8深度学习的智能草莓病害检测与分割系统】 |

| 37.【基于YOLOv8深度学习的复杂场景下船舶目标检测系统】 | 38.【基于YOLOv8深度学习的农作物幼苗与杂草检测系统】 |

| 39.【基于YOLOv8深度学习的智能道路裂缝检测与分析系统】 | 40.【基于YOLOv8深度学习的葡萄病害智能诊断与防治系统】 |

| 41.【基于YOLOv8深度学习的遥感地理空间物体检测系统】 | 42.【基于YOLOv8深度学习的无人机视角地面物体检测系统】 |

| 43.【基于YOLOv8深度学习的木薯病害智能诊断与防治系统】 | 44.【基于YOLOv8深度学习的野外火焰烟雾检测系统】 |

| 45.【基于YOLOv8深度学习的脑肿瘤智能检测系统】 | 46.【基于YOLOv8深度学习的玉米叶片病害智能诊断与防治系统】 |

| 47.【基于YOLOv8深度学习的橙子病害智能诊断与防治系统】 | 48.【车辆检测追踪与流量计数系统】 |

| 49.【行人检测追踪与双向流量计数系统】 |

二、机器学习实战专栏【链接】,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

引言

手部关键点检测是计算机视觉领域的一项重要技术,主要用于识别与定位手部在图像或视频中的关键位置点,如指关节和手腕等。通过精确识别这些关键点,我们可以获取到手部的精确姿态和手势信息。

手部关键点检测在许多领域都有着广泛的应用可能性。例如,在人机交互中,通过检测用户的手部关键点和手势,计算机可以实现无触摸的交互界面,这对于虚拟现实(VR)和增强现实(AR)应用尤为重要。此外,在健康医疗领域,可以通过对患者手部的关键点检测,来评估和诊断一些由手部动作异常引发的疾病,如帕金森氏症等。再比如,手部关键点检测也可以用于机器人视觉系统,通过对人手的识别和理解,使得机器人能更好地协作和交互。它还在手语识别、动作捕捉、游戏控制等场景找到了广泛应用。

本文介绍了一个基于OpenCV和cvzone库的实时手部跟踪系统,附全部源码,并对源码内容进行了详细讲解。

实现步骤详解

实现效果

摄像头初始化

import cv2

# 初始化摄像头以捕捉视频

# 通常 '0' 指内置摄像头

cap = cv2.VideoCapture(0)

摄像头初始化:通过cv2.VideoCapture(0)初始化摄像头,通常情况下0代表默认摄像头,但这里设置为2,意味着可能连接了多个摄像头,选择第三个摄像头作为输入源。

手部检测器配置

# 初始化 HandDetector 类并设置参数

detector = HandDetector(staticMode=False, # 非静态模式,持续检测

maxHands=2, # 最多检测两只手

modelComplexity=1, # 手部识别模型复杂度

detectionCon=0.5, # 手部检测的最小置信度

minTrackCon=0.5) # 追踪的最小置信度

创建HandDetector对象,配置参数如最大检测手数、模型复杂度、检测和追踪的最小置信度,这些参数平衡了检测速度和准确性。

实时帧处理循环

实时帧处理循环:程序进入一个无限循环,不断从摄像头读取视频帧。对于每一帧进行:

手部检测:利用findHands方法检测画面中的手部,同时根据配置参数在图像上绘制手部轮廓和关键点。

# 实时从摄像头获取帧

while True:

# 读取每一帧图像

# 'success' 表示是否成功捕获,'img' 存储捕获的图像

success, img = cap.read()

# 在当前帧中寻找手部

# 'draw' 参数决定是否在图像上绘制手部关键点和边界框

# 'flipType' 翻转图像,便于某些检测操作

hands, img = detector.findHands(img, draw=True, flipType=True)

获取关键点并计算手指间距

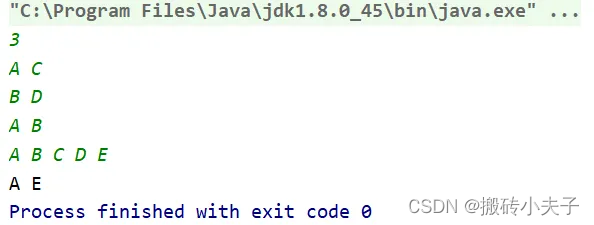

手指计数:对每只检测到的手,使用fingersUp方法计算并打印出抬起的手指数。

# 计算第一只手抬起的手指数量

fingers1 = detector.fingersUp(hand1)

print(f'H1 = {fingers1.count(1)}', end=" ") # 输出抬起手指的数量

手指间距离计算:计算第一只手的食指和中指指尖之间的距离,并在图像上用特定颜色标出。

# 定位食指和中指指尖

tipOfIndexFinger = lmList1[8][0:2]

tipOfMiddleFinger = lmList1[12][0:2]

# 计算并绘制食指与中指指尖间的距离

length, info, img = detector.findDistance(tipOfIndexFinger, tipOfMiddleFinger, img, color=(255, 0, 255), scale=5)

双手中指距离计算:如果有两只手被检测到,还计算两只手的食指指尖之间的距离,同样在图像上标出。

# 计算第二只手抬起的手指数量

fingers2 = detector.fingersUp(hand2)

print(f'H2 = {fingers2.count(1)}', end=" ")

# 定位第二只手的食指指尖

tipOfIndexFinger2 = lmList2[8][0:2]

# 计算并绘制两只手食指指尖间的距离

length, info, img = detector.findDistance(tipOfIndexFinger, tipOfIndexFinger2, img, color=(255, 0, 0), scale=10)

图像显示

# 显示处理后的图像

cv2.imshow("图像", img)

# 保持窗口打开,等待1毫秒后显示下一帧

cv2.waitKey(1)

使用imshow函数在名为"图像"的窗口中显示处理后的图像。

整个程序的核心在于利用HandDetector类提供的功能来实时检测和分析手部特征。这使得它能够应用于各种应用场景,如手势识别、游戏控制、无障碍交互等。通过实时更新图像并显示手部信息,用户可以直观地看到手部检测和分析的结果。

完成源码

# 导入所需库

from cvzone.HandTrackingModule import HandDetector

import cv2

# 初始化摄像头以捕捉视频

# 通常 '0' 指内置摄像头

cap = cv2.VideoCapture(0)

# 初始化 HandDetector 类并设置参数

detector = HandDetector(staticMode=False, # 非静态模式,持续检测

maxHands=2, # 最多检测两只手

modelComplexity=1, # 手部识别模型复杂度

detectionCon=0.5, # 手部检测的最小置信度

minTrackCon=0.5) # 追踪的最小置信度

# 实时从摄像头获取帧

while True:

# 读取每一帧图像

# 'success' 表示是否成功捕获,'img' 存储捕获的图像

success, img = cap.read()

# 在当前帧中寻找手部

# 'draw' 参数决定是否在图像上绘制手部关键点和边界框

# 'flipType' 翻转图像,便于某些检测操作

hands, img = detector.findHands(img, draw=True, flipType=True)

# 检查是否检测到手

if hands:

# 获取第一只手的信息

hand1 = hands[0] # 第一只手

lmList1 = hand1["lmList"] # 21个关键点坐标列表

bbox1 = hand1["bbox"] # 手部边界框坐标

center1 = hand1['center'] # 手心中心点坐标

handType1 = hand1["type"] # 手型("Left" 或 "Right")

# 计算第一只手抬起的手指数量

fingers1 = detector.fingersUp(hand1)

print(f'H1 = {fingers1.count(1)}', end=" ") # 输出抬起手指的数量

# 定位食指和中指指尖

tipOfIndexFinger = lmList1[8][0:2]

tipOfMiddleFinger = lmList1[12][0:2]

# 计算并绘制食指与中指指尖间的距离

length, info, img = detector.findDistance(tipOfIndexFinger, tipOfMiddleFinger, img, color=(255, 0, 255), scale=5)

# 检查是否有第二只手

if len(hands) == 2:

# 获取第二只手的信息

hand2 = hands[1]

lmList2 = hand2["lmList"]

bbox2 = hand2["bbox"]

center2 = hand2['center']

handType2 = hand2["type"]

# 计算第二只手抬起的手指数量

fingers2 = detector.fingersUp(hand2)

print(f'H2 = {fingers2.count(1)}', end=" ")

# 定位第二只手的食指指尖

tipOfIndexFinger2 = lmList2[8][0:2]

# 计算并绘制两只手食指指尖间的距离

length, info, img = detector.findDistance(tipOfIndexFinger, tipOfIndexFinger2, img, color=(255, 0, 0), scale=10)

print() # 打印换行,提高输出可读性

# 显示处理后的图像

cv2.imshow("图像", img)

# 保持窗口打开,等待1毫秒后显示下一帧

cv2.waitKey(1)

好了,这篇文章就介绍到这里,喜欢的小伙伴感谢给点个赞和关注,更多精彩内容持续更新~~

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!