-

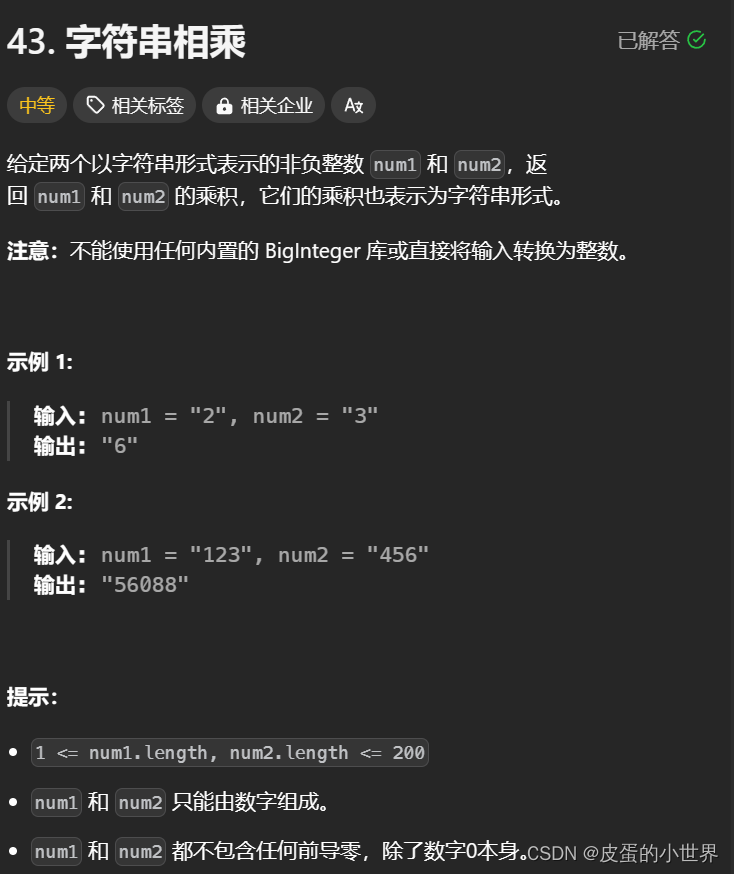

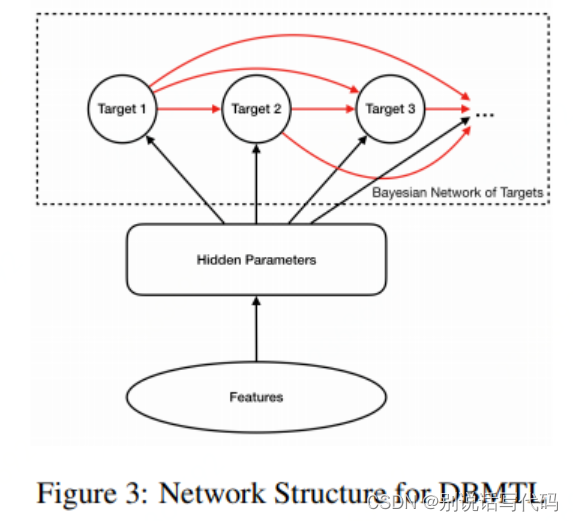

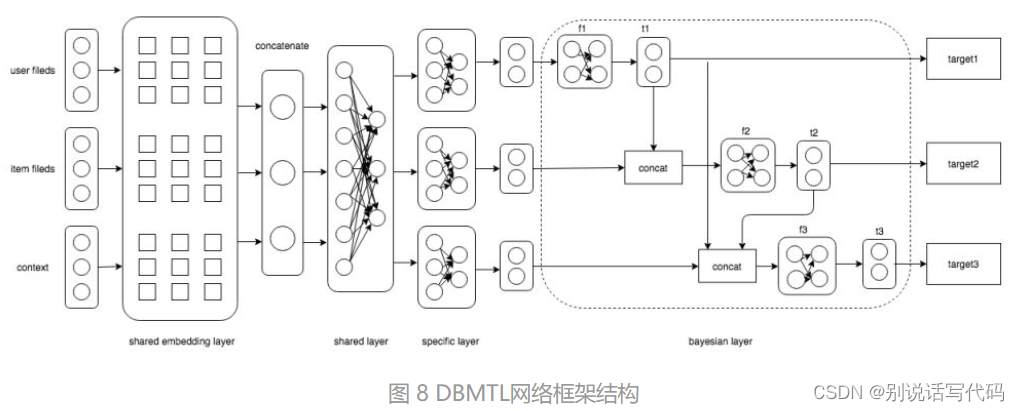

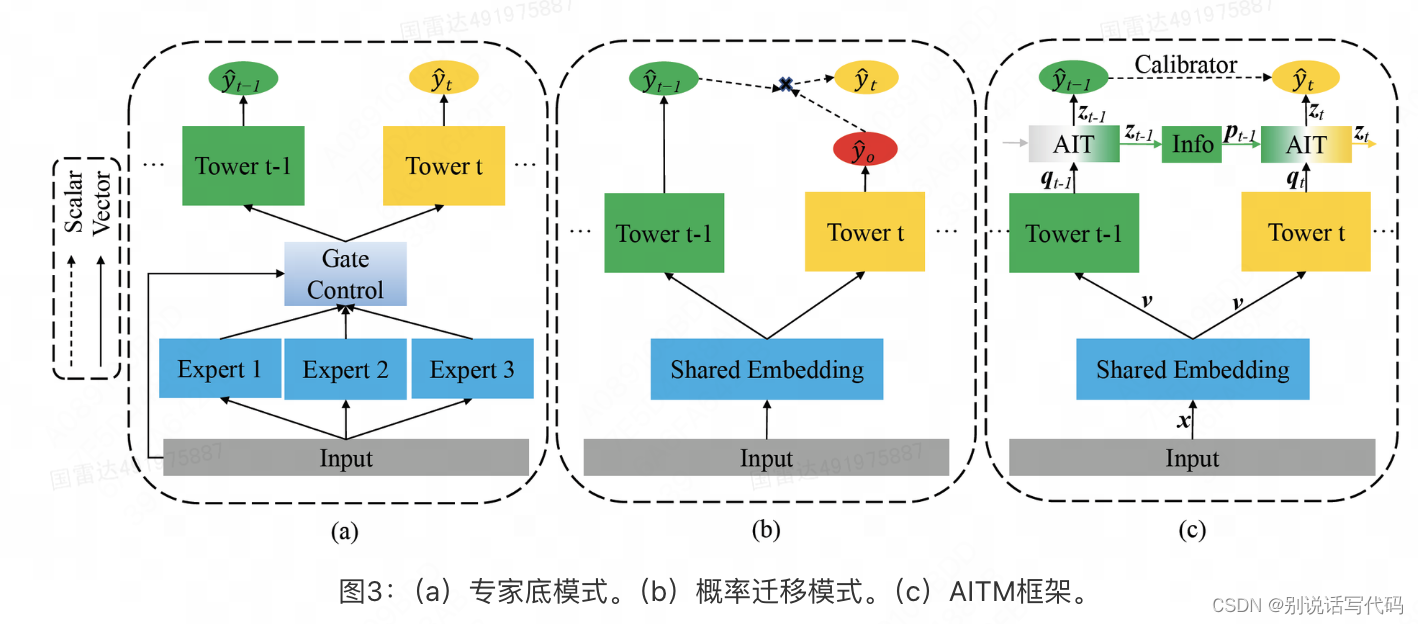

DBMTL:通过前序目标输出作为后序目标输入刻画概率转移关系,概率关系的刻画是通过MLP来刻画的;目标之间如果存在内在联系,稀疏目标能利用非稀疏目标中的信息,得到特殊收益;

-

DBMTL与ESMM区别:直接ctr和cvr双塔相乘,是基于用户点击和点击之后再转换两个事件是独立的,可直接相乘,而拼接再过MLP的形式本身放宽了这一假设,两者没有必要是独立的,关系可以通过MLP来进行学习,进而得到CTCVR

-

AIT自适应信息迁移:在点击塔输出embedding后(倒数第2层,最后一层是1个节点sigmoid)后接一个32维MLP作为Info,后用一个AttentionLayer融合计算转化塔的输出和Info,然后转化塔在后面接1个sigmoid。具体为啥用Attention参考论文。后面损失加一个转化概率-点击概率的约束(感觉没必要,作用很小)。其实利用了特殊设计的注意力机制来自动为迁移信息pt-1 (点击)和原始信息qt (支付)来分配权重,而迁移的信息pt-1 是通过函数gt-1 (·)来学习的,这里gt-1 (·)可以是一个简单的全连接层,用来学习两个相邻的任务间应该迁移什么信息。而该函数的输入zt-1 是前一个任务的AIT模块的输出。也就是先对点击它倒数第二层后接一个32维MLP和Relu,然后与支付倒数第二层concat再过一个self-att自动为迁移信息(点击)和原始信息(支付)学习权重。

![[leetcode] 64. 最小路径和](https://img-blog.csdnimg.cn/direct/a36c1b59f2eb48eebd27dc7ba26116ca.png)