目录

1、metastore服务

1.1、metastore运行模式

1.2、metastore部署

1.3、测试

2、编写Hive服务启动脚本

3、Hive使用技巧

3.1、Hive常用交互命令

3.2、Hive参数配置方式

3.3、Hive常见属性配置

1、metastore服务

Hive的metastore服务的作用是为Hive CLI或者Hiveserver2提供元数据访问接口。

1.1、metastore运行模式

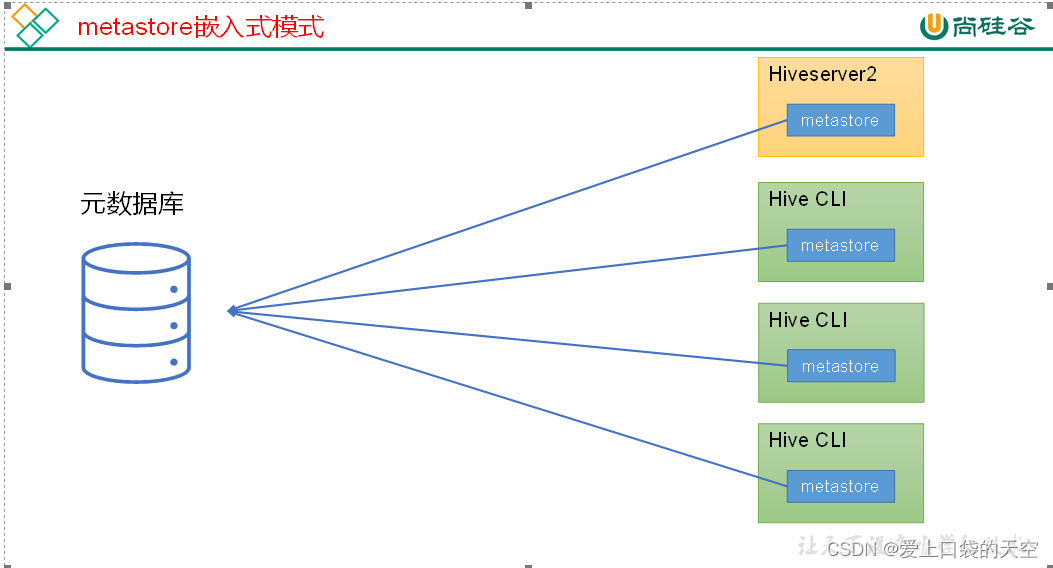

metastore有两种运行模式,分别为嵌入式模式和独立服务模式。下面分别对两种模式进行说明:

(1)嵌入式模式

(2)独立服务模式

生产环境中,不推荐使用嵌入式模式。因为其存在以下两个问题:

(1)嵌入式模式下,每个Hive CLI都需要直接连接元数据库,当Hive CLI较多时,数据库压力会比较大。

(2)每个客户端都需要用户元数据库的读写权限,元数据库的安全得不到很好的保证。

1.2、metastore部署

(1)嵌入式模式

嵌入式模式下,只需保证Hiveserver2和每个Hive CLI的配置文件hive-site.xml中包含连接元数据库所需要的以下参数即可:

<!-- jdbc连接的URL -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop102:3306/metastore?useSSL=false</value>

</property>

<!-- jdbc连接的Driver-->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- jdbc连接的username-->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- jdbc连接的password -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

(2)独立服务模式

独立服务模式需做以下配置:

首先,保证metastore服务的配置文件hive-site.xml中包含连接元数据库所需的以下参数:

(注意:这里我们将之前的hadoop102上的hive目录拷贝一份到hadoop103服务下面这个metastore部署在hadoop102)

<!-- jdbc连接的URL -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop102:3306/metastore?useSSL=false</value>

</property>

<!-- jdbc连接的Driver-->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- jdbc连接的username-->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- jdbc连接的password -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

其次,保证Hiveserver2和每个Hive CLI的配置文件hive-site.xml中包含访问metastore服务所需的以下参数,注意:这个就再hadoop103上面配置:

<!-- 指定metastore服务的地址 -->

<property>

<name>hive.metastore.uris</name>

<value>thrift://hadoop102:9083</value>

</property>

注意:主机名需要改为metastore服务所在节点,端口号无需修改,metastore服务的默认端口就是9083。

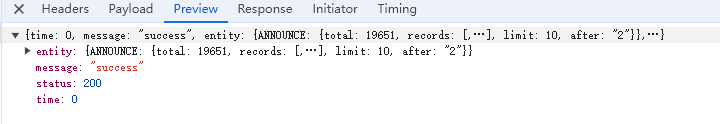

1.3、测试

此时启动Hive CLI,执行shou databases语句,会出现一下错误提示信息:

hive (default)> show databases;

FAILED: HiveException java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

这是因为我们在Hive CLI的配置文件中配置了hive.metastore.uris参数,此时Hive CLI会去请求我们执行的metastore服务地址,所以必须启动metastore服务才能正常使用

metastore服务的启动命令如下:

[kgf@hadoop202 hive]$ hive --service metastore

2022-04-24 16:58:08: Starting Hive Metastore Server

注意:启动后该窗口不能再操作,需打开一个新的Xshell窗口来对Hive操作。

重新启动 Hive CLI,并执行shou databases语句,就能正常访问了

2、编写Hive服务启动脚本

1)前台启动的方式导致需要打开多个Xshell窗口,可以使用如下方式后台方式启动

- nohup:放在命令开头,表示不挂起,也就是关闭终端进程也继续保持运行状态

- /dev/null:是Linux文件系统中的一个文件,被称为黑洞,所有写入该文件的内容都会被自动丢弃

- 2>&1:表示将错误重定向到标准输出上

- &:放在命令结尾,表示后台运行

一般会组合使用:nohup [xxx命令操作]> file 2>&1 &,表示将xxx命令运行的结果输出到file中,并保持命令启动的进程在后台运行

[kgf@hadoop202 hive]$ nohup hive --service metastore 2>&1 &

[kgf@hadoop202 hive]$ nohup hive --service hiveserver2 2>&1 &

2)为了方便使用,可以直接编写脚本来管理服务的启动和关闭

[kgf@hadoop102 hive]$ vim $HIVE_HOME/bin/hiveservices.sh

内容如下:

#!/bin/bash

HIVE_LOG_DIR=$HIVE_HOME/logs

if [ ! -d $HIVE_LOG_DIR ]

then

mkdir -p $HIVE_LOG_DIR

fi

#检查进程是否运行正常,参数1为进程名,参数2为进程端口

function check_process()

{

pid=$(ps -ef 2>/dev/null | grep -v grep | grep -i $1 | awk '{print $2}')

ppid=$(netstat -nltp 2>/dev/null | grep $2 | awk '{print $7}' | cut -d '/' -f 1)

echo $pid

[[ "$pid" =~ "$ppid" ]] && [ "$ppid" ] && return 0 || return 1

}

function hive_start()

{

metapid=$(check_process HiveMetastore 9083)

cmd="nohup hive --service metastore >$HIVE_LOG_DIR/metastore.log 2>&1 &"

[ -z "$metapid" ] && eval $cmd || echo "Metastroe服务已启动"

server2pid=$(check_process HiveServer2 10000)

cmd="nohup hive --service hiveserver2 >$HIVE_LOG_DIR/hiveServer2.log 2>&1 &"

[ -z "$server2pid" ] && eval $cmd || echo "HiveServer2服务已启动"

}

function hive_stop()

{

metapid=$(check_process HiveMetastore 9083)

[ "$metapid" ] && kill $metapid || echo "Metastore服务未启动"

server2pid=$(check_process HiveServer2 10000)

[ "$server2pid" ] && kill $server2pid || echo "HiveServer2服务未启动"

}

case $1 in

"start")

hive_start

;;

"stop")

hive_stop

;;

"restart")

hive_stop

sleep 2

hive_start

;;

"status")

check_process HiveMetastore 9083 >/dev/null && echo "Metastore服务运行正常" || echo "Metastore服务运行异常"

check_process HiveServer2 10000 >/dev/null && echo "HiveServer2服务运行正常" || echo "HiveServer2服务运行异常"

;;

*)

echo Invalid Args!

echo 'Usage: '$(basename $0)' start|stop|restart|status'

;;

esac

3)添加执行权限

[kgf@hadoop102 hive]$ chmod +x $HIVE_HOME/bin/hiveservices.sh

4)启动Hive后台服务

[kgf@hadoop102 hive]$ hiveservices.sh start

3、Hive使用技巧

3.1、Hive常用交互命令

[kgf@hadoop102 hive]$ bin/hive -help

usage: hive

-d,--define <key=value> Variable subsitution to apply to hive

commands. e.g. -d A=B or --define A=B

--database <databasename> Specify the database to use

-e <quoted-query-string> SQL from command line

-f <filename> SQL from files

-H,--help Print help information

--hiveconf <property=value> Use value for given property

--hivevar <key=value> Variable subsitution to apply to hive

commands. e.g. --hivevar A=B

-i <filename> Initialization SQL file

-S,--silent Silent mode in interactive shell

-v,--verbose Verbose mode (echo executed SQL to the console)

1)在Hive命令行里创建一个表student,并插入1条数据

hive (default)> create table student(id int,name string);

OK

Time taken: 1.291 seconds

hive (default)> insert into table student values(1,"zhangsan");

hive (default)> select * from student;

OK

student.id student.name

1 zhangsan

Time taken: 0.144 seconds, Fetched: 1 row(s)

2)“-e”不进入hive的交互窗口执行hql语句

[kgf@hadoop102 hive]$ bin/hive -e "select id from student;"

3)“-f”执行脚本中的hql语句

(1)在/opt/module/hive/下创建datas目录并在datas目录下创建hivef.sql文件

[kgf@hadoop102 hive]$ mkdir datas

[kgf@hadoop102 datas]$ vim hivef.sql

(2)文件中写入正确的hql语句

select * from student;

(3)执行文件中的hql语句

[kgf@hadoop102 hive]$ bin/hive -f /opt/module/hive/datas/hivef.sql

(4)执行文件中的hql语句并将结果写入文件中

[kgf@hadoop102 hive]$ bin/hive -f /opt/module/hive/datas/hivef.sql > /opt/module/hive/datas/hive_result.txt

3.2、Hive参数配置方式

1)查看当前所有的配置信息

hive>set;

2)参数的配置三种方式

(1)配置文件方式

- 默认配置文件:hive-default.xml

- 用户自定义配置文件:hive-site.xml

注意:用户自定义配置会覆盖默认配置。另外,Hive也会读入Hadoop的配置,因为Hive是作为Hadoop的客户端启动的,Hive的配置会覆盖Hadoop的配置。配置文件的设定对本机启动的所有Hive进程都有效。

(2)命令行参数方式

①启动Hive时,可以在命令行添加-hiveconf param=value来设定参数。例如:

[kgf@hadoop103 hive]$ bin/hive -hiveconf mapreduce.job.reduces=10;

注意:仅对本次Hive启动有效。

②查看参数设置

hive (default)> set mapreduce.job.reduces;

(3)参数声明方式

可以在HQL中使用SET关键字设定参数,例如:

hive(default)> set mapreduce.job.reduces=10;

注意:仅对本次Hive启动有效。

查看参数设置:

hive(default)> set mapreduce.job.reduces;

上述三种设定方式的优先级依次递增。即配置文件 < 命令行参数 < 参数声明。注意某些系统级的参数,例如log4j相关的设定,必须用前两种方式设定,因为那些参数的读取在会话建立以前已经完成了。

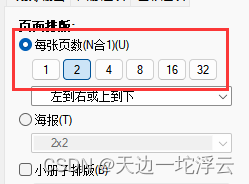

3.3、Hive常见属性配置

1)Hive客户端显示当前库和表头

(1)在hive-site.xml中加入如下两个配置:

[kgf@hadoop102 conf]$ vim hive-site.xml

<property>

<name>hive.cli.print.header</name>

<value>true</value>

<description>Whether to print the names of the columns in query output.</description>

</property>

<property>

<name>hive.cli.print.current.db</name>

<value>true</value>

<description>Whether to include the current database in the Hive prompt.</description>

</property>

(2)hive客户端在运行时可以显示当前使用的库和表头信息

[kgf@hadoop102 conf]$ hive

hive (default)> select * from stu;

OK

stu.id stu.name

1 ss

Time taken: 1.874 seconds, Fetched: 1 row(s)

hive (default)>

2)Hive运行日志路径配置

(1)Hive的log默认存放在/tmp/atguigu/hive.log目录下(当前用户名下)

[kgf@hadoop102 kgf]$ pwd

/tmp/kgf

[kgf@hadoop102 kgf]$ ls

hive.log

hive.log.2022-06-27

(2)修改Hive的log存放日志到/opt/module/hive/logs

1) 修改$HIVE_HOME/conf/hive-log4j2.properties.template文件名称为

hive-log4j2.properties

[kgf@hadoop102 conf]$ pwd

/opt/module/hive/conf

[kgf@hadoop102 conf]$ mv hive-log4j2.properties.template hive-log4j2.properties

2)在hive-log4j2.properties文件中修改log存放位置

property.hive.log.dir=/opt/module/hive/logs

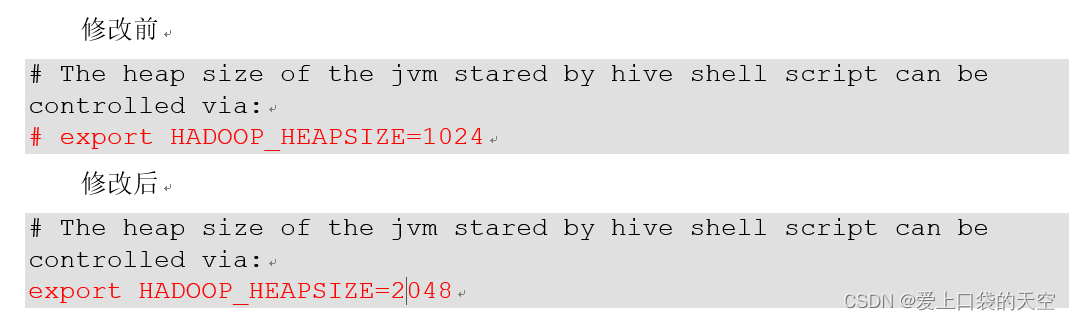

3)Hive的JVM堆内存设置

新版本的Hive启动的时候,默认申请的JVM堆内存大小为256M,JVM堆内存申请的太小,导致后期开启本地模式,执行复杂的SQL时经常会报错:java.lang.OutOfMemoryError: Java heap space,因此最好提前调整一下HADOOP_HEAPSIZE这个参数。

(1)修改$HIVE_HOME/conf下的hive-env.sh.template为hive-env.sh

[kgf@hadoop102 conf]$ pwd

/opt/module/hive/conf

[kgf@hadoop102 conf]$ mv hive-env.sh.template hive-env.sh

(2)将hive-env.sh其中的参数 export HADOOP_HEAPSIZE修改为2048,重启Hive。

4)关闭Hadoop虚拟内存检查

在yarn-site.xml中关闭虚拟内存检查(虚拟内存校验,如果已经关闭了,就不需要配了)。

(1)修改前记得先停Hadoop

[kgf@hadoop102 hadoop]$ pwd

/opt/module/hadoop-3.1.3/etc/hadoop

[kgf@hadoop102 hadoop]$ vim yarn-site.xml

(2)添加如下配置

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

(3)修改完后记得分发yarn-site.xml,并重启yarn。