Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-CjEOAdsm-1673679260352)(Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction.assets/image-20230113160859808.png)]](https://img-blog.csdnimg.cn/ffb9c82cdd2d4466bf430128f85eb2c1.png)

论文:2210.05958.pdf (arxiv.org)

代码:zhangzx-uiuc/AMR-IE: The code repository for AMR guided joint information extraction model (NAACL-2021). (github.com)

期刊/会议:NAACL2021

摘要

富语义解析的任务,如抽象语义表示(AMR),与信息抽取(IE)具有相似的目标,即将自然语言文本转换为结构化的语义表示。为了利用这种相似性,我们提出了一种新的AMR引导框架,用于联合信息抽取,以在预先训练的AMR解析器的帮助下发现实体、关系和事件。该框架由两个新组件组成:1)基于AMR的语义图聚合器,让候选实体和事件触发词节点从AMR图中收集邻域信息,以便在相关知识元素之间传递消息;2) AMR引导图解码器,根据AMR中层次结构决定的顺序提取知识元素。在多个数据集上的实验表明,AMR图编码器和解码器提供了显著的增益,我们的方法在所有IE子任务上都达到了SOTA。

1、简介

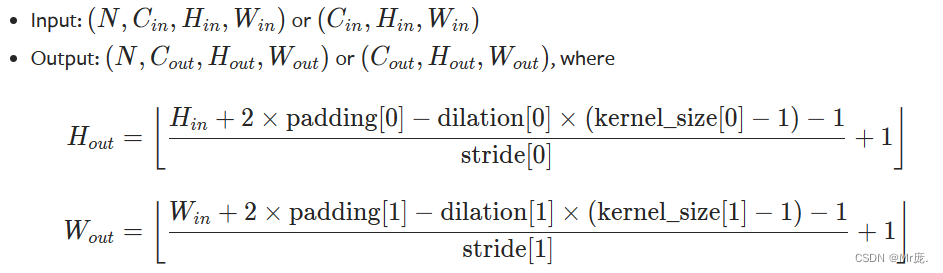

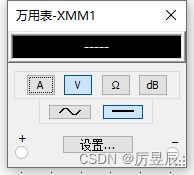

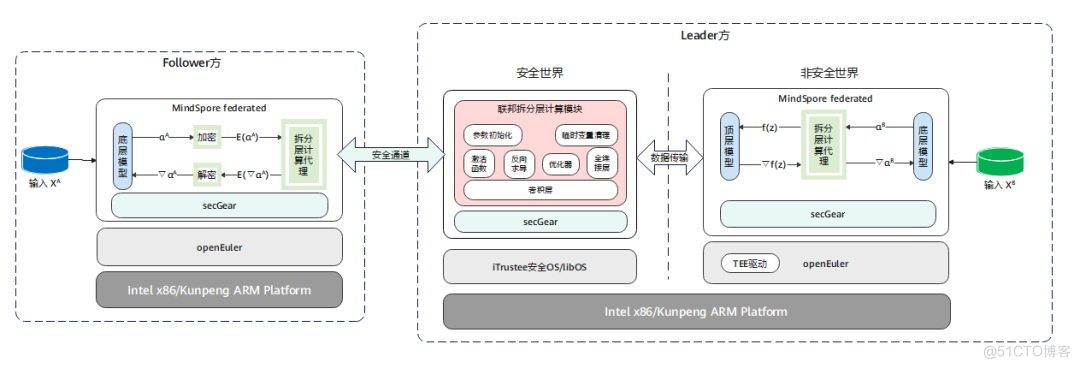

信息提取(IE)旨在从非结构化自然语言文本中抽取结构化知识作为信息网络,而语义解析试图构建语义图来总结输入文本的含义。由于它们都侧重于从句子中抽取主要信息,因此输出信息网络和语义图在节点语义和边缘语义方面有很多共同之处。如图1所示的例子中,信息网络中的许多知识元素可以与语义图中具有相似语义的某些节点完美匹配。此外,这两种类型的图在网络拓扑结构方面也可能相似。更进一步来说,语义图中相邻或通过几跳连接(few hops)的节点在相应的信息网络中也可能彼此接近。在图1中,我们可以看到“Scott Peterson”作为两个事件触发词“murders”和“faces”的共享论元,也直接连接到语义图中的两个主要谓词murder-01和face-01。从全局的角度来看,信息网络可以近似地看作是语义解析的子图,其中IE节点大致是语义图中节点的一个子集,同时保持相似的相互连接。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-uH2C8kCn-1673679260354)(Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction.assets/image-20230113194339460.png)]](https://img-blog.csdnimg.cn/e1175e1f6ec34400950a64ed4fee0776.png#pic_center)

为了进一步挖掘和利用这些相似性进行信息抽取,我们提出了一个直观有效的框架,利用语义解析中的信息,去抽取细胞系网络组成的实体、关系、事件触发词和事件论元。我们采用抽象语义表示(AMR)作为我们的输入语义图,AMR包含丰富的语义结构和细粒度的节点和边类型。与以往的IE模型相比,我们提出的模型主要由以下两个新颖的组成部分组成。

AMR-Guided Graph Encoding:AMR图拓扑可以直接告知IE模型一些知识元素之间的全局相互依赖关系,即使它们位于原始句子中很远的位置。这样的属性使IE模型更容易捕获一些非本地长距离连接,用于关系和事件论元角色标记。我们设计了一个基于图注意力网络(GAT)的语义图聚合器(semantic graph aggregator),让候选实体和事件触发词节点聚合来自语义图的邻域信息,以便在相关知识元素之间传递消息。在我们的模型中使用的GAT架构是专门设计来允许节点和边缘特征之间的交互,从而可以有效地利用AMR中丰富的边类型。

AMR-Condition Graph Decoding:这两类图中的大量节点具有相似的含义,这使得在信息网络和语义图之间获得有意义的节点对齐成为可能。这种对齐提供了在联合IE模型的解码部分设计更有组织的方法的潜在机会。我们提出了一种新的**分层解码(hierarchical decoding)**方法,而不是像以前的模型(如OneIE)那样使用顺序解码,其中知识元素的类型根据它们在原始句子中的位置从左到右确定。我们使用AMR解析作为确定解码知识元素顺序的条件,其中节点和边基于语义图层次结构以树状顺序确定。

在多个数据集上的实验结果表明,我们提出的模型在所有IE子任务上都显著优于现有的技术。

2、问题描述

我们重点从输入句子中提取实体、关系、事件触发词及其论元,形成一个信息网络。请注意,我们模型中的AMR图不需要一定是对的(ground-truth),而是由预先训练的AMR解析器生成的。因此,我们不包含额外的信息,我们的问题设置与典型的联合信息提取方法相同,如DyGIE++和OneIE。给定一个输入句子 S = { w 1 , w 2 , . . . , w N } S = \{w_1, w_2,...,w_N\} S={w1,w2,...,wN},我们将我们的联合信息抽取问题表述如下。

实体抽取:实体提取的目的是将词跨度识别为实体提及,并将其分类为预定义的实体类型。给定实体类型集合

E

E

E,实体抽取任务是输出实体提及的集合

ε

\varepsilon

ε:

ε

=

{

ε

i

=

(

a

i

,

b

i

,

e

i

)

∣

a

i

≤

b

i

,

e

i

∈

E

}

\varepsilon=\{ \varepsilon_i=(a_i,b_i,e_i)| a_i \le b_i,e_i \in E \}

ε={εi=(ai,bi,ei)∣ai≤bi,ei∈E}

a

i

,

b

i

∈

{

1

,

2

,

.

.

.

,

N

}

a_i,b_i \in \{ 1,2,...,N\}

ai,bi∈{1,2,...,N}指的是抽取的实体提及开始索引和结束索引,

e

i

e_i

ei表示的是实体的类型,在集合

E

E

E中。如图1所示,实体提及“Scott Peterson”将被表示为

(0,1PER)

\text{(0,1PER)}

(0,1PER)。

关系抽取:关系抽取的任务是将关系类型分配给所抽取实体中提到的每个可能的有序对。给定标识的实体提及

E

E

E和预定义的关系类型

R

R

R,关系集被抽取为

R

=

{

r

i

=

(

ε

i

,

ε

j

,

l

i

j

r

)

∣

l

i

j

r

∈

R

,

ε

i

,

ε

j

∈

ε

}

R=\{ r_i=(\varepsilon_i,\varepsilon_j,l_{ij}^r) | l_{ij}^r \in R,\varepsilon_i,\varepsilon_j \in \varepsilon \}

R={ri=(εi,εj,lijr)∣lijr∈R,εi,εj∈ε}

ε

i

,

ε

j

\varepsilon_i,\varepsilon_j

εi,εj是从

ε

\varepsilon

ε中选出的实体提及,其中

i

,

j

∈

{

1

,

2

,

.

.

.

,

∣

ε

∣

}

i,j \in \{ 1,2,...,|\varepsilon|\}

i,j∈{1,2,...,∣ε∣}。如图1中的关系提及所示"

("their","son",PER-SOC)

\text{("their","son",PER-SOC)}

("their","son",PER-SOC)"。

事件抽取:事件抽取的任务包括提取事件触发词及其论元。事件触发词提取是从事件类型集

T

T

T中识别出最清楚地表明某一类型事件发生的单词或短语,可以表述为:

T

=

{

T

i

=

(

p

i

,

q

i

,

t

i

)

∣

p

i

≤

q

i

,

t

i

∈

T

}

T=\{ T_i = (p_i,q_i,t_i)|p_i \le q_i, t_i \in T \}

T={Ti=(pi,qi,ti)∣pi≤qi,ti∈T}

p

i

,

q

i

∈

{

1

,

2

,

.

.

.

,

N

}

p_i,q_i \in \{1,2,...,N\}

pi,qi∈{1,2,...,N}指的是抽取出的事件提及开始位置索引和结束位置索引,

t

i

t_i

ti为

T

T

T中的事件类型。给定预定义的事件论元集

A

A

A,事件论元抽取的任务是为每个触发词和实体对分配一个论元角色标签,以指示实体提及是否充当事件的某个特定角色,这被表述为抽取的论元集

Λ

\Lambda

Λ

Λ

=

{

α

i

=

(

T

i

,

ε

j

,

l

i

j

a

)

∣

l

i

j

a

∈

A

,

T

i

∈

A

,

ε

j

∈

ε

}

\Lambda=\{ \alpha_i=(T_i,\varepsilon_j,l_{ij}^a)|l_{ij}^a\in A,T_i\in A,\varepsilon_j \in \varepsilon \}

Λ={αi=(Ti,εj,lija)∣lija∈A,Ti∈A,εj∈ε}

T

i

,

ε

j

T_i,\varepsilon_j

Ti,εj是先前抽取的事件和实体提及,

l

i

j

a

l_{ij}^a

lija是事件论元标签。

信息网络构建:所有这些抽取出来的知识元素组成了一个信息网络 G = ( V , E ) G = (V, E) G=(V,E)(示例如图1所示)。每个节点 v i ∈ V v_i \in V vi∈V是一个实体提及或事件触发词,每个边 e i ∈ E e_i \in E ei∈E表示一个关系或事件论元角色。因此,我们的问题可以表述为在给定输入句子 S S S的情况下生成一个信息网络 G G G。

3、我们的方法

给定一个输入句子 S S S,我们首先使用预训练的基于Transformer的AMR解析器来获得 S S S的AMR图。然后使用RoBERTa对每个句子进行编码,以识别实体提及和事件触发词作为候选节点。在此之后,我们将每个候选节点映射到AMR节点,并使用基于GAT的语义图聚合器强制消息传递,以捕获候选节点之间的全局相互依赖性。然后将所有候选节点及其成对边通过特定任务前馈神经网络来计算得分向量。在解码过程中,我们利用每个AMR图中的层次结构作为条件来决定beam search的顺序,并找到全局得分最高的最佳候选图。

3.1 AMR Parsing

我们使用一个基于Transformer的AMR解析器在AMR 3.0标注上进行预训练,生成一个AMR图 G a = ( V a , E a ) G^a = (V^a, E^a) Ga=(Va,Ea),其中AMR节点与输入句子 S S S中的片段对齐。每个节点 v i a = ( m i a , n i a ) ∈ V a v^a_i = (m^a_i, n^a_i) \in V^a via=(mia,nia)∈Va表示一个AMR概念(concept)或谓词(predicate),我们使用 m i a , n i a m^a_i, n^a_i mia,nia表示原始句子中该节点的起始和结束索引。对于AMR边,我们用 e i , j a e_{i,j}^a ei,ja表示AMR标注中节点 v i a v^a_i via和 v j a v^a_j vja之间的具体关系类型。

AMR关系聚类的嵌入:为了降低在数百个细粒度AMR边类型上过度拟合的风险,我们只考虑与IE任务最相关的边类型,并手动定义 M = 12 M = 12 M=12个AMR边类型集群,如表1所示。注意每个 A R G x ARG_x ARGx关系将被视作一个单独个体簇(集群),因为每一个 A R G x ARG_x ARGx表示一个不同的论元角色。对于每个边类型聚类,我们随机初始化一个 d E d_E dE维嵌入,得到一个嵌入矩阵 E ∈ R M × d E E \in \R^{M×d_E} E∈RM×dE,并在训练过程中进行优化。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-MBjWtAhp-1673679260355)(Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction.assets/image-20230113205305388.png)]](https://img-blog.csdnimg.cn/ebe0262bfc354c30901247e42124ddc1.png#pic_center)

3.2 实体和事件触发词识别

我们首先从输入语句中将实体提及和事件触发词识别为候选节点。与Lin等人类似,我们采用条件随机场(CRF)约束的前馈神经网络来识别实体提及和事件触发词的片段范围。

上下文编码:给定一个长度为 N N N的输入句子 S = { w 1 , w 2 , . . . , w N } S = \{w_1, w_2,...,w_N\} S={w1,w2,...,wN},我们首先使用预训练好的RoBERTa编码器计算每个单词 w i w_i wi的上下文单词表示 x i x_i xi。如果一个单词被RoBERTa tokenizer分割成多个片段,我们将所有单词片段的表示向量的平均值作为最终的单词表示。

基于CRF的序列标注:在获得上下文单词表示之后,我们使用前馈神经网络FFN为每个单词计算得分向量

y

^

i

=

F

F

N

(

x

i

)

\hat y_i = FFN(x_i)

y^i=FFN(xi),其中

y

^

i

\hat y_i

y^i中的每个元素表示标记集合中某个标记的得分。一个标记路径

z

^

=

{

z

^

1

,

z

^

2

,

.

.

.

,

z

^

N

}

\hat z=\{\hat z_1,\hat z_2,...,\hat z_N \}

z^={z^1,z^2,...,z^N}的综合得分被计算通过:

s

(

z

^

)

=

∑

i

=

1

N

y

^

i

,

z

^

i

+

∑

i

=

1

N

+

1

P

z

^

i

−

1

,

z

^

i

s(\hat z)=\sum_{i=1}^N \hat y_{i,\hat z_i}+\sum_{i=1}^{N+1} P_{\hat z_{i-1},\hat z_i}

s(z^)=i=1∑Ny^i,z^i+i=1∑N+1Pz^i−1,z^i

y

^

i

,

z

^

i

\hat y_{i,\hat z_i}

y^i,z^i是

y

^

i

\hat y_i

y^i中第

z

^

i

\hat z_i

z^i元素的得分向量,

P

z

^

i

−

1

,

z

^

i

P_{\hat z_{i-1},\hat z_i}

Pz^i−1,z^i指的是标记

z

^

i

−

1

\hat z_{i-1}

z^i−1到标记

z

^

i

\hat z_i

z^i转发分数(transition score),从优化矩阵

P

P

P中得到。节点识别训练的目标是最大化对数似然

L

I

L^I

LI的正确标记路径

z

z

z:

L

I

=

s

(

z

)

−

l

o

g

∑

z

^

∈

Z

e

s

(

z

^

)

L^I=s(z)-log \sum_{\hat z \in Z} e^{s(\hat z)}

LI=s(z)−logz^∈Z∑es(z^)

我们使用单独的基于CRF的标记器来抽取实体和事件触发词。**注意,我们不使用CRF标记器预测的特定节点类型作为实体和触发词的最终输出分类结果,而只保留标识的实体和触发词范围。**实体和触发词的最终类型由后续解码步骤中的关系和论元提取共同决定。具体来说,我们将在这一步中获得实体span

{

(

a

i

,

b

i

)

}

i

=

1

∣

ε

∣

\{(a_i, b_i)\}^{|\varepsilon|}_{i=1}

{(ai,bi)}i=1∣ε∣和触发词片段

{

(

p

i

,

q

i

)

}

i

=

1

∣

T

∣

\{(p_i, q_i)\}^{|T|}_{i=1}

{(pi,qi)}i=1∣T∣的集合,其中

a

i

,

b

i

,

p

i

,

q

i

a_i, b_i, p_i, q_i

ai,bi,pi,qi表示词span的起始索引和结束索引。

3.3 语义图的聚合

为了充分利用AMR分析中共享的语义特征(semantic feature)和拓扑特征(topological feature),我们设计了一个语义图聚合器(semantic graph aggregator),使候选实体节点和事件节点能够基于AMR拓扑聚合来自其邻居的信息。

初始化节点表示:每个实体节点、触发词节点或AMR节点都用向量表示形式

h

i

0

h^0_i

hi0进行初始化,方法是对其跨度内所有单词的词嵌入进行平均。例如,给定一个实体节点

(

a

i

,

b

i

)

(a_i, b_i)

(ai,bi),其表示向量计算为

h

i

0

=

1

∣

b

i

−

a

i

+

1

∣

∑

k

=

a

i

b

i

x

k

h^0_i=\frac{1}{|b_i-a_i+1|}\sum_{k=a_i}^{b_i} x_k

hi0=∣bi−ai+1∣1k=ai∑bixk

x

k

x_k

xk表示RoBERTa编码器的词表征。

结点对齐:在进行消息传递之前,我们首先尝试将每个标识的实体节点和触发词节点与其中一个AMR节点对齐。以跨度为

(

a

i

,

b

i

)

(a_i, b_i)

(ai,bi)的实体节点为例。给定AMR节点集合

{

(

m

i

a

,

n

i

a

)

}

i

=

1

∣

V

a

∣

\{(m^a_i, n^a_i)\}^{|V^a|}_{i=1}

{(mia,nia)}i=1∣Va∣,将

b

i

b_i

bi作为实体节点head word的索引,寻找

(

a

i

,

b

i

)

(a_i, b_i)

(ai,bi)的匹配AMR节点

(

m

i

∗

a

,

n

i

∗

a

)

(m^a_{i^∗},n^a_{i^∗})

(mi∗a,ni∗a),即该节点满足

m

i

∗

a

≤

b

i

≤

n

i

∗

a

m^a_{i^∗} \le b_i \le n^a_{i^∗}

mi∗a≤bi≤ni∗a。如果没有节点可以通过这种方式匹配到

(

a

i

,

b

i

)

(a_i, b_i)

(ai,bi),我们转向搜索最近的AMR节点:

i

∗

=

arg

min

k

(

∣

b

i

−

m

k

∣

+

∣

b

i

−

n

k

∣

)

i^*=\text{arg}\ \min_{k}(|b_i-m_k|+|b_i-n_k|)

i∗=arg kmin(∣bi−mk∣+∣bi−nk∣)

(

m

i

∗

a

,

n

i

∗

a

)

(m_{i^*}^a,n_{i^*}^a)

(mi∗a,ni∗a)是与实体节点

(

a

i

,

b

i

)

(a_i, b_i)

(ai,bi)距离最短的AMR节点。我们还以同样的方式对事件触发词节点进行对齐。

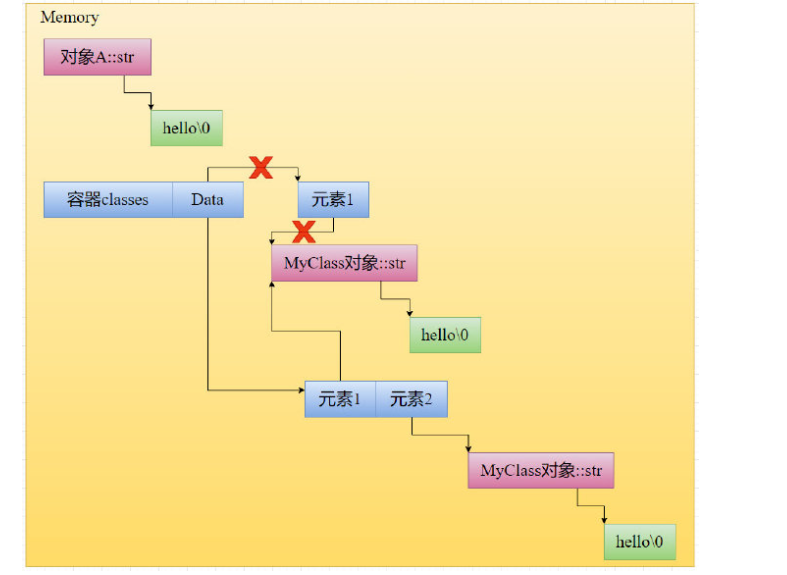

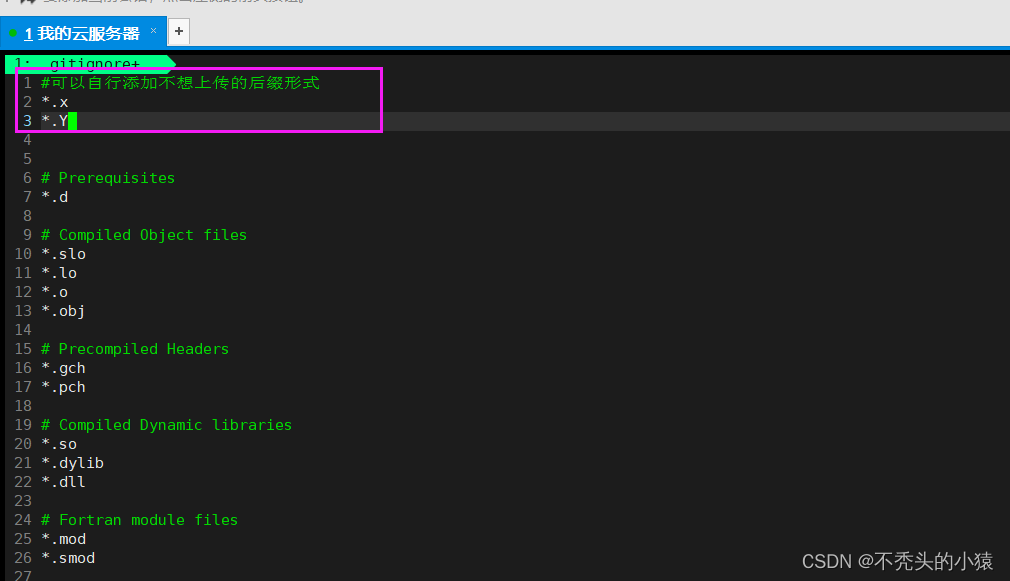

异构图的构建:在为每个已识别的实体提及和事件触发词获得匹配或最近的AMR节点后,我们构造一个具有初始化节点和边缘特征的异构图,如下所示。给定一个AMR图 G a = ( V a , E a ) G^a = (V^a, E^a) Ga=(Va,Ea),我们考虑以下三种情况来初始化每个节点 v i a v^a_i via的特征向量:

- 节点 v i a v^a_i via已匹配到实体提及或事件触发词。我们将匹配节点的表示向量(而不是 v i a v^a_i via)作为初始化的特征向量。

- 节点 v i a v^a_i via不匹配任何已识别的节点,而是标记为实体提及或事件触发词的最近节点,例如 ( a i , b i ) (a_i, b_i) (ai,bi)。我们在AMR拓扑中添加一个表示向量为 ( a i , b i ) (a_i, b_i) (ai,bi)的新节点,并将 v i a v^a_i via中的这个新节点与表1中定义的边缘类型Others连接起来。

- 节点 v i a v^a_i via既不匹配也不作为距离任何实体(触发词)最近的节点。我们使用它自己的节点表示作为初始化的特征向量。

对于每个边 e i , j a e_{i,j}^a ei,ja,我们首先根据表1将其映射到一个AMR关系簇,然后从嵌入矩阵 E E E查找它的表示 e i , j e_{i,j} ei,j,我们用 h i 0 h_i^0 hi0表示每个节点的初始特征。图2显示了该步骤的示例。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ylgL0s9B-1673679260356)(Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction.assets/image-20230114100638815.png)]](https://img-blog.csdnimg.cn/e6b876d0b2ef43b48cd9c1f6f974911a.png#pic_center)

基于Attention的信息传递:受图注意力网络(GATs)的启发,我们在AMR图拓扑上设计了一种基于

L

L

L层注意力的消息传递机制,使实体和触发词节点聚合邻居信息。对于层

l

l

l中的节点

i

i

i,我们首先根据节点特征

h

i

l

,

h

j

l

h^l_i, h^l_j

hil,hjl和边缘特征

e

i

,

j

l

e^l_{i,j}

ei,jl计算每个邻居

j

∈

N

i

j \in N_i

j∈Ni的注意力得分。

α

i

,

j

l

=

e

x

p

(

σ

(

f

l

[

W

h

i

l

:

W

e

e

i

,

j

:

W

h

j

l

]

)

)

∑

k

∈

N

i

e

x

p

(

σ

(

f

l

[

W

h

i

l

:

W

e

e

i

,

k

:

W

h

k

l

]

)

)

\alpha_{i,j}^l=\frac{exp(\sigma(f^l[Wh_i^l:W_ee_{i,j}:Wh_j^l]))}{\sum_{k \in N_i} exp(\sigma(f^l[Wh_i^l:W_ee_{i,k}:Wh_k^l]))}

αi,jl=∑k∈Niexp(σ(fl[Whil:Weei,k:Whkl]))exp(σ(fl[Whil:Weei,j:Whjl]))

W

,

W

e

W,W_e

W,We是可训练的参数,

f

l

f^l

fl和

σ

(

⋅

)

\sigma(\cdot)

σ(⋅)是单一的前向神经网络层和

LeakyReLU

\text{LeakyReLU}

LeakyReLU激活函数。邻居节点信息

h

∗

h^*

h∗将被计算通过其他邻居节点的加权特征:

h

∗

=

∑

j

∈

N

i

α

i

,

j

l

h

i

l

h^*=\sum_{j \in N_i} \alpha_{i,j}^l h_i^l

h∗=j∈Ni∑αi,jlhil

更新的节点特征是通过原始节点特征及其邻域信息的组合来计算的,其中

γ

γ

γ控制邻居之间的消息传递级别,

W

∗

W^*

W∗表示一个可训练的线性转换参数。

h

l

+

1

=

h

l

+

γ

⋅

W

∗

h

∗

h^{l+1}=h^l+\gamma \cdot W^*h^*

hl+1=hl+γ⋅W∗h∗

我们从图中选择实体和触发词节点,并从最后一层取它们的特征向量

h

i

L

h_i^L

hiL作为从AMR图中聚合信息的表示向量(如图2所示)。我们使用

h

i

e

h^e_i

hie和

h

i

t

h^t_i

hit分别表示每个实体和触发词的特征。

3.4 模型训练和解码

在本小节中,我们将介绍如何在给定已识别实体的情况下联合解码输出信息网络,并使用其聚合特征 h i e h^e_i hie和 h i t h^t_i hit触发词节点。我们设计了一种分层解码方法,将AMR层次结构作为条件,以确定更有组织的知识元素解码顺序。

使用全局特征去最大化分数:类似于OneIE,我们使用特定于任务的前馈神经网络将每个节点或节点对映射到一个分数向量。具体来说,我们分别为实体、触发词、关系和论元角色抽取任务计算了四种类型的分数向量

s

i

e

,

s

i

t

,

s

i

,

j

r

和

s

i

,

j

a

s^e_i,s^t_i,s^r_{i,j}和s^a_{i,j}

sie,sit,si,jr和si,ja,其中每个分数向量的维数与每个任务中的类数相同。

s

i

e

=

F

F

N

e

(

h

i

e

)

,

s

i

t

=

F

F

N

t

(

h

i

t

)

,

s

i

,

j

r

=

F

F

N

r

(

[

h

i

e

:

h

j

e

]

)

,

s

i

,

j

a

=

F

F

N

a

(

[

h

i

t

:

h

j

e

]

)

.

s_i^e=FFN^e(h_i^e),s_i^t=FFN^t(h_i^t),\\ s_{i,j}^r=FFN^r([h_i^e:h_j^e]),\\ s_{i,j}^a=FFN^a([h_i^t:h_j^e]).

sie=FFNe(hie),sit=FFNt(hit),si,jr=FFNr([hie:hje]),si,ja=FFNa([hit:hje]).

所以,总的得分

c

(

G

)

c(G)

c(G)将被计算如下:

c

(

G

)

=

∑

i

=

1

∣

S

∣

s

i

e

+

∑

i

=

1

∣

T

∣

s

i

t

+

∑

i

=

1

∣

ε

∣

∑

j

=

1

∣

ε

∣

s

i

,

j

r

+

∑

i

=

1

∣

T

∣

∑

j

=

1

∣

ε

∣

s

i

,

j

a

c(G)=\sum_{i=1}^{|S|}s_i^e+\sum_{i=1}^{|T|}s_i^t+\sum_{i=1}^{|\varepsilon|}\sum_{j=1}^{|\varepsilon|}s_{i,j}^r+\sum_{i=1}^{|T|}\sum_{j=1}^{|\varepsilon|}s_{i,j}^a

c(G)=i=1∑∣S∣sie+i=1∑∣T∣sit+i=1∑∣ε∣j=1∑∣ε∣si,jr+i=1∑∣T∣j=1∑∣ε∣si,ja

我们继承了OneIE中使用全局特征的方法,以强迫模型捕获关于全局交互的更多信息。信息网络

G

G

G的全局分数

g

(

G

)

g(G)

g(G)定义为局部分数

c

(

G

)

c(G)

c(G)与全局特征

f

G

f_G

fG的贡献之和。

g

(

G

)

=

c

(

G

)

+

u

⋅

f

G

g(G)=c(G)+u \cdot f_G

g(G)=c(G)+u⋅fG

u

u

u是可训练参数。全局特征向量

f

G

f_G

fG由二值组成,表示输出图中知识元素之间是否具有某种相互依赖性(例如,一个攻击者可能是一个被逮捕的人)。在训练过程中,我们使用与OneIE相同的局部特征类别,总训练目标是最大化识别对数似然,即局部分数

s

(

G

)

s(G)

s(G),最小化全局得分ground-truth

G

^

\hat G

G^与预测信息网络

G

G

G之间的差距:

max

L

I

+

c

(

G

^

)

−

(

g

(

G

^

)

−

g

(

G

)

)

\max \ L^I+c(\hat G)-(g(\hat G)-g(G))

max LI+c(G^)−(g(G^)−g(G))

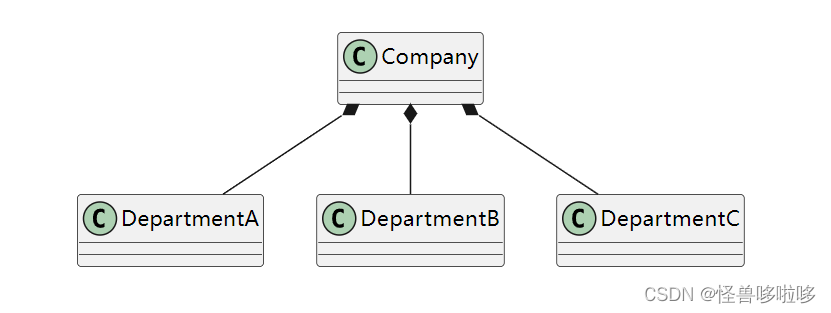

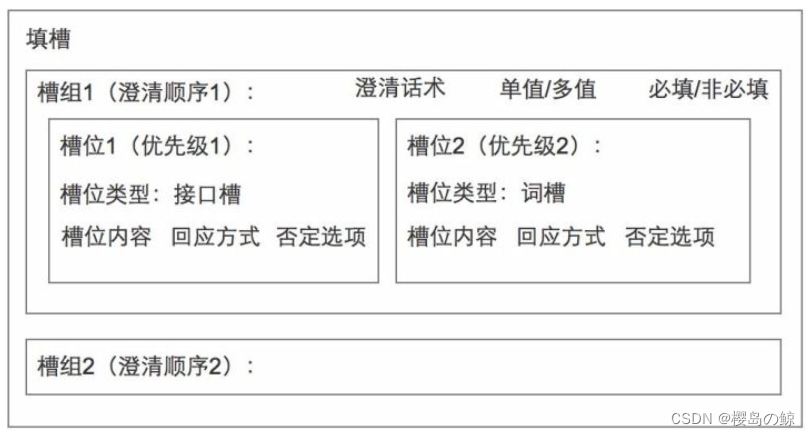

层级顺序解码:给定所有节点及其成对边的输出得分向量,最直接的方法是输出全局得分最高

g

(

G

)

g(G)

g(G)的信息网络

G

G

G。由于利用了全局特征,搜索所有可能的信息网络可能会导致指数级的复杂性,因此我们采用了类似的基于波束搜索(beam search)的方法。与OneIE相比,我们创造性地结合了AMR层次结构,以确定更有组织的解码顺序,而不是简单的基于原始句子中的单词位置的左至右顺序。具体来说,给定节点及其与AMR的对齐关系,我们根据其对齐的AMR节点的位置自上而下地对这些节点进行排序,即首先解码离AMR根节点最近的对齐AMR节点。我们用一个例子来说明图3中的解码顺序。我们用

U

=

{

v

1

,

v

2

,

.

.

.

,

v

K

}

U = \{v_1, v_2,...,v_K\}

U={v1,v2,...,vK}表示已排序的标识触发词节点和实体节点,类似于Lin等人,我们从

v

1

v_1

v1到

v

K

v_K

vK一步一步地添加这些节点,每一步通过枚举新节点和其他现有节点成对边的类型来获得所有可能的子图。我们只保留每一步中最上面的

θ

θ

θ子图作为候选图,以避免指数复杂度,最后选择第

K

K

K步中全局得分

g

(

G

)

g(G)

g(G)最高得分图作为输出。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-dbeWFcDj-1673679260356)(Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction.assets/image-20230114105442944.png)]](https://img-blog.csdnimg.cn/c94cf60d708747908c993317ca5aeeb6.png#pic_center)

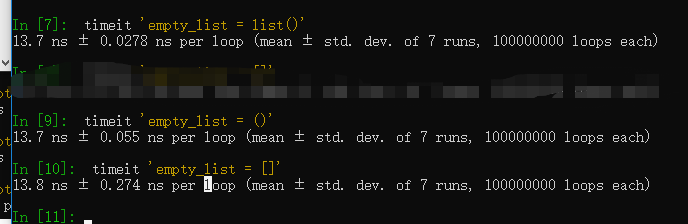

4、实验

4.1 数据

ACE-2005、ERE-EN、GENIA。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-6Dwx3H4E-1673679260357)(Abstract Meaning Representation Guided Graph Encoding and Decoding for Joint Information Extraction.assets/image-20230114105952151.png)]](https://img-blog.csdnimg.cn/2d490e379f7a47dcb7a97122d6b467ec.png#pic_center)

4.2 实验设置

Baseline:DyGIE++、OneIE。

实体:只有当预测的词跨度 ( a i , b i ) (a_i, b_i) (ai,bi)和实体类型 e i e_i ei都匹配引用实体时,抽取的实体提及才正确。

事件触发词:如果预测的跨度 ( p i , q i ) (p_i, q_i) (pi,qi)与参考触发词匹配,则正确识别事件触发词(Trg-I)。如果预测的事件类型 t i t_i ti也与参考触发词相匹配,则它被正确分类(Trg-C)。

事件论元:如果 ( T i , ε j ) (T_i,\varepsilon_j) (Ti,εj)与参考事件论元匹配,则预测的事件论元 ( T i , ε j , l i , j a ) (T_i,\varepsilon_j,l_{i,j}^a) (Ti,εj,li,ja)将被正确识别(Arg-I)。它被正确分类(Arg-C)是 l i , j a l_{i,j}^a li,ja类型,也匹配引用论元角色。

关系:预测关系只有在论元 ε i ε_i εi和 ε j ε_j εj都匹配引用关系时才是正确的。

我们使用Adam在NVIDIA Tesla V100 GPU上训练模型80个epoch(一个训练epoch大约需要10分钟),RoBERTa参数的学习率为1e-5,其他参数的学习率为5e-3。我们将消息传递水平 γ γ γ设为0.001,这是一个相对较低的消息传递水平,因为我们发现过多的消息传递会导致节点失去自身的特征。我们使用两层语义图聚合器,节点的特征维数为2048,边的特征维数为256。对于其他超参数,我们保持它们与OneIE严格相同,以保证公平比较。具体来说,FFN由两层组成,dropout rate为0.4,隐藏单元的数量为150用于实体和关系抽取,600用于事件抽取,beam size设置为10。

4.3 总体效果

我们报告了我们的AMR-IE模型的性能,并将其与表3和表4中之前的方法进行了比较。总的来说,我们的AMR引导方法在包括实体、事件和关系抽取在内的所有IE子任务上都大大优于基线。在关系抽取和事件论元角色标注等边分类任务上,性能提升尤其显著,因为该模型借助外部AMR图结构可以更好地理解知识元素之间的关系。为了进一步显示模型中每个单独部分的帮助,我们引入了用于消融研究了模型的两种变体,并将结果显示在表3中。在没有Enc的AMR-IE中,我们去掉了语义图聚合器,只保留了有序的解码,而在没有Dec的AMR-IE中,我们保留了语义图聚合器,但使用了从左到右的统一解码顺序。从结果中,我们可以看到,仅仅结合图形编码器已经能够大幅提高所有IE子任务的性能,因为所识别的节点可以通过AMR拓扑上的消息传递捕获一些全局交互。此外,使用AMR引导的解码顺序可以进一步提高性能,特别是在事件论元抽取任务上。

4.4 消息传递的影响

我们还进行了参数敏感性分析,以公式(11)中定义的 γ γ γ的影响,它控制了从AMR图中的邻居节点聚集多少信息。我们将这个参数从10−5更改为10,并在图4中显示了ACE-05E数据集上IE子任务的性能趋势。**我们可以发现,对于每个子任务,模型的性能都经历了一个上升趋势,随着消息传递级别的提高。然而,当 γ γ γ持续增加到10-2以上时,所有子任务的性能都将出现明显的下降。这种现象符合我们的直觉,因为被识别的节点可以通过消息传递从它们的AMR邻居收集有用的信息。但是,如果节点过多地关注它们的邻域信息,它们将失去一些自身固有的语义特征,从而导致性能下降。**此外,我们还可以看到,相对于实体和触发词抽取任务,关系和论元提取任务的性能随 γ γ γ的变化更为剧烈。这是因为边类型预测需要对所涉及的两个节点进行高质量的嵌入,这使得边类型预测任务对消息传递更加敏感。

4.5 问题分析

为了进一步理解我们提出的AMR引导编码和AMR条件解码方法如何帮助提高性能,我们从AMR-IE模型的输出中选择典型示例用于表5中的说明。

5、相关工作

最近的一些努力将依赖解析树(dependency parsing tree)纳入神经网络,用于事件抽取和关系抽取。对于语义角色标记(semantic role labeling,SRL), Stanovsky和Dagan通过在两个任务之间创建映射,设法利用了SRL和开放域IE之间的相似性。Huang等人使用AMR作为IE模型的更简洁的输入格式,但他们将每个AMR分解为三元组,以捕获节点和边之间的局部上下文信息,而节点信息并没有在全局图拓扑中传播。Rao等人提出了一种基于子图匹配的方法来从AMR图中提取生物医学事件,而Li等人使用另一种基于GCN的编码器来获得更好的单词表示。

此外,图神经网络也被广泛用于事件抽取以及关系和实体抽取。图神经网络也证明了编码句子的其他类型的内在结构的有效性,例如知识图谱,文档级关,以及自构图。然而,所有这些方法都专注于单个IE任务,而不能扩展到提取包含实体、关系和事件的联合信息网络。

最近有一些研究专注于构建用于同时执行多个IE任务的联合神经模型,例如联合实体和关系抽取以及联合事件和实体抽取。DyGIE++设计了一个基于跨度图传播的联合模型来提取实体、事件和关系,而OneIE进一步利用全局特征来促进模型捕获更多的全局交互。与OneIE中的flat encoder相比,我们提出的框架利用语义图聚合器来合并来自细粒度AMR语义的信息,并在编码阶段强制执行全局交互。此外,我们创造性地使用AMR层次结构来决定知识元素的解码顺序,而不是简单的从左到右顺序解码器。与flat encoder相比,AMR引导的图编码器和解码器都被证明是非常有效的。

6、总结和未来工作

AMR解析和IE具有从非结构化文本构建语义图的相同目标。**IE更关注目标本体,因此它的输出可以看作是AMR图的一个子集。**在本文中,我们提出了两种直观而有效的方法,在编码和解码阶段利用AMR解析的指导来改进IE。在未来,我们计划将AMR图与实体共指图集成,使我们的IE框架可以扩展到文档级。

外部参考资料

全网首讲最详细AMR系统介绍(1):Abstract Meaning Representation(AMR,抽象语义表示) 的基础表示逻辑;附英文版原 pdf 资料_暖仔会飞的博客-CSDN博客