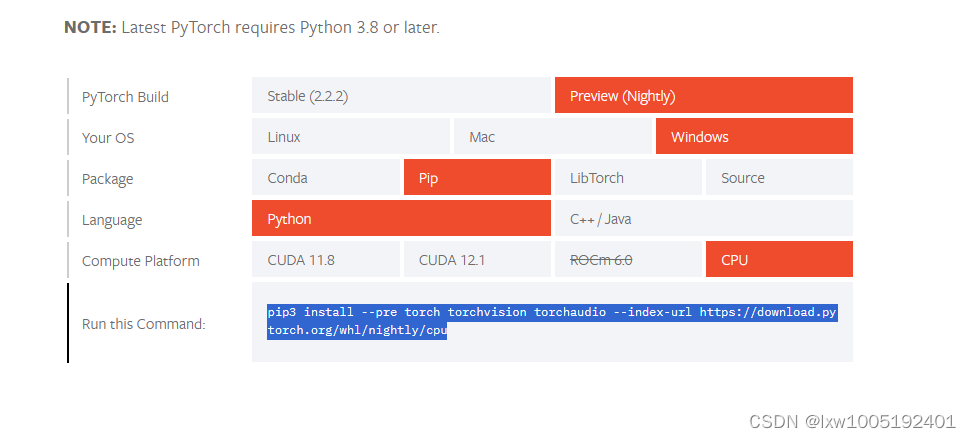

1、安装 pytorch https://pytorch.org/get-started/locally/ 点击进入官网,如图选择自己的环境得到pip安装依赖的命令:

pip3 install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cpu

2、拉取代码并安装依赖

# 拉取代码

git clone https://github.com/QwenLM/Qwen-7B.git

# 进入代码目录

cd Qwen-7B

# 安装依赖

pip install -r requirements.txt

# 安装 web_demo 依赖

pip install -r requirements_web_demo.txt检出的项目为启动项目:Qwen-7B,不包含预训练好的模型文件。

3、启动模型

python web_demo.py --server-port 8087 --server-name "0.0.0.0"

不出意外的话,这里要出现意外了。OSError: We couldn't connect to 'https://huggingface.co' to load this file,大意是不能连接到https://huggingface.co下载模型文件。因为这个地址国内访问不了。只能自己下载模型文件到本地,离线启动。

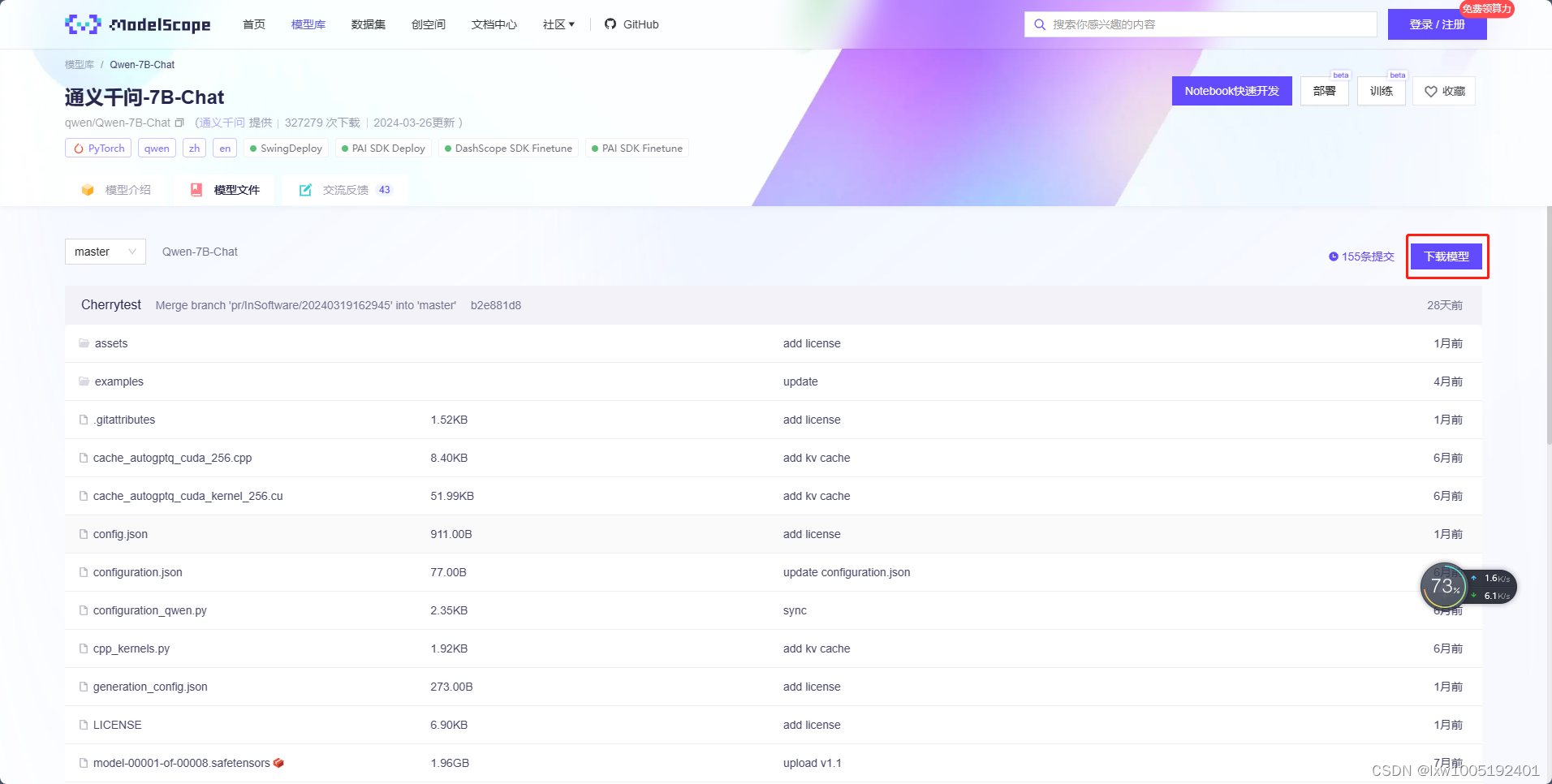

4、模型下载

去魔搭官网下载:https://www.modelscope.cn/models/qwen/Qwen-7B-Chat/files

点击【下载模型】按钮,得到git仓库检出命令:

git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat.git检出模型到本地目录,例如:D:\Qwen\Qwen-7B-Chat

5、修改启动项目:Qwen-7B

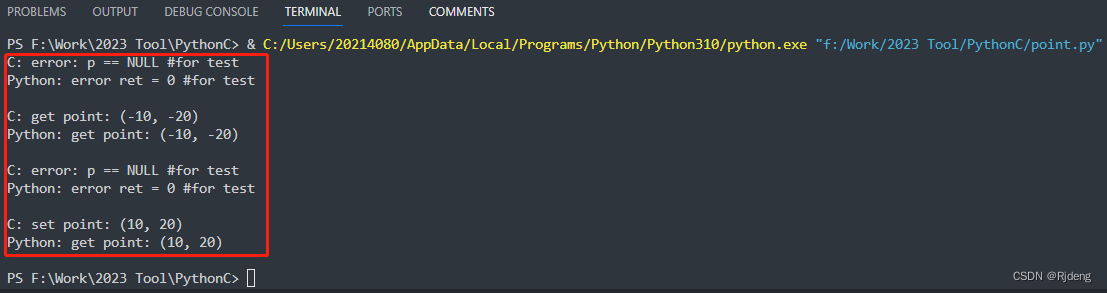

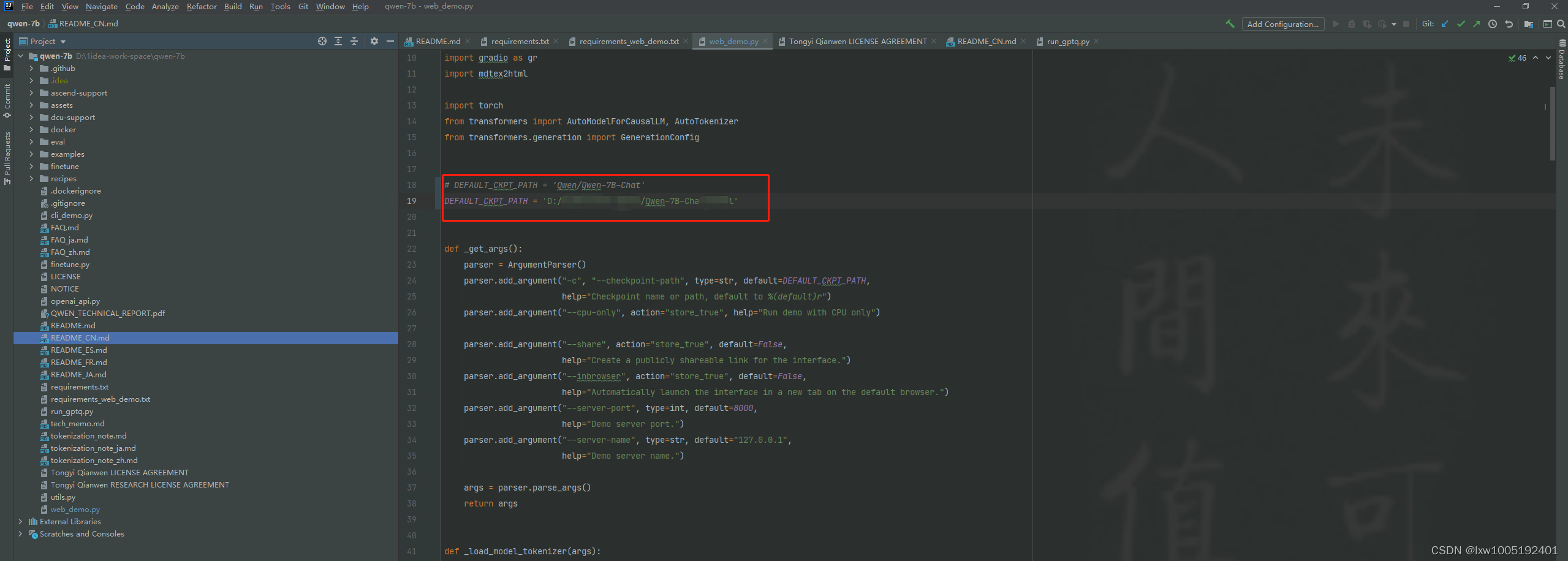

找到web_demo.py文件,如图

将DEFAULT_CKPT_PATH参数改为模型下载的路径:D:/Qwen/Qwen-7B-Chat

再次进行步骤3的python文件执行命令。即可启动成功

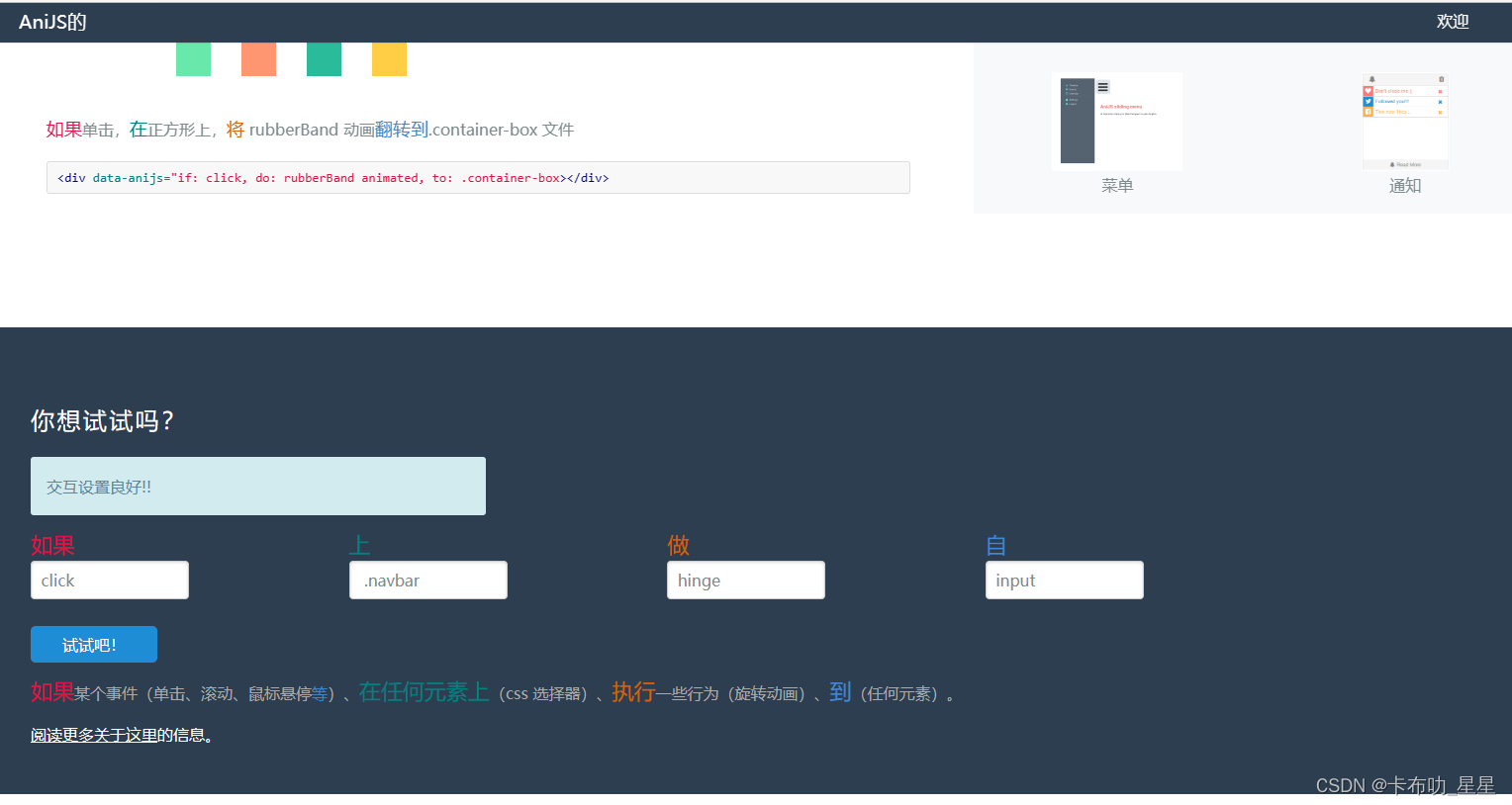

浏览器访问即可,如图

6、启动 openai api 形式的接口

安装依赖

pip install sse_starlette启动API接口服务

python openai_api.py --server-port 8086 --server-name "0.0.0.0"