这篇论文的标题是《Decoupled Iterative Refinement Framework for Interacting Hands Reconstruction from a Single RGB Image》,作者是Pengfei Ren, Chao Wen, Xiaozheng Zheng, Zhou Xue, Haifeng Sun, Qi Qi, Jingyu Wang, Jianxin Liao。他们来自北京邮电大学网络与交换技术国家重点实验室和字节跳动的PICO IDL。

摘要

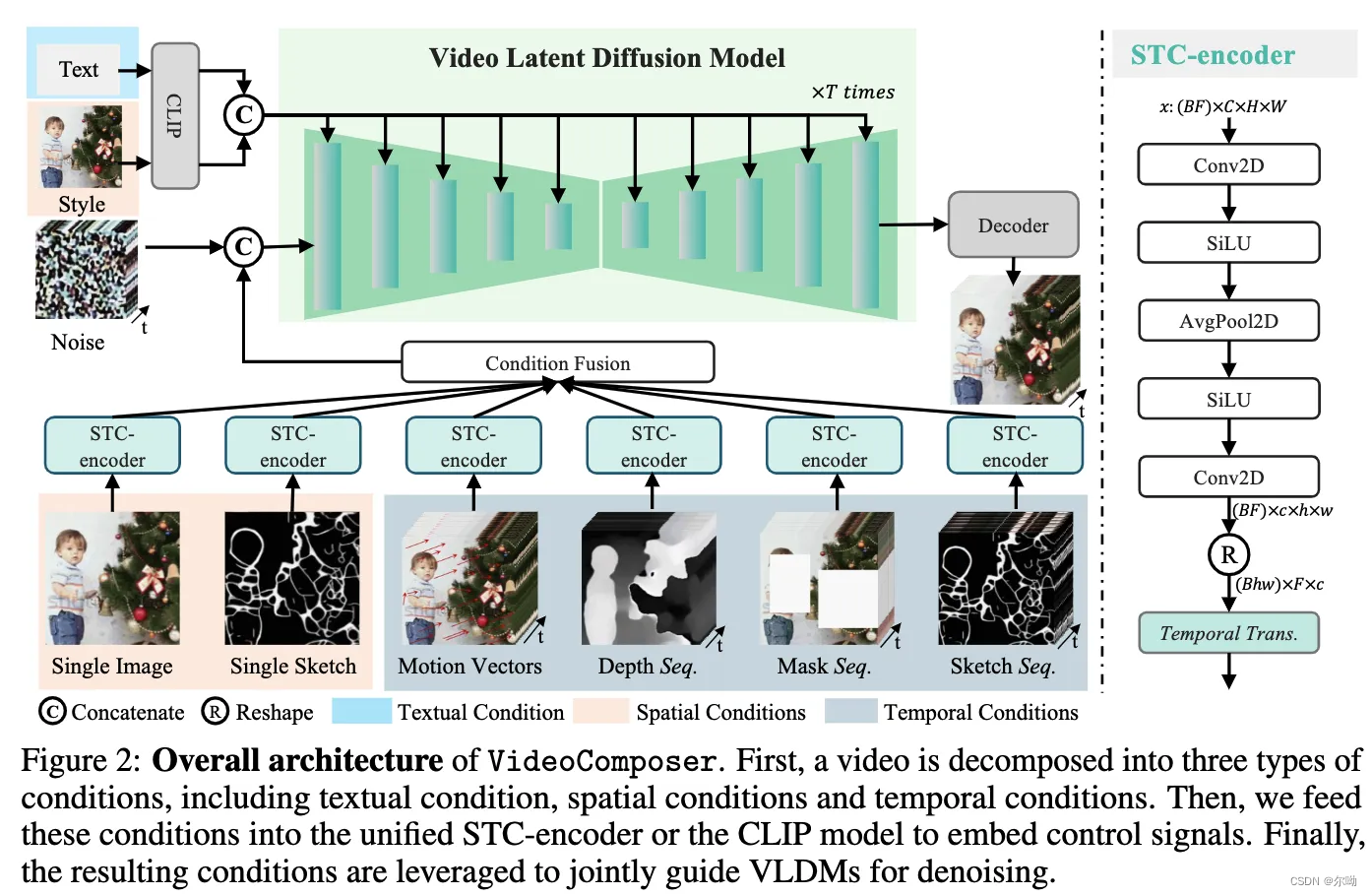

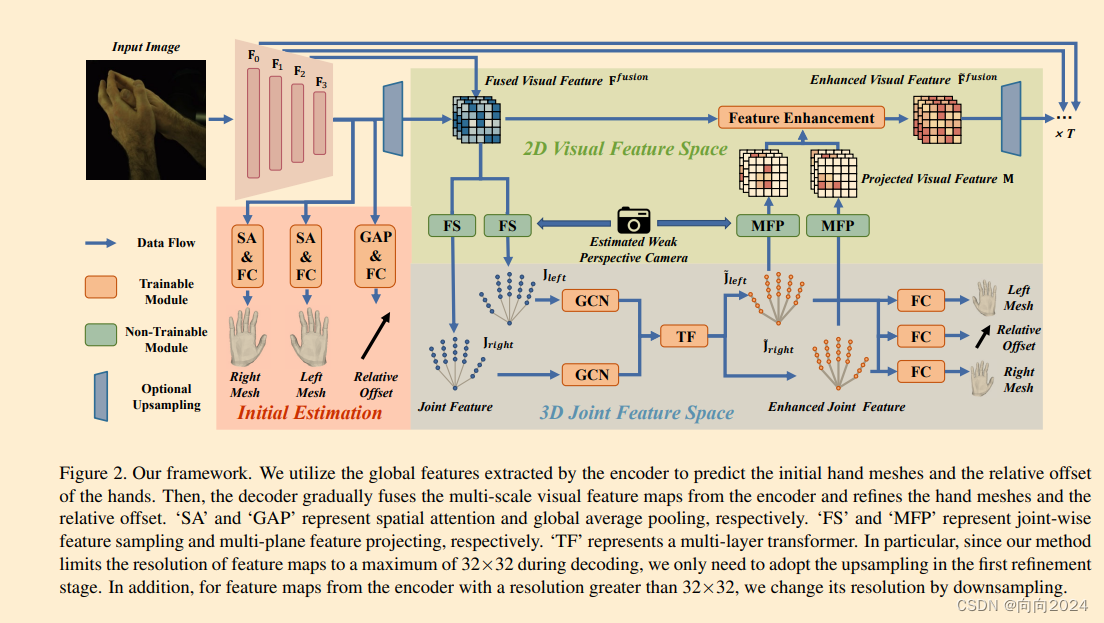

从单个RGB图像中重建交互的双手是一个非常具有挑战性的任务。一方面,双手之间的严重遮挡和相似的局部外观会混淆视觉特征的提取,导致估计的手部网格与图像错位。另一方面,交互的双手之间存在复杂的空间关系,这显著增加了手部姿态的解空间,增加了网络学习的难度。在本文中,我们提出了一个解耦的迭代细化框架,以实现像素级对齐的手部重建,同时有效建模双手之间的空间关系。具体来说,我们定义了两个具有不同特征的特征空间,即2D视觉特征空间和3D关节特征空间。首先,我们从视觉特征图中获得关节特征,并使用图卷积网络和变换器分别在3D关节特征空间内进行手内和手间信息交互。然后,我们将具有全局信息的关节特征以无歧义的方式投影回2D视觉特征空间,并使用2D卷积进行像素级增强。通过在两个特征空间中进行多次交替增强,我们的方法可以实现对交互双手的准确和鲁棒重建。我们的方法在InterHand2.6M数据集上大幅度超越了所有现有的双手重建方法。

主要贡献

- 提出了一个解耦的迭代细化框架,用于重建交互的双手。

- 通过紧凑且语义明确的关节节点建模双手的空间关系,这对计算友好并可以利用手骨结构的先验知识。

- 提出了一种无歧义的方式来将关节特征投影到视觉特征空间,这减轻了由于自相似性和自我遮挡引起的视觉线索缺失所导致的歧义。

- 方法在InterHand2.6M数据集上大幅度超越了最近的SOTA方法,并对野外图像显示出强大的泛化能力。

相关工作

论文回顾了单手重建和交互手重建的相关研究,包括使用深度数据或多相机系统的早期工作,以及最近的基于RGB的深度学习方法。

方法

- 采用编码器-解码器网络结构,编码器从输入图像中提取多尺度视觉特征,并使用全局特征估计初始手部网格和双手的相对偏移。

- 解码器逐步增强视觉特征图并细化手部网格和相对偏移。

- 在解码过程中,迭代地以解耦的方式进行双手空间关系建模和视觉特征细化。

实验

- 在单个NVIDIA A100 Tensor Core GPU服务器上实现和评估网络,使用PyTorch实现。

- 在InterHand2.6M数据集上进行主要实验,该数据集提供多视角RGB图像,带有双手网格和关节的3D注释。

- 还对RGB2Hands数据集、EgoHands数据集、100DOH数据集和Tzionas等人提出数据集上的定性实验进行了评估。

结论

本文提出的解耦迭代细化框架可以从单个RGB图像中重建交互的双手。通过在3D关节特征空间中使用GCN和变换器进行手内和手间信息交互,有效地建模了双手之间的空间依赖性。为了实现估计网格与观测图像的更好对齐,我们将具有全局信息的关节特征以无歧义的方式投影回视觉特征空间,为视觉特征提供了强大的消歧线索,减轻了自遮挡和自相似性问题。消融实验表明,解耦迭代细化可以有效地解决交互手重建中的两个主要挑战,即建模复杂的手部空间关系和视觉特征消歧。在InterHand2.6M上的定量实验表明,我们的方法大幅度超越了以前的SOTA。同时,在野外图像上的实验表明,我们的方法具有很强的泛化能力。

限制和未来工作

- 方法没有显式建模手部之间的碰撞,因此即使在建模手部的内部和外部关系时,手部之间的交叉仍然发生,有时会导致失败。

- 方法没有充分利用估计的3D网格信息。网格信息可能有助于对手部之间关系的细粒度理解。

- 为了实现更细粒度的网格图像对齐,高保真的参数化手部模型可能是有益的。

致谢

该工作得到了中国国家自然科学基金的部分支持,以及教育部和中国移动联合基金、北京邮电大学-中国移动研究院联合创新中心的部分支持,以及中国博士后科学基金会资助项目的部分支持。

补充材料

补充材料包括网络结构和计算需求的详细信息、网格平滑损失的详细信息、更多的定量结果、更多的消融实验和现实场景中的定性结果。