FairAdaBN: Mitigating Unfairness with Adaptive Batch Normalization and Its Application to Dermatological Disease Classification

摘要

深度学习在医疗研究和应用中变得越来越普遍,同时涉及敏感信息和关键诊断决策。研究人员观察到不同人口统计属性子组之间的性能差异显著,这被称为模型不公平性,并投入大量精力精心设计优雅的架构来解决不公平性,这带来了沉重的训练负担,带来了糟糕的泛化能力,并揭示了模型性能和公平性之间的权衡。

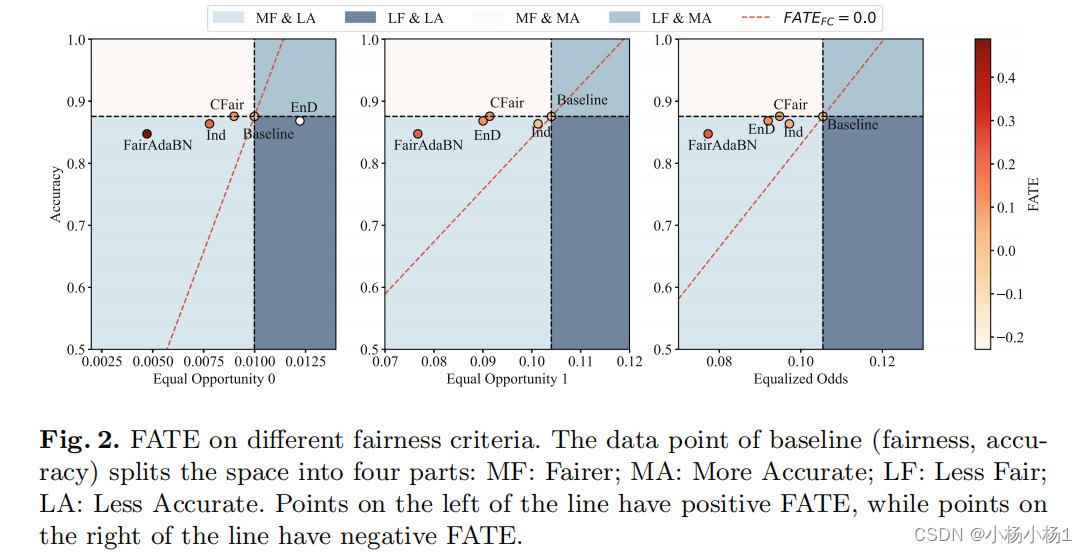

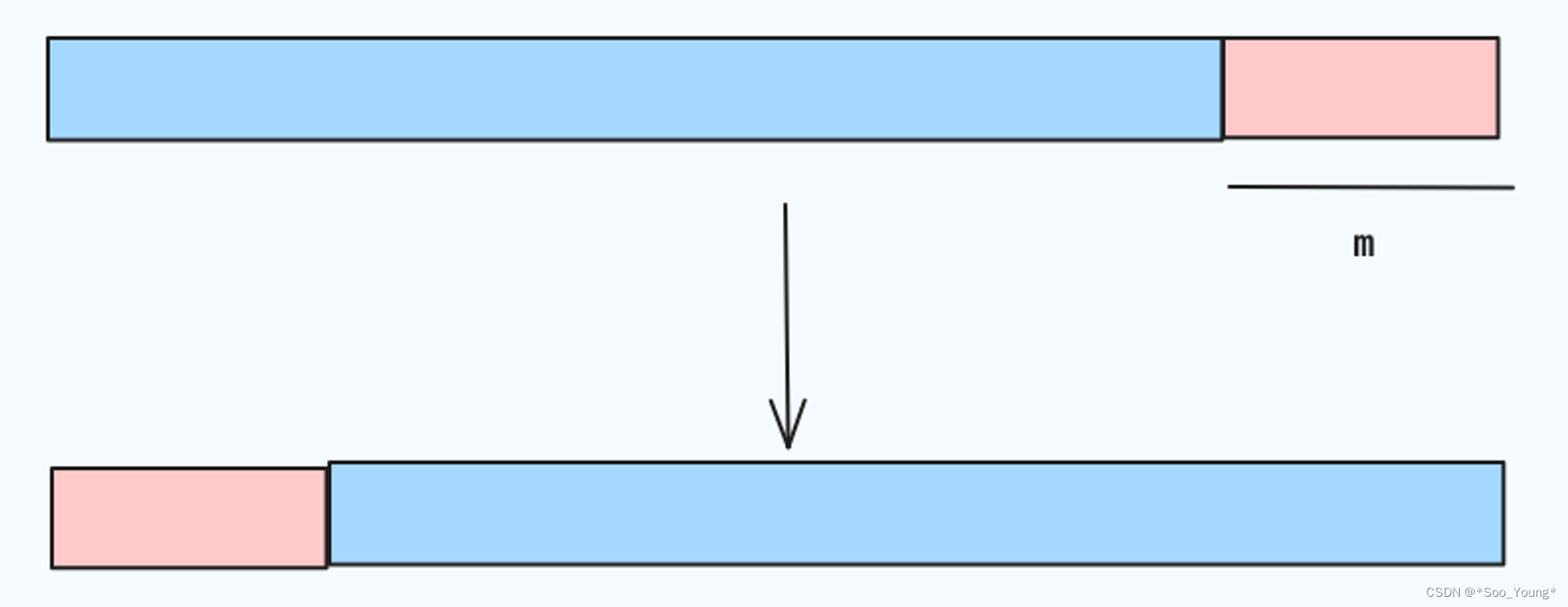

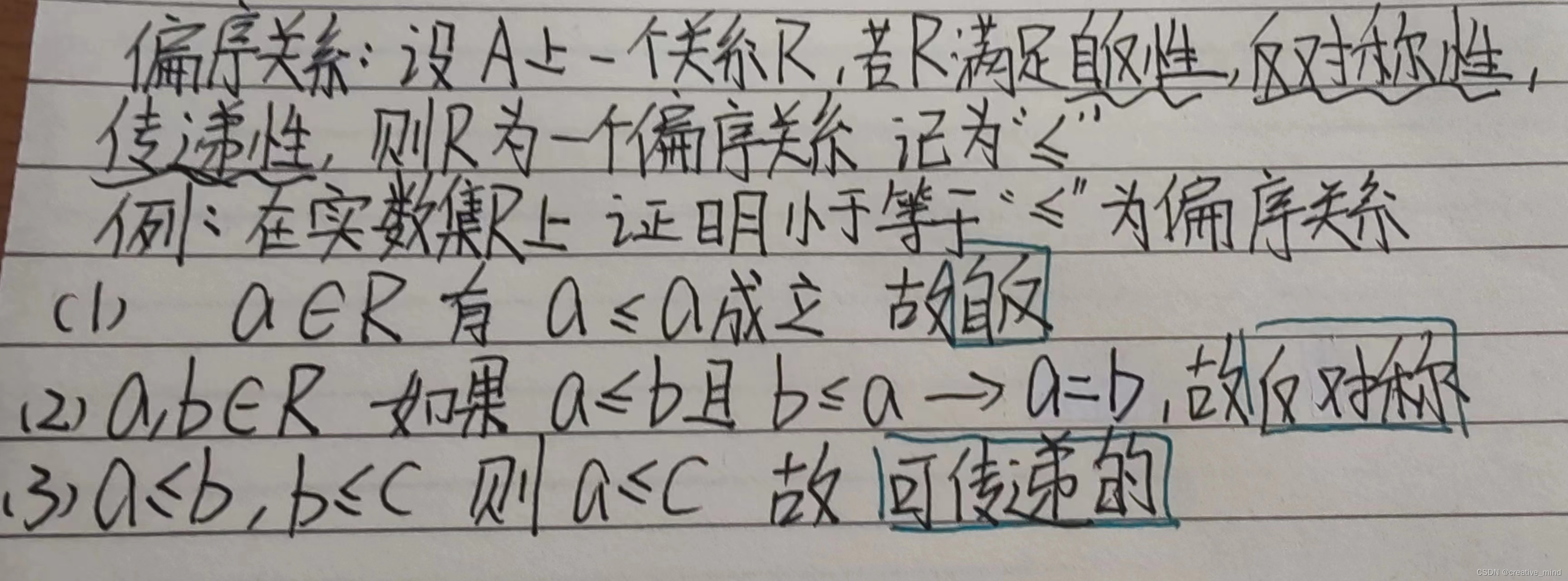

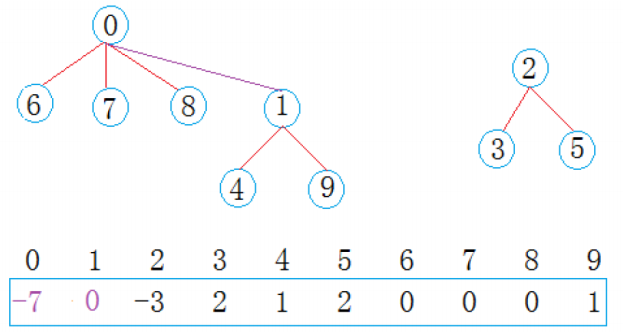

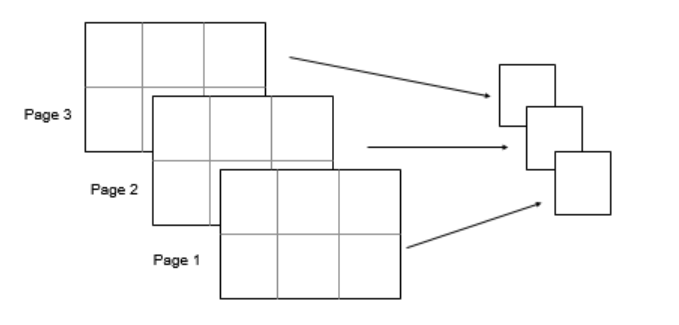

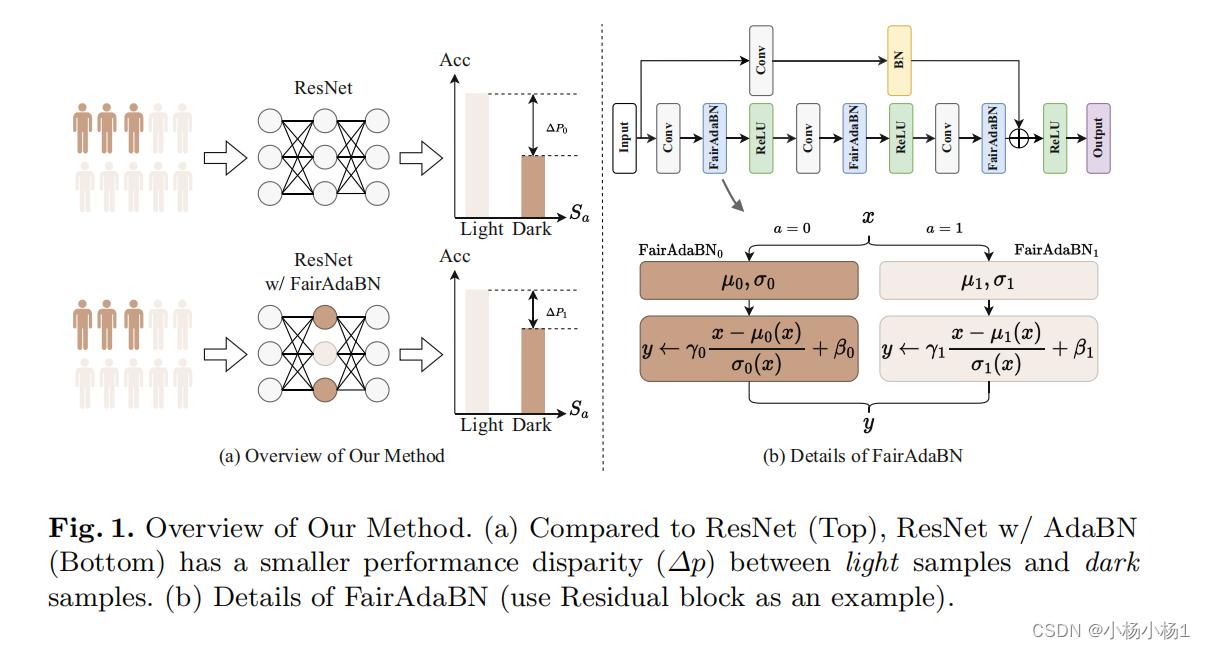

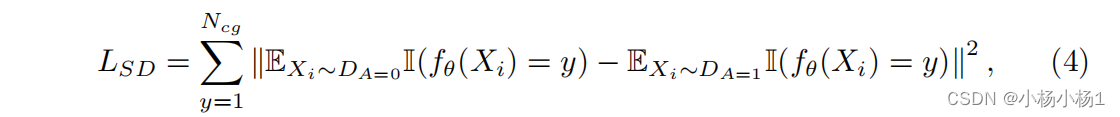

本文提出了一种使批标准化适应于敏感属性的方法,即FairAdaBN。可以适应几种原来不知道公平性的分类主干。此外,我们推导出一个新的损失函数,该函数限制了小批量上的子组之间的统计平衡,鼓励模型在收敛时具有相当的公平性。为了评估模型性能和公平性的权衡,我们提出了一种新的度量方法,称为公平性准确性权衡效率(FATE),用于计算公平性改进的标准化精度下降。

代码地址

本文方法

损失函数如下:

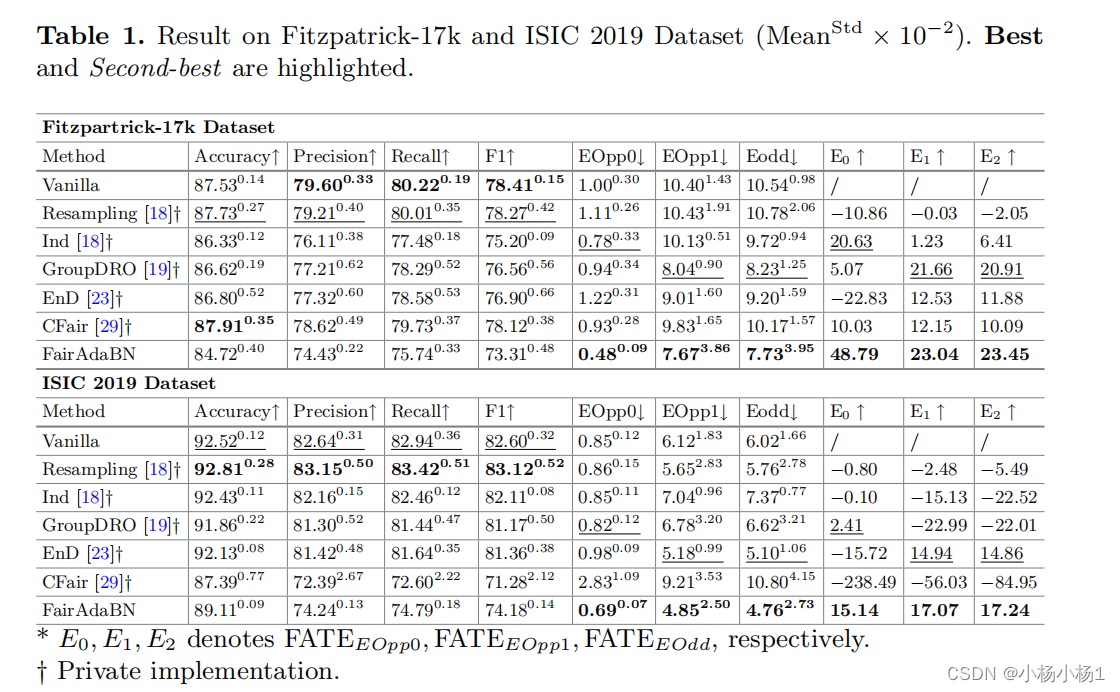

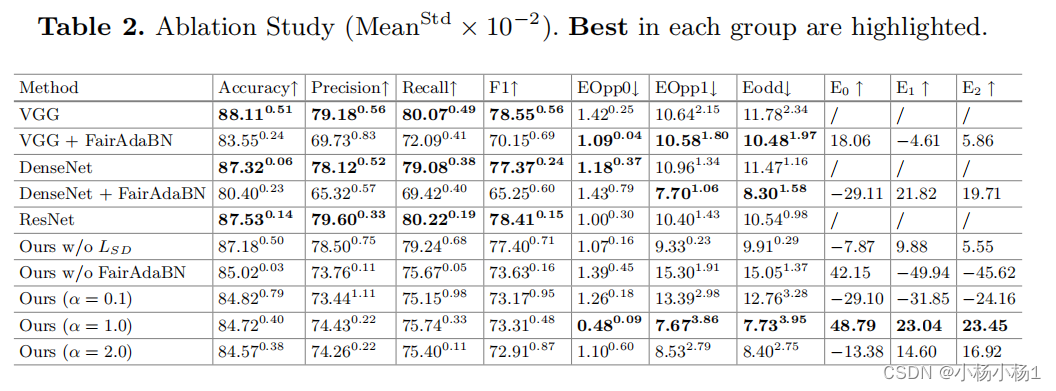

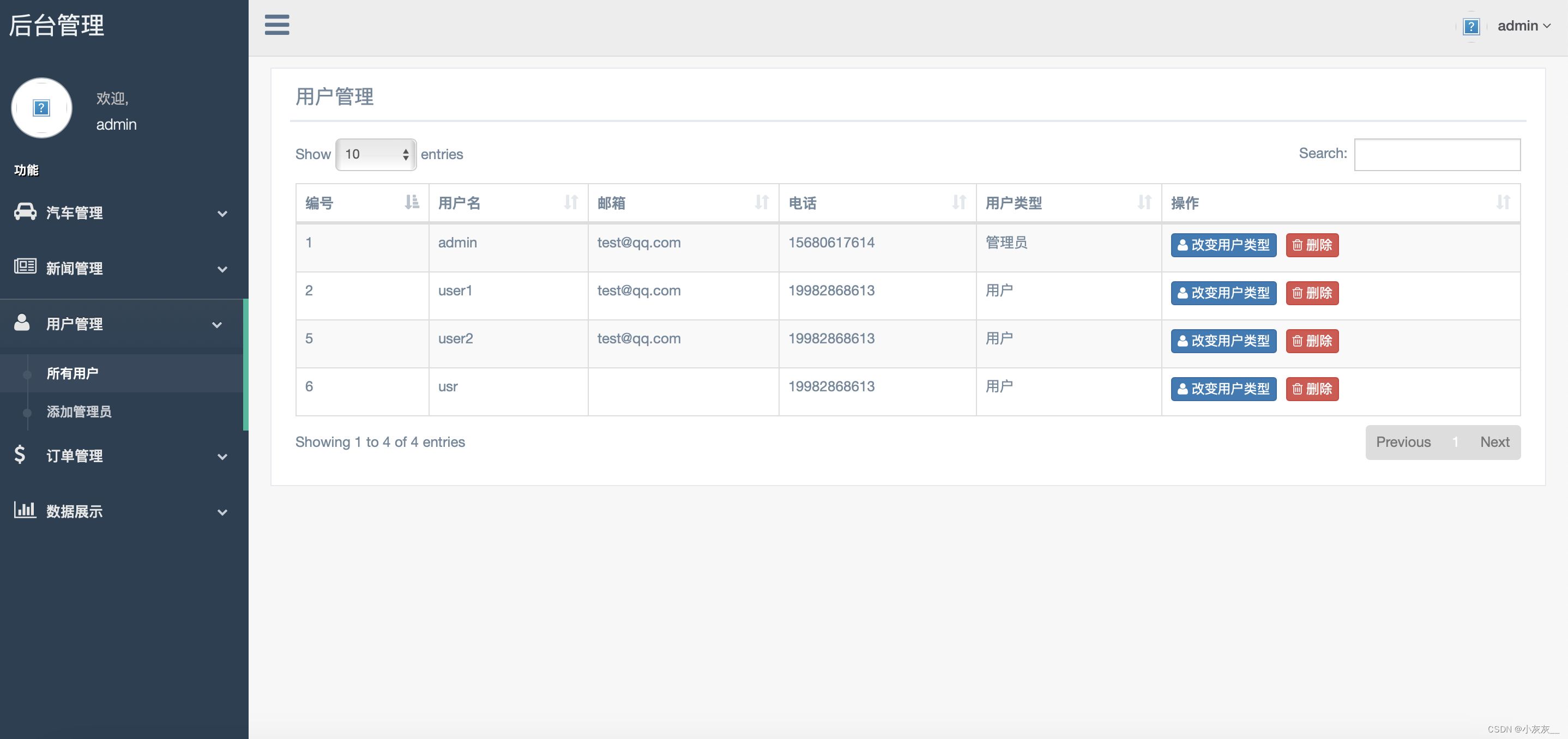

实验结果