【背景说明】

我正在学习sgg的数仓采集项目,采集内容分为用户行为日志采集和MySQL的业务数据采集。

用户行为日志采集分为2个阶段:

阶段1:将日志文件的数据通过flume采集到kafka。我的这一步正常,kafka上有数据,即f1.sh是正常的。

阶段2:将kafka上的数据采集到hdfs上,因为我是用application.yml造的数据,每次需要改这个文件中的mock.data这个参数,但我每次改完后。再次用lg.sh生成数据时,发现它没有跑。即f2.sh没有生效。

【原因】

啊,西八,又是个没注意到点小问题。

对了,另外我把f2.sh里面对应的这个flume进程又重启了一遍

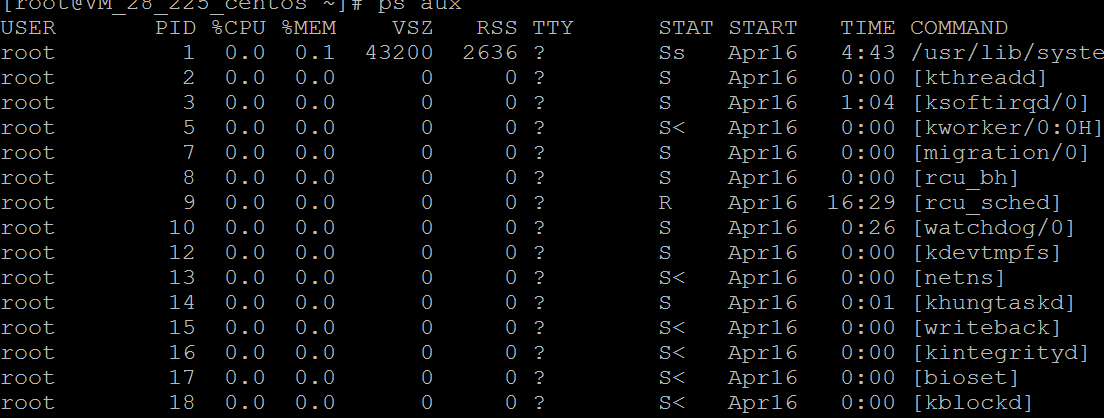

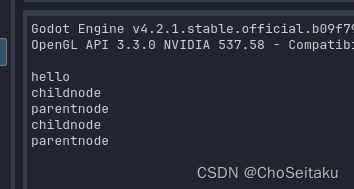

先杀死:ssh hadoop102 "ps -ef | grep kafka_to_hdfs_log | grep -v grep |awk '{print \$2}' | xargs -n1 kill"

再启动:[atguigu@hadoop104 flume]$ bin/flume-ng agent -n a1 -c conf/ -f jobs/collectionProject/kafka_to_hdfs_log.conf

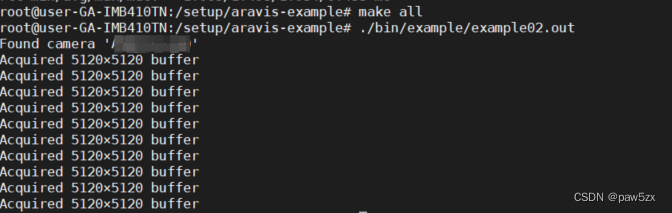

再查看hdfs上的数据生成情况:

成功!