目录

一.Kafka基本介绍

1.定义

2.特点

(1)高吞吐量、低延迟

(2)可扩展性

(3)持久性、可靠性

(4)容错性

(5)高并发

3.系统架构

(1)Broker(服务代理节点)

(2)Producer(生产者)

(3)Consumer(消费者)

(4)Consumer Group(消费组)

(5)ZooKeeper

(6)Topic(主题)

(7)Partition(分区)

(8)Replica(副本)

(9)Leader and Follower

(10)Offset(偏移量)

二.部署ZooKeeper+Kafka集群

1.环境准备

2.下载安装包

3.修改配置文件

4.设置环境变量

5.配置ZooKeeper启动脚本

6.设置开机自启并启动

7.Kafka命令行操作

(1)创建topic

(2)查看当前服务器中的所有topic

(3)查看某个topic的详情

(4)发布消息

(5)消费消息

(6)修改分区数

(7)删除topic

一.Kafka基本介绍

1.定义

Kafka 是一个分布式的基于发布/订阅模式的消息队列(MQ,Message Queue),主要应用于大数据实时处理领域。

最初由 Linkedin 公司开发,是一个分布式、支持分区的(partition)、多副本的(replica),基于 Zookeeper 协调的分布式消息中间件系统,它的最大的特性就是可以实时的处理大量数据以满足各种需求场景,比如基于 hadoop 的批处理系统、低延迟的实时系统、Spark/Flink 流式处理引擎,nginx 访问日志,消息服务等等,用 scala 语言编写,Linkedin 于 2010 年贡献给了 Apache 基金会并成为顶级开源项目。

官方网址:https://kafka.apache.org/

2.特点

(1)高吞吐量、低延迟

Kafka 每秒可以处理几十万条消息,它的延迟最低只有几毫秒。每个 topic 可以分多个 Partition,Consumer Group 对 Partition 进行消费操作,提高负载均衡能力和消费能力。

(2)可扩展性

kafka 集群支持热扩展

(3)持久性、可靠性

消息被持久化到本地磁盘,并且支持数据备份防止数据丢失

(4)容错性

允许集群中节点失败(多副本情况下,若副本数量为 n,则允许 n-1 个节点失败)

(5)高并发

支持数干个客户端同时读写

3.系统架构

- 生产者生产数据传给broker即kafka服务器集群

- kafka集群将数据存储在topic主题中,每个topic主题中有多个分片(分片做了备份在其他topic)

- 分片中存储数据,kafka集群注册在zookeeper中,zookeeper通知消费者kafka服务器在线列表

- 消费者收到zookeeper通知的在线列表,从broker中拉取数据

- 消费者保存偏移量到zookeeper中,以便记录自己宕机消费到什么地方

(1)Broker(服务代理节点)

- 服务代理节点,其实就是一个kafka实例或服务节点,多个broker构成了kafka集群

- 一台 kafka 服务器就是一个 broker。一个集群由多个 broker 组成。一个 broker 可以容纳多个 topic

(2)Producer(生产者)

- 生产者,也就是写入消息的一方,将消息写入broker中

- 即数据的发布者,该角色将消息 push 发布到 Kafka 的 topic 中

- broker 接收到生产者发送的消息后,broker 将该消息追加到当前用于追加数据的 segment 文件中

- 生产者发送的消息,存储到一个 partition 中,生产者也可以指定数据存储的 partition

(3)Consumer(消费者)

- 消费者,也就是读取消息的一方,从broker中pull 拉取数据

- 可以消费多个 topic 中的数据

(4)Consumer Group(消费组)

- 消费者组,由多个 consumer 组成

- 所有的消费者都属于某个消费者组,即消费者组是逻辑上的一个订阅者。可为每个消费者指定组名,若不指定组名则属于默认的组

- 将多个消费者集中到一起去处理某一个 Topic 的数据,可以更快的提高数据的消费能力

- 消费者组内每个消费者负责消费不同分区的数据,一个分区只能由一个组内消费者消费,防止数据被重复读取

- 消费者组之间互不影响

- 消费组。一个或多个消费者构成一个消费组,不同的消费组可以订阅同一个主题的消息且互不影响

(5)ZooKeeper

- kafka使用zookeeper来管理集群的元数据 meta 信息,以及控制器的选举等操作

- 由于 consumer 在消费过程中可能会出现断电宕机等故障,consumer 恢复后,需要从故障前的位置的继续消费,所以 consumer 需要实时记录自己消费到了哪个 offset,以便故障恢复后继续消费

- zookeeper的作用就是,生产者push数据到kafka集群,就必须要找到kafka集群的节点在哪里,这些都是通过zookeeper去寻找的。消费者消费哪一条数据,也需要zookeeper的支持,从zookeeper获得offset,offset记录上一次消费的数据消费到哪里,这样就可以接着下一条数据进行消费

(6)Topic(主题)

- 可以理解为一个队列,生产者和消费者面向的都是一个 topic。

- 类似于数据库的表名或者 ES 的 index

- 物理上不同 topic 的消息分开存储

(7)Partition(分区)

- 分区,同一个主题下的消息还可以继续分成多个分区,一个分区只属于一个主题

- 为了实现扩展性,一个非常大的 topic 可以分布到多个 broker(即服务器)上,一个 topic 可以分割为一个或多个 partition,每个 partition 是一个有序的队列。Kafka 只保证 partition 内的记录是有序的,而不保证 topic 中不同 partition 的顺序

- 每个 topic 至少有一个 partition,当生产者产生数据的时候,会根据分配策略选择分区,然后将消息追加到指定的分区的队列末尾

Partation 数据路由规则:

1.指定了 patition,则直接使用

2.未指定 patition 但指定 key(相当于消息中某个属性),通过对 key 的 value 进行 hash 取模,选出一个 patition

3.patition 和 key 都未指定,使用轮询选出一个 patition每条消息都会有一个自增的编号,用于标识消息的偏移量,标识顺序从 0 开始。

每个 partition 中的数据使用多个 segment 文件存储。

如果 topic 有多个 partition,消费数据时就不能保证数据的顺序。严格保证消息的消费顺序的场景下(例如商品秒杀、 抢红包),需要将 partition 数目设为 1。

- broker 存储 topic 的数据。如果某 topic 有 N 个 partition,集群有 N 个 broker,那么每个 broker 存储该 topic 的一个 partition。

- 如果某 topic 有 N 个 partition,集群有 (N+M) 个 broker,那么其中有 N 个 broker 存储 topic 的一个 partition, 剩下的 M 个 broker 不存储该 topic 的 partition 数据。

- 如果某 topic 有 N 个 partition,集群中 broker 数目少于 N 个,那么一个 broker 存储该 topic 的一个或多个 partition。在实际生产环境中,尽量避免这种情况的发生,这种情况容易导致 Kafka 集群数据不均衡。

(8)Replica(副本)

- 副本,一个分区可以有多个副本来提高容灾性

- 为保证集群中的某个节点发生故障时,该节点上的 partition 数据不丢失,且 kafka 仍然能够继续工作,kafka 提供了副本机制,一个 topic 的每个分区都有若干个副本,一个 leader 和若干个 follower

(9)Leader and Follower

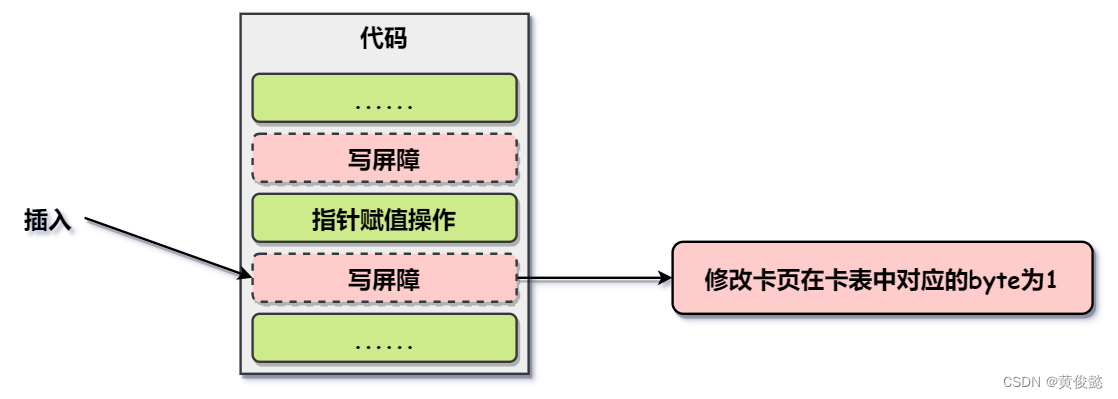

- 分区有了多个副本,那么就需要有同步方式。kafka使用一主多从进行消息同步,主副本提供读写的能力,而从副本不提供读写,仅仅作为主副本的备份

- 每个 partition 有多个副本,其中有且仅有一个作为 Leader,Leader 是当前负责数据的读写的 partition

- Follower 跟随 Leader,所有写请求都通过 Leader 路由,数据变更会广播给所有 Follower,Follower 与 Leader 保持数据同步。Follower 只负责备份,不负责数据的读写。

- 如果 Leader 故障,则从 Follower 中选举出一个新的 Leader。

- 当 Follower 挂掉、卡住或者同步太慢,Leader 会把这个 Follower 从 ISR(Leader 维护的一个和 Leader 保持同步的 Follower 集合) 列表中删除,重新创建一个 Follower

(10)Offset(偏移量)

- 可以唯一的标识一条消息,分区中的每一条消息都有一个所在分区的偏移量,这个偏移量唯一标识了该消息在当前这个分区的位置,并保证了在这个分区的顺序性,不过不保证跨分区的顺序性

- 偏移量决定读取数据的位置,不会有线程安全的问题,消费者通过偏移量来决定下次读取的消息(即消费位置)

- 消息被消费之后,并不被马上删除,这样多个业务就可以重复使用 Kafka 的消息

- 某一个业务也可以通过修改偏移量达到重新读取消息的目的,偏移量由用户控制

- 消息最终还是会被删除的,默认生命周期为 1 周(7*24小时)

二.部署ZooKeeper+Kafka集群

1.环境准备

| 服务器类型 | 系统和IP地址 | 需要安装的组件 |

|---|---|---|

| Zookeeper服务器1 | CentOS7.4(64 位) 192.168.227.100 | jdk、ZooKeeper |

| Zookeeper服务器2 | CentOS7.4(64 位) 192.168.227.101 | jdk、ZooKeeper |

| Zookeeper服务器3 | CentOS7.4(64 位) 192.168.227.102 | jdk、ZooKeeper |

需要部署ZooKeeper集群(详情请见ZooKeeper分布式应用程序协调服务-CSDN博客)三台服务器步骤相同,此处只展示一台设备的搭建

2.下载安装包

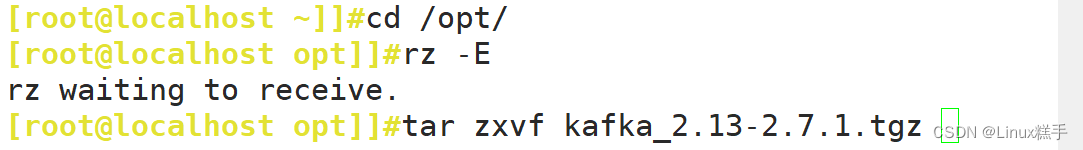

1. #下载安装包

cd /opt

wget https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/2.7.1/kafka_2.13-2.7.1.tgz

1.1 #有压缩包就直接拖进来

cd /opt

rz -E

2. #安装Kafka

tar zxvf kafka_2.13-2.7.1.tgz

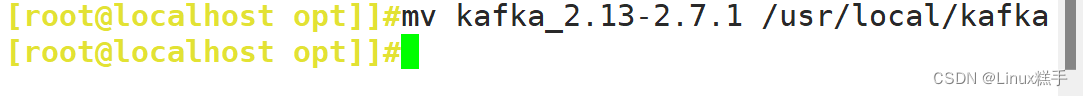

mv kafka_2.13-2.7.1 /usr/local/kafka

3.修改配置文件

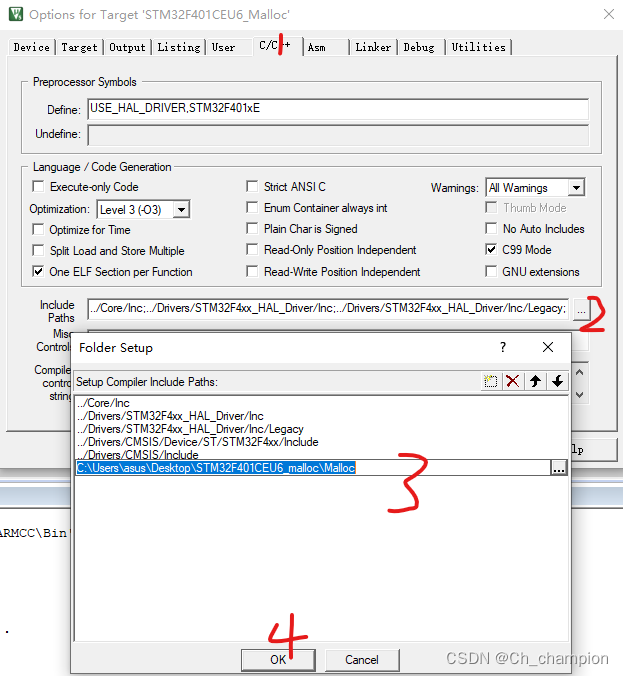

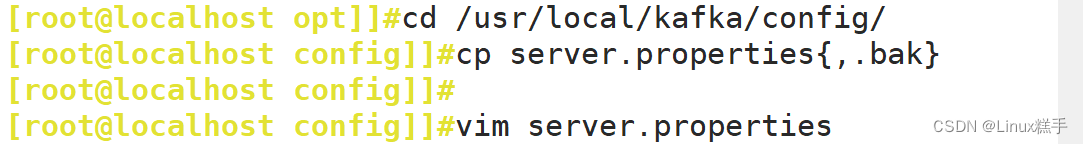

1. #移动并将配置文件进行备份

cd /usr/local/kafka/config/

cp server.properties{,.bak}

2. #修改

vim server.properties

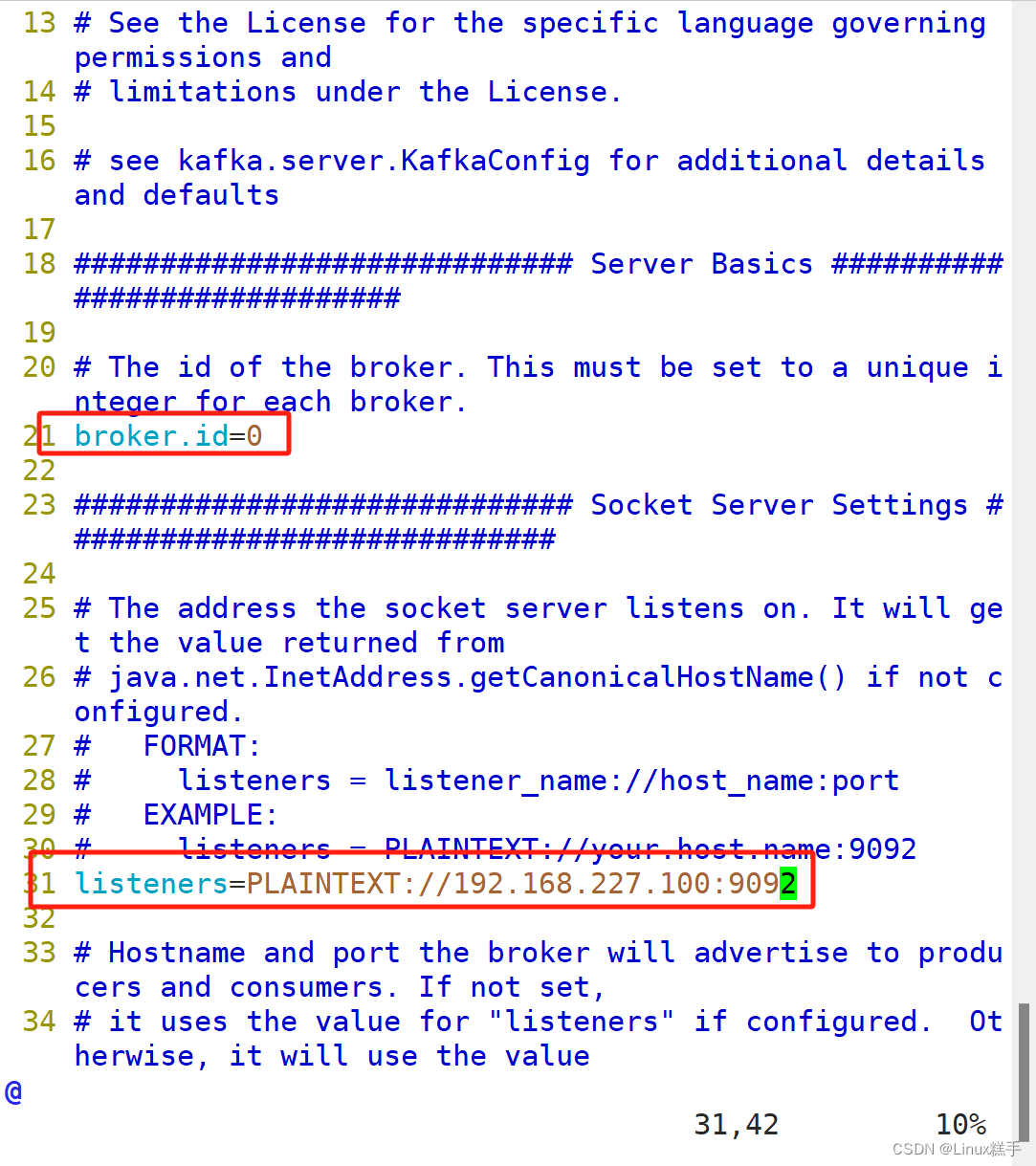

-------------------------------------------

broker.id=0

#21行,broker的全局唯一编号,每个broker不能重复,因此要在其他机器上配置 broker.id=1、broker.id=2

listeners=PLAINTEXT://192.168.227.100:9092

#31行,指定监听的IP和端口,如果修改每个broker的IP需区分开来,也可保持默认配置不用修改

num.network.threads=3

#42行,broker 处理网络请求的线程数量,一般情况下不需要去修改

num.io.threads=8

#45行,用来处理磁盘IO的线程数量,数值应该大于硬盘数

socket.send.buffer.bytes=102400 #48行,发送套接字的缓冲区大小

socket.receive.buffer.bytes=102400 #51行,接收套接字的缓冲区大小

socket.request.max.bytes=104857600 #54行,请求套接字的缓冲区大小

log.dirs=/usr/local/kafka/logs #60行,kafka运行日志存放的路径,也是数据存放的路径

num.partitions=1

#65行,topic在当前broker上的默认分区个数,会被topic创建时的指定参数覆盖

num.recovery.threads.per.data.dir=1 #69行,用来恢复和清理data下数据的线程数量

log.retention.hours=168

#103行,segment文件(数据文件)保留的最长时间,单位为小时,默认为7天,超时将被删除

log.segment.bytes=1073741824

#110行,一个segment文件最大的大小,默认为 1G,超出将新建一个新的segment文件

zookeeper.connect=192.168.227.100:2181,192.168.227.101:2181,192.168.227.102:2181

#123行,配置连接Zookeeper集群地址

------------------------------------------------

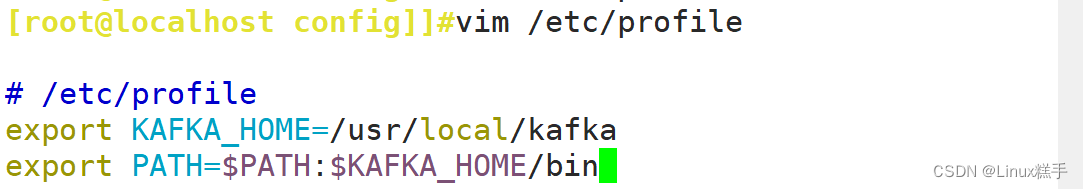

4.设置环境变量

1. #修改环境变量

vim /etc/profile

----------------------------------------

export KAFKA_HOME=/usr/local/kafka

export PATH=$PATH:$KAFKA_HOME/bin

-----------------------------------------

2. #刷新配置文件

source /etc/profile

3. #查看环境变量

echo $PATH

5.配置ZooKeeper启动脚本

vim /etc/init.d/kafka

------------------------------------------------

#!/bin/bash

#chkconfig:2345 22 88

#description:Kafka Service Control Script

KAFKA_HOME='/usr/local/kafka'

case $1 in

start)

echo "---------- Kafka 启动 ------------"

${KAFKA_HOME}/bin/kafka-server-start.sh -daemon ${KAFKA_HOME}/config/server.properties

;;

stop)

echo "---------- Kafka 停止 ------------"

${KAFKA_HOME}/bin/kafka-server-stop.sh

;;

restart)

$0 stop

$0 start

;;

status)

echo "---------- Kafka 状态 ------------"

count=$(ps -ef | grep kafka | egrep -cv "grep|$$")

if [ "$count" -eq 0 ];then

echo "kafka is not running"

else

echo "kafka is running"

fi

;;

*)

echo "Usage: $0 {start|stop|restart|status}"

esac

------------------------------------------------------------------

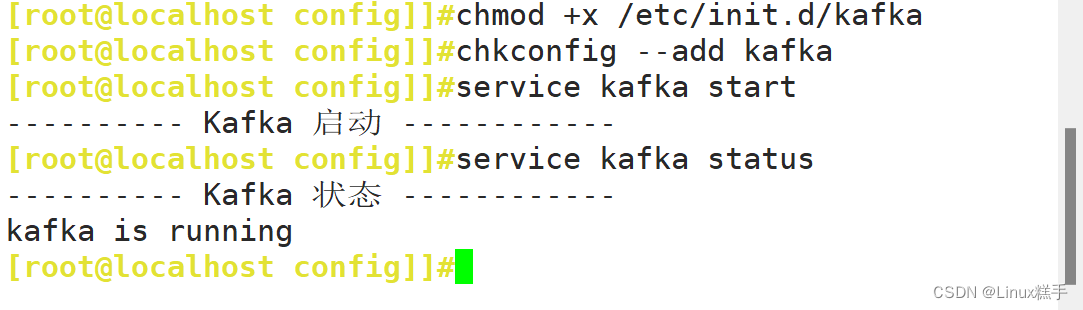

6.设置开机自启并启动

1. #设置开机自启

chmod +x /etc/init.d/kafka

chkconfig --add kafka

2. #分别启动 Kafka

service kafka start

7.Kafka命令行操作

(1)创建topic

kafka-topics.sh --create --zookeeper 192.168.227.100:2181,192.168.227.101:2181,192.168.227.102:2181 --replication-factor 2 --partitions 3 --topic test

############################################

--zookeeper:定义 zookeeper 集群服务器地址,如果有多个 IP 地址使用逗号分割,一般使用一个 IP 即可

--replication-factor:定义分区副本数,1 代表单副本,建议为 2

--partitions:定义分区数

--topic:定义 topic 名称

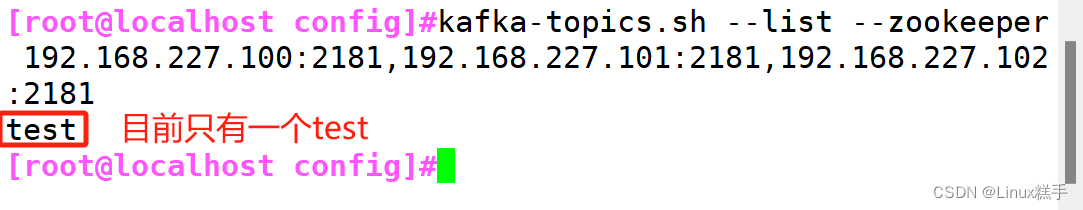

(2)查看当前服务器中的所有topic

kafka-topics.sh --list --zookeeper 192.168.227.100:2181,192.168.227.101:2181,192.168.227.102:2181

(3)查看某个topic的详情

kafka-topics.sh --describe --zookeeper 192.168.227.100:2181,192.168.227.101:2181,192.168.227.102:2181

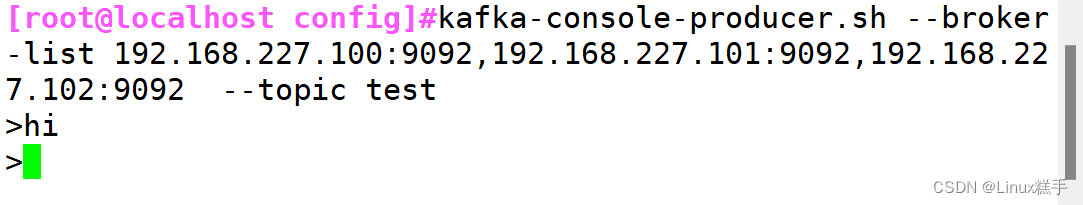

(4)发布消息

kafka-console-producer.sh --broker-list 192.168.227.100:9092,192.168.227.101:9092,192.168.227.102:9092 --topic test

(5)消费消息

kafka-console-consumer.sh --bootstrap-server 192.168.227.100:9092,192.168.227.101:9092,192.168.227.102:9092 --topic test --from-beginning

#--from-beginning:会把主题中以往所有的数据都读取出来

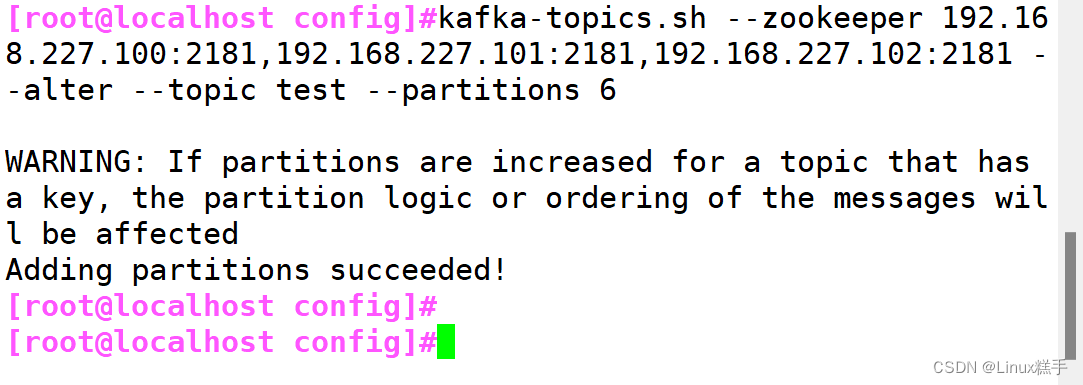

(6)修改分区数

kafka-topics.sh --zookeeper 192.168.227.100:2181,192.168.227.101:2181,192.168.227.102:2181 --alter --topic test --partitions 6

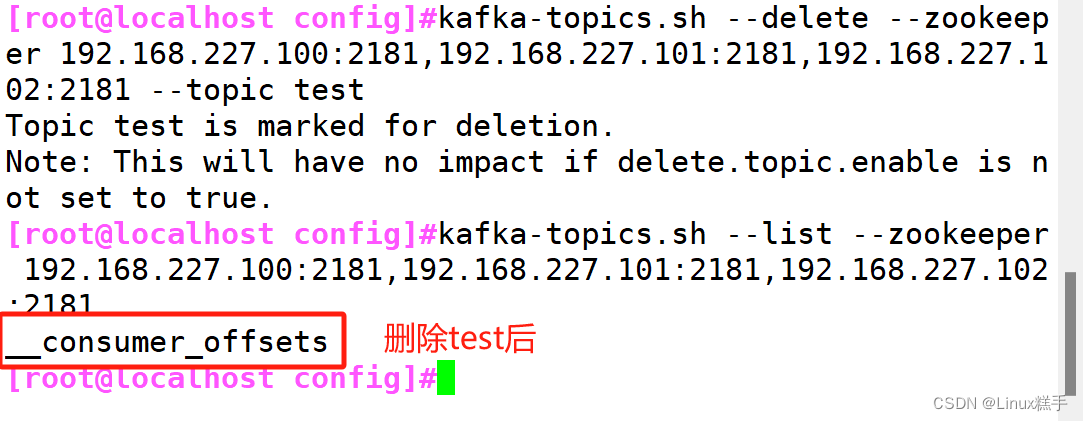

(7)删除topic

kafka-topics.sh --delete --zookeeper 192.168.227.100:2181,192.168.227.101:2181,192.168.227.102:2181 --topic test