目录

前言

一些说明

过程

git chatglm.cpp代码

安装相关包

convert量化ggml

cmake构建项目

命令行模型推理

webdemo模型推理

APIServer

性能表现

gpu推理设置

前言

Linux之前用的少,多数还是在Windows下操作,导致对Linux很陌生,而且思维定势的,一有什么操作,还是习惯性在Windows下操作。

在chatglm.cpp操作上也是如此,但是代码可不管你这些,该报错就报错。so可能还是尝试下Linux。而wsl下Linux就是一个比较方便使用Linux环境的方法,wsl很轻量化,避免了你还得再安装虚拟机软件,而且VMWare可能还和docker存在冲突。

wsl下Linux基本操作间如下链接,本文主要讲后续如何在wsl下的Linux环境使用chatglm.cpp

wsl初步使用记录-CSDN博客![]() https://blog.csdn.net/to_love_/article/details/137559827

https://blog.csdn.net/to_love_/article/details/137559827

一些说明

wsl下的Linux环境还是比较干净,相比云服务器提供了毕竟完善的软件安装,wsl下的Linux系统一些软件都需要自己安装的。

对于这些不一样的地方,我进行颜色标识,方便快速查阅。

过程

git chatglm.cpp代码

git clone --recursive https://github.com/li-plus/chatglm.cpp.git && cd chatglm.cpp

git submodule update --init --recursive正常是没问题的,不过我这里一直连不上github.com,提示连接被拒绝,而且是秒拒。

试着ping结果ip是127.0.0.1,怪不得,应该和我Windows本机使用了Github加速代理有关,本质上是给hosts加了github.com的映射记录。

而且吧,wsl还有个机制,他会自动同步Windows宿主机的hosts记录到Linux下的hosts文件。当然可以关闭自动更新

sudo vim /etc/wsl.conf

增加

[network]

generateHosts = false

小提示:这里使用了vim编辑器,需要保存的话,先按ESC键,然后输入:wq即可保存并退出。

cat /etc/wsl.conf即可查看文件是否已更新

cat /etc/hosts查看Linux下hosts文件,是否还有错误的github.com映射信息

有的话,通过sudo vim /etc/hosts删掉,并增加20.205.243.166 github.com,这样访问githun.com就会去找这个新增的IP记录(注意:ip地址可能会变,则需要更新)

这个时候再次ping github.com,IP信息已经变过来了。

接下来重启Linux环境

wsl --shutdown ubuntu(这里看你具体的wsl系统名)

重新进入Linux环境

wsl -d ubuntu

这个时候就可以正常执行git操作了

安装相关包

python3 -m pip install torch tabulate tqdm transformers accelerate sentencepiece这个时候会提示pip不存在(python倒是有了),那么再安装下pip

sudo apt install python3-pip

接下来即可正常pip install了,不过这几个包都很大,下载包很慢。那么可以先Ctrl+C停掉安装过程,在如上命令后加 -i https://pypi.tuna.tsinghua.edu.cn/simple,这样通过清华pip镜像源下载就飞快了

convert量化ggml

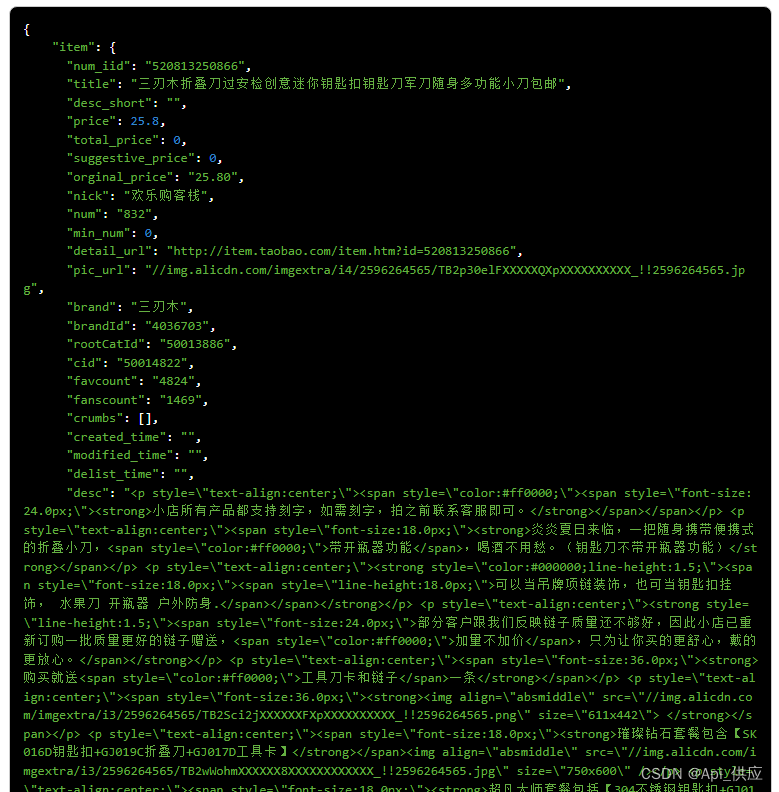

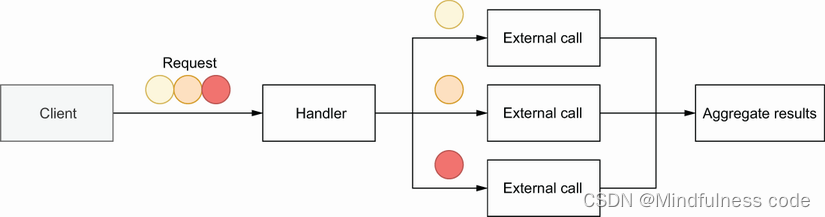

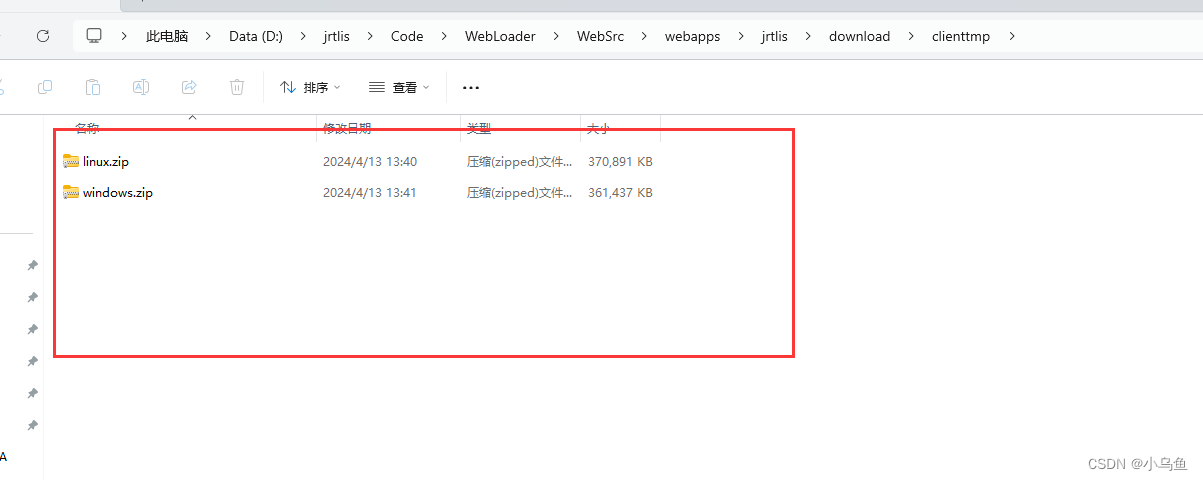

python3 chatglm_cpp/convert.py -i THUDM/chatglm3-6b -t q4_0 -o chatglm3-ggml.bin如果使用该命令,如果当前模型文件不存在,会自动从huggingface下载模型。

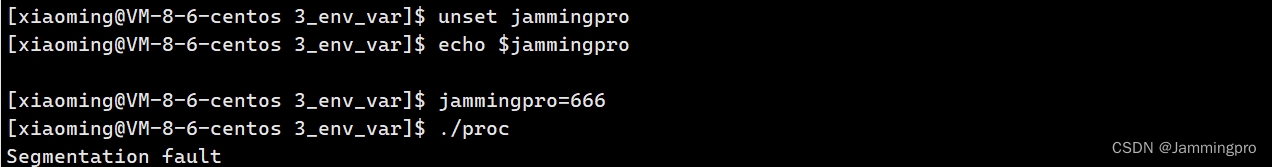

这个时候问题又来了,由于网络原因,会提示你连不上huggingface,那么就需要通过镜像来下载,即需要设置huggingface模型下载地址的环境变量

export HF_ENDPOINT="https://hf-mirror.com"

查看是否已更新echo $HF_ENDPOINT

继续执行如上命令,这速度嗖嗖的~

很快q4_0量化模型也好了

cmake构建项目

cmake -B build

cmake --build build -j --config Release其实,这里也需要先安装cmake

sudo apt update

sudo apt install cmake

命令行模型推理

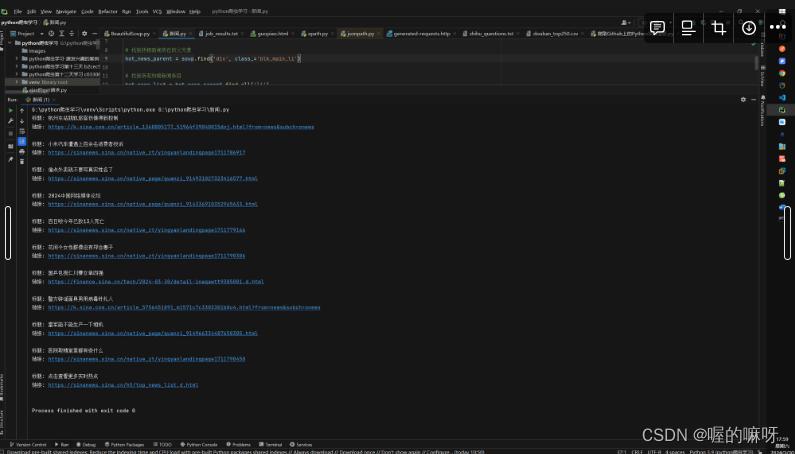

./build/bin/main -m chatglm3-ggml.bin -p 你好webdemo模型推理

python3 ./examples/web_demo.py -m chatglm3-ggml.bin这里会提示chatglm_cpp不存在,pip install .即可解决

再次运行提示gradio不存在,pip install gradio即可,这个包可以更新到最前面的pip install命令中

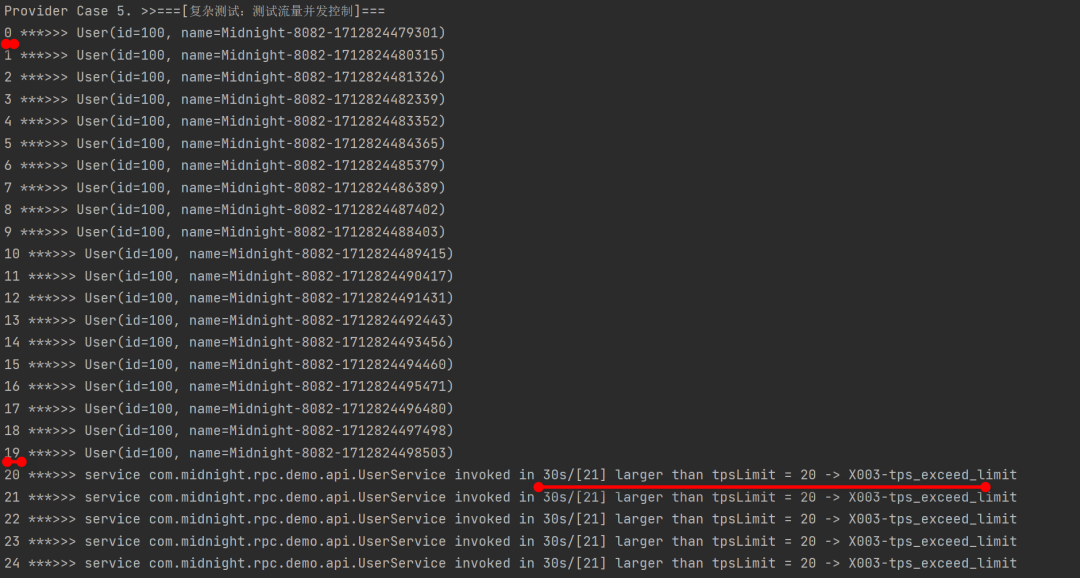

APIServer

首先说下这块比较有坑

MODEL=./chatglm3-ggml.bin uvicorn chatglm_cpp.openai_api:app --host 127.0.0.1 --port 8000

这个时候会报错,不存在chatglm_cpp._C

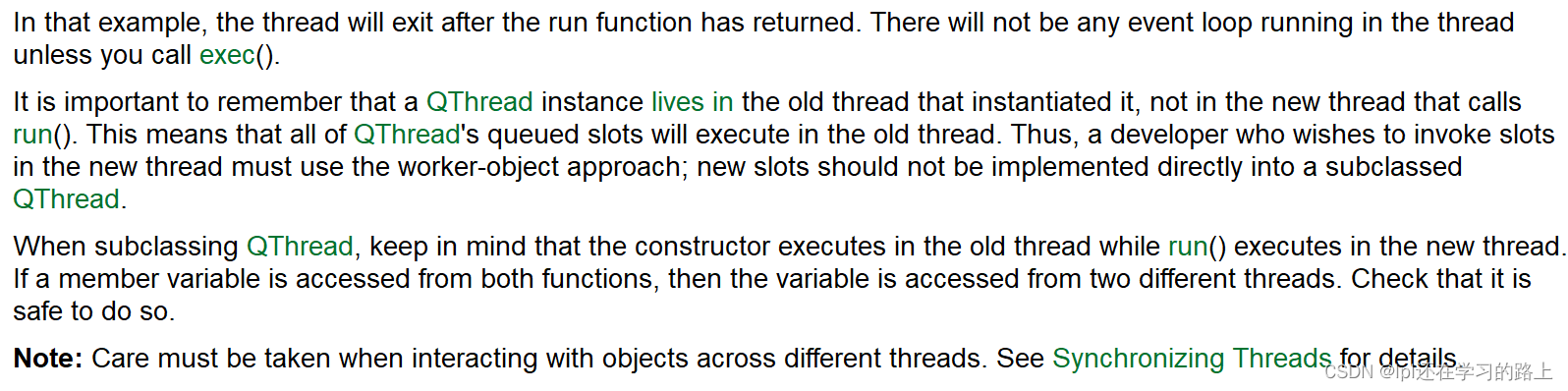

可以发现如上命令是在chatglm.cpp路径下执行的,然后openai_api.py在chatglm_cpp路径下。看了下代码,在chatglm_cpp下有__init__.py,里边引用了chatglm_cpp._C。另一方面,我们在前面pip install的时候也是chatglm_cpp,可能两个一起有冲突,这样就出问题了

有2个办法吧,一个是改掉这个文件夹名称,比如改为chatglm-cpp

再一个,cd 到chatglm_cpp下执行,这个时候需要改下命令,主要是相对路径变了

MODEL=../chatglm3-ggml.bin uvicorn openai_api:app --host 127.0.0.1 --port 8000

两种方式都可以的,然后通过apipost或代码方式,都可以调用类openai的webapi了

性能表现

我这本身的Windows环境,然后是通过wsl新建了一个Linux环境。

硬件方面,没有GPU,在q4_0量化后,速度也还凑合用。

不过个人觉得,要准生产可用,还是需要GPU的,推理速度还是会差很多的。

gpu推理设置

如果电脑有GPU,那么cmake和pip install .的时候,都需要增加参数

cmake -B build -DGGML_CUBLAS=ON

CMAKE_ARGS="-DGGML_CUBLAS=ON" pip install .

相关参数其实在chatglm.cpp代码下的readme文档都有说明。