自监督学习之掩码自动编码器(Masked Autoencoders, MAE)——音频识别方面

1.参考文献

《Masked Autoencoders that Listen》

2.背景

Transformers和self-supervised learning(自监督学习)占据了计算机视觉(Computer Vision,CV)和自然语言处理(natural language processing, NLP)的主导地位。

使用BERT进行屏蔽自动编码,通过对大规模语言语料库的自监督预训练,为各种NLP任务提供了一种新的最新技术。类似地,在CV社区中,Vision Transformers (ViT)变得越来越流行,在自监督的图像表示学习中,掩码自动编码器(MAE)使CV社区更接近BERT在NLP中的成功。

在这项工作中,主要研究了听的方面,即音频识别方面,如Audioset(规模最大的音频数据集),环境声识别(ESC-50),语音指令识别(SPC-2, SPC-1),说话人识别(VoxCeleb)。

3.掩码自动编码器

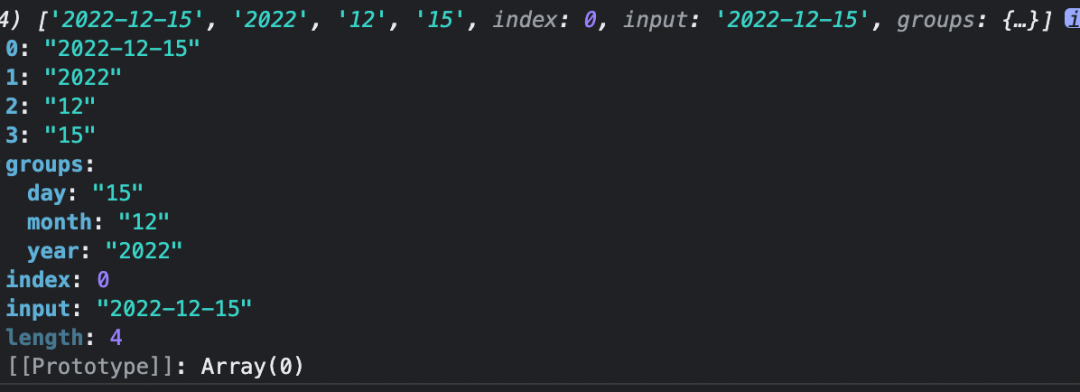

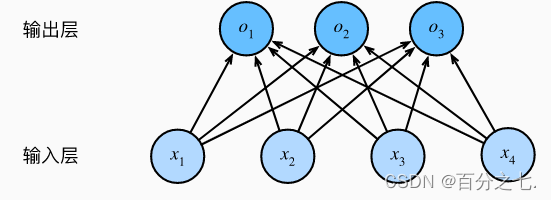

MAE如上图所示。

①将音频的时频谱图分割成许多patch,对大部分patch进行掩码处理;

②通过把剩余可见的patch块进行编码操作;

③然后通过解码操作,对顺序恢复和掩码patch块进行重构输出;

④并与目标时频谱图计算MSE损失以此更新编码器和解码器;

这里编码器使用12-layer ViT-Base (ViT-B)

解码器用standard Transformer模块。

具体细节可以看原文。

4.微调至下游任务

MAE最终只保留编码器部分,解码器将删除,这样就能应用到下游任务。

5.结果

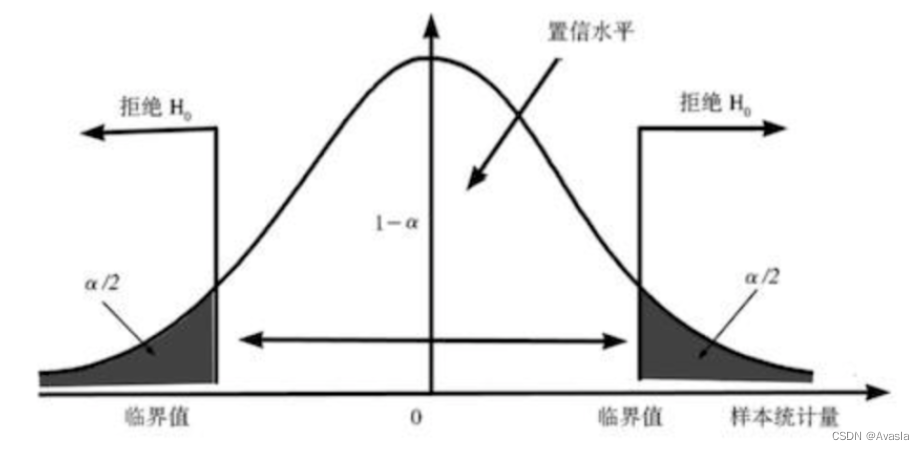

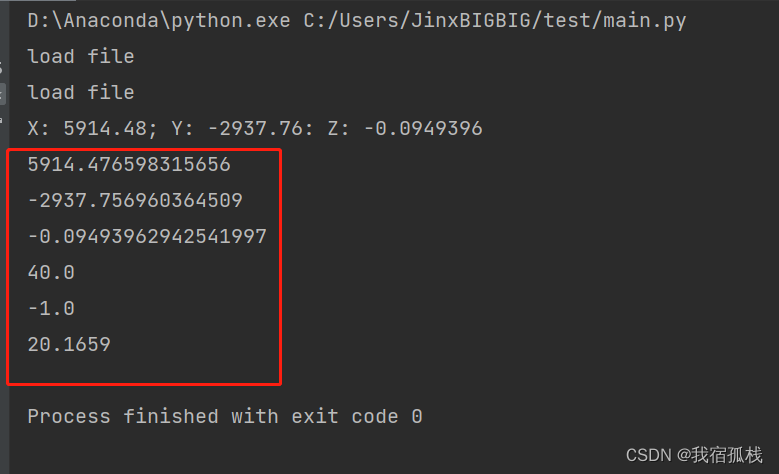

谱图修复结果如上图所示

MAE下游任务结果如上表所示

6.应用拓展

MAE预训练模型可以用于各种下游任务,对于提升识别率都很有效。