🎈🎈作者主页: 喔的嘛呀🎈🎈

🎈🎈所属专栏:python爬虫学习🎈🎈

✨✨谢谢大家捧场,祝屏幕前的小伙伴们每天都有好运相伴左右,一定要天天开心哦!✨✨

目录

一、URLError和HTTPError

三、Handler处理器

兄弟姐妹们,大家好哇!今天我们来学习URLError和HTTPError、cookie登录、Handler处理器这三个方面的知识

一、URLError和HTTPError

在Python中进行网络爬虫时,经常会遇到 URLError 和 HTTPError 异常。这两种异常通常与网络连接和HTTP请求有关,以下是它们的一些常见情况和处理方法:

URLError:表示URL无效或无法打开的错误,可能的原因包括网络连接问题、URL拼写错误等。处理方法包括:- 检查URL是否正确,并确保网络连接正常。

- 使用

try-except块捕获URLError异常,并进行相应的处理。

from urllib.error import URLError

import urllib.request

url = "<http://example.com>"

try:

response = urllib.request.urlopen(url)

# 处理响应数据

except URLError as e:

print("URLError:", e)

# 处理异常情况

2、HTTPError:表示HTTP请求错误,例如404 Not Found等。处理方法包括:

- 使用

try-except块捕获HTTPError异常,并根据状态码进行处理。 - 可以通过

e.code获取状态码,e.reason获取原因。

from urllib.error import HTTPError

import urllib.request

url = "<http://example.com/404>"

try:

response = urllib.request.urlopen(url)

# 处理响应数据

except HTTPError as e:

print("HTTPError:", e.code, e.reason)

# 处理异常情况

在处理这些异常时,可以根据具体情况进行适当的错误处理和重试机制,以确保网络爬虫的稳定性和可靠性。

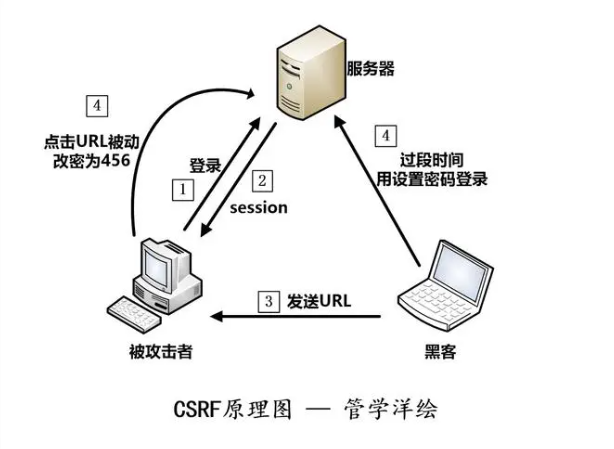

二、cookie登录

Cookie登录,需要分为以下步骤:

- 发送登录请求并获取Cookie:首先,您需要发送一个POST请求到登录页面,包含用户名和密码等登录信息。成功登录后,服务器会返回一个包含登录凭据的Cookie。您可以使用**

requests库来发送这个请求,并通过response.cookies**属性获取Cookie。 - 使用Cookie进行后续请求:在登录后,您可以使用获取到的Cookie来发送其他请求,以模拟登录状态。每次请求都需要包含这个Cookie,以便服务器能够识别您已经登录。

以下是一个示例,演示如何使用Python进行Cookie登录:

import requests

# 登录页面URL和登录信息

login_url = '<https://example.com/login>'

login_data = {

'username': 'your_username',

'password': 'your_password'

}

# 发送登录请求并获取Cookie

response = requests.post(login_url, data=login_data)

cookies = response.cookies

# 使用Cookie发送后续请求

protected_url = '<https://example.com/protected-page>'

response = requests.get(protected_url, cookies=cookies)

# 检查响应状态码

if response.status_code == 200:

# 打印响应内容

print(response.text)

else:

print('Failed to retrieve protected page. Status code:', response.status_code)

在这个示例中,首先发送了一个POST请求到**example.com/login,并包含了用户名和密码作为表单数据。然后,从登录响应中获取了Cookie,并将其保存在cookies变量中。最后,使用这个Cookie发送了一个GET请求到example.com/protected-page**,以获取受保护页面的内容。

案列:模拟登录Gitte并访问用户信息的示例:

import requests

from bs4 import BeautifulSoup

# 登录页面 URL

login_url = '<https://gitte.cn/login>'

# 受保护页面 URL

protected_url = '<https://gitte.cn/settings>'

# 用户名和密码

username = 'your_username'

password = 'your_password'

# 创建会话对象

session = requests.Session()

# 设置请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.116 Safari/537.36'

}

# 发送登录请求,禁用SSL证书验证

login_data = {'username': username, 'password': password}

login_response = session.post(login_url, headers=headers, data=login_data, verify=False)

# 检查登录是否成功

if login_response.status_code == 200:

print("Login successful")

# 获取重定向后的页面

protected_response = session.get(protected_url, headers=headers, verify=False)

# 检查是否成功访问受保护页面

if protected_response.status_code == 200:

print("Protected page content:")

soup = BeautifulSoup(protected_response.text, 'html.parser')

# 解析页面内容

content = soup.find('div', class_='your_content_class')

if content:

print(content.text)

else:

print("Failed to find content on protected page")

else:

print("Failed to retrieve protected page. Status code:", protected_response.status_code)

else:

print("Login failed")

这个案列是针对cookie这方面的,报错也没事,给后面的知识一块用才可以爬取到信息

注意:受保护页面通常指需要登录或授权才能访问的页面。这些页面可能包含用户个人信息、敏感数据或需要特定权限才能查看的内容。通过登录或授权后,用户可以访问这些受保护页面。在网络应用程序中,受保护页面通常用于确保用户身份验证和数据安全性。

三、Handler处理器

Handler处理器在Python的urllib库中是一个非常重要的组件,它提供了一种灵活和高级的方式来处理HTTP请求。使用Handler处理器的主要原因包括:

- 处理各种情况的请求:Handler处理器可以处理各种情况下的HTTP请求,如处理HTTP重定向、处理代理、处理cookie等。这使得我们可以更灵活地处理不同情况下的请求。

- 定制请求头和请求参数:通过Handler处理器,我们可以定制请求头和请求参数,以满足不同的需求。这样可以更好地模拟浏览器行为,使得我们可以发送更加复杂和特定的请求。

- 处理cookie和认证信息:Handler处理器可以用于处理cookie和认证信息,使得我们可以在请求中包含cookie和认证信息,从而实现对需要认证的网站进行访问。

- 处理代理:Handler处理器可以用于设置代理服务器,从而实现通过代理服务器发送请求,这对于需要使用代理的情况非常有用。

- 处理HTTP和HTTPS请求:Handler处理器可以用于处理HTTP和HTTPS请求,使得我们可以发送安全的HTTPS请求,并对响应进行处理。

总的来说,Handler处理器提供了一种灵活和高级的方式来处理HTTP请求,使得我们可以更好地控制请求和响应的处理过程,从而实现更加复杂和特定的功能。

Handler处理器是Python标准库urllib中用于处理HTTP请求的组件之一,它提供了一种灵活的方式来处理请求和响应。Handler处理器可以用于处理HTTP请求的各种情况,比如处理重定向、处理代理、处理cookie等。

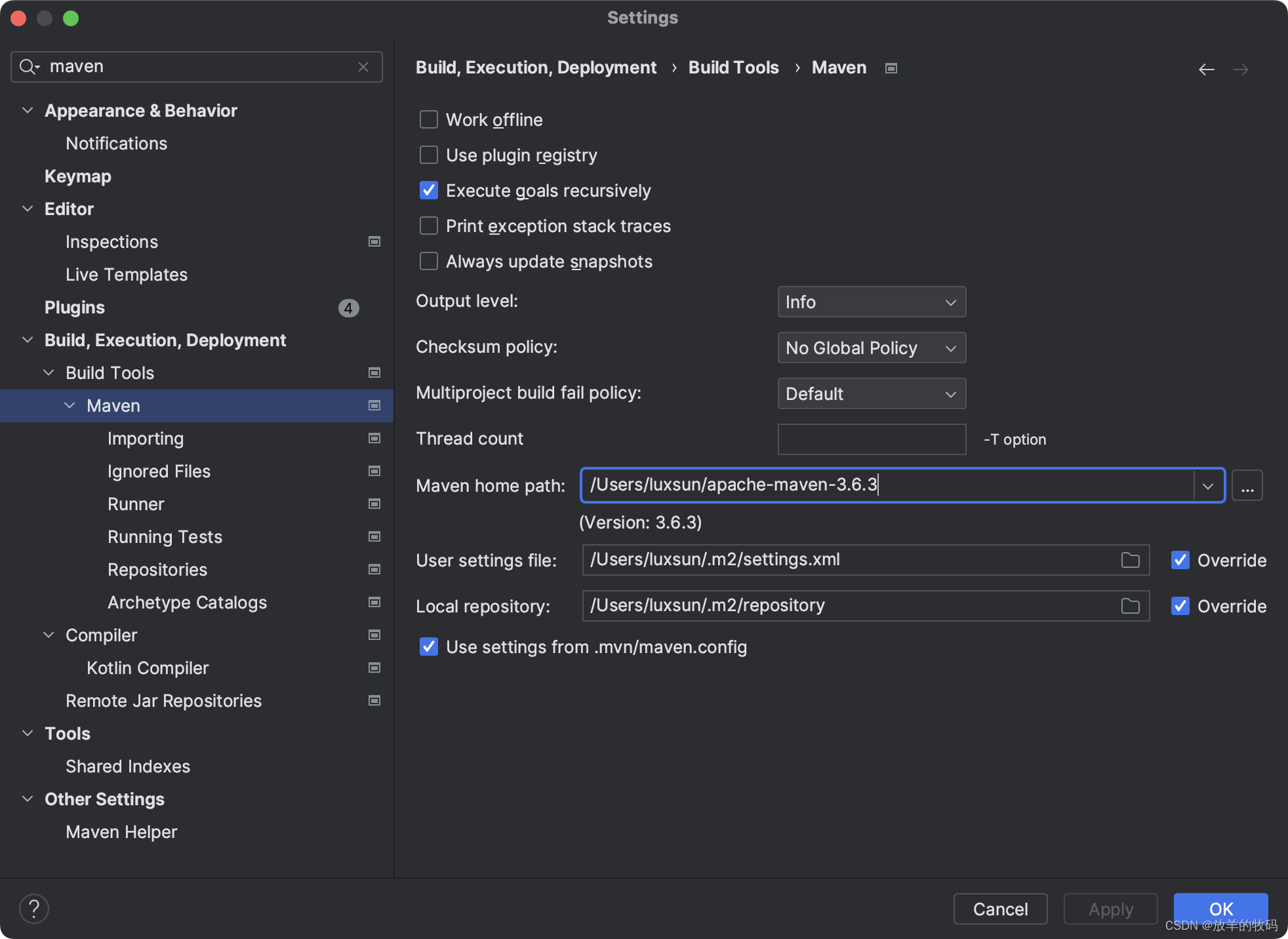

下面是Handler处理器的基本使用方法:

- 导入必要的模块:

import urllib.request

import urllib.error

https://lh3.googleusercontent.com/a/AGNmyxaP8ZNr9lxDW8mItZrsrrHxTdxmBq6TmE5JzuBD=s96-c

2.创建一个Handler处理器:

handler = urllib.request.HTTPHandler()

这里创建了一个用于处理HTTP请求的Handler处理器。如果需要处理HTTPS请求,可以使用**urllib.request.HTTPSHandler()**来创建一个处理HTTPS请求的Handler处理器。

3.创建一个Opener对象,并将Handler处理器添加进去:

opener = urllib.request.build_opener(handler)

这里创建了一个Opener对象,并将之前创建的Handler处理器添加进去。

4.使用Opener对象发送请求:

url = '<http://www.example.com>'

req = urllib.request.Request(url)

try:

response = opener.open(req)

print(response.read().decode('utf-8'))

except urllib.error.URLError as e:

print(e)

这里使用Opener对象的**open()方法发送请求,并捕获可能的URLError异常。如果请求成功,可以通过response.read().decode('utf-8')**来获取响应内容。

5.完整示例代码:

import urllib.request

import urllib.error

# 创建一个Handler处理器

handler = urllib.request.HTTPHandler()

# 创建一个Opener对象,并将Handler处理器添加进去

opener = urllib.request.build_opener(handler)

# 使用Opener对象发送请求

url = '<http://www.example.com>'

req = urllib.request.Request(url)

try:

response = opener.open(req)

print(response.read().decode('utf-8'))

except urllib.error.URLError as e:

print(e)

通过以上步骤,我们可以使用Handler处理器来发送HTTP请求,并且可以根据需要添加不同的处理器来处理请求和响应,实现更灵活和高级的功能。