1. 部署 InternLM2-Chat-1.8B 模型进行智能对话

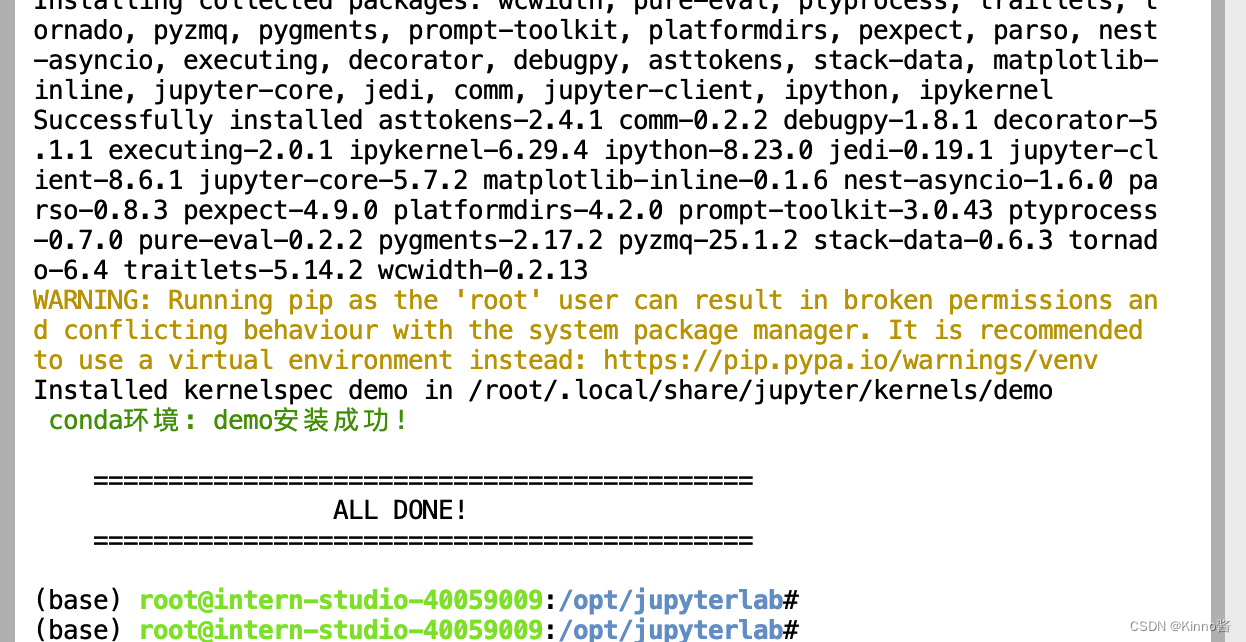

1.1 配置环境

- 创建conda环境,安装必要的库

studio-conda -o internlm-base -t demo

# 与 studio-conda 等效的配置方案

# conda create -n demo python==3.10 -y

# conda activate demo

# conda install pytorch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 pytorch-cuda=11.7 -c pytorch -c nvidia

- 配置完成后,进入到新创建的 conda 环境之中:

conda activate demo

- 输入以下命令,完成环境包的安装:

pip install huggingface-hub==0.17.3

pip install transformers==4.34

pip install psutil==5.9.8

pip install accelerate==0.24.1

pip install streamlit==1.32.2

pip install matplotlib==3.8.3

pip install modelscope==1.9.5

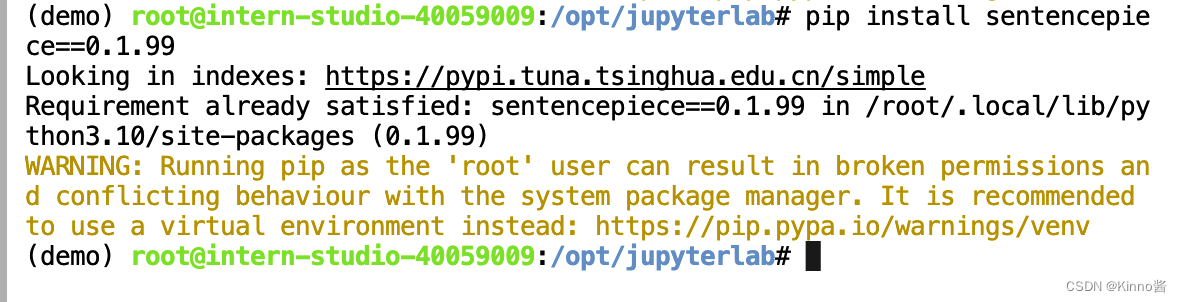

pip install sentencepiece==0.1.99

查看该环境内已安装的包

conda list

1.2 下载 InternLM2-Chat-1.8B 模型

- 按路径创建文件夹,并进入到对应文件目录中:

mkdir -p /root/demo

touch /root/demo/cli_demo.py

touch /root/demo/download_mini.py

cd /root/demo

这里的

touch命令用于创建两个空的Python文件:cli_demo.py和download_mini.py。如果这些文件已经存在,touch命令不会更改它们的内容,只会更新时间戳。

touch命令通常用于:

- 创建空文件

- 更新文件的时间戳(访问时间和修改时间)

- 避免在脚本或Makefile中创建文件时出现"文件不存在"的错误

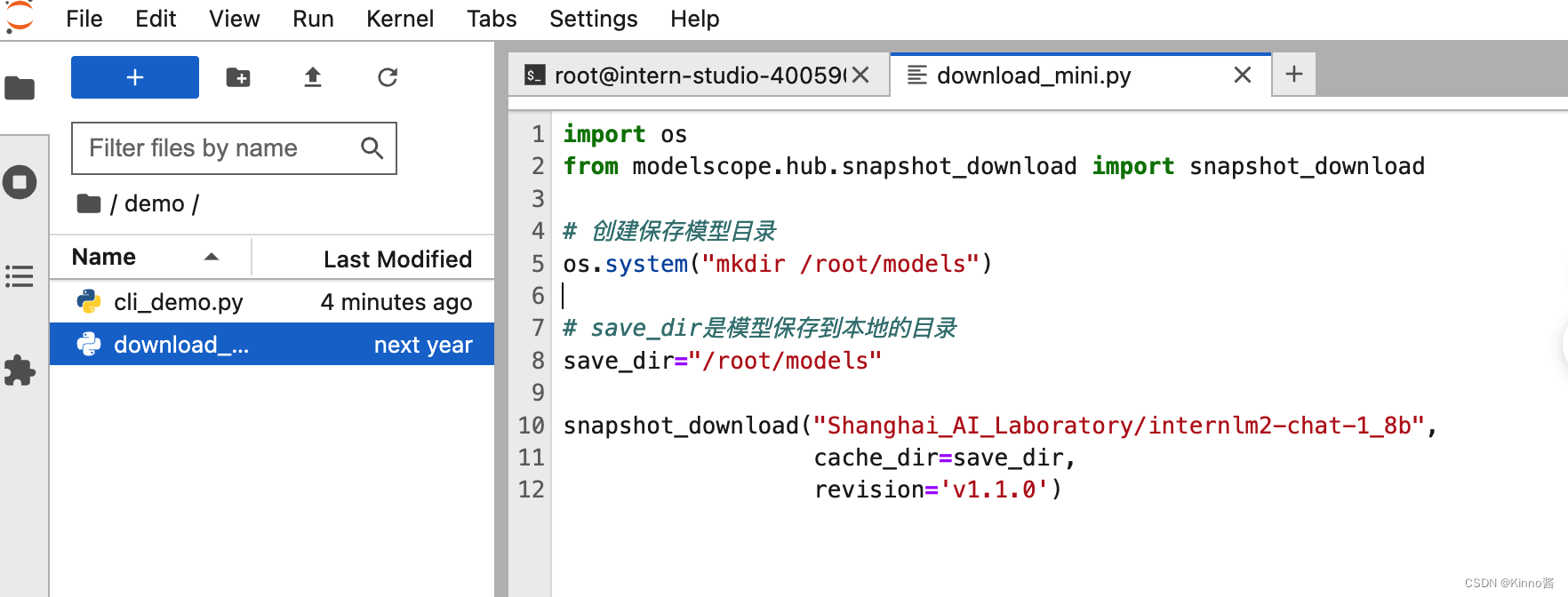

通过左侧文件夹栏目,双击进入demo文件夹。

- 双击打开

/root/demo/download_mini.py文件,复制以下代码:

import os

from modelscope.hub.snapshot_download import snapshot_download

# 创建保存模型目录

os.system("mkdir /root/models")

# save_dir是模型保存到本地的目录

save_dir="/root/models"

snapshot_download("Shanghai_AI_Laboratory/internlm2-chat-1_8b",

cache_dir=save_dir,

revision='v1.1.0')

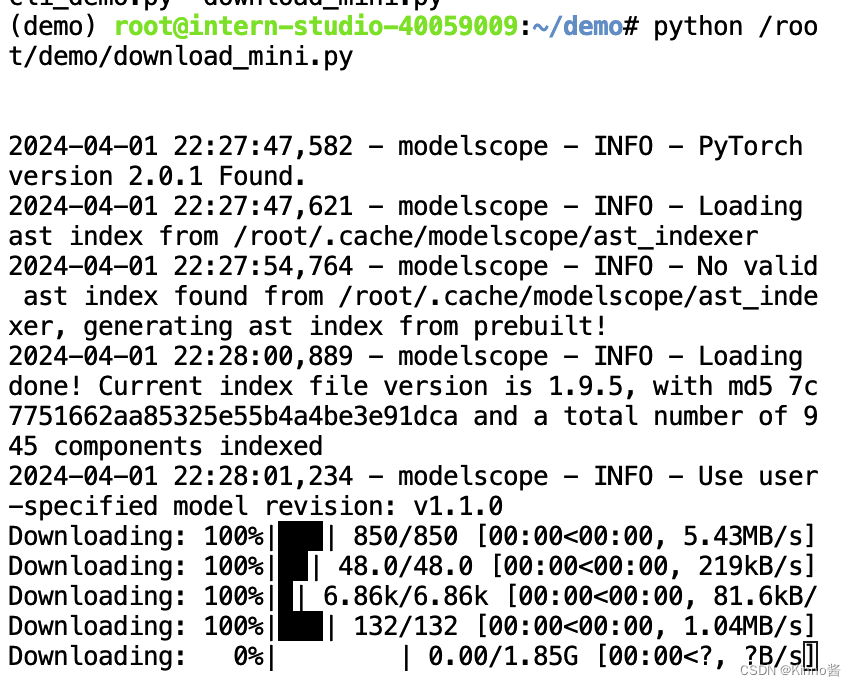

3. 执行命令,下载模型参数文件:

python /root/demo/download_mini.py

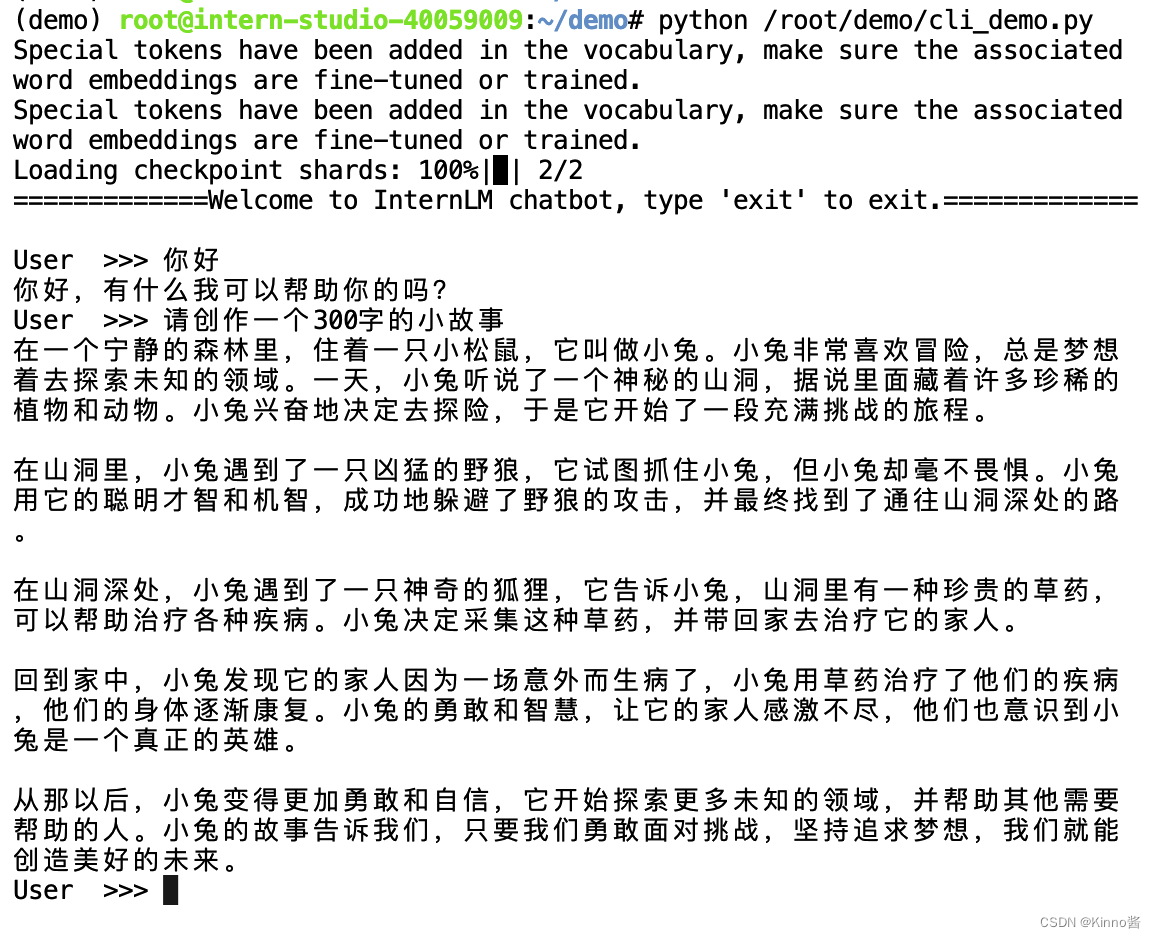

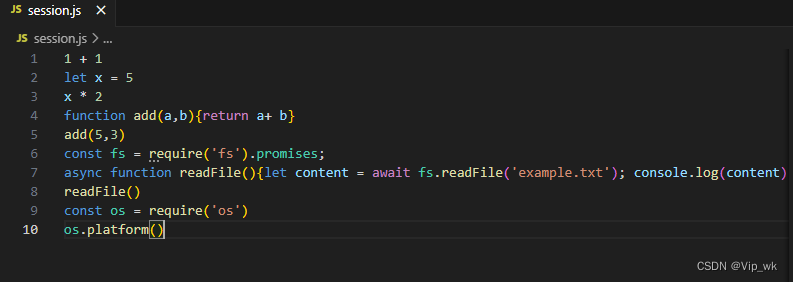

4. 运行 cli_demo

双击打开 /root/demo/cli_demo.py 文件,复制以下代码:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name_or_path = "/root/models/Shanghai_AI_Laboratory/internlm2-chat-1_8b"

tokenizer = AutoTokenizer.from_pretrained(model_name_or_path, trust_remote_code=True, device_map='cuda:0')

model = AutoModelForCausalLM.from_pretrained(model_name_or_path, trust_remote_code=True, torch_dtype=torch.bfloat16, device_map='cuda:0')

model = model.eval()

system_prompt = """You are an AI assistant whose name is InternLM (书生·浦语).

- InternLM (书生·浦语) is a conversational language model that is developed by Shanghai AI Laboratory (上海人工智能实验室). It is designed to be helpful, honest, and harmless.

- InternLM (书生·浦语) can understand and communicate fluently in the language chosen by the user such as English and 中文.

"""

messages = [(system_prompt, '')]

print("=============Welcome to InternLM chatbot, type 'exit' to exit.=============")

while True:

input_text = input("\nUser >>> ")

input_text = input_text.replace(' ', '')

if input_text == "exit":

break

length = 0

for response, _ in model.stream_chat(tokenizer, input_text, messages):

if response is not None:

print(response[length:], flush=True, end="")

length = len(response)

使用 Hugging Face Transformers 库与 InternLM 对话模型进行交互的 Python代码。

加载分词器和模型:

tokenizer = AutoTokenizer.from_pretrained(...): 加载与模型相对应的分词器。model = AutoModelForCausalLM.from_pretrained(...): 加载语言模型,使用bfloat16数据类型,并指定设备为cuda:0。model = model.eval(): 将模型设置为评估模式。定义系统提示:

system_prompt = """...""": 定义一个系统提示,介绍 InternLM 助手的基本信息。初始化消息列表:

messages = [(system_prompt, '')]: 将系统提示添加到消息列表中。开始交互循环:

while True: 进入无限循环,直到用户输入 “exit” 时退出。input_text = input("\nUser >>> "): 提示用户输入问题。input_text = input_text.replace(' ', ''): 去除输入文本中的空格。生成助手的响应:

for response, _ in model.stream_chat(tokenizer, input_text, messages): 使用stream_chat方法生成助手的响应。

tokenizer: 分词器对象。input_text: 用户输入的问题。messages: 之前的对话消息列表。- 循环内部:

- 如果

response不为None,则打印从上次打印的长度到当前长度的新生成内容。- 更新

length变量为当前响应的长度。

在命令行运行

python /root/demo/cli_demo.py